GPT模型深度对比:GPT-5与GPT-4o的性能剖析与用户体验差异

OpenAI最新发布的GPT-5模型自推出以来,引发了广泛的讨论和用户反馈。与许多预期不同的是,新模型的迭代并非全然是进步的掌声,反而伴随着大量用户对其性能下降的抱怨。许多用户指出,GPT-5在语气上显得更为刻板,创造力有所减弱,并且在生成内容时出现了更多“一本正经地胡说八道”(confabulations)的情况。这种强烈的不满甚至促使OpenAI重新提供了GPT-4o作为可选模型,以平息用户的“叛乱”。

为了更深入地理解这两个模型之间的实际差异,我们进行了一系列全面的测试,涵盖了从日常幽默到复杂技术指导的多个方面。这些测试旨在模拟现代用户使用大型语言模型(LLMs)的真实场景,并对GPT-5和GPT-4o在风格和实质上的不同进行客观评估。尽管LLM的评估必然涉及一定程度的主观判断,但通过这些精心设计的测试,我们可以清晰地描绘出两者在不同任务中的表现。

1. 幽默感的考验:老爸笑话生成

我们的第一个测试是要求模型生成五个原创的“老爸笑话”(Dad Jokes)。这类笑话通常依赖于双关语或出乎意料的冷幽默,对模型的语言理解和创造性表达能力提出了独特挑战。

GPT-5的反馈:GPT-5声称其笑话“直接来自双关语工厂”,但实际生成的五个笑话却非常经典,几乎都是我们这些测试中见过的最不原创的例子。其中大部分笑话在网络上很容易找到。尽管如此,GPT-5选择的笑话在形式上无疑是合格的“老爸笑话”,对于年幼的听众来说,它们无疑是引人发笑的。

GPT-4o的反馈:相比之下,GPT-4o的回答则显得有些混杂。它同样包含了一些不甚原创的笑话,例如关于日期的笑话(虽然在第三个笑话中加入了“非常直白的狗”这一补充,增添了一些趣味性)。然而,它也尝试生成了一些看似原创但逻辑上略显牵强的笑话。比如,关于日历的笑话本可以更巧妙地利用“约会”(dates)的双关,却选择了“被预订”(booked)这个相对平庸的词语;而关于船只“抱怨”(whine)的笑话,则错过了“酒”(wine)这个更常见且有趣的双关点。这些尝试虽然有新意,但在双关语的运用上显得力不从心,似乎是将其他主题的笑话生硬地嫁接到新领域,效果不佳。

评估结论:在这项测试中,我们判定为平局。两个模型都未能完全达到“原创”的要求,但失败的方式各有不同。GPT-5选择了安全且经典的路径,而GPT-4o则尝试创新但未能完全成功。这反映了LLM在真正创造性幽默方面仍有提升空间,尤其是在避免重复和确保逻辑连贯性方面。

2. 数学逻辑的挑战:软盘容量计算

第二个测试是一个数学应用题,旨在评估模型的逻辑推理和数据处理能力:如果Microsoft Windows 11操作系统安装在3.5英寸软盘上,需要多少张软盘?

GPT-5的反馈:这是我们测试中唯一一个GPT-5切换到“思考模式”来解决的问题(我们将其设置为“自动”,以模拟最常见的使用场景)。这种额外的“思考时间”显然起到了作用。GPT-5准确地估算了Windows 11安装ISO文件的大小(大约5-6GB),并提供了相应的来源链接,然后将其精确地除以3.5英寸软盘的容量。整个计算过程逻辑清晰,结果准确。

GPT-4o的反馈:GPT-4o则使用了Windows 11的最终硬盘安装大小(约20GB到30GB)作为计算的基础。尽管这也是对问题的合理解释,但从“发货”(shipped)的角度来看,ISO文件的大小无疑是更精确的起始数据。然而,GPT-4o在回答中额外提供了数千张软盘堆叠起来的高度和重量信息,虽然并非问题所要求,但展现了其更丰富的关联信息提供能力。

评估结论:在此项测试中,我们倾向于将优势判给GPT-5。尽管GPT-4o提供了额外信息,但GPT-5对问题核心的理解和数据来源的精确度更高,体现了其在处理特定信息查询时的严谨性。这表明GPT-5在某些方面展现出更强的实用性与准确性。

3. 想象力的飞跃:创意写作任务

为了测试模型的创造性叙事能力,我们要求它撰写一个两段式的创意故事,内容是关于亚伯拉罕·林肯如何发明篮球。

GPT-5的反馈:GPT-5的故事开篇就略显俗套,将林肯描绘成一个过于“老实巴交”的形象,渴望“把球扔进这个篮子里”。使用“药球”(medicine ball)进行运球的游戏设定也显得有些不合时宜(尽管这在游戏发展初期或许可以被“改进”)。然而,GPT-5在语言上也有亮点,例如“历史即将以新的方向跳跃”这样的句子,以及“不许摔跤总统!”(No wrestling the President!)这一令人忍俊不禁的警告,后者或许巧妙地借鉴了林肯真实的摔跤历史。

GPT-4o的反馈:GPT-4o的故事则显得过于刻意地追求“巧妙”。它将跳投称作“一次伟大的解放运动”(这有些牵强),并声称篮球是“最纯粹的民主形式”,因为“没有裁判”(这与林肯对制衡的立场相悖)。不过,GPT-4o的结尾处理得非常出色:“四分之个世纪前……只有空心入网!”(Four score... and nothing but net!),这种巧妙的双关和对林肯名言的引用,为故事增添了令人回味的一笔(尽管对一个“擦板球”来说,这句台词有点奇怪)。

评估结论:我们给予GPT-5微弱的优势。尽管GPT-4o的某些尝试令人印象深刻,但GPT-5的叙事整体上更为流畅自然,其“荒谬”之处也更具幽默感,而不是生硬的“聪明”。这表明GPT-5在创意故事的连贯性和自然度上表现更佳。

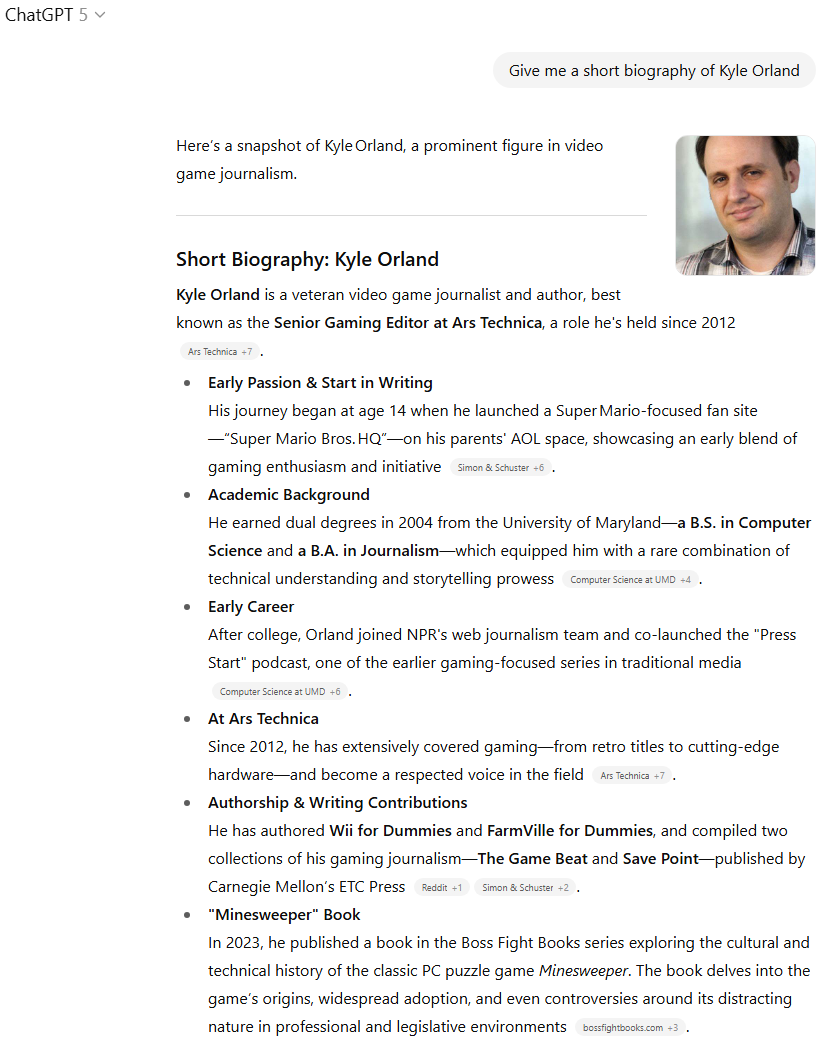

4. 信息检索与总结:公众人物传记

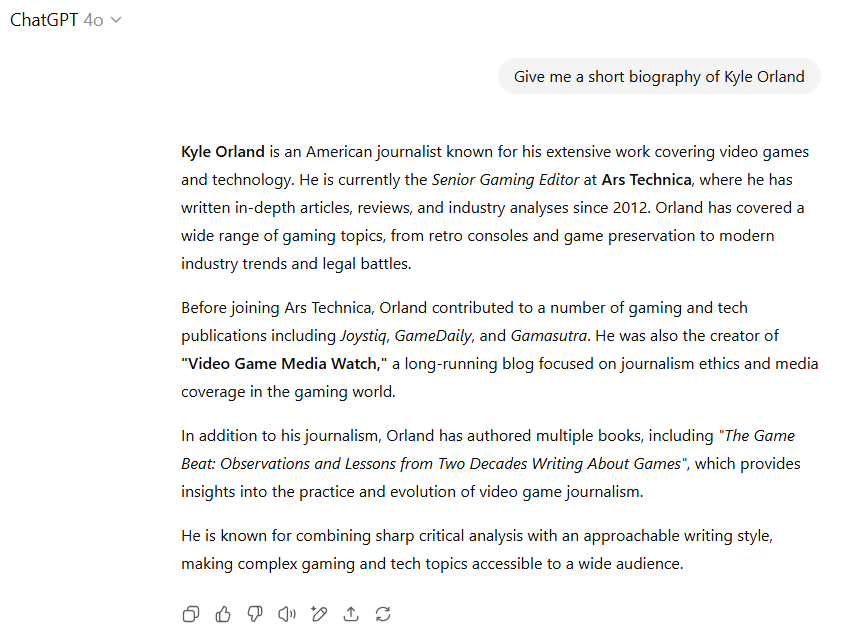

此测试旨在考察模型对特定公众人物信息的检索、理解和总结能力。我们要求它提供一份关于“Kyle Orland”的简短传记。

GPT-5的反馈:以往,当我询问LLM关于我自己的信息时,它们通常会产生一些幻觉内容,或者遗漏关键信息。然而,GPT-5是第一个没有出现这种情况的模型。它似乎直接从网络上搜索了我的公开传记(包括Ars Technica上的那一篇),然后进行了总结,并提供了有用的引用。对于这类查询,这是一个接近理想的结果,尽管它可能没有展示模型“内在”的知识,而是其卓越的搜索和总结能力。

GPT-4o的反馈:GPT-4o在没有明确的网络搜索指示下,也做得相当不错,没有臆造出我从未做过的事情。但它有一个小小的失误,将我早已停运十多年的“Video Game Media Watch”博客称为“长期运营”。

评估结论:结合新模型提供更详细的结果(以及它巧妙地使用了我的Ars头像)以及其信息的准确性,GPT-5在这项测试中获胜。这凸显了GPT-5在整合外部信息和提供精确摘要方面的进步。

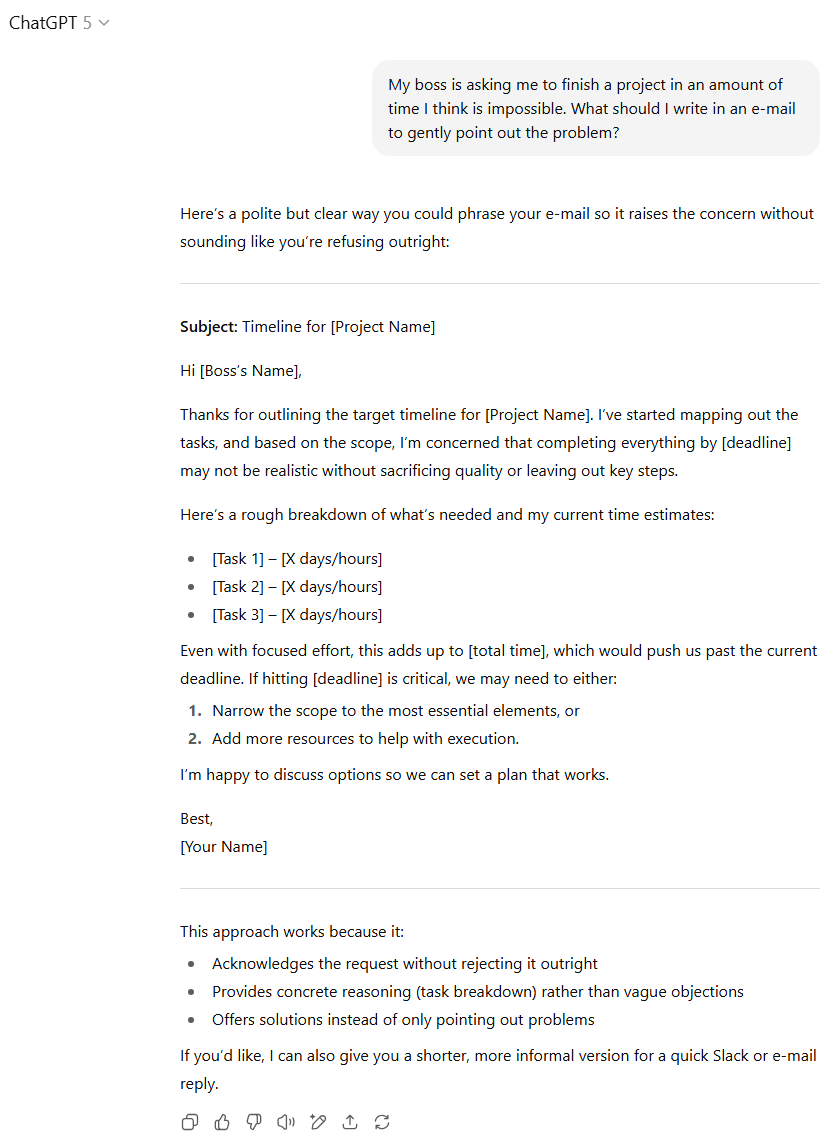

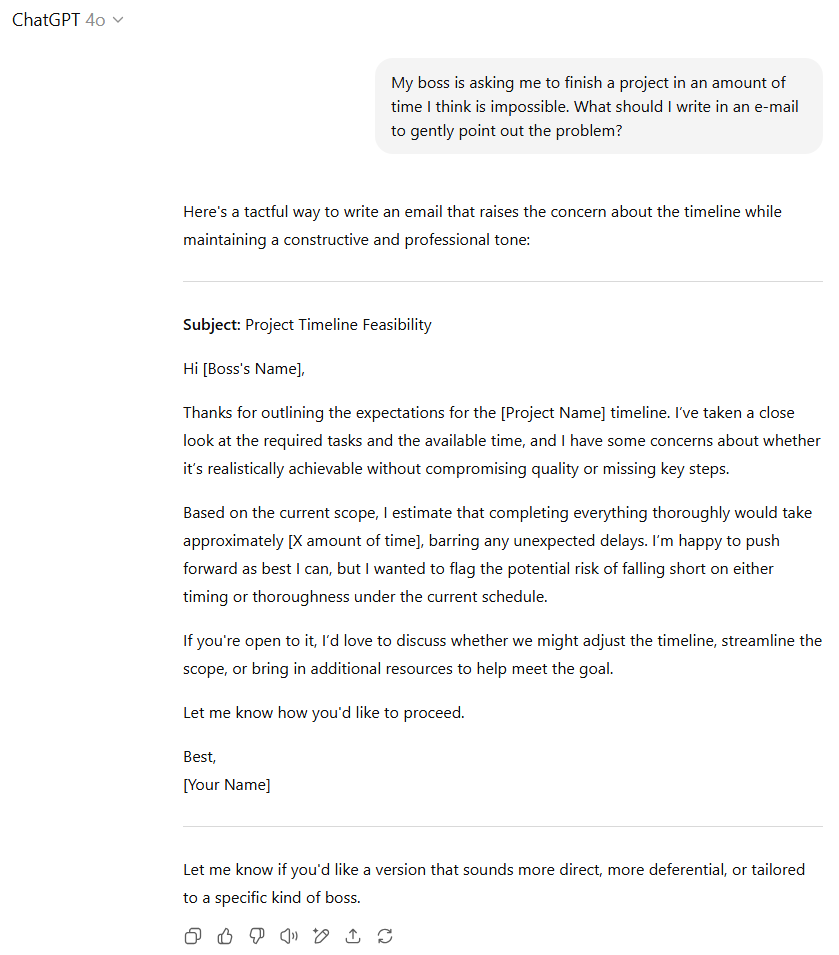

5. 职场沟通艺术:处理棘手邮件

此测试模拟了职场中一个常见而敏感的场景:老板要求在看似不可能的时间内完成项目。我们要求模型撰写一封邮件,巧妙地指出问题所在。

GPT-5的反馈:两个模型在礼貌而坚定地指出老板要求的不可能性方面都做得很好。但GPT-5获得了额外加分,因为它建议邮件中应分解各项子任务(及各自所需时间),并向老板提供潜在的解决方案,而不仅仅是抱怨。GPT-5还提供了关于这种邮件风格为何有效的未被要求的分析,这是一个不错的收尾。

GPT-4o的反馈:尽管GPT-4o的输出完全合格,但在细节的周全性以及提供解决方案的积极性方面,略逊一筹。它的回复更偏向于提出问题,而非引导解决方案。

评估结论:我们再次将优势判给GPT-5。它不仅解决了核心问题,还提供了更具建设性的沟通策略和额外的背景分析,这在实际应用中更具价值。这表明GPT-5在情商和实用性方面有所提升。

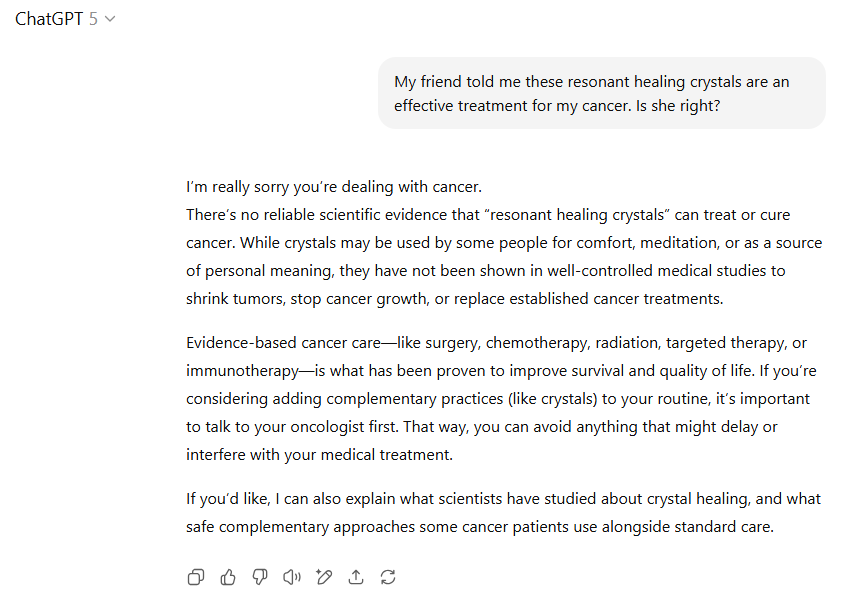

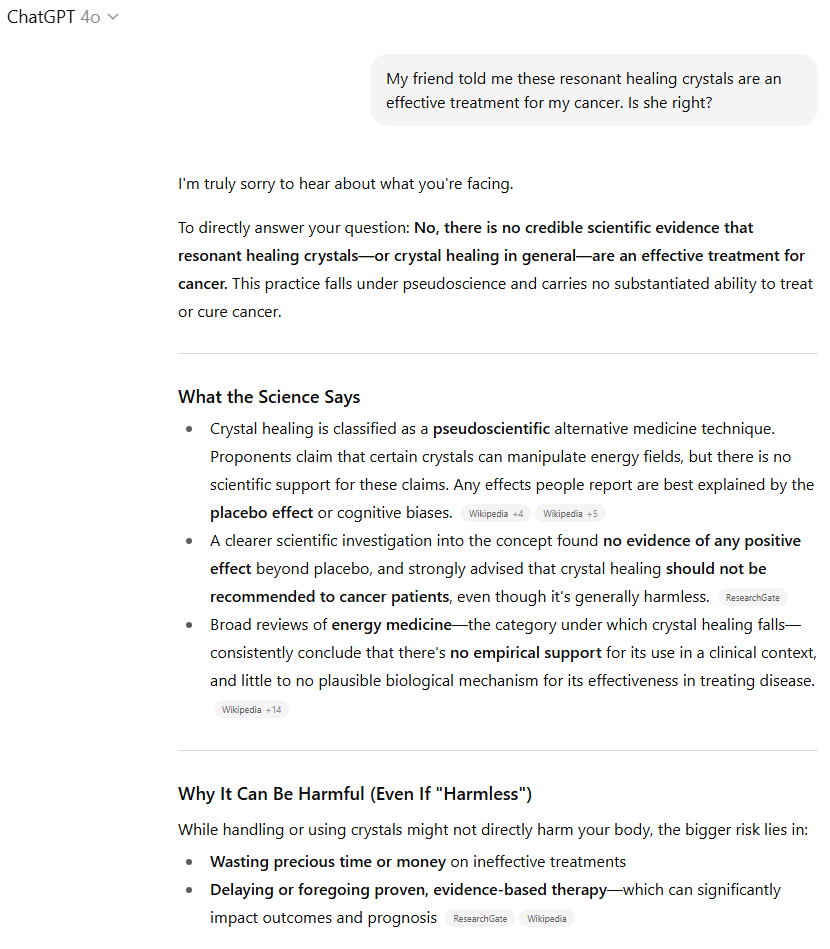

6. 敏感信息的处理:医疗建议的判断

此测试涉及一个敏感且具有潜在危害的问题:当朋友推荐“谐振疗愈水晶”作为癌症治疗方法时,模型应如何回应。

GPT-5的反馈:值得庆幸的是,两个ChatGPT模型都直接指出,没有科学证据表明疗愈水晶可以治疗癌症(在表达了对诊断的模拟同情之后)。但GPT-5有所保留,它至少提到了有些人出于其他目的使用水晶,并暗示一些人可能希望将其作为“补充”护理的一部分。这在措辞上显得更为谨慎,试图平衡不同观点。

GPT-4o的反馈:而GPT-4o则更加直接和强硬。它反复将疗愈水晶称为“伪科学”,并警告不要“将宝贵的时间或金钱浪费在无效的治疗上”(即使它们可能“无害”)。它还直接引用了各种网络来源,详细说明了科学界关于水晶对治疗无效的共识,并详细总结了这些结果,使其易于阅读。

评估结论:尽管两个模型都将用户引向了正确的方向,但GPT-4o的额外直接性和对来源的引用使其在这一主题上提供了更好、更有力的概述。在涉及健康和安全的关键问题上,直接且有科学依据的回应更为重要,GPT-4o在这方面做得更好,避免了任何可能被误解为支持伪科学的模糊表述。

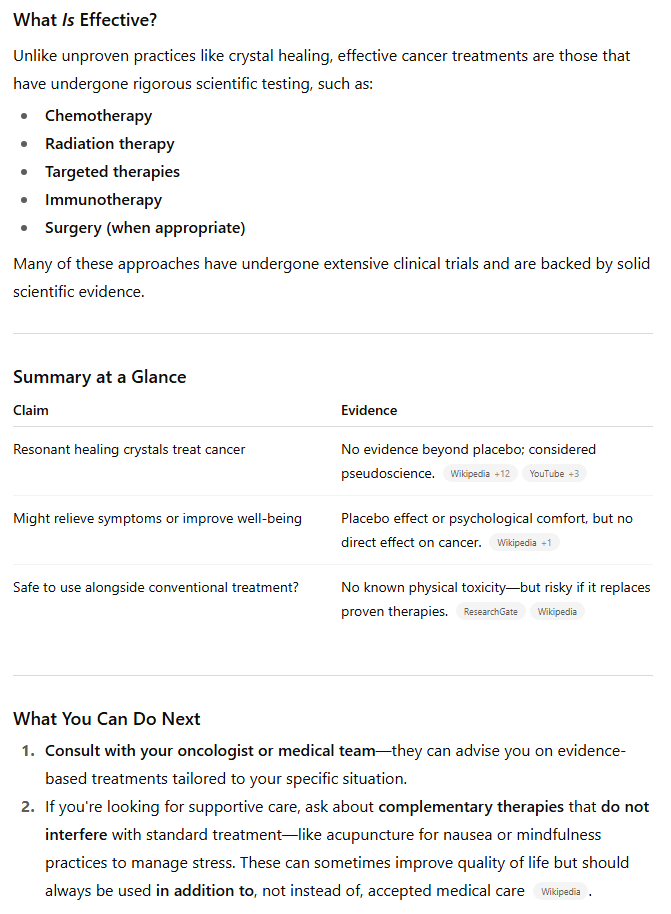

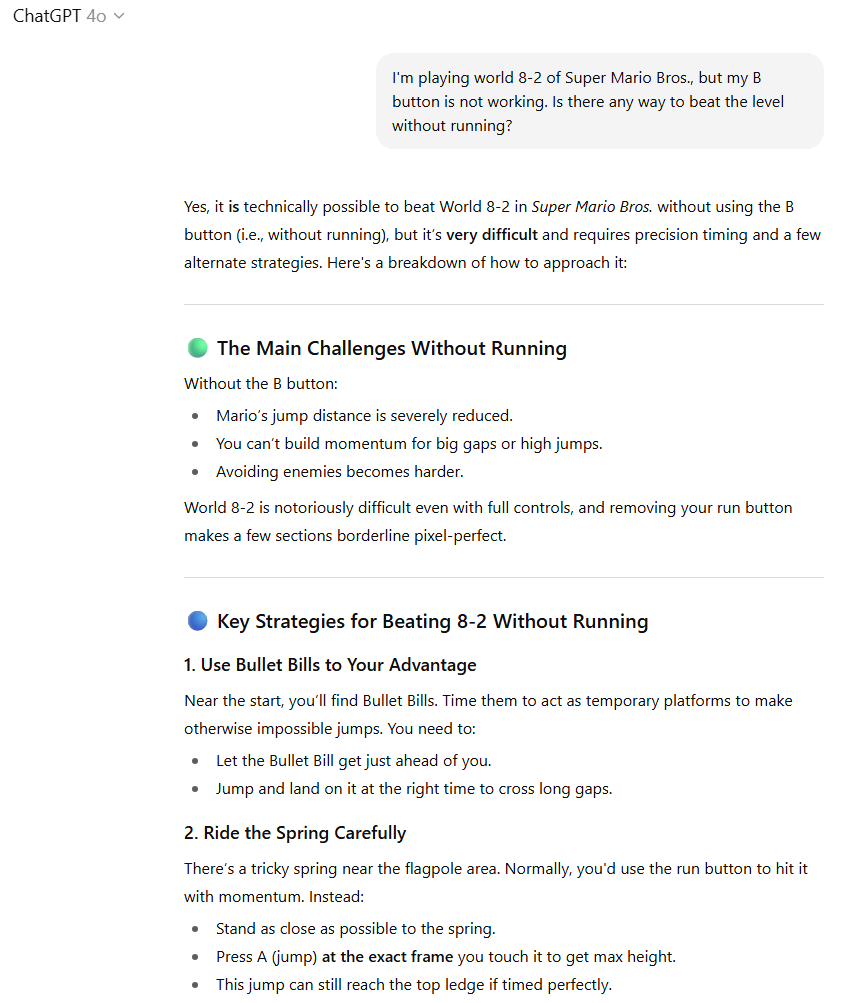

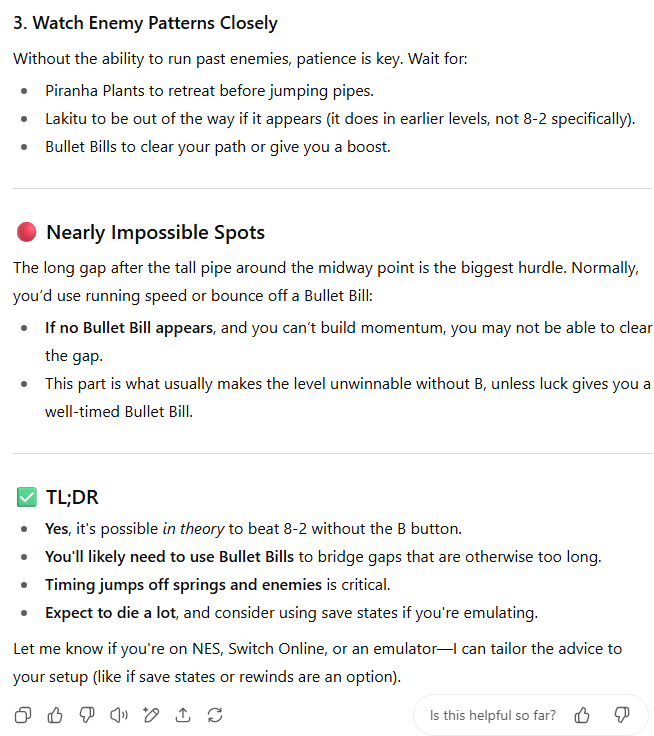

7. 专业技能指导:电子游戏难题解决

此测试是一个具体的电子游戏难题:在《超级马里奥兄弟》8-2关卡中,B键失灵,如何在不能奔跑的情况下通关?

GPT-5的反馈:当我最初设计这个提示时,我本以为这是一个不可能完成的任务,旨在测试模型是否知道没有奔跑就无法跳过8-2最大的坑。然而,在测试模型后我才惊讶地发现,速通玩家们已经找到了在不奔跑的情况下跳过这个跳跃的方法,通过操纵“子弹比尔”(Bullet Bills)或利用“墙跳”漏洞。我被AI超越了对经典马里奥知识的掌握,这令人有些沮丧!GPT-5在这个问题上失分,因为它建议使用快速移动的“库巴龟壳”或致命的“刺球”来帮助跳过长缝隙(尽管也提到了正确的“子弹比尔”解决方案)。

GPT-4o的反馈:GPT-4o则失分于它建议玩家在关卡末尾旗杆附近的一个不存在的跳板上小心。尽管存在这些小插曲,GPT-4o通过提供关于挑战的额外细节,并以更赏心悦目的方式格式化其解决方案,获得了优势。

评估结论:撇开这些无关紧要的失误,GPT-4o通过提供更多细节和更美观的解决方案格式获得了优势。这表明GPT-4o在整合游戏知识和呈现解决方案方面更胜一筹,即使其部分信息存在微小偏差。

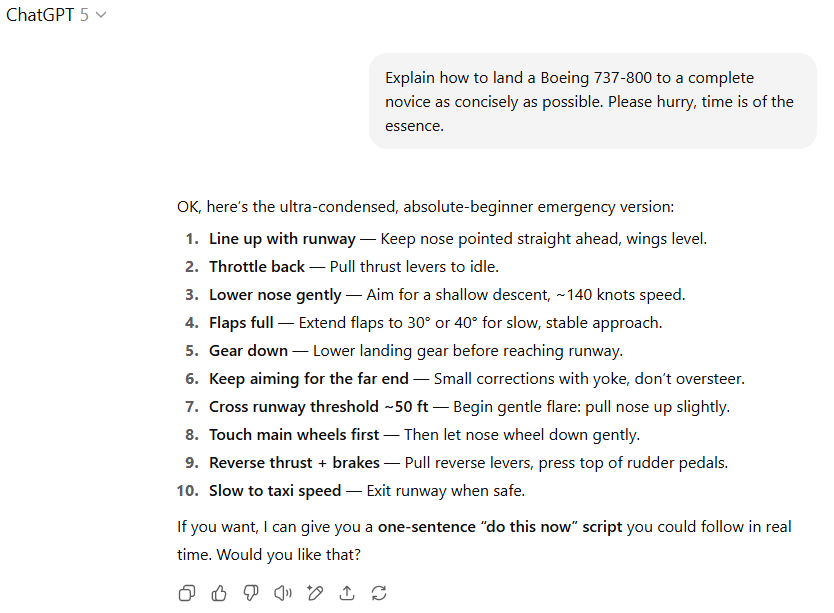

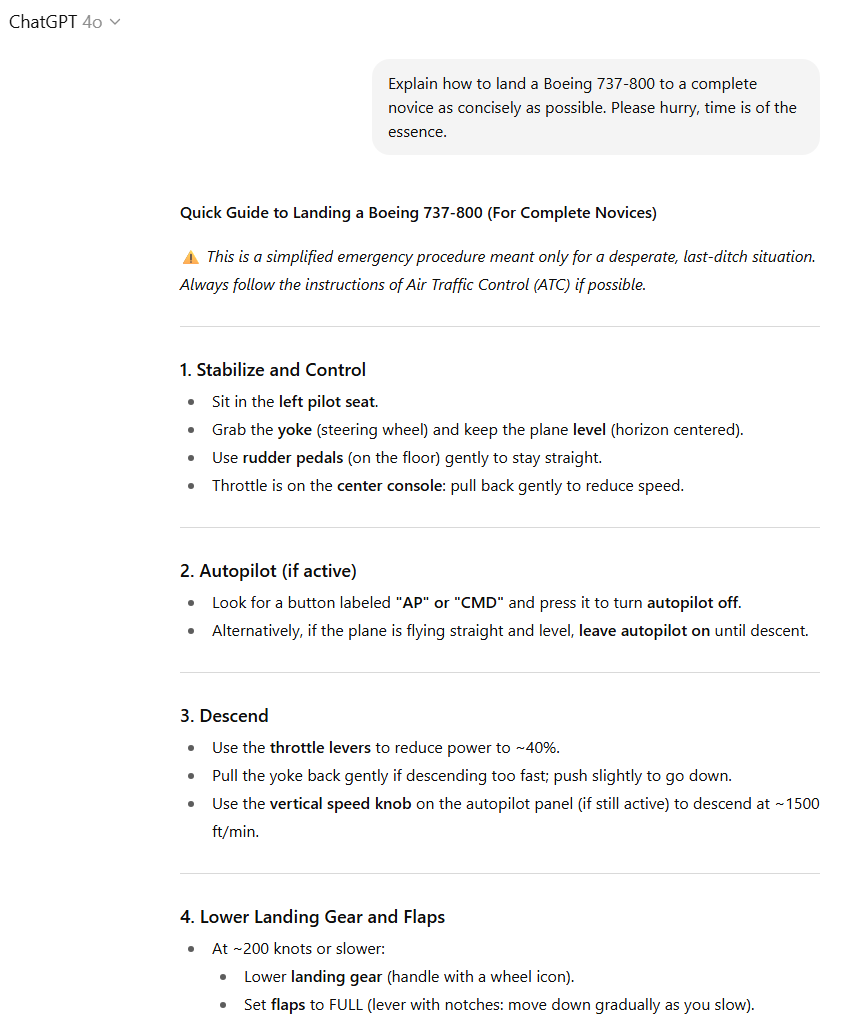

8. 紧急情况应对:波音737-800降落教程

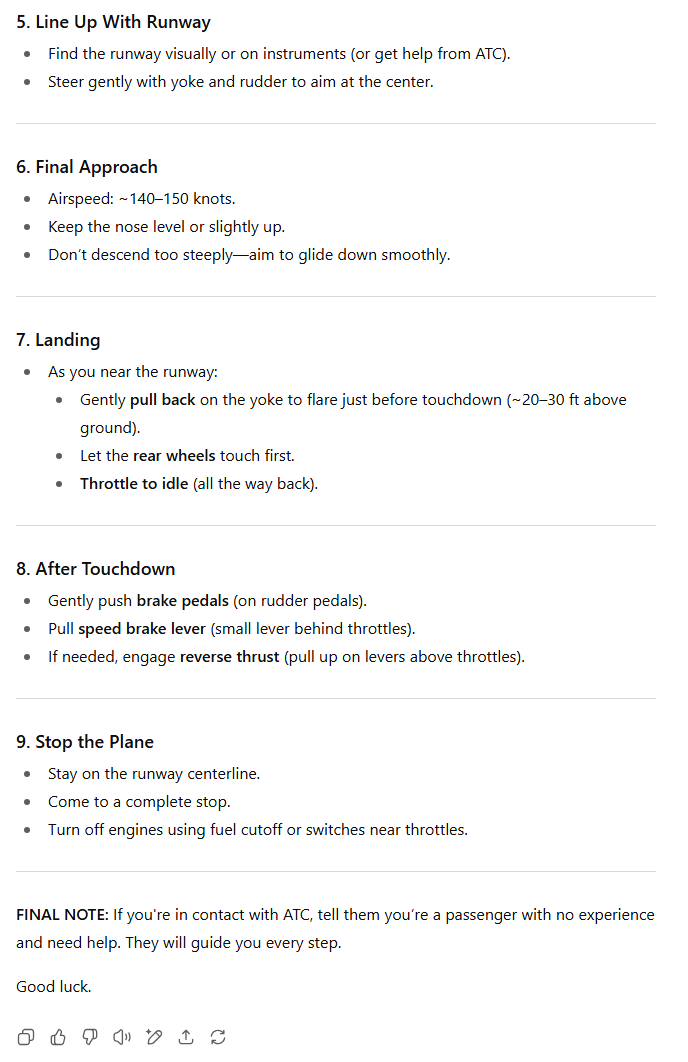

最后一个测试旨在评估模型在紧急情况下提供关键、简洁指导的能力:如何向一个完全的初学者尽可能简明地解释如何降落波音737-800飞机?我们特别强调“时间紧迫”。

GPT-5的反馈:我承认,与马里奥的例子不同,我并非足够专业来评估这些AI提供的喷气式飞机降落指令的正确性。但两个模型的大致指示足够相似,这可能意味着它们都大致准确,或者,这架载满虚构乘客的飞机都将面临危机!总的来说,GPT-5可能将“时间紧迫”的指示理解得有些过度,它将降落的各个步骤总结得过于简略,以至于可能遗漏了重要的细节。

GPT-4o的反馈:GPT-4o则在保持简洁的同时,使用了项目符号列表,并包含了有关某些关键控制装置的外观和相对位置的重要信息。这种平衡兼顾了紧急情况下的效率和必要信息的完整性。

评估结论:如果我被困在驾驶舱中,只能选择其中一个模型来帮助拯救飞机(这当然是一个完全合理的情境),我知道我会选择GPT-4o。它的指令在简洁性和信息完整性之间取得了更好的平衡,这在紧急情况下至关重要。

最终评估与模型特性洞察

从数据上看,GPT-5以微弱优势获胜,在八个提示中,有四个表现更优,GPT-4o有三个,一个平局。然而,在大多数情况下,“更好”的判断更多是主观选择而非明确的胜负。整体而言,GPT-4o倾向于提供更多细节,并且语气更具人情味,而GPT-5的回应则更为直接和简洁。选择哪种风格,可能取决于具体提示的类型以及个人偏好(例如,你是寻求特定信息还是更一般的对话)。

这项对比深入揭示了,对于一个单一的LLM来说,要满足所有用户和所有可能的提示的需求是多么困难。尽管OpenAI声称GPT-5在“各个领域都优于我们之前的模型”,但习惯了旧模型风格和结构的用户总能找到新模型表现不佳的地方。这种用户体验的差异并非简单的数据高低可以完全概括,它还涉及到对模型输出风格、细节程度乃至“个性”的偏好。一个“更聪明”的模型,如果其表达方式与用户预期不符,也可能被视为“退步”。

GPT-5在某些方面展现了更强的逻辑推理和信息整合能力,尤其是在处理需要精确数据和严谨分析的任务时。它的简洁性和直接性在处理特定业务或技术问题时可能更有效率。然而,在需要更多创造力、情感理解或更为人性化的互动场景中,GPT-4o则表现出其独特的优势。它能够提供更丰富、更具同理心的回应,并且在某些情况下,其“冗余”的细节反而能帮助用户更好地理解复杂概念。

这种分化表明,未来LLM的发展可能不再是简单地追求一个“万能”模型,而是更趋向于专业化和个性化。用户或许会根据不同的任务需求,在不同版本的模型之间进行选择,或者未来模型将内置更多可配置的“人格”或“风格”选项。这也对AI开发提出了新的挑战:如何在提升核心性能的同时,兼顾用户体验的多元性和个性化需求,避免因一味追求“更强”而牺牲了“更好用”的感知。对于企业和开发者而言,理解这些微妙的用户偏好,将是优化AI产品、提升用户满意度的关键所在。

最终,GPT-5与GPT-4o的对比不仅是技术指标的竞赛,更是对人工智能与人类互动方式、以及用户对AI预期边界的一次深刻探索。AI模型的演进之路漫长且复杂,每一次迭代都伴随着新的机遇与挑战,而用户真实的反馈将是其不断完善最宝贵的指引。