大型语言模型推理能力的深度剖析:超越模式识别的挑战

近年来,人工智能领域见证了大型语言模型(LLMs)在处理复杂问题方面取得了显著进展,特别是通过“思维链”(Chain-of-Thought, CoT)这类模拟推理机制。这些模型能够通过多步骤逻辑推导,看似有效地解决难题。然而,伴随这一进展的是学术界对LLMs“真实”推理能力日益增长的质疑。多项研究表明,这些模型在面对与训练数据稍有偏差的问题时,其性能会显著下降,有时甚至产生看似流畅却缺乏逻辑基础的“胡言乱语”。这种现象引发了我们对LLMs深层理解能力及其泛化潜力的重新审视。

亚利桑那州立大学的研究人员在一项预印本论文中指出,当前的LLMs并非“原则性的推理者”,而更像是“推理式文本的复杂模拟器”。为了更深入地探讨这一观点,他们构建了一个受严格控制的LLM实验环境,旨在量化“思维链”模型在处理“域外”(out of domain)逻辑问题时的表现。这些问题与模型在训练数据中遇到的特定逻辑模式有所不同,旨在测试其真正的泛化能力,而非仅仅是模式记忆。

思维链推理的“脆弱幻象”:泛化能力的极限

研究结果揭示了一个引人深思的结论:思维链模型看似巨大的性能飞跃,在很大程度上可能是一个“脆弱的幻象”。当任务分布发生中等程度的偏移时,这些模型的性能便会变得“脆弱且容易失败”。研究人员强调:“与其说它展示了对文本的真正理解,不如说在任务转换下,思维链推理反映了对训练过程中所学模式的复制。”这表明LLMs在很大程度上依然依赖于模式匹配,而非抽象的、通用性的推理能力。

为了客观、可量化地评估LLM的泛化推理能力,研究团队开发了一个名为DataAlchemy的特殊受控训练环境。这个系统创建了小型模型,这些模型在两种极其简单的文本转换示例上进行训练:ROT密码和循环移位。随后,研究人员又增加了这两种功能以各种顺序和组合执行的训练数据。这种分步训练方法旨在模拟LLM在学习多步推理时的过程。

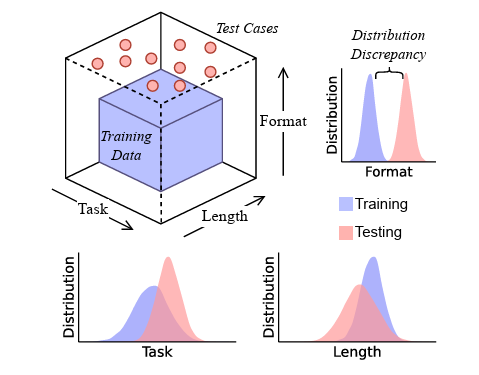

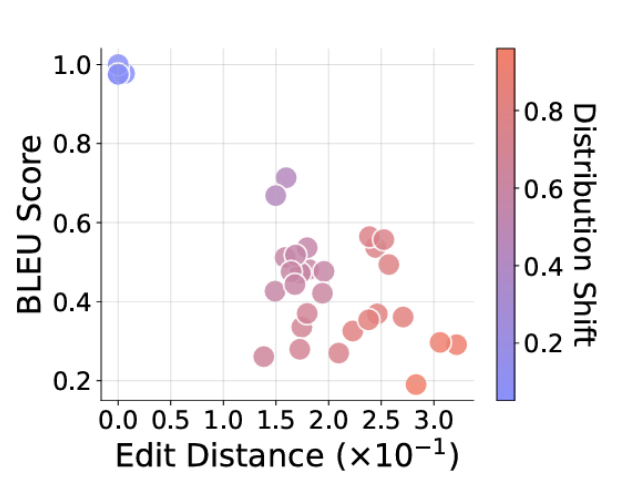

研究人员使用了一系列测试任务来评估这些简化模型的性能。其中一些任务与训练数据中的功能模式完全或非常接近,而另一些则需要执行的功能组合是部分或完全“域外”的。例如,一个模型可能在学习了两次循环移位的训练数据后,被要求执行一个涉及两次ROT移位的新颖转换,而它仅对单个ROT移位有基本了解。通过将模型的最终答案和推理步骤与预期答案进行比较,研究人员利用BLEU分数和莱文斯坦距离等客观指标来衡量其准确性。

正如研究人员所预期的,这些基础模型在被要求泛化到训练数据中没有直接演示的“新颖”转换组合时,开始出现“灾难性”的失败。尽管模型经常试图根据训练数据中相似的模式来泛化新的逻辑规则,但这通常会导致模型给出“正确的推理路径,但答案却是错误的”。在其他情况下,LLM有时会偶然发现正确答案,但却伴随着“不忠实的推理路径”,即推理过程缺乏逻辑连贯性。

研究团队进一步测试了其受控系统,使用了比训练数据略短或略长的输入字符串,或者需要执行与训练长度不同的功能链。在这两种情况下,结果的准确性都随着“长度差异的增加而恶化”,这“表明了模型泛化能力的失败”。即使测试任务格式中出现模型不熟悉的小差异(例如,引入训练数据中未出现的字母或符号),也会导致模型性能“急剧下降”并“影响”其响应的正确性。这清晰地揭示了LLMs在面对微小分布偏移时的脆弱性。

超越表层模式识别:对未来模型与应用的反思

尽管通过有监督微调(SFT)引入少量相关数据通常能显著改善这种“域外”模型的性能,但研究人员认为,这种对各种逻辑任务的“修补”不应被误认为是实现了真正的泛化。“依赖SFT来修复每一次域外失败是一种不可持续的被动策略,它未能解决核心问题:模型缺乏抽象推理能力。”这强调了从根本上提升模型理解能力的重要性。

研究人员指出,这些思维链模型并非具备通用逻辑推理能力的体现,而是一种“复杂的结构化模式匹配”形式。当模型被稍微推离其训练分布时,其性能便会“显著下降”。更令人担忧的是,这些模型生成“流畅的胡言乱语”的能力,创造了一种“虚假的可靠性光环”,这在仔细审查下是站不住脚的。这种现象在实际应用中可能带来严重的误导。

因此,研究人员强烈警告不要将“思维链式输出等同于人类思维”,尤其是在“医疗、金融或法律分析等高风险领域”。他们建议,当前的测试和基准应优先考虑那些超出任何训练集范围的任务,以深入探究这类错误。未来的模型需要超越“表面级别的模式识别”,以展现更深层次的推断能力。这意味着人工智能研究的未来方向应更加侧重于构建具备真正抽象理解和泛化能力的模型,而非仅仅依赖于大规模数据训练和模式复制。