边缘智能新范式:谷歌Gemma 3 270M引领小型化AI浪潮

在过去几年中,人工智能领域见证了参数规模呈指数级增长的趋势,大型模型凭借其强大的算力与海量数据,成为驱动生成式AI服务的主力军。然而,这场军备竞赛中,小型化AI模型的崛起正悄然改变格局。谷歌最新发布的Gemma 3 270M模型,以其“袖珍”的身躯,预示着边缘AI计算的新纪元,旨在将高级AI能力普惠至本地设备,而非仅仅依赖云端。

这款仅拥有2.7亿参数的Gemma 3 270M,相较于其同系列中参数量在10亿至270亿之间的前辈们,显得尤为轻巧。在生成式AI语境中,模型参数是学习变量的核心载体,它们决定了模型如何处理输入并生成输出。通常而言,参数越多,模型的表现力越强。然而,Gemma 3 270M的诞生,旨在打破这一传统认知,证明在特定应用场景下,精巧高效同样能发挥巨大价值。其显著优势在于,它能够在诸如智能手机等移动设备,甚至是完全基于Web浏览器的环境中流畅运行,这为AI应用的普及提供了前所未有的可能性。

本地化AI的深远益处与技术考量

将AI模型部署在本地设备上运行,不仅是一项技术突破,更是解决当前云端AI服务诸多挑战的关键路径。首当其冲的便是隐私保护。数据在本地设备上处理,无需上传至云端,极大地降低了数据泄露的风险,符合用户对数据主权的日益增长的需求。其次是显著降低的延迟。本地运行消除了网络传输的耗时,使得AI响应速度更快,用户体验更为即时、流畅。这对于需要实时交互的应用,如语音助手、智能图像识别或本地内容生成等,具有决定性意义。

此外,本地化AI还能有效降低对云服务资源的依赖及相关成本。对于企业而言,这意味着可以构建更具成本效益的AI解决方案;对于个人用户,则意味着更便捷、经济的AI功能触达。Gemma 3 270M正是为这些本地化用例量身打造。以Pixel 9 Pro手机为例,在搭载Tensor G4芯片的环境中,这款小型Gemma模型能够支持多达25次会话,而电池消耗仅为0.75%,充分展示了其卓越的能效比。这种极致的效率,使其成为Gemma系列中迄今为止最为节能的模型,为移动AI的持久运行奠定了坚实基础。

性能评测:小身材蕴藏大能量

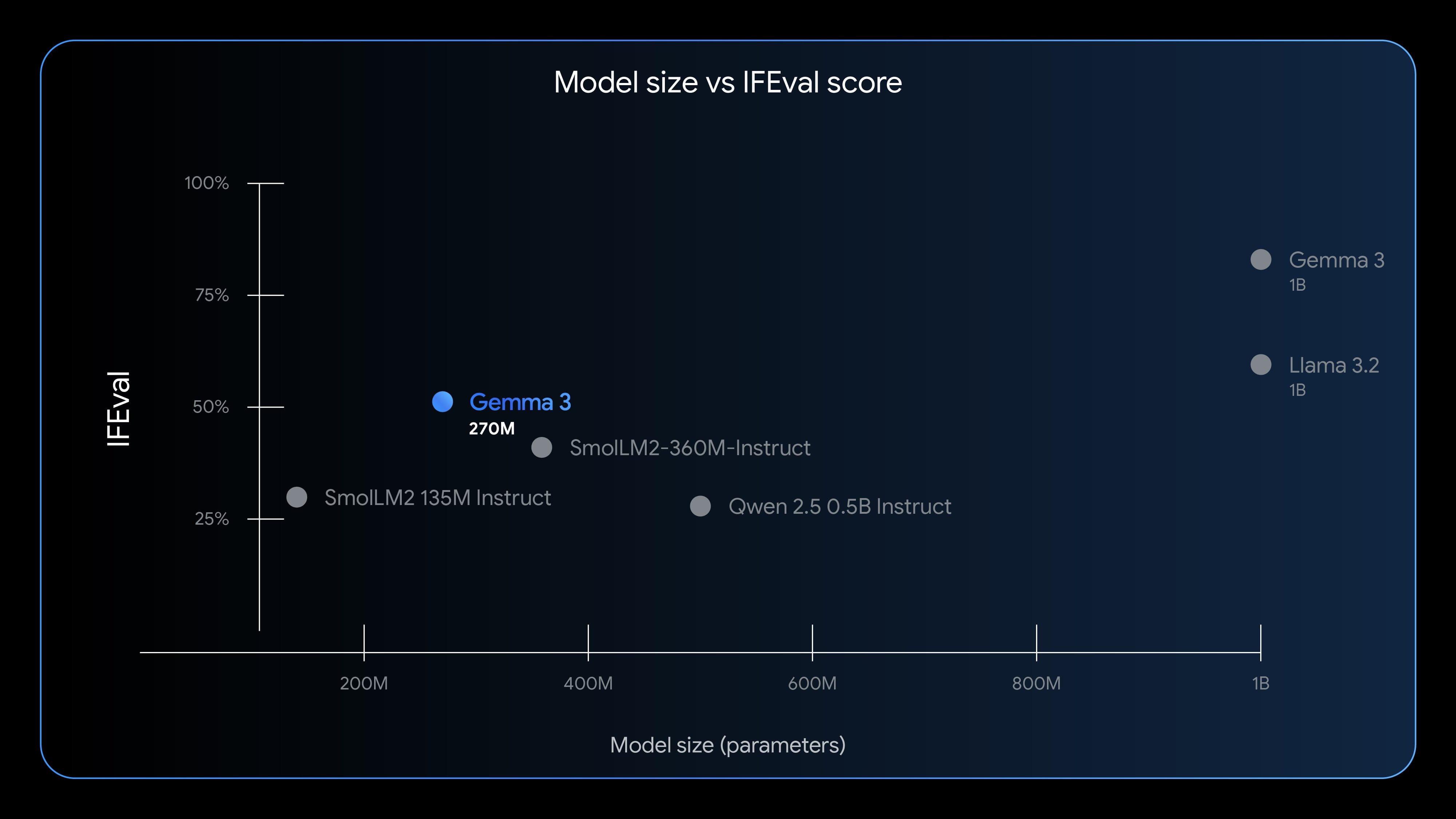

尽管Gemma 3 270M的参数规模无法与数十亿甚至数百亿参数的巨型模型相提并论,但在特定任务上,其表现却远超预期。谷歌采用IFEval基准测试来评估模型的指令遵循能力,结果显示,Gemma 3 270M取得了51.2%的优异成绩。这一分数超越了许多参数量更大的轻量级模型,有力证明了其在理解和执行指令方面的“超常”能力。虽然与Llama 3.2等参数过十亿的模型相比仍有差距,但考虑到其参数量仅为后者的极小一部分,这种接近的性能表现已足以令人惊叹。

谷歌明确指出,Gemma 3 270M在开箱即用的状态下,指令遵循能力已经相当强大,但其真正的潜力在于开发者可以根据特定需求进行快速且低成本的微调。由于模型体量小,微调过程所需计算资源和时间大幅减少,极大地降低了开发门槛。这使得Gemma 3 270M成为文本分类、数据分析等任务的理想选择。例如,在需要快速识别大量邮件内容、分析用户评论情感倾向或进行本地数据预处理的场景中,Gemma 3 270M能够以高效、低功耗的方式完成任务,而无需繁重的云计算支持。

“准开源”生态:开放性与责任边界

谷歌将Gemma系列模型定义为“开放”,这与传统意义上的“开源”有所区别,但两者在许多方面具有相似性。开发者可以免费下载Gemma 3 270M,并且其模型权重对外开放。更重要的是,它不设独立的商业许可协议,这意味着开发者可以自由修改、发布并将基于Gemma 3 270M衍生的工具部署到各自的产品中,这为创新应用提供了广阔空间。

然而,这种开放并非没有限制。所有使用Gemma模型的开发者都必须遵守其使用条款,其中明确禁止将模型用于生成有害内容,或故意违反隐私规定。这体现了谷歌在推动AI技术普及的同时,对伦理和责任的审慎考量。此外,开发者还有责任详细说明对模型的任何修改,并为所有衍生版本提供一份使用条款副本,确保其继承谷歌的定制许可。这种“负责任的开放”模式,旨在平衡技术共享与潜在风险控制,构建一个可持续发展的AI生态。

广泛可及:赋能多元开发与创新体验

Gemma 3 270M目前已在多个主流AI平台上线,开发者可以通过Hugging Face和Kaggle获取其预训练版本和指令微调版本,以便快速集成到自己的项目中。同时,谷歌的Vertex AI平台也提供了Gemma 3 270M的测试环境,方便开发者进行功能验证与性能调优。为了进一步展示这款轻量级模型的强大潜力,谷歌还特意通过Transformer.js构建了一个完全基于浏览器的故事生成器,用户无需专业的开发背景,也能亲身体验Gemma 3 270M在本地设备上进行内容创作的魅力,这无疑极大降低了AI体验的门槛。

小型化AI的未来展望与挑战

Gemma 3 270M的发布,不仅是谷歌在小型化AI领域的一次重要探索,更是对整个AI行业未来发展方向的有力指引。它预示着AI技术将从高高在上的云端,逐步下沉到无处不在的边缘设备。这将极大地推动个性化AI、离线AI应用的普及,使得智能助手、智能穿戴设备、物联网终端等能够拥有更强大的本地智能处理能力。

当然,小型化模型并非万能。尽管Gemma 3 270M在指令遵循和效率方面表现出色,但在处理高度复杂、需要极致泛化能力或海量知识的任务时,参数量庞大的模型依然具有不可替代的优势。未来的挑战在于如何进一步优化小型模型的结构和训练方法,使其在保持轻量化的同时,不断提升性能上限,以适应更广泛的应用场景。Gemma 3 270M的成功,无疑为研究者们提供了宝贵的经验和新的思考方向,它将鼓励更多创新者探索如何在资源受限的环境中,发挥AI的最大价值,共同绘制AI普惠的宏伟蓝图。这次突破,标志着AI技术发展不再仅仅是追求“更大更强”,而是更注重“更小更智能”的均衡演进,为我们开启了一个充满无限可能的边缘智能新篇章。