大型语言模型“链式思考”能力的深层剖析:模拟推理与泛化能力边界

近年来,大型语言模型(LLM)在模拟复杂推理任务方面取得了显著进展,特别是通过引入“链式思考”(Chain-of-Thought, CoT)提示策略,模型能够逐步分解问题并生成中间步骤,从而在诸多基准测试中展现出惊人的解决能力。然而,随着AI技术应用的深入,越来越多的研究开始对这些模型的“推理”本质提出质疑。它们究竟是在进行真正的逻辑推理,还是仅仅巧妙地模拟了人类的思维过程?最近,亚利桑那州立大学的一项研究深入探讨了这一关键问题,其结论揭示了LLM“模拟推理”的脆弱性,尤其是在其训练数据分布之外的场景中。

链式思考的表象与内在局限

“链式思考”机制通过促使模型输出一系列中间步骤,模仿了人类在解决复杂问题时的思维路径。这种方法在多步数学问题、常识推理和符号操作等任务上表现出色,使得LLM能够处理过去被认为超出其能力的复杂任务。例如,一些模型甚至能够像人类一样,在解决问题时“自我纠正”或“反思”。这种能力的出现,无疑为通用人工智能的实现描绘了诱人的前景。

然而,这种看似强大的推理能力正面临严峻的审视。现有研究已发现,当问题中包含不相关的子句、或仅仅在表述上与训练数据中的常见模板存在微小偏差时,这些“推理”模型便可能产生逻辑上不连贯或完全错误的答案。这种现象表明,模型可能并非真正理解逻辑概念,而是高度依赖于其在训练过程中学习到的特定模式和结构。换言之,其表现出的“思考过程”可能更接近于一种高阶的模式匹配,而非深层的抽象理解与泛化。

DataAlchemy实验揭示的泛化困境

为了系统性地评估LLM在“域外”(out-of-domain)逻辑问题上的泛化能力,亚利桑那州立大学的研究团队构建了一个名为DataAlchemy的受控LLM训练环境。该平台旨在通过最小化训练数据的复杂性,从而清晰地衡量模型在面对陌生逻辑模式时的表现。研究人员训练了一系列小型模型,使其掌握两种极其简单的文本转换规则:ROT加密(一种简单的替换密码)和循环移位(将字符串中的字符循环移动指定位置)。随后,模型还被提供了这两种功能以不同顺序和组合执行的示例。

研究的核心在于测试模型在以下场景中的性能:

- 域内匹配任务: 与训练数据中的函数模式完全或高度匹配的任务。

- 部分域外任务: 需要模型组合训练数据中未直接展示的函数(例如,模型在单一ROT移位和单一循环移位上受过训练,但被要求执行连续两次ROT移位)。

- 完全域外任务: 任务类型、格式或长度与训练数据显著不同的任务。

为了客观衡量模型的准确性,研究人员采用了BLEU分数(常用于评估机器翻译质量)和Levenshtein距离(衡量两个序列之间差异的指标)来比较模型的输出与期望答案。这些量化指标为深入分析模型的表现提供了坚实的数据基础。

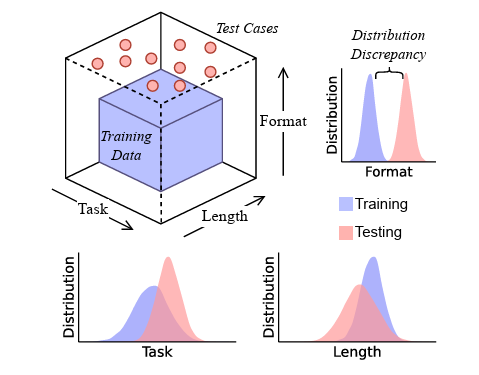

图示:研究人员设计了测试用例,这些用例在任务类型、格式和长度上均超出了LLM的训练数据范围,旨在探究其在泛化能力上的真实表现。图片来源:Zhao et al.

脆弱的海市蜃楼:性能的急剧下降

实验结果有力地支持了研究团队的假设:当被要求处理训练数据中未直接展示的新型转换组合时,这些基础模型的表现急剧恶化,甚至出现“灾难性”的失败。这种失败并非简单的准确率下降,而是呈现出复杂的错误模式:

- 推理路径正确,答案错误: 模型有时能够生成看似逻辑正确的推理步骤,但最终给出的答案却是错误的。这表明模型可能掌握了某种形式的“思考”模板,但在实际执行过程中缺乏对抽象概念的深层理解,导致在具体计算或符号操作上出错。

- 推理路径不忠实,答案正确: 另一些情况下,模型可能会偶然地得出正确答案,但其所展示的推理路径却并不符合逻辑,甚至与实际的解题过程相悖。这进一步印证了模型倾向于复制模式而非真正理解的特性,其成功可能来源于对表面模式的“幸运”匹配。

研究人员明确指出,这些发现“揭示了CoT推理在任务转换下反映的是训练中学到的模式复制,而非对文本的真正理解。” 这意味着,CoT机制所带来的性能飞跃,在很大程度上是一种“脆弱的海市蜃楼”,即使在适度的分布偏移下也极易崩溃。

除了任务类型上的变化,研究还考察了输入文本的长度和任务链长度对模型性能的影响。结果显示,当输入字符串的长度略长或略短于训练数据中的示例,或者要求执行的函数链长度不同于训练样本时,模型的准确性会随着“差异程度”的增加而显著下降。这直接“表明了模型泛化能力的失败”。此外,测试任务格式上哪怕是微小且不熟悉的差异(例如,引入训练数据中未曾出现的字母或符号),也会导致模型性能“急剧下降”,并“影响”其响应的正确性。

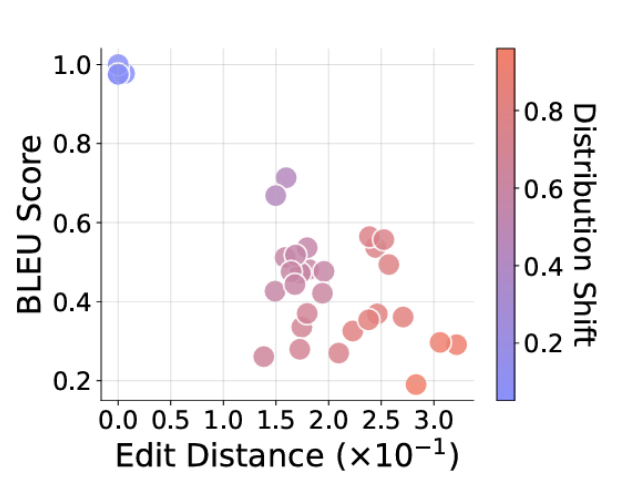

图示:随着请求任务与训练数据分布的距离增加(图中点颜色越红),模型提供的答案与期望答案的偏离程度也越大(图表右下角区域)。图片来源:Zhao et al.

监督微调的局限性与抽象推理的缺失

在实践中,当LLM在特定“域外”任务上表现不佳时,一种常见的解决方案是采用监督微调(Supervised Fine-Tuning, SFT),即向训练集中引入少量相关的特定数据以提升性能。虽然SFT在某些情况下能带来显著改进,但研究人员强调,这种“修补”策略不应被误认为是实现了真正的泛化能力。他们认为,“依靠SFT来修复每一次‘域外’失败是一种不可持续的、被动的策略,它未能解决核心问题:模型缺乏抽象推理能力。”

从更深层次看,LLM的泛化能力主要体现在其对已知模式的内插(interpolation)上,即在训练数据分布内部进行推断。然而,真正的抽象推理和泛化则要求模型能够进行外推(extrapolation),即在训练数据分布之外,面对全新的、未曾见过的模式或组合时,依然能够运用深层逻辑和概念进行有效推断。目前,链式思考模型更多表现为一种“复杂的结构化模式匹配”,而非真正的抽象逻辑推理,这使其在稍稍偏离训练分布时便“显著退化”。

警示与未来展望:超越“流畅的废话”

研究的发现对当前LLM的评估和应用具有深刻的启示。由于CoT模型能够生成“流畅的废话”(fluent nonsense),即听起来合理但实际上逻辑不健全的输出,这可能在用户心中制造“虚假的可靠性光环”(a false aura of dependability)。这种现象在医学诊断、金融分析或法律判决等高风险领域尤为危险,因为错误的“推理”可能导致灾难性的后果。

因此,研究人员强烈呼吁,当前的测试和基准评估应优先考虑那些处于任何训练集之外的任务,以此来深入探究模型潜在的逻辑缺陷和泛化边界。未来的模型发展必须超越“表面模式识别”,才能展现出更深层次的“推理能力”。这可能意味着需要探索将符号逻辑与神经网络结合的混合AI架构,或者开发全新的模型范式,以赋予AI真正的因果理解和抽象概念处理能力。

展望未来,人工智能领域需要更加注重模型的透明度、可解释性和鲁棒性。我们不能仅仅满足于模型能够“看起来在思考”,而是必须追求它们能够“真正地思考”。这意味着对AI的认知能力进行更严格、更全面的科学审视,从而推动人工智能从模拟智能迈向真正意义上的理解与推理。只有这样,我们才能构建出值得信赖、能在复杂且不可预测的真实世界中安全运作的智能系统。