在过去数年间,科技巨头们竞相投入巨资,利用堆栈如山的昂贵GPU集群,构建规模日益庞大的人工智能模型,并通过云服务形式提供强大的生成式AI能力。然而,这种中心化、资源密集型的AI发展路径,虽然推动了AI能力的上限,但也伴随着高昂的运行成本、潜在的数据隐私风险以及不可避免的网络延迟。随着智能设备普及和边缘计算的兴起,市场对能够在本地设备上高效运行的“微型AI”展现出前所未有的需求。

正是在这样的背景下,谷歌适时推出了其Gemma系列家族的最新成员——Gemma 3 270M。这款模型以其“袖珍”的体积引发了业界广泛关注,其参数量仅为2.7亿,相较于此前发布、拥有10亿至270亿参数的Gemma 3模型系列,以及市场上主流的数十亿乃至千亿级大型模型,Gemma 3 270M无疑是一次大胆且富有远见的尝试,旨在将高级AI能力下沉到更贴近用户和数据源的设备端。

突破性的本地运行能力与核心优势

Gemma 3 270M最显著的创新在于其卓越的本地运行能力。得益于极小的参数规模,该模型可以轻松部署在资源受限的设备上,例如智能手机、可穿戴设备乃至直接运行于网络浏览器之中。这种去中心化的AI处理模式,为用户和开发者带来了多重核心优势:

增强的隐私保护:将AI模型部署在本地设备上运行,推理过程完全在用户设备端完成,敏感数据无需上传至云端,从而从根本上杜绝了数据在传输或存储环节可能遭遇的泄露或滥用风险。这对于涉及个人健康信息、财务数据或私密通信等对隐私要求极高的场景尤为重要,使得AI应用能够在遵守严格数据保护法规的同时,提供个性化服务。

显著降低的延迟:传统云端AI服务往往受限于网络带宽和服务器响应时间,尤其是在对实时性要求较高的应用场景中,如语音助手、实时翻译或智能推荐,任何毫秒级的延迟都可能影响用户体验。本地运行的Gemma 3 270M直接在设备端处理请求,消除了网络传输带来的延迟,实现了近乎即时的响应,极大地提升了用户交互的流畅度。

惊人的能源效率:小模型通常意味着更低的计算资源需求。谷歌在Pixel 9 Pro手机上进行的测试结果令人印象深刻:Gemma 3 270M在Tensor G4芯片上运行25次对话,仅消耗了设备0.75%的电池电量。这种极高的能效比,使得AI功能可以在移动设备上长时间运行而无需担心电量耗尽,同时也减少了设备发热量,延长了硬件寿命。这是当前所有Gemma模型中能效表现最为卓越的一款,为构建可持续的设备端AI体验奠定了基础。

性能表现:小身材,大能量

尽管Gemma 3 270M的参数规模远小于其“大哥”们,但其性能表现却出乎意料地强大。开发者不应期待它能与数十亿参数模型相匹敌,但在特定任务上,Gemma 3 270M展现出了超越其体量的潜力。

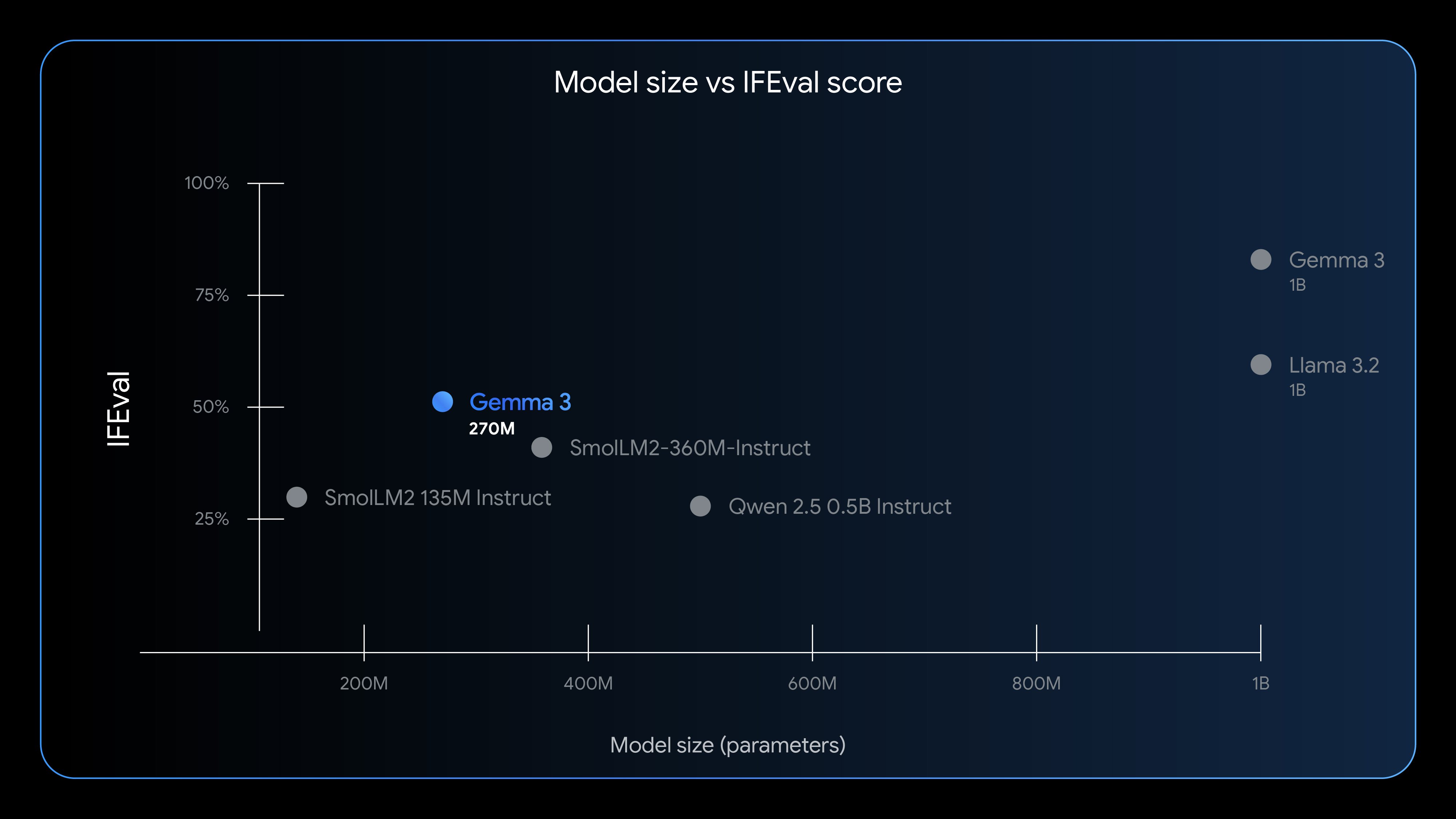

谷歌采用了IFEval基准测试来评估模型遵循指令的能力。Gemma 3 270M在此项测试中取得了51.2%的得分,这一成绩高于一些参数量更大的轻量级模型,充分证明了其在理解和执行指令方面的有效性。虽然它与Llama 3.2等十亿级参数模型仍存在一定差距,但考虑到其参数仅为后者的极小一部分,这种接近的性能表现已足以令人瞩目。这表明,在模型设计和优化方面,谷歌取得了显著的进步,使得小型模型也能胜任复杂的指令遵循任务。

快速微调与广泛的应用潜力

谷歌表示,Gemma 3 270M在开箱即用的状态下就具备了良好的指令遵循能力,但它更强调开发者可以根据具体用例对其进行快速且低成本的微调。由于模型体积小巧,微调过程所需的时间和计算资源大幅减少,这极大地降低了开发者定制化AI模型的门槛,加速了AI应用的迭代周期。

谷歌预见Gemma 3 270M将在多种任务中发挥关键作用,例如:

- 文本分类:对电子邮件、评论或新闻文章进行快速分类,提高信息处理效率。

- 数据分析:在设备端对数据进行初步的模式识别和洞察提取,无需上传敏感数据。

- 个性化推荐:根据用户本地行为数据提供高度个性化的内容或产品推荐,同时保护用户隐私。

- 设备端智能助手:构建响应更迅速、更具隐私保护的语音助手或聊天机器人。

- 增强现实/虚拟现实(AR/VR):在头戴设备上实现实时场景理解和交互,提升沉浸感。

这些应用场景的共同特点是它们需要快速响应、具备一定智能,并且对隐私或资源有特定要求,而Gemma 3 270M恰好能完美满足这些条件。

“开放”模式与开发者生态

谷歌将Gemma模型定义为“开放”,这与传统的“开源”概念有所不同,但其开放程度已足以满足大部分开发者的需求。用户可以免费下载Gemma 3 270M模型及其权重,且无独立的商业许可协议。这意味着开发者可以自由地修改、发布并在自己的工具和应用中部署基于Gemma 3 270M的衍生版本,无需支付额外的许可费用。

然而,所有Gemma模型的使用者仍需遵守谷歌的使用条款。这些条款明确禁止将模型用于生成有害内容或故意违反隐私规定。开发者还有责任详细说明模型所做的修改,并为所有衍生版本提供一份使用条款副本,因为它们将继承谷歌的定制许可。这种“负责任的开放”模式旨在平衡技术普及与伦理规范,确保AI技术在健康、可控的方向上发展。

为了进一步推动Gemma 3 270M的普及,谷歌已将其部署在多个主流平台,包括Hugging Face和Kaggle,提供预训练和指令微调两个版本,方便开发者按需选用。此外,开发者还可以在谷歌的Vertex AI平台上进行测试和实验。谷歌甚至展示了一个完全基于浏览器的故事生成器,该生成器便是基于Transformer.js和这款轻量级模型构建,用户即使不具备开发背景也能体验到Gemma 3 270M的强大功能,这无疑为未来AI应用的普及描绘了广阔前景。

展望:边缘AI的未来图景

Gemma 3 270M的发布,不仅是谷歌在轻量级AI领域的一次重要突破,更是对整个AI行业发展方向的一次战略性指引。它预示着未来AI将不再局限于数据中心,而是更加普及化、本地化、个性化。随着模型小型化技术的不断进步,我们可以期待更多高效、低能耗的AI模型出现在边缘设备上,赋能智能家居、物联网、工业自动化乃至个人健康管理等诸多领域。这种“AI无处不在”的愿景,将通过像Gemma 3 270M这样的小而强大的模型,逐步变为现实,开启一个更加智能、更加安全、更加普惠的AI时代。