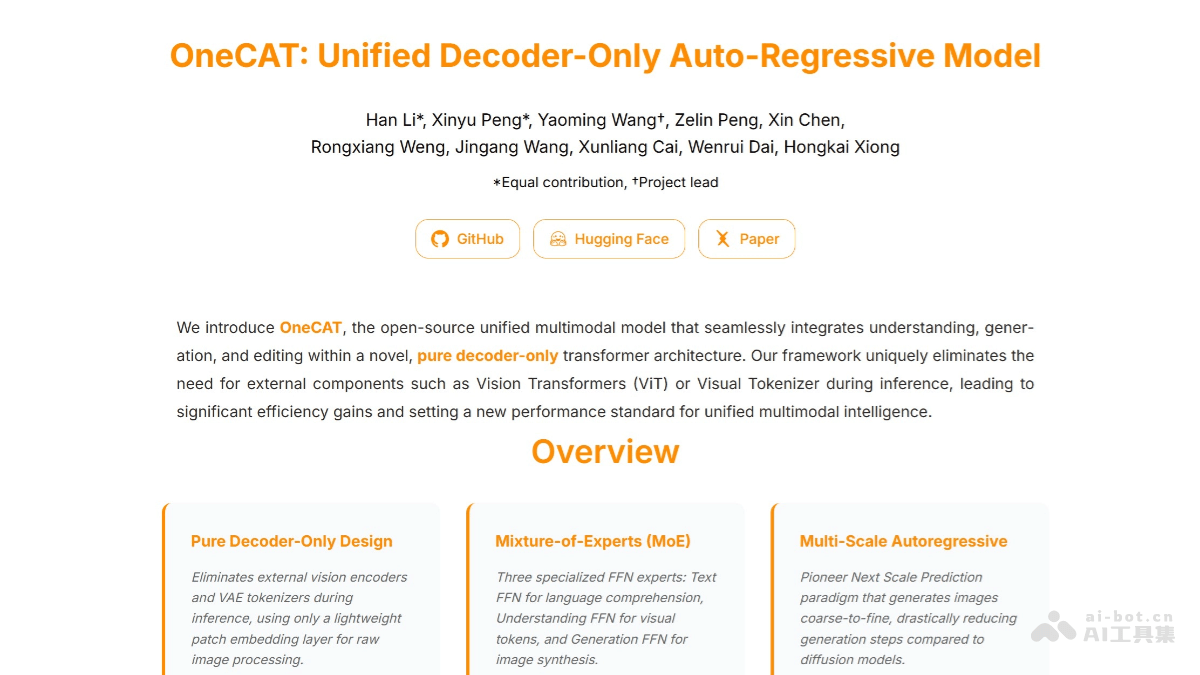

美团与上海交通大学联合推出的OneCAT模型,标志着统一多模态人工智能领域迈入了新的阶段。这款模型以其独特的纯解码器架构,实现了多模态理解、文本到图像生成以及图像编辑功能的无缝集成,旨在克服传统多模态模型在复杂性、效率和高分辨率处理方面的局限。

核心创新:纯解码器架构的颠覆性优势

传统的多模态模型通常依赖独立的视觉编码器(如ViT)和文本分词器来处理不同模态的数据,然后通过复杂的融合机制进行整合。这种方法虽然有效,但在模型复杂度、计算资源消耗以及跨模态对齐的精细度上存在挑战,尤其在处理高分辨率图像时,其效率问题尤为突出。

OneCAT模型选择了一条更为激进的路径——采用纯解码器自回归Transformer架构。这意味着它完全摒弃了外部视觉编码器和分词器,将所有模态的信息统一在一个解码器框架内进行处理。这一设计极大地简化了模型结构,降低了训练和推理的计算开销。更关键的是,通过共享底层注意力机制和参数,OneCAT能够更自然、更深入地实现不同模态信息之间的对齐和理解,为构建真正通用的AI智能体奠定了基础。

多功能融合:OneCAT的多元能力解析

OneCAT并非单一功能的模型,它集成了多项前沿的AI能力,使其在多个应用场景中都展现出强大的潜力。

1. 高效多模态理解

得益于其纯解码器架构,OneCAT能够高效地处理图像和文本信息,实现深度的多模态理解。它不再需要将图像分解为独立的视觉特征向量,或将文本转换为离散词元再进行拼接。相反,所有输入都被视为统一的序列,模型直接在这一统一的表示空间中进行推理和理解。这使得OneCAT能够处理更加复杂的图文语义关系,例如理解带有嵌入文字的图像、分析图像中特定对象的文本描述等。

2. 精准文本到图像生成

OneCAT能够根据给定的文本描述,生成高质量的图像。其生成过程并非一蹴而就,而是通过一种创新的多尺度自回归机制逐步实现。模型从低分辨率的视觉标记开始预测,然后逐步细化到高分辨率,这种由粗到细的生成方式,不仅显著减少了解码步骤,还确保了生成图像的细节和整体连贯性。无论是生成写实照片还是抽象概念图,OneCAT都能展现出卓越的创造力和控制力。

3. 灵活图像编辑

除了生成,OneCAT还具备强大的图像编辑能力。用户可以通过文本指令,对图像进行精准的局部或全局修改。例如,指示模型“将图片中的狗替换成猫”、“改变天空的颜色为傍晚的霞光”等。这种基于指令的编辑能力无需额外的架构修改,而是将视觉生成过程条件化在参考图像和编辑指令之上,展现了其强大的条件生成潜力,为创意工作提供了极大的便利。

深层技术解析:OneCAT的技术基石

OneCAT的出色表现离不开其背后精妙的技术设计。

1. 纯解码器架构的进一步剖析

OneCAT将所有模态的数据(包括文本标记、连续视觉标记和离散视觉标记)统一到一个共享的词汇空间中,并由一个大型的自回归Transformer解码器进行处理。这种统一的建模方式,使得模型能够在一个单一的框架内学习不同模态之间的内在关联,而非通过外部模块强制拼接。它消除了传统模型中不同模态表示层之间的“鸿沟”,使得知识迁移和跨模态推理更为高效。

2. 模态特定的专家混合(MoE)结构

为了在统一架构下兼顾不同模态的特性,OneCAT引入了模态特定的专家混合(MoE)结构。具体来说,模型包含三个专门的前馈网络(FFN)专家,分别负责处理文本标记、连续视觉标记和离散视觉标记。这意味着,在处理特定模态的信息时,相应的专家会被激活,从而提供更专业的处理能力。然而,所有查询、键、值(QKV)和注意力层在不同模态和任务之间都是共享的,这种设计极大地提高了参数效率,并进一步增强了模型的跨模态对齐能力,使得模型能够在理解文本的同时更好地理解图像,反之亦然。

3. 多尺度视觉自回归机制

OneCAT借鉴了大型语言模型(LLM)中的自回归生成范式,并将其扩展到视觉领域。通过一种粗到细、层次化的方式生成图像,模型首先预测图像的低分辨率视觉标记,然后逐步增加细节,最终生成高分辨率图像。这种机制不仅优化了生成效率,减少了序列长度,还通过从整体到局部的生成过程,确保了图像的全局一致性和局部细节的准确性,有效避免了直接生成高分辨率图像时常见的计算瓶颈和细节失真问题。

4. 多模态多功能注意力机制

OneCAT采用基于PyTorch FlexAttention的多模态多功能注意力机制,使其能够灵活适应多种模态和任务的需求。对于文本标记,它采用因果注意力(Causal Attention),确保文本生成和理解的顺序性;对于连续视觉标记,则采用全注意力(Full Attention),捕获图像中所有元素之间的关系;而对于多尺度离散视觉标记,则通过块状因果注意力(Block-Causal Attention)进行高效处理。这种精细化的注意力机制设计,确保了模型在处理不同模态数据时都能发挥最佳性能,同时保持了模态间的无缝交互。

变革性应用:OneCAT如何驱动行业未来

OneCAT的诞生,为多个行业带来了前所未有的创新机遇。

1. 智能客服与内容审核

OneCAT的多模态理解能力使其成为智能客服系统的理想选择。例如,用户上传带有产品图片和文字描述的投诉,OneCAT能同时理解图像中的产品状态和文本中的问题细节,提供更准确的诊断和回复。在内容审核领域,它能高效识别和筛选结合图像与文本的违规内容,如色情图片配有引诱性文字、虚假宣传图文等,大幅提升审核效率和准确性。

2. 创意设计与数字内容创作

对于设计师和内容创作者而言,OneCAT的文本到图像生成功能是强大的生产力工具。设计师可以快速根据文字概念生成多种风格的图像草图,进行迭代优化。例如,广告公司可根据客户的品牌理念和营销文案,迅速生成一系列视觉效果,加速创意落地。视频制作公司则可利用其图像生成和编辑能力,快速构建场景概念图,甚至辅助生成影视特效的初步素材,显著缩短前期制作周期。

3. 广告设计与营销

在竞争激烈的广告市场中,个性化和效率是关键。OneCAT能够根据不同目标受众的特征和偏好,生成定制化的广告图像和文案组合。例如,针对年轻群体生成时尚潮流的图片,针对商务人士生成专业严谨的视觉内容。通过快速生成和测试不同版本的广告素材,营销人员可以更精准地优化投放策略,提高转化率。图像编辑功能则能快速调整广告素材以适应不同平台和版面要求。

4. 影视后期制作

影视后期制作往往耗时耗力,OneCAT有望改变这一现状。其图像编辑功能可用于复杂的图像修复(如移除穿帮物体)、风格转换(如将现代场景转换为赛博朋克风格)、甚至辅助生成特定特效的背景或元素。这不仅能大幅提升后期制作效率,还能降低成本,让更多创意得以实现。例如,通过简单的文本描述,即可生成特定时代背景的道具或服装,省去大量建模和渲染工作。

5. 教育与学习

OneCAT在教育领域也具有广阔的应用前景。它可以根据教学文本或概念,自动生成形象生动的示意图或示例场景,帮助学生更直观地理解抽象知识。例如,在历史课中,根据对某个战役的描述生成战场地图;在生物课中,根据对细胞结构的描述生成微观图像。这种个性化、视觉化的学习体验将极大地提升教学质量和学生的学习兴趣。

展望未来:OneCAT引领下的AI新篇章

OneCAT模型的发布,不仅展示了美团与上海交通大学在人工智能前沿领域的强大研发实力,更代表着AI从“专用”走向“通用”的关键一步。通过统一多模态处理,OneCAT有望打破不同模态AI模型之间的壁垒,推动形成一个更为高效、智能的AI生态系统。它的纯解码器架构、模态专家混合以及多尺度自回归机制,为未来AI模型的设计提供了重要的范式。随着技术的不断演进和应用场景的持续拓展,OneCAT及其后续发展必将在重塑数字内容生产、提升人机交互体验、乃至驱动整个数字经济转型中发挥越来越重要的作用,共同开启一个由统一多模态AI驱动的智能新篇章。