AI深度洞察:单图生3D可探索世界,腾讯HunyuanWorld-Voyager的技术突破与行业前瞻

在人工智能飞速发展的今天,将静态图像转化为可交互、可探索的动态三维世界,无疑是计算机视觉与生成式AI领域的一个长期梦想。这一愿景正随着腾讯HunyuanWorld-Voyager的发布,变得触手可及。这款开放权重的AI模型,不仅实现了从单一图像生成具有3D一致性的视频序列,更赋予用户操控虚拟相机路径,在数字场景中“自由探索”的能力。这标志着AI在模拟真实世界感知与交互方面迈出了重要一步,为未来的内容创作与沉浸式体验开辟了全新可能。

Voyager的核心功能与独特之处

HunyuanWorld-Voyager的核心在于其能够将一张普通的2D照片转化为一段具有深度感、允许用户通过控制相机路径进行“漫游”的视频。这种能力并非传统的3D建模,而是通过生成一系列在空间上高度一致的2D视频帧来实现。尽管输出并非原生的三维模型,但其视觉效果足以模拟出相机在真实三维空间中移动的感受,让物体在相机移动时保持相对位置不变,视角随之正确切换。这一技术突破性地将RGB视频与深度信息同时生成,为后续直接进行三维重建提供了数据基础,而无需依赖复杂的传统建模技术。

具体而言,每次生成约49帧的视频,时长约两秒。然而,通过巧妙地将多个片段衔接起来,可实现长达数分钟的连续序列。这种设计既保证了单次生成的质量和一致性,又通过模块化组合延长了探索时间。其关键在于对物体相对位置的精准维持以及透视变换的正确呈现,这在以往的2D视频生成中是极难实现的。值得注意的是,这些生成的视频与深度信息结合,能够被转换为3D点云,为进一步的三维重建工作提供了宝贵数据。

技术原理深度解析:几何反馈与世界缓存

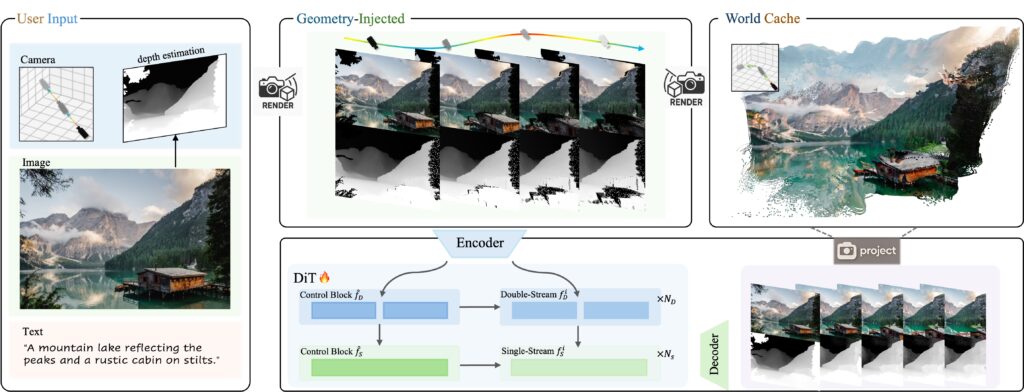

Voyager之所以能实现如此高的空间一致性,得益于其精巧的系统架构,特别是“几何反馈循环”与“世界缓存”机制。

1. RGB视频与深度信息协同生成

该系统首先在同一时刻同步生成彩色视频(RGB)和深度信息。这意味着当视频帧中出现一棵树时,伴随的深度数据能够精确地指出这棵树距离虚拟摄像机的远近。这种紧密耦合确保了视觉内容与空间位置的完美匹配,为后续的一致性维护打下了坚实基础。传统上,视频生成与深度估计往往是独立任务,Voyager的协同生成策略显著提升了效率与准确性。

2. 世界缓存:构建动态三维记忆

Voyager的另一个创新之处在于其名为“世界缓存”(World Cache)的机制。这是一个不断增长的3D点云集合,由此前生成的所有帧中的深度信息转化而来。当系统生成新帧时,这个3D点云会从新的摄像机角度重新投影回2D图像平面,形成部分图像。这些投影图像充当了至关重要的“一致性检查”参照物。模型会利用这些预测出的部分图像来校准新生成的帧,确保它们与之前生成的内容在几何上保持高度一致。

图1:Voyager世界生成流程图

图1:Voyager世界生成流程图

这种几何反馈循环是Voyager超越其他普通AI视频生成模型的关键。大多数基于Transformer架构的AI视频生成器,例如Sora,虽然能生成看似合理的连续帧,但通常难以在长时间序列或复杂相机运动中维持精确的空间一致性,物体可能会变形或跳动。Voyager通过强制模型将其学习到的模式与自身先前输出的几何一致性投影进行匹配,极大地提升了视频的空间连贯性。

然而,尽管这种技术显著改善了空间一致性,它仍然是基于模式匹配,并通过几何约束进行引导,而非真正意义上的三维“理解”。这也是为什么模型可以在数分钟内保持一致性,但在进行完整的360度旋转时会遇到挑战的原因。在大量帧的积累下,模式匹配中的微小误差会逐渐累积,最终超出几何约束所能维持的连贯范围。这一局限性提示我们,当前的生成式AI模型在处理复杂三维拓扑结构时,仍有巨大的进步空间。

训练方法与数据管线创新

Voyager的卓越性能离不开其高效且创新的训练方法。腾讯研究人员开发了一套自动化的数据处理管线,该管线能够自动分析现有视频,提取摄像机运动轨迹,并为每一帧计算深度信息。这种自动化过程极大地解放了人力,避免了耗时且昂贵的人工标注数千小时视频数据的需求。

该系统处理了超过100,000个视频片段,这些数据来源多样,既包括了真实世界录像,也包含了来自虚幻引擎(Unreal Engine)的计算机生成场景。通过学习虚幻引擎中摄像机在3D游戏环境中的移动模式,模型得以模拟出高质量的、具有游戏感官的3D空间探索体验。这种混合数据集的策略,使得模型能够同时从真实世界场景的复杂性和虚拟环境的完美几何特性中学习,从而提升了其生成视频的真实感和几何一致性。

算力需求与部署限制

尽管Voyager展现出强大的能力,其运行对计算资源有着极高的要求。为了生成540p分辨率的视频,至少需要60GB的GPU显存;而为了获得更佳效果,腾讯推荐使用80GB显存的GPU。这种对高端GPU的依赖,使得Voyager在个人用户层面普及面临挑战,主要限于拥有专业硬件的开发者和研究机构。

腾讯已在Hugging Face上发布了模型权重和相关代码,支持单GPU和多GPU设置。通过xDiT框架,该系统能够实现多GPU并行推理,例如,在八块GPU上运行,处理速度可比单GPU设置快6.69倍。这为追求更高效率的开发者提供了解决方案,但也进一步强调了其对分布式计算环境的需求。

值得关注的是,该模型还伴随着显著的许可限制。与腾讯旗下的其他Hunyuan模型类似,Voyager的许可禁止在欧盟、英国和韩国使用。此外,任何月活跃用户超过1亿的商业部署都需要获得腾讯的单独许可。这些地理和商业限制无疑会影响Voyager在全球范围内的推广与应用,但也反映了核心技术提供方对于知识产权和市场策略的审慎考量。

行业竞争格局与Voyager的定位

HunyuanWorld-Voyager的发布,是当前蓬勃发展的世界生成模型领域中的又一力作。在这一领域,多家科技巨头和创新公司都在积极探索。

- Google的Genie 3:于2025年8月发布,该模型能够从文本提示生成720p分辨率、24帧/秒的交互式世界,并支持实时导航。Genie 3主要侧重于训练AI智能体,目前尚未公开。

- Dynamics Lab的Mirage 2:提供基于浏览器的世界生成功能,允许用户上传图像并利用实时文本提示将其转化为可玩的交互式环境。Mirage 2更强调用户生成内容在游戏领域的应用。

与上述模型相比,Voyager拥有其独特的市场定位。尽管Genie 3侧重于AI智能体训练,Mirage 2着眼于用户生成游戏内容,Voyager则专注于视频生产和3D重建工作流程。其直接输出RGB-D(彩色视频加深度信息)的能力,使其在影视后期制作、建筑可视化、虚拟旅游和三维数据采集等领域具有独特的优势。它不是为了直接替代游戏引擎,而是为视觉内容创作提供了一种全新的、高效的工具。

在WorldScore基准测试中,Voyager表现出色,总分达到77.62,超越了WonderWorld(72.69)和CogVideoX-I2V(62.15)。特别是在物体控制(66.92)、风格一致性(84.89)和主观质量(71.09)方面表现卓越。尽管在摄像机控制(85.95)上略低于WonderWorld的92.98,但其综合性能仍处于行业领先水平。WorldScore基准测试由斯坦福大学研究人员开发,旨在评估世界生成方法在3D一致性和内容对齐等多方面的性能。这些数据表明,Voyager在技术成熟度上已达到较高水准。

展望未来:交互式生成艺术的新范式

当前,像Voyager这样对计算资源要求极高、且在生成长篇连贯“世界”方面仍存在局限性的模型,距离实现真正的实时交互式体验尚有一段距离。然而,正如Google的Genie等早期实验所昭示的,我们正在见证一种全新的、交互式生成艺术形式的萌芽。

Voyager的技术进步预示着多方面的深远影响。在影视制作领域,导演和视觉效果艺术家可以快速预览复杂的相机运动,甚至从2D概念图中生成初步的3D场景。在建筑和城市规划中,它可以将设计蓝图或照片转化为可漫游的虚拟模型,大大提升设计评审和方案展示的效率。对于虚拟旅游和文化遗产保护而言,用户仅凭一张历史照片或一张地标图片,就能“穿越”到过去的场景或遥远的国度。

长远来看,随着AI模型效率的提升和算力成本的下降,此类技术有望普及到更广泛的用户群体。结合更先进的语言模型和多模态理解能力,未来的世界生成模型或许能够根据复杂的自然语言描述,实时创建出包含丰富细节、可交互、且具备物理真实感的虚拟世界。这将彻底改变游戏开发、元宇宙构建以及任何需要沉浸式三维内容的应用领域。从2D图像到可探索3D世界的转变,不仅仅是技术上的飞跃,更是人类与数字内容交互方式的革命性开端。我们正站在一个新时代的门槛上,见证着AI如何重塑我们对现实世界的感知与想象。