迷你模型的崛起:Google Gemma 3 270M引领边缘智能新范式

近年来,科技巨头们在人工智能领域竞相投入巨资,推动着AI模型向着更大、更复杂的方向发展,动辄数十亿乃至数千亿参数的巨型模型,通常需要强大的云端算力支持。然而,在追求极致性能的同时,另一股新兴力量正悄然崛起——专注于小型化、本地化的“迷你AI”。Google近期发布的Gemma 3 270M模型,便是这一趋势的杰出代表,它以极小的体积和卓越的效率,为AI的普及和本地化应用开辟了广阔前景。这款仅有2.7亿参数的模型,不仅是Google Gemma系列中的“小巨人”,更预示着AI技术将从云端走向更广阔的边缘设备,深刻改变我们与智能互动的日常体验。

从庞然大物到精巧袖珍:AI模型发展的新拐点

传统的AI开发路径往往遵循“参数越多,性能越好”的理念,这导致了模型体积不断膨胀,对计算资源的需求也水涨船高。这类大型模型通常部署在数据中心,以云服务的形式提供,虽然功能强大,但在隐私保护、响应速度和离线可用性方面存在固有限制。例如,早前发布的Gemma 3系列模型,其参数量就介于10亿至270亿之间,旨在满足不同规模的应用需求。

Gemma 3 270M的出现,则代表了一种新的战略思维:在保证核心功能的前提下,通过极致优化,实现模型的小型化。这里的“参数”指的是模型在学习过程中调整的变量,它们决定了模型如何处理输入数据并生成输出。通常情况下,参数越多,模型的学习能力和泛化能力越强。但Gemma 3 270M在仅有2.7亿参数的情况下,依然能够保持强劲的性能,这得益于Google在模型架构设计、训练数据筛选和量化技术等方面的创新,使其在资源受限的环境下也能展现出令人惊喜的智能。

本地化运行:隐私、速度与成本的三重优势

将AI模型部署到本地设备运行,带来了多方面的显著优势,而Gemma 3 270M正是为此而生:

增强隐私保护:数据无需上传至云端服务器进行处理,用户数据始终留在本地设备,大大降低了数据泄露和滥用的风险。这对于涉及个人敏感信息或商业机密的场景尤为重要,使得医疗、金融等行业的AI应用更加安全可靠。

极低延迟:省去了网络传输和云端排队的环节,本地AI的响应速度近乎实时。用户指令能够瞬间得到处理和反馈,极大地提升了用户体验。例如,在智能助理、实时翻译或创意生成等应用中,低延迟是实现流畅交互的关键。

节约运营成本:减少了对昂贵云端算力的依赖,企业和开发者可以显著降低AI服务的运营成本。对于需要大规模部署AI功能的场景,如智能工厂或物联网设备集群,本地化部署能带来巨大的经济效益。

离线可用性:本地运行的AI模型不受网络连接的限制,即使在无网络环境下也能正常工作。这对于偏远地区、移动办公或应对突发网络故障的场景,提供了极大的便利性和可靠性。

为了验证Gemma 3 270M的效率,Google在一台Pixel 9 Pro手机上进行了测试。结果显示,该模型在Tensor G4芯片上能够同时处理25个对话,并且仅消耗了设备0.75%的电池电量。这一数据令人印象深刻,充分证明了其在移动设备上运行的卓越能效,远超其他同类Gemma模型,为未来智能手机、平板电脑乃至可穿戴设备集成AI功能奠定了坚实基础。

性能超越预期:小模型的大作为

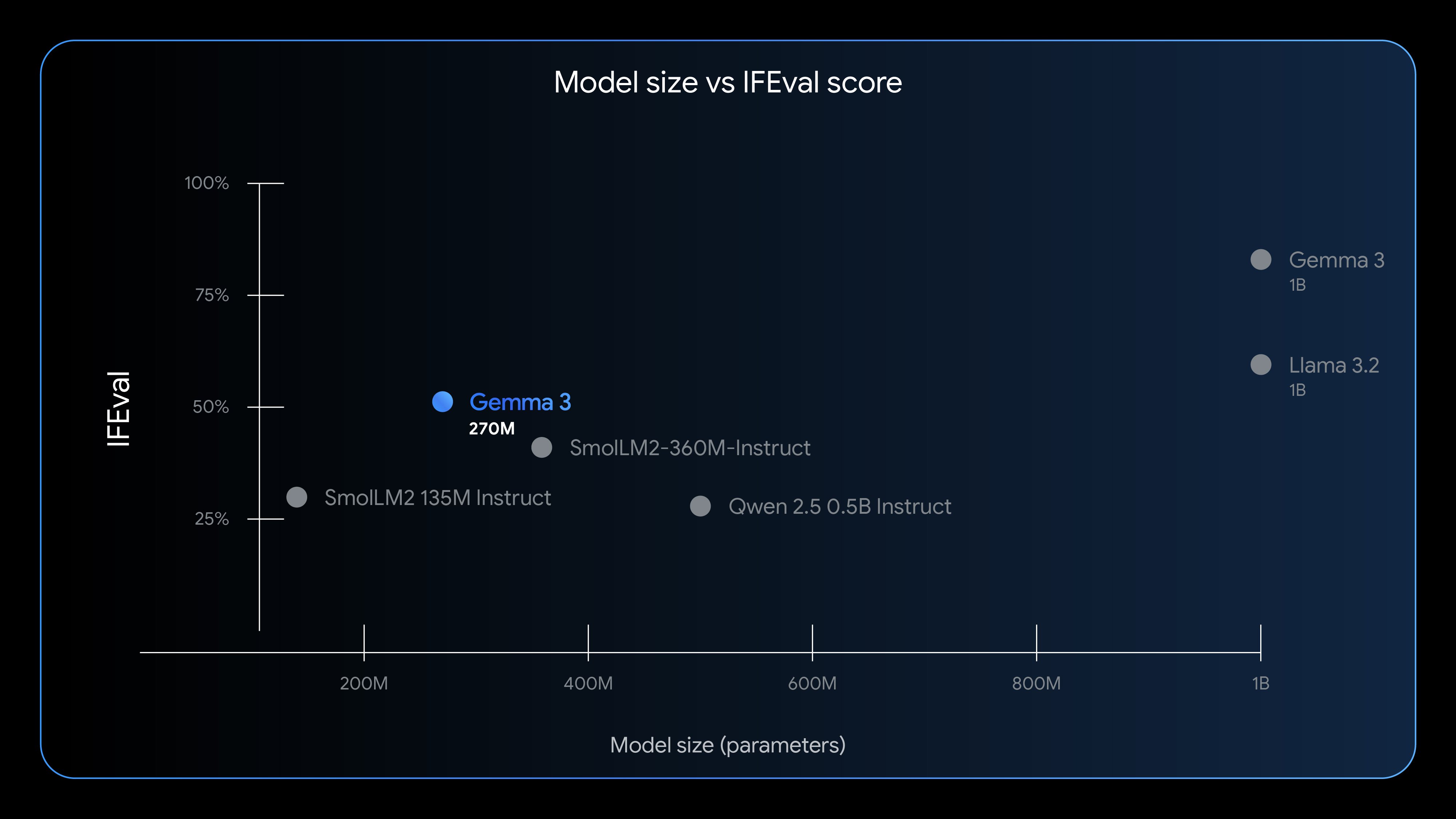

尽管参数量较小,但Gemma 3 270M在特定任务上表现出的性能令人瞩目。Google采用IFEval基准测试来评估模型遵循指令的能力,结果显示Gemma 3 270M在此测试中取得了51.2%的得分,这一成绩甚至超过了一些参数量更大的轻量级模型。这表明,Google在模型结构和训练策略上的优化,有效提升了其单位参数的效能。

当然,我们不能期望Gemma 3 270M能与Llama 3.2这样拥有数十亿参数的巨型模型在所有通用任务上匹敌。但在其设计的特定应用领域,如文本分类、情绪分析、数据提取和轻量级内容生成等,Gemma 3 270M展现出了超乎想象的实用价值和效率。它的核心优势在于,能够以极低的资源消耗,快速且准确地完成这些任务,从而有效弥补了大型模型在边缘设备应用中的空白。

快速微调与多样化应用场景

Google明确指出,Gemma 3 270M在开箱即用状态下就具备强大的指令遵循能力,但其真正的价值在于便捷的微调潜力。由于模型体积小,开发者可以以极低的成本和极快的速度对模型进行定制化微调,使其适应特定的业务需求或领域知识。这一特性对于希望在垂直领域构建专属AI解决方案的开发者而言,无疑是一大利好。

Gemma 3 270M的理想应用场景包括但不限于:

- 文本分类与标签:例如,将用户评论自动归类、识别邮件垃圾信息、对新闻文章进行主题分类,或在客户服务中快速路由请求。

- 数据分析与提取:从非结构化文本中快速提取关键信息、进行趋势分析或生成摘要,提高数据处理效率。

- 个性化推荐系统:在本地设备上分析用户偏好,提供定制化的内容或产品推荐,同时保护用户隐私。

- 智能助理与对话系统:作为轻量级的自然语言理解(NLU)核心,在手机、智能家居设备上提供更快速、更自然的交互体验。

- 边缘计算与物联网:在智能摄像头、传感器等边缘设备上进行实时数据处理和决策,减少对云端的依赖,提升系统响应速度和鲁棒性。

- 教育与辅助工具:在离线环境下提供语言学习辅助、写作批改或信息检索功能。

这种快速、低成本的微调能力,将极大地降低AI开发的门槛,鼓励更多创新应用在边缘设备上涌现,推动AI从少数巨头掌控的云端走向千行百业的本地终端。

“准开放”模式:赋能开发者的同时划定边界

Google将Gemma系列模型定义为“开放”模型,但这与“开源”存在细微差别。尽管如此,开发者依然可以免费下载Gemma 3 270M模型及其权重,并且无需单独的商业许可协议。这意味着开发者可以自由地修改、发布和部署基于Gemma 3 270M的衍生工具和应用,从而极大地促进了其在社区中的传播和创新。

然而,使用Gemma模型仍需遵守其使用条款。这些条款旨在防止模型被用于生成有害内容或故意侵犯隐私。开发者也有责任详细说明对模型的修改,并为所有衍生版本提供一份使用条款副本,这些衍生版本将继承Google的自定义许可。这种“准开放”策略,在鼓励创新的同时,也为AI技术的伦理应用和负责任开发设定了明确的边界,试图在开放性与可控性之间找到一个平衡点,确保AI技术能够向着积极、有益的方向发展。

广泛的可用性与生态系统支持

为了方便开发者获取和使用Gemma 3 270M,Google将其部署在多个主流平台上。目前,开发者可以通过Hugging Face和Kaggle等平台获取Gemma 3 270M的预训练版本和指令微调版本,这些平台提供了丰富的工具和社区支持,便于开发者快速上手。此外,该模型也在Google的Vertex AI平台上提供,方便用户进行测试和集成。Vertex AI作为一个端到端的机器学习平台,可以为Gemma 3 270M的部署、管理和扩展提供全面的支持。

为了进一步展示这款轻量级模型的潜力,Google还特意推出了一款完全基于浏览器运行的睡前故事生成器,该应用构建于Transformer.js之上。这个演示不仅直观地展现了Gemma 3 270M在本地设备上进行内容生成的能力,也为那些对开发轻量级模型感兴趣的非专业用户提供了一个直观的体验入口,让他们能够亲身感受迷你AI带来的乐趣和便利。

迷你AI的深远影响与未来展望

Gemma 3 270M的发布,不仅仅是Google在AI领域的一次技术突破,更是对整个AI产业发展方向的一次重要提示。它表明,AI的未来并非只有“大模型”一条道路可走,“小模型”同样拥有巨大的潜力和广阔的应用空间。

这种迷你AI模型将加速人工智能的民主化进程,使得更多的个人开发者、中小型企业乃至普通用户能够接触和使用AI技术,降低了AI开发的门槛和成本。它将推动AI从云端巨头专属的高端服务,转变为无处不在、触手可及的普惠技术。

展望未来,我们可以预见,Gemma 3 270M这类迷你AI模型将会在智能穿戴设备、智能家居、车载系统、工业物联网以及各类边缘计算设备中扮演越来越重要的角色。它们将赋能设备具备更强的独立思考和决策能力,减少对云端连接的依赖,构建起更加安全、高效、个性化的智能生态系统。随着模型优化技术的不断进步和硬件算力的持续提升,迷你AI的性能边界还将不断被拓展,我们有理由相信,一个由轻量级、本地化AI驱动的智能新时代正在加速到来,它将比以往任何时候都更加贴近我们的生活,并以前所未有的方式改变世界。