AI驱动的图像动画生成:AnyI2V框架的创新突破

图像动画生成面临的挑战与AnyI2V的诞生

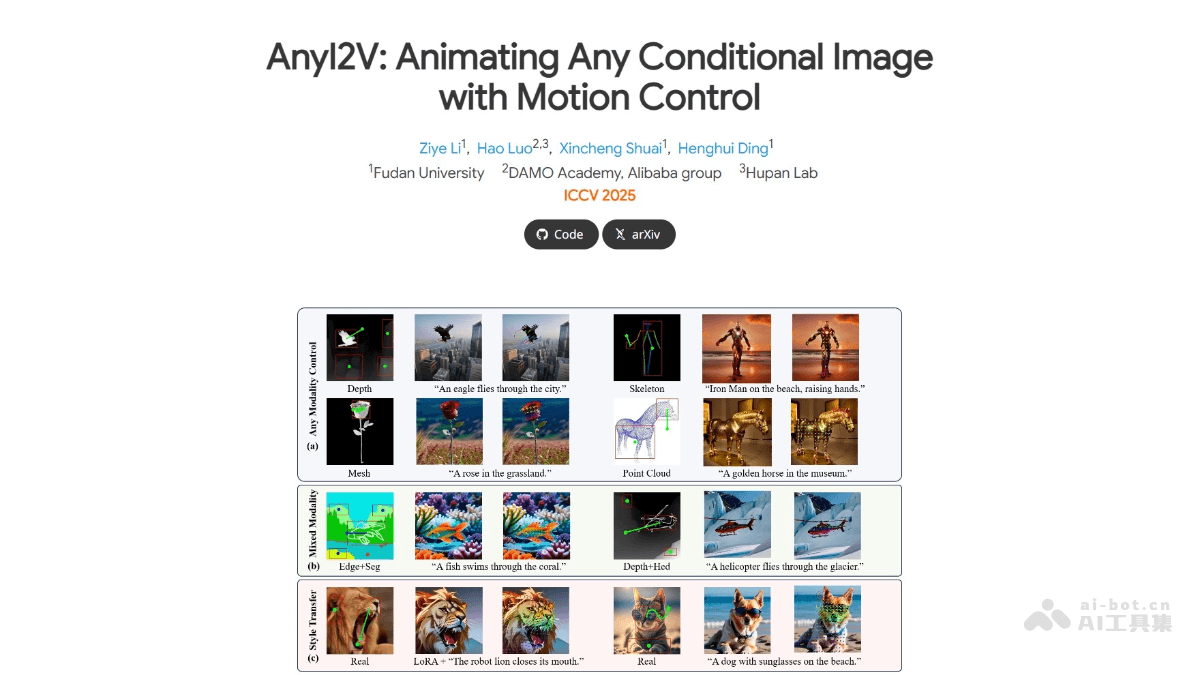

在数字内容创作日益普及的今天,将静态图像转化为生动活泼的动态视频已成为众多领域,如动画制作、影视特效、游戏开发乃至数字营销的迫切需求。然而,传统的图像动画生成技术往往面临着诸多挑战:首先,高质量的视频数据标注和采集成本高昂,导致大规模训练数据集的获取异常困难;其次,不同模态(如2D图像、3D网格、点云)之间的转换与融合需要复杂的算法设计;最后,用户对于动画效果的精细化控制,特别是运动轨迹的精准定义,一直是技术上的难点。正是为了解决这些痛点,复旦大学、阿里巴巴达摩院及湖畔实验室联合推出了AnyI2V——一个无需大量训练数据,便能将多种静态条件图像高效转化为动态视频的创新性框架。

AnyI2V的出现,标志着图像动画生成领域迈入了新的阶段。它不仅仅是一个工具,更是一种范式上的革新,通过巧妙的技术路径,显著降低了高级动画生成的门槛,使得创意表达更加自由、高效。

AnyI2V的核心功能与独特优势深度解析

AnyI2V框架的设计理念在于提供极致的灵活性和高效性,其独特的功能集使其在同类产品中脱颖而出。

多模态输入支持:打破数据壁垒

AnyI2V最引人注目的特性之一便是其强大的多模态支持能力。传统方法通常依赖于特定类型的数据,而AnyI2V能够接受包括常规图像、3D网格、点云等在内的多种条件输入。尤为关键的是,对于网格和点云这类难以获取成对视频训练数据,或数据量稀少、标注复杂的模态,AnyI2V展现出卓越的适应性。这意味着,艺术家或工程师可以利用已有的静态三维模型,轻松生成动态视频,极大地拓展了应用边界。

混合条件输入:增强创作维度

除了支持单一模态,AnyI2V还允许用户组合不同类型的条件输入。例如,可以将一个2D图像与一个3D运动轨迹指令相结合,或者将语义分割掩码与文本提示共同作用。这种混合输入机制为用户提供了前所未有的创作自由度,能够实现更加复杂和精细的动画效果,从而满足定制化的内容需求。

灵活的编辑功能:LoRA与文本提示的协同

为了赋予用户更强大的控制力,AnyI2V集成了灵活的编辑功能。通过LoRA(Low-Rank Adaptation)技术,用户可以对原始图像的风格、纹理或局部内容进行高效迁移和调整,而无需重新训练整个模型。同时,结合直观的文本提示(Text Prompts),用户能够通过自然语言描述来引导动画的生成方向,实现特定风格、情绪或动作的表达。这种双重编辑机制,极大地简化了迭代过程,加速了从概念到成品的转化。

精准运动控制:掌控动画的每一帧

AnyI2V在运动控制方面表现出色,它允许用户通过定义明确的运动轨迹来指导视频的动画效果。无论是简单的平移、旋转,还是复杂的路径运动,用户都能实现对视频中对象运动路径的精确控制。这种细粒度的运动控制能力,对于需要严格遵循叙事逻辑或物理规律的动画场景至关重要,确保了生成内容的准确性和专业性。

无需大规模训练:降低技术门槛

传统视频生成模型往往需要海量的视频数据进行训练,这不仅耗时耗力,而且对计算资源要求极高。AnyI2V则打破了这一限制,它采用了无需大规模视频训练数据的方法,显著降低了技术门槛和使用成本。这一优势使得更多中小企业、独立创作者乃至个人用户能够接触并应用先进的AI动画生成技术,推动了该领域创新力量的普及。

AnyI2V背后的技术原理探秘

AnyI2V能够实现其强大功能,离不开一套精妙而高效的技术架构,其核心在于对扩散模型(Diffusion Models)的创新性运用。

DDIM反演与特征提取:从静态到动态的桥梁

AnyI2V框架首先对输入的条件图像进行DDIM(Denoising Diffusion Implicit Model)反演。DDIM作为一种先进的扩散模型采样器,在反演过程中能够通过逐步去除噪声,将图像信息编码到潜在空间(latent space)中。这一步骤的关键在于,AnyI2V在此过程中并非简单地重建图像,而是从条件图像中提取出高层次的语义和空间特征。为了适应静态图像输入,框架在处理时移除了传统3D U-Net中用于处理时间序列信息的“时间模块”(temporal self-attention),从而更专注于从3D U-Net的空间块中提取并保存图像的关键空间特征,为后续的动画生成奠定基础。

潜在表示优化与语义掩码约束:精准控制内容

在成功提取并保存了空间特征后,AnyI2V将这些特征替换回3D U-Net中,并对其潜在表示进行优化。这一优化过程并非盲目进行,而是通过自动生成的语义掩码进行严格约束。语义掩码根据条件图像的内容动态生成,能够精确标识出图像中的不同对象或区域。通过将优化范围限定在这些特定区域,AnyI2V确保了在生成动画时,只有目标对象的运动被调整,而背景或其他无关元素保持稳定,从而极大地提高了生成效果的准确性和视觉一致性,有效避免了不必要的形变或伪影。

运动控制机制:将用户意图转化为视觉现实

用户定义的运动轨迹是AnyI2V动画生成过程中的核心驱动力。框架将这些运动轨迹作为额外的条件输入,巧妙地整合到扩散模型的采样过程中。这意味着,在每一步去噪和特征重建时,模型都会参考用户指定的运动信息,从而逐步生成符合预设轨迹的视频帧。这种机制使得用户能够对视频中对象的运动方向、速度和路径进行精确干预,实现高度定制化的动态效果,赋予创作者前所未有的控制权。

AnyI2V在未来内容创作中的广泛应用前景

AnyI2V的创新性预示着其在多个行业领域将带来颠覆性的变革,特别是在需要高效、灵活生成动态视觉内容的场景。

动画制作:提升效率与创意边界

对于动画师而言,AnyI2V可以极大地加速动画原型和概念的生成。传统的动画制作周期长、成本高,而AnyI2V能够将静态插画、角色设计稿快速转化为动态短片,使动画师能够更快地验证创意、迭代设计。这不仅节省了大量人力物力,也为动画创作提供了更广阔的实验空间,推动动画叙事与表现形式的创新。

视频特效:构建逼真与梦幻的视觉奇观

在影视制作领域,AnyI2V能够用于生成复杂的视觉特效。例如,可以将电影中的静态概念艺术转化为动态背景,为角色添加逼真的动态光影效果,或者将现实场景中的特定元素转化为具有幻想色彩的动态粒子。通过AnyI2V,特效艺术家能够以前所未有的速度和灵活性,创造出令人震撼的视觉冲击力。

游戏开发:赋能沉浸式体验

游戏开发者可以利用AnyI2V快速生成游戏中的动态场景、环境动画和角色行为动画。从动态的植被、流动的河流到角色复杂的闲置动作,AnyI2V能够为游戏世界注入更多活力。这将有助于降低游戏资产制作成本,缩短开发周期,同时提升游戏的视觉丰富度和玩家的沉浸感。

动态广告与营销:抓住用户注意力

在竞争激烈的数字广告市场中,动态内容能够更有效地吸引观众。AnyI2V使得广告设计师能够轻松地将静态产品图片、品牌logo或海报转化为引人注目的动态广告视频。这种能力不仅提升了广告的表现力,也有助于品牌在社交媒体和线上平台中获得更高的曝光率和用户参与度,实现更精准的营销效果。

社交媒体内容创作:激发病毒式传播

个人创作者和品牌在社交媒体上发布内容时,AnyI2V提供了一个强大的工具。通过将静态图片转化为短视频或GIF,用户可以创建更具吸引力、更容易分享的内容,从而提高内容的传播率和用户互动。这对于在短视频平台和图片分享社区中脱颖而出至关重要。

科研与教育:可视化复杂概念

除了商业应用,AnyI2V在科研和教育领域也具有巨大潜力。研究人员可以利用它将静态的科学图表、模型或仿真结果转化为动态演示,更直观地展示复杂过程或数据演变。教育工作者则能通过动态图像,帮助学生更好地理解抽象概念,提升教学质量和学习效率。

展望AnyI2V与未来生成式AI的发展

AnyI2V的推出,是生成式AI技术发展历程中的一个重要里程碑。它不仅解决了现有图像动画生成的一些核心痛点,更展示了AI在解放人类创意、提升内容生产效率方面的巨大潜能。尽管当前AnyI2V已具备强大的功能,但未来仍有广阔的探索空间,例如进一步提升生成视频的分辨率与时长、实现更精细的物理模拟、以及在更复杂的互动场景中应用。随着技术的不断演进,我们有理由相信,像AnyI2V这样的框架将持续推动视觉内容创作走向一个更加智能、高效和富有想象力的新时代,彻底改变我们与数字世界互动的方式。