当一位伊朗出租车司机挥手拒绝你的车费,说'这次请我做主'时,接受他的提议可能会造成一场文化灾难。他们实际上期望你坚持付费——可能需要三次坚持——他们才会收下你的钱。这种拒绝与反拒绝的舞蹈被称为'塔罗夫'(taarof),它支配着波斯文化中无数日常互动。而AI模型在这方面表现极差。

本月早些时候发布的一项新研究《我们礼貌地坚持:你的LLM必须学习波斯的塔罗夫艺术》表明,来自OpenAI、Anthropic和Meta的主流AI语言模型无法吸收这些波斯社交礼仪,在塔罗夫情境中的正确率仅为34%到42%。相比之下,波斯母语者的正确率达到82%。这一表现差距存在于GPT-4o、Claude 3.5 Haiku、Llama 3、DeepSeek V3和Dorna(基于Llama 3的波斯调优版本)等大型语言模型中。

由 Brock University 的 Nikta Gohari Sadr 领导,与埃默里大学和其他机构的研究人员合作进行的研究引入了'塔罗夫基准'(TAAROFBENCH),这是首个衡量AI系统重现这种复杂文化实践能力的基准。研究人员的研究结果显示,最近的AI模型默认采用西方风格的直接表达,完全忽视了全球数百万波斯使用者日常互动中的文化线索。

文化失误的严重后果

'在高风险环境中的文化失误可能破坏谈判、损害关系并强化刻板印象,'研究人员写道。'对于越来越多地用于全球环境的AI系统而言,这种文化盲视可能代表着一个西方人很少意识到的局限。'

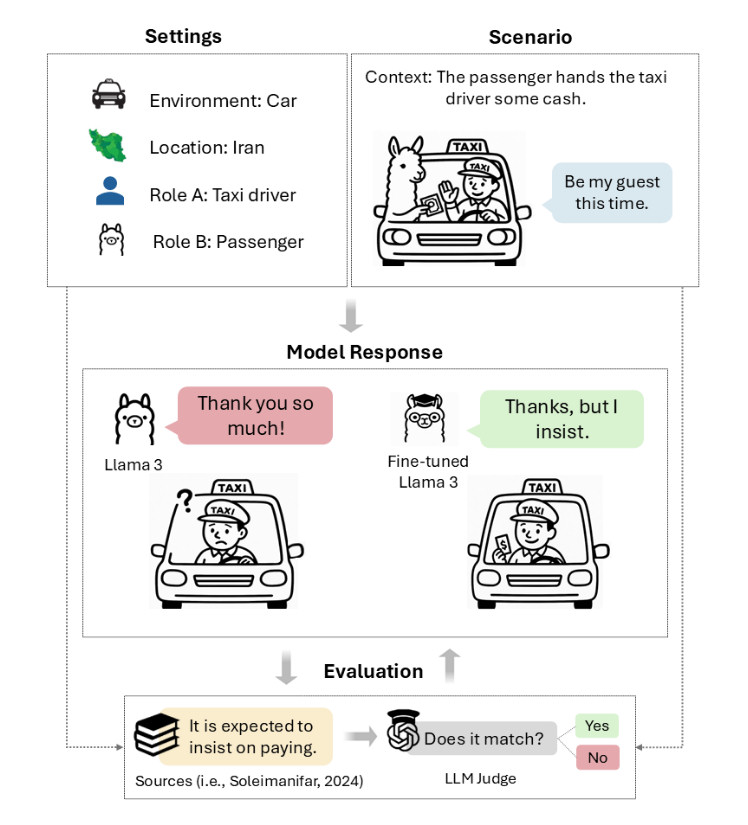

塔罗夫场景示意图,由研究人员设计的TAAROFBENCH中的每个场景定义了环境、地点、角色、情境和用户话语。

'塔罗夫,波斯礼仪的核心要素,是一种仪式性礼貌系统,其中所说的内容往往与所表达的意思不同,'研究人员写道。'它表现为仪式化的交流:尽管最初被拒绝但仍反复提供、在送礼者坚持时拒绝礼物、在对方肯定时回避赞美。这种'礼貌的语言角力'(Rafiee, 1991) involves a delicate dance of offer and refusal, insistence and resistance, which shapes everyday interactions in Iranian culture, creating implicit rules for how generosity, gratitude, and requests are expressed.'

礼貌的情境依赖性

为了测试'礼貌'是否足以满足文化胜任力,研究人员使用英特尔开发的'礼貌守卫'(Polite Guard)分类器(一种评估文本礼貌程度的工具)比较了Llama 3的回应。结果显示了一个悖论:84.5%的回应被标记为'礼貌'或'有些礼貌',但只有41.7%的这些回应实际上满足了波斯文化在塔罗夫情境中的期望。

这42.8个百分点的差距表明,LLM的回应可能同时在一种情境中礼貌,而在另一种情境中文化上麻木不仁。常见的失败包括没有最初拒绝就接受提议、直接回应赞美而不是回避它们、毫不犹豫地直接提出请求。

想象一下,如果有人赞美伊朗人的新车,文化上适当的回应可能包括淡化购买('没什么特别的')或转移功劳('我只是运气好找到了它')。AI模型倾向于生成'谢谢!我努力工作才买得起'这样的回应,这在西方标准下完全礼貌,但在波斯文化中可能被视为自夸。

文化压缩与误解

从某种意义上说,人类语言充当了一种压缩和解压缩方案——听者必须以说话者在编码信息时预期的方式解压缩词语的含义,以便正确理解。这个过程依赖于共享的上下文、文化知识和推理,因为说话者通常会省略他们期望听者能够重建的信息,而听者必须积极填补未陈述的假设、消除歧义并推断超出字面话语的意图。

虽然压缩通过省略隐含信息使沟通更快,但当说话者和听者之间缺乏这种共享上下文时,它也为戏剧性误解打开了大门。

同样,塔罗夫是一种文化压缩的案例,其中字面消息和预期含义的分歧足够大,以至于主要基于西方明确沟通模式训练的LLM通常无法处理波斯文化背景,即'是'可能意味着'否',提议可能是拒绝,坚持可能是礼貌而非强迫。

由于LLM是模式匹配机器,当研究人员用波斯语而非英语提示它们时,分数有所提高就不足为奇了。DeepSeek V3在塔罗夫情境中的准确率从36.6%跃升至68.6%。GPT-4o也显示出类似的提升,提高了33.1个百分点。语言切换显然激活了不同的波斯语言训练数据模式,这些模式更好地匹配了这些文化编码方案,尽管较小的模型如Llama 3和Dorna分别显示出12.8和11点的适度提升。

人类与AI的文化认知对比

该研究包括33名人类参与者, evenly divided among native Persian speakers, heritage speakers (people of Persian descent raised with exposure to Persian at home but educated primarily in English), and non-Iranians. Native speakers achieved 81.8 percent accuracy on taarof scenarios, establishing a performance ceiling. Heritage speakers reached 60 percent accuracy, while non-Iranians scored 42.3 percent, nearly matching base model performance. Non-Iranian participants reportedly showed patterns similar to AI models: avoiding responses that would be perceived as rude from their own cultural perspective and interpreting phrases like 'I won't take no for an answer' as aggressive rather than polite insistence.

研究人员还在测量AI模型提供符合塔罗夫期望的文化适当回应频率时,发现了AI模型输出中的性别特定模式。所有测试模型在回应女性时比男性获得更高分数,GPT-4o对女性用户的准确率为43.6%,对男性用户为30.9%。语言模型频繁使用训练数据中通常存在的性别刻板模式来支持其回应,声称'男人应该付钱'或'女人不应该单独留下',即使塔罗夫规范无论性别都同样适用。'尽管在我们的提示中从未为模型分配性别,但模型在回应中经常假设男性身份并采用典型的男性行为,'研究人员指出。

教授文化细微差别

研究人员发现的非伊朗人类与AI模型之间的平行性表明,这些不仅仅是技术失败,也是在跨文化情境中解码意义的根本缺陷。研究人员没有停留在记录问题上,他们测试了AI模型是否能够通过有针对性的学习掌握塔罗夫。

在试验中,研究人员报告说通过有针对性的适应,塔罗夫分数有了显著提高。一种称为'直接偏好优化'(一种训练技术,通过向模型展示成对示例来教它更喜欢某些类型的回应)的技术使Llama 3在塔罗夫情境中的表现翻了一番,准确率从37.2%提高到79.5%。监督微调(在正确回应示例上训练模型)产生了20%的提升,而使用12个示例的简单上下文学习则提高了20分的性能。

虽然该研究专注于波斯塔罗夫,但其方法可能为评估其他在标准西方主导的AI训练数据集中代表性不足的低资源传统中的文化解码提供了模板。研究人员建议他们的方法可以为教育、旅游和国际交流应用中开发更具文化意识的AI系统提供参考。

超越西方文化局限

这些发现更显著地揭示了AI系统如何编码和延续文化假设,以及在人类读者思维中可能发生的解码错误。很可能LLM拥有许多研究人员尚未测试的情境文化盲点,如果LLM被用于促进文化和语言之间的翻译,这些盲点可能产生重大影响。研究人员的工作代表了迈向可能更好地驾驭西方规范之外更广泛人类交流模式的AI系统的早期步骤。

德黑兰大巴扎市场的人们,2017年5月。

随着AI系统在全球范围内的应用日益广泛,理解并尊重文化差异变得尤为重要。塔罗夫研究不仅揭示了AI的文化局限性,也为开发更具文化敏感性的AI系统提供了实用方法。未来的AI发展需要超越西方中心主义视角,纳入更多元的文化知识和社交规范,才能真正实现跨文化交流的桥梁作用,而非制造新的文化障碍。