将复杂的科学发现总结为非专业受众能够理解的内容,是科学记者日常工作中最重要的任务之一。同时,生成复杂文本的摘要也被频繁提及作为大型语言模型(LLM)的最佳应用场景之一。

然而,美国科学促进会(AAAS)进行的一项为期一年的研究表明,ChatGPT在撰写科学论文摘要时存在明显缺陷,这一发现对AI在科学传播领域的应用提出了重要质疑。

研究背景与方法

从2023年12月到2024年12月,AAAS研究人员每周选择最多两篇论文,使用三种不同详细程度的提示让ChatGPT进行摘要。研究团队重点关注包含技术术语、争议性见解、突破性发现、人类受试者或非传统格式等困难元素的论文。

测试使用了研究期间最新的公开"Plus"版GPT模型,主要涵盖了GPT-4和GPT-4o时代。总共对64篇论文进行了摘要,并由撰写这些论文SciPak摘要的同一批科学记者进行了定量和定性评估。

大型语言模型在尝试总结科学论文时的内部运作情况

主要发现

研究人员发现,ChatGPT能够"勉强模仿SciPak风格摘要的结构",但其文本"往往为了简化而牺牲准确性",需要"SciPak作者的严格事实核查"。

"这些技术可能成为科学记者的有用工具,但目前对SciPak团队而言,它们尚未准备好'正式登场',"AAAS作家Abigail Eisenstadt表示。

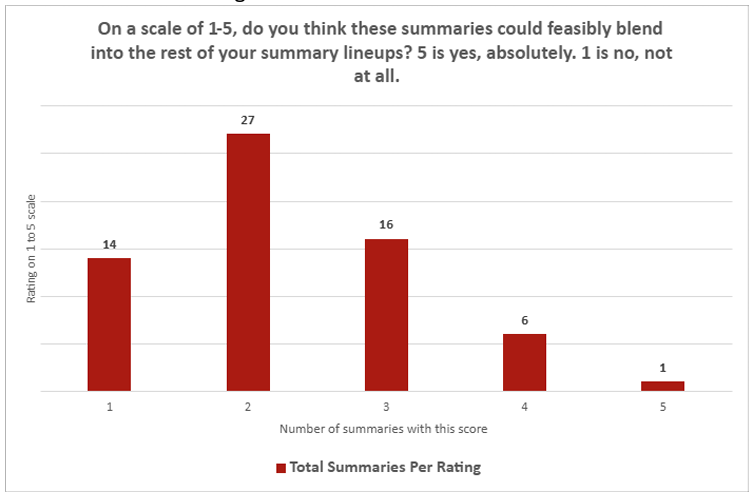

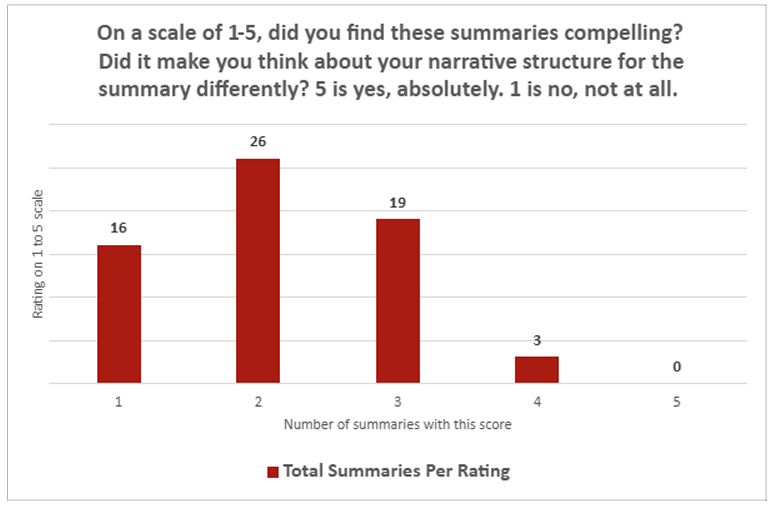

定量评估结果

科学记者对ChatGPT摘要的定量评估结果相当一边倒。在问题"ChatGPT摘要是否能融入您的摘要系列"上,平均得分仅为2.26(1-5分制,1为"完全不",5为"绝对可以")。在问题"摘要是否引人入胜"上,LLM摘要平均得分为2.14。在这两个问题上,只有一份摘要获得了人类评估者的"5"分,相比之下有30个"1"分。

科学记者对AI摘要的评估结果

定性评估问题

在定性评估中,记者们抱怨ChatGPT经常混淆相关性与因果关系,未能提供背景信息(例如,软驱动器通常非常缓慢),并且过度使用"突破性"和"新颖"等词汇夸大结果(尽管当提示特别指出这一点时,这种行为会消失)。

总体而言,研究人员发现ChatGPT通常擅长"转录"科学论文中的内容,特别是当论文没有太多细微差别时。但该模型在"翻译"这些发现方面表现较弱,无法深入探讨方法、局限性或宏观影响。这些弱点在论文提供多个不同结果,或当被要求将两篇相关论文总结为一个简报时尤为明显。

专业标准的差距

尽管ChatGPT摘要的语调和风格通常与人类撰写的内容相匹配,"关于LLM生成内容的事实准确性问题"普遍存在,记者们写道。他们补充说,即使将ChatGPT摘要作为"起点"进行人工编辑,"由于需要广泛的事实核查,所需的工作量与从头撰写摘要相当,甚至更多"。

科学记者对AI摘要专业性的评估

考虑到先前研究表明AI搜索引擎引用错误新闻来源的比例高达60%,这些结果可能并不令人意外。然而,在讨论科学论文时,这些具体弱点更加明显,因为准确性和沟通清晰度至关重要。

研究结论与未来展望

最终,AAAS科学记者得出结论,ChatGPT"不符合SciPak简报包中的风格和标准"。但白皮书也指出,如果ChatGPT"经历重大更新",再次进行实验可能是有价值的。

值得注意的是,GPT-5已于2025年8月向公众发布。这项研究不仅揭示了当前AI工具在科学传播领域的局限性,也为科学记者和研究人员提供了宝贵的见解,即在拥抱AI技术的同时,仍需保持对内容质量和准确性的严格把控。

科学写作的本质挑战

科学写作的核心挑战在于平衡准确性与可读性。科学记者需要深入理解复杂的研究内容,然后将其转化为非专业受众能够理解的形式,同时保持科学严谨性。

ChatGPT在这一过程中表现出几个关键不足:首先,它难以把握科学研究的细微差别和不确定性;其次,它容易过度简化复杂的因果关系;最后,它缺乏对科学领域背景知识的深度理解。

这些局限性凸显了人类科学记者的不可替代性——他们不仅能够准确传达科学内容,还能理解研究的意义、局限性和潜在影响,为读者提供全面而平衡的科学视角。

AI在科学传播中的潜在角色

尽管存在这些局限性,AI工具在科学传播中仍有潜在价值。例如,它们可以帮助:

- 初步筛选:快速扫描大量研究,识别可能值得深入报道的重要发现

- 术语解释:为非专业读者提供科学术语的简单解释

- 多语言翻译:将科学内容翻译成多种语言,扩大传播范围

- 内容结构化:帮助组织复杂信息的框架和结构

然而,这些应用都需要人类科学记者的严格监督和编辑,确保最终内容的准确性和质量。

科学传播的未来

随着AI技术的不断发展,科学传播领域面临着前所未有的机遇与挑战。一方面,AI工具可以提高科学传播的效率和覆盖范围;另一方面,它们也可能带来信息准确性和偏见的新问题。

AAAS的研究提醒我们,在拥抱AI技术的同时,不应忽视科学传播的本质——准确、清晰、平衡地传达科学知识。未来,科学记者可能需要发展新的技能,与AI工具协作,同时保持对内容质量的严格把控。

科学传播的未来可能不是AI取代人类,而是人类与AI的协作——AI处理重复性任务,人类专注于内容质量、深度分析和伦理考量。这种协作模式或许能够创造出更高效、更广泛、更准确的科学传播生态。

结论

AAAS的研究明确指出,尽管ChatGPT等大型语言模型在科学摘要生成方面展现出一定潜力,但它们目前仍无法达到科学传播的专业标准。科学记者在准确性、深度和背景理解方面的专业知识仍然是不可替代的。

这项研究不仅对科学记者有重要启示,也对研究人员、出版机构和科学传播者提出了思考:如何在利用AI技术提高效率的同时,确保科学传播的质量和准确性?

随着AI技术的不断发展,科学传播领域需要持续评估和调整其使用AI的方式,确保科学知识的准确传播,同时为公众提供可靠的科学信息。这不仅是技术问题,更是关乎科学传播本质和价值的重要议题。