在人工智能技术飞速发展的今天,如何有效监管AI已成为全球政策制定者面临的核心议题。美国近期通过的'一揽子美丽法案'(Big Beautiful Bill)为AI监管带来了新的变数,特别是在州级监管与联邦立法之间的平衡问题上。本文将深入分析这一法案如何塑造美国AI监管格局,以及各州独立监管可能带来的机遇与挑战。

州级AI监管的碎片化风险

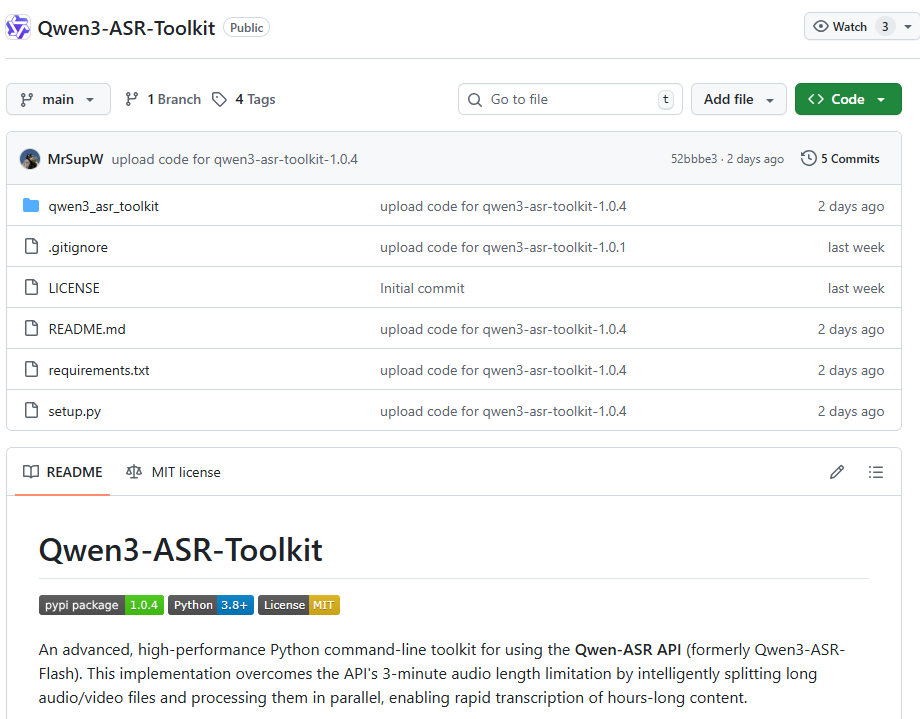

当前,美国各州正在积极推进各自的AI监管立法,这种分散化的监管模式正在形成一幅"法律拼贴画"。根据2025年的美国AI治理法案状态地图,各州在立法进度上呈现出明显的差异,从早期提案到最终通过,颜色编码清晰展示了这一分散进程。

这种州级监管的碎片化趋势带来了多重问题:

- 合规成本增加:企业,特别是中小企业,需要应对各州不同的监管要求,大大增加了合规成本和复杂性。

- 创新阻碍:频繁变化的监管环境使企业难以制定长期技术发展战略,可能减缓AI创新速度。

- 监管套利:企业可能选择监管较为宽松的州设立业务,导致监管效果大打折扣。

正如一位行业观察家所言:"当每个州都有自己的AI规则时,我们实际上创造了一个复杂的迷宫,而不是清晰的监管路径。"

监管的时机困境:过早与过晚的风险

AI监管面临的核心挑战是时机选择。过早监管可能导致基于不完整信息的决策,而过晚监管则可能让潜在风险失控。理想的监管时机窗口往往难以把握。

技术初期的监管陷阱

在AI技术发展的初期阶段,存在一个典型的监管陷阱周期:

- 认知不足期:当新技术尚不被充分理解时,企业和利益相关者可以夸大其益处或危险,而传统和社交媒体往往难以有效核查这些说法。

- 炒作与恐惧期:基于对AI危险的夸大声明,出现机会主义炒作和恐惧营销。一些企业试图利用这种环境推动反竞争法规,阻碍开源和其他竞争性AI发展。

- 理性认知期:随着监管者对AI的理解加深,他们开始认识到技术的实际收益和风险,欧盟AI法案后的调整就是明证。

欧盟的经验教训

欧盟AI法案的实施过程提供了宝贵的经验。法案通过后,许多监管者意识到其中的许多"保护措施"实际上并无实质帮助。随后,欧盟监管机构放松了部分条款,使法案对创新的阻碍程度低于许多观察者的初始担忧。

一位欧盟数字政策顾问表示:"AI监管需要灵活性,技术发展如此之快,固定不变的法规很快就会过时。我们正在学习如何在不扼杀创新的前提下保护公众利益。"

州级AI监管的问题案例分析

加州SB 1047法案的争议

加州提出的SB 1047法案试图对前沿AI系统施加安全要求,但它对模型创作者设置了模糊和/或技术上不可行的要求,以防止有害的下游使用。这类似于如果有人用锤子进行有害用途,就要追究锤子制造者的责任。

批评者指出,该法案存在以下问题:

- 要求开发者预测并防止所有可能的负面用途,这在技术上几乎不可能实现

- 对开源AI项目施加过重负担,可能导致许多有价值的项目被迫停止

- 定义过于宽泛,可能覆盖到许多低风险AI应用

幸运的是,州长加文·纽森(Gavin Newsom)最终否决了SB 1047,认为其"对创新造成的风险大于其带来的潜在益处"。

纽约州法案的担忧

纽约州《负责任AI安全与教育法案》于2024年6月通过州立法机构,等待州长凯西·霍楚尔(Kathy Hochul)的签署或否决。该法案同样对模型构建者设置了模糊且不合理的要求,据称是为了防范理论上的"关键危害"。

行业分析师警告:"纽约法案将严重阻碍开源AI发展,而不会使任何人真正更安全。它基于对AI能力的误解,试图解决不存在的问题。"

德州法案的演变

德克萨斯州《负责任AI治理法案》最初包含了SB 1047的许多有问题的元素。它本会创建不合理的要求,使模型提供商难以合规,而这种合规将等同于安全剧场,不太可能真正提高安全性。

然而,随着德州监管者对AI的理解加深,他们大幅缩减了该法案的范围。州长格雷格·阿博特(Greg Abbott)于6月下旬签署该法案使其成为法律。最终法案专注于特定应用领域,建立了咨询委员会和监管沙盒,并将更多负担放在政府机构而非私营公司身上。

监管与创新的平衡之道

应对有害AI应用的合理监管

并非所有AI监管都是负面的。有些监管措施可以适当限制有害应用,例如:

- 禁止未经同意的深度伪造色情内容

- 防止误导性营销

- 确保AI系统的透明度和可解释性

这些监管措施针对的是具体的应用场景而非技术本身,能够在保护公众利益的同时不阻碍技术创新。

监管沙盒的价值

监管沙盒(Regulatory Sandbox)机制为创新与监管之间的平衡提供了一种有效途径。通过在受控环境中测试新方法,监管者可以在不承担全面风险的情况下获取宝贵经验。

德克萨斯州最终法案中纳入的监管沙盒条款就是一个积极信号,它允许:

- 在有限时间内测试创新AI应用

- 监管者与企业直接合作制定适当的监管框架

- 基于实际证据而非理论假设调整监管要求

更优监管路径的建议

鉴于当前州级AI监管的种种问题,作者提出以下建议:

有限度的监管暂停期

虽然全面的10年监管暂停期可能过于极端,但一个更有限的,例如2年的暂停期,且仅针对最有问题的监管提案,可能会更有通过的机会。这种暂停期将带来以下好处:

- 为监管者提供时间充分理解AI技术

- 减少不负责任的恐惧营销的影响

- 避免在技术尚不成熟时制定出有损行业发展的法规

联邦协调与州级补充

理想的AI监管架构应该是联邦层面制定基本原则和框架,各州在此基础上针对具体问题制定补充规定。这种模式可以:

- 确保全国范围内的一致性

- 允许各州根据当地需求调整具体实施

- 避免监管重叠和冲突

基于风险的分级监管

采用基于风险的分级监管方法,根据AI应用的风险级别采取不同的监管强度:

- 低风险应用:自我监管,行业自律

- 中等风险应用:透明度和问责制要求

- 高风险应用:严格的合规要求和持续监督

全球AI监管趋势比较

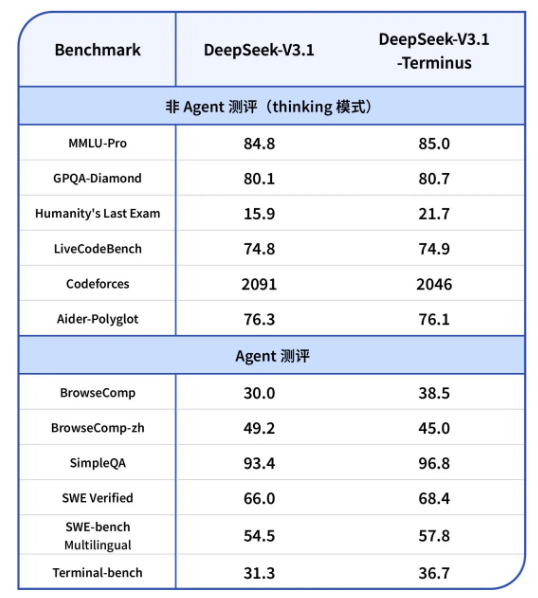

美国与欧盟在AI监管方面采取了不同路径,这反映了各自不同的政策理念和价值观:

| 监管维度 | 美国模式 | 欧盟模式 |

|---|---|---|

| 监管哲学 | 市场驱动,创新优先 | 权利保护,预防原则 |

| 监管层级 | 联邦与州两级协调 | 统一欧盟框架 |

| 监管范围 | 逐步扩大,针对性监管 | 全面覆盖,分级管理 |

| 执行机制 | 行业自律为主,政府监督 | 强制合规,严格处罚 |

这两种模式各有优劣,美国模式的灵活性有利于创新,但可能导致保护不足;欧盟模式的全面性有助于保护,但可能过于僵化。未来,两种模式可能会相互借鉴,形成更加平衡的全球AI监管格局。

未来展望:AI监管的演进方向

随着AI技术的不断发展,监管框架也需要持续演进。未来几年,我们可能会看到以下趋势:

- 动态监管机制:监管要求将能够根据技术发展进行调整,避免法规过时。

- 国际合作加强:各国在AI监管方面的协调将更加紧密,形成全球共识。

- 多方参与治理:政府、企业、学术界和公民社会将共同参与AI治理决策。

- 技术赋能监管:利用AI技术本身来辅助监管过程,提高效率和准确性。

一位领先的AI政策研究员预测:"未来的AI监管将更加注重适应性,不再是静态的规则手册,而是一个能够与技术共同演进的动态系统。"

结论:寻找监管与创新的平衡点

美国'一揽子美丽法案'的通过标志着AI监管进入新阶段,但州级监管的碎片化问题仍然突出。过早且不协调的监管可能阻碍创新,而完全放任又可能导致风险失控。理想的路径是在保护公众利益的同时,为AI创新留出足够空间。

正如一位科技伦理专家所言:"好的AI监管不是限制技术的边界,而是确保技术发展朝着对社会有益的方向前进。监管与创新不是对立面,而是可以相互促进的伙伴。"

在AI技术快速发展的今天,我们需要监管框架既能防范风险,又能不扼杀创新。这需要监管者、开发者和公众之间的持续对话与合作,共同塑造一个既安全又繁荣的AI未来。