在数字化时代,浏览器作为我们连接互联网的重要窗口,其功能的创新与优化直接影响着用户的上网体验。近日,QQ浏览器电脑端迎来v19.8.5版本的重大更新,此次升级不仅在AI功能上实现了显著突破,更在用户体验层面进行了深度优化,为用户带来前所未有的智能浏览新体验。

菜单与功能区布局的全面革新

QQ浏览器此次更新对菜单与功能区布局进行了大刀阔斧的改革。以往藏匿较深、需要多次点击才能找到的书签、历史记录等常用工具入口,此次被悉数挪至菜单顶部,实现了一点即达的便捷操作。这一改变极大地提升了用户的操作效率,减少了不必要的点击次数。

用户还可根据个人使用习惯,一键将这些常用功能固定至右上角,实现随叫随到的便捷体验。这种个性化的设计理念,体现了QQ浏览器对用户需求的深入洞察和精准把握。

更为贴心的是,当鼠标悬停在书签或历史记录上时,二级面板将自动弹出,用户可一眼看清最近浏览记录和收藏内容。这种即时反馈的设计,让信息获取变得更加直观高效。

同时,所有已固定的功能模块,如AI+区域、插件区、菜单功能区等,均支持自由拖拽排序,用户可完全按照自己的喜好来决定各模块的位置。这种高度个性化的界面定制能力,让每个用户都能打造专属自己的浏览环境。

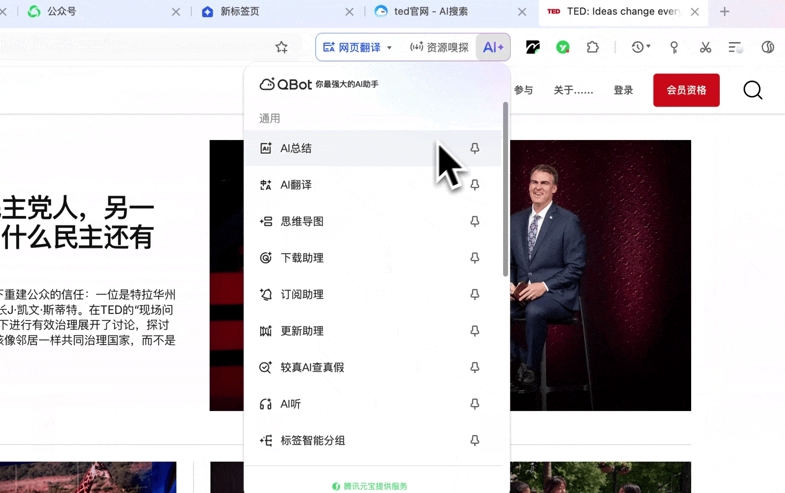

AI+小窗功能的多任务处理革命

AI+小窗功能在此次更新中得到了全面升级,成为本次更新的最大亮点。当用户打开外文网页查资料,或是在进行总结、思维导图等任务时,AI+小窗如今已支持多任务同时处理。

这一功能的革新彻底改变了以往只能单一使用AI功能的局限,用户可边让AI总结要点,边查看思维导图,同时还能开启订阅助理,实时跟踪关注的信息。每个窗口独立运行,互不干扰,用户可根据需要随时切换,告别手忙脚乱,工作效率实现翻倍提升。

这种多任务并行处理的能力,特别适合现代快节奏的工作环境。用户可以在一个界面内完成多种任务,无需在不同应用间频繁切换,大大节省了时间和精力。对于需要同时处理多个任务的用户而言,这一功能无疑是一大福音。

较真AI:网络信息真伪的守护者

针对网络上真假难辨的信息,AI+小窗还新增了较真AI功能,可一键查证信息真伪,为用户提供更加安全可靠的浏览环境。在信息爆炸的时代,辨别信息的真伪成为了一项重要技能,而较真AI功能正是QQ浏览器为解决这一痛点而推出的创新方案。

该功能通过先进的AI算法,能够快速分析网络信息的可信度,为用户提供权威的查证结果。无论是新闻报道、学术资料还是日常信息,用户都可以通过这一功能快速了解其真实性,有效避免被虚假信息误导。

这一功能的推出,体现了QQ浏览器对用户信息安全的重视,也展现了AI技术在信息甄别领域的应用潜力。通过技术创新,QQ浏览器不仅提升了用户体验,更在维护网络信息生态方面发挥了积极作用。

标签智能分组:解决'千层饼'痛点

标签页管理方面,QQ浏览器此次也推出了创新功能。针对以往标签页堆叠如'千层饼',找个页面需要翻找多次的痛点,新增的标签智能分组功能可按照网页内容和域名对标签进行自动划分,杂乱标签瞬间变得整齐有序。

这一功能的实现基于先进的AI算法,能够智能识别网页内容的关联性,并将相似内容的标签页自动归类。用户查找页面如同在文件夹中找东西一般方便,大大提升了标签页管理的效率。

对于经常需要同时打开多个网页的用户而言,这一功能无疑解决了长期以来的痛点。通过智能分组,用户可以快速定位到需要的页面,无需在众多标签页中苦苦寻找,极大地提升了工作效率。

网页语音朗读:让网页能'听'

除了上述功能升级外,QQ浏览器此次更新还解锁了一项新技能——网页语音朗读,即网页能'听'了。当用户查资料眼睛疲劳时,现在可以用耳朵'听'网页内容,无论是新闻、攻略还是小说,统统支持语音朗读。

这一功能的推出,体现了QQ浏览器对用户健康和多元化需求的关注。在长时间使用电脑的情况下,眼睛容易疲劳,而语音朗读功能则提供了一种休息眼睛的方式,让用户可以在不停止信息获取的同时,减轻视觉负担。

AI播客和原生朗读双模式可智能切换,朗读效果自然不尴尬。同时,用户还可根据个人吸收节奏,进行15秒精准进退和5档倍速调节,想快就快,想慢就慢。这种个性化的朗读设置,让每个用户都能找到最适合自己的聆听方式。

AI技术深度整合的浏览器新标准

此次QQ浏览器的更新,不仅仅是功能的简单叠加,更是AI技术与浏览器深度融合的体现。从多任务处理的AI+小窗,到信息真伪查证的较真AI,再到标签智能分组和网页语音朗读,AI技术贯穿于此次更新的各个功能模块。

这种深度整合的AI应用模式,正在重新定义浏览器的功能边界和使用方式。传统的浏览器主要提供信息展示和导航功能,而AI技术的加入则使其具备了信息处理、智能分析和个性化服务的能力,成为用户的智能上网助手。

随着AI技术的不断发展,浏览器作为用户与互联网交互的重要入口,其智能化程度将成为衡量用户体验的重要指标。QQ浏览器此次更新,无疑在这一领域走在了前列,为行业树立了新的标杆。

用户体验的全方位提升

除了AI功能的创新,QQ浏览器此次更新还注重用户体验的全方位提升。从界面布局的优化,到操作流程的简化,再到个性化设置的丰富,每一个细节都体现了以用户为中心的设计理念。

菜单与功能区布局的调整,让常用功能触手可及;标签智能分组功能,解决了长期困扰用户的标签页管理难题;网页语音朗读功能,则满足了用户在不同场景下的使用需求。这些改进看似细微,却实实在在地提升了用户的日常上网体验。

用户体验的提升不仅体现在功能设计上,还表现在对用户需求的深入理解和快速响应上。QQ浏览器通过持续的用户调研和数据分析,不断挖掘用户痛点,针对性地推出解决方案,形成了产品迭代与用户需求之间的良性互动。

智能浏览的未来发展趋势

QQ浏览器此次更新,不仅是对现有功能的优化,更是对未来智能浏览趋势的前瞻性探索。随着AI技术的不断发展和应用场景的不断拓展,浏览器将朝着更加智能化、个性化和高效化的方向发展。

多任务处理能力将成为浏览器的标配,用户可以在一个界面内完成多种复杂任务;信息甄别功能将更加精准,帮助用户在海量信息中快速找到有价值的内容;语音交互将更加自然,实现人与浏览器之间的无缝沟通。这些趋势正在逐步成为现实,而QQ浏览器已经走在了这一变革的前沿。

未来,随着AI技术的进一步发展,浏览器可能会进化为真正的智能助手,能够理解用户的真实需求,主动提供个性化服务,甚至在用户开口之前就预判其需求。这种智能化的演进,将彻底改变我们与互联网交互的方式,开启智能浏览的新纪元。

结语

QQ浏览器电脑端v19.8.5版本的更新,通过AI技术的深度整合和用户体验的全方位优化,为用户带来了前所未有的智能浏览新体验。从多任务处理的AI+小窗,到信息真伪查证的较真AI,再到标签智能分组和网页语音朗读,每一项功能都体现了创新与实用的完美结合。

此次更新不仅解决了用户长期以来的痛点,更通过技术创新重新定义了浏览器的功能边界和使用方式。随着AI技术的不断发展,我们有理由相信,QQ浏览器将继续引领智能浏览的潮流,为用户带来更多惊喜和可能。