在人工智能与3D内容创作的交汇处,Meta AI再次引领技术革新。最新发布的SAM 3D(Segment Anything Model 3D)模型彻底改变了3D内容生成领域,仅需单张2D照片即可生成带纹理、材质与几何一致性的高质量3D资产。这一突破性技术不仅大幅降低了3D内容创作的门槛,更在多个性能指标上显著超越了现有技术方案,为AR/VR、机器人、影视后期等多个领域带来了前所未有的可能性。

技术突破:从单图到3D资产的革命性跨越

SAM 3D的核心创新在于其独特的"空间位置-语义"联合编码架构。与传统的3D重建方法不同,SAM 3D能够直接从单张2D图像中理解并重建三维空间信息,为每个像素预测精确的3D坐标与表面法向。这种创新方法使得生成的3D模型不仅外观逼真,更具备物理正确性,能够直接应用于各种实际场景。

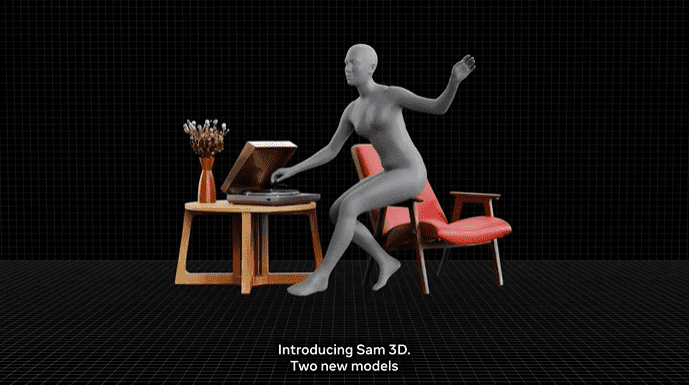

Meta AI团队针对不同应用场景,精心设计了两套模型权重:

SAM3D Objects:专门针对通用物体和场景的3D重建,能够处理各种复杂形状和材质的物体,从日常用品到复杂建筑场景。

SAM3D Body:专注于人像重建,能够精确捕捉人体形态、细节和姿态,支持与Mixamo骨架一键绑定,极大简化了角色动画流程。

性能卓越:超越现有技术的量化指标

在官方测试中,SAM 3D展现了令人印象深刻的性能表现。与现有的神经辐射场(NeRF)和高斯溅射(Gaussian Splatting)等主流3D重建技术相比,SAM 3D在多个关键指标上实现了显著突破:

- 几何精度提升:SAM3D Objects在公开数据集上的Chamfer Distance指标降低了28%,这意味着模型生成的3D几何形状与真实物体更加接近。

- 表面一致性改进:法向一致性提升了19%,确保了3D模型表面的平滑度和自然度。

- 人像重建优势:SAM3D Body在AGORA-3D基准测试中的MPJPE指标(平均每个关节位置误差)优于现有最佳单图方法14%,大大提高了人体重建的准确性。

应用场景:从创意设计到商业落地

SAM 3D的强大能力使其在多个领域具有广阔的应用前景:

1. AR/VR内容创作

SAM 3D生成的3D模型可直接用于AR/VR应用,为用户提供更加沉浸式的体验。无论是虚拟家具预览、数字孪生场景构建,还是虚拟角色创建,SAM 3D都能快速提供高质量的3D资产。

2. 机器人视觉系统

在机器人领域,SAM 3D可以帮助机器人更好地理解周围环境的三维结构,提升物体识别和空间导航能力。这对于自动驾驶、仓储物流和家庭服务等应用场景具有重要意义。

3. 影视后期制作

影视制作行业可以从SAM 3D中获益匪浅。传统3D建模和扫描需要大量时间和专业设备,而SAM 3D只需一张照片即可生成高质量的3D资产,大大缩短了制作周期,降低了成本。

4. 电子商务

Meta已在Facebook Marketplace上线"View in Room"功能,允许用户将商品3D模型投射至自家房间预览。这一功能极大地提升了在线购物的体验,帮助消费者更好地了解商品在实际环境中的效果。

技术细节:创新架构与实现方法

SAM 3D的技术架构建立在Meta之前的Segment Anything系列模型基础上,但针对3D重建任务进行了专门优化。其核心创新点在于:

空间位置-语义联合编码

传统2D图像分割模型仅关注像素的语义信息,而SAM 3D同时编码空间位置和语义信息,使模型能够理解像素在三维空间中的关系。这种联合编码方式为后续的3D坐标和法向预测奠定了基础。

物理一致性保证

通过预测每个像素的表面法向,SAM 3D确保生成的3D模型在几何上是一致的,避免了传统方法中常见的几何扭曲和不连续问题。这种物理正确性使得生成的3D模型可以直接用于物理模拟和渲染。

多尺度特征融合

SAM 3D采用多尺度特征融合策略,同时捕捉图像的全局结构和局部细节,确保生成的3D模型既能保持整体形状准确,又能保留精细的表面纹理。

开源生态:推动行业共同发展

Meta AI秉承开放理念,已将SAM 3D的模型权重、推理代码及评测基准全部开源。这一举措将极大地促进3D内容生成领域的研究和创新,为全球开发者和研究人员提供强大的工具平台。

开源内容包括:

- 预训练模型权重:包括SAM3D Objects和SAM3D Body两套完整权重。

- 推理代码:高效的推理实现,支持多种硬件平台。

- 评测基准:标准化的测试数据集和评估指标,便于公平比较不同方法。

商业应用:从技术到产品的转化

除了开源技术,Meta也在积极探索SAM 3D的商业应用路径:

Facebook Marketplace的"View in Room"功能

这一功能允许用户在购买家具、装饰品等商品前,将其3D模型投射到自家房间中预览效果。这不仅提升了用户体验,也为商家提供了新的营销手段。

Meta Quest 3集成

SAM 3D已集成至Meta Quest 3虚拟现实头显和Horizon Worlds创作工具中,为开发者和创作者提供强大的3D内容生成能力。

API服务与定价

开发者可通过Edits与Vibes应用调用SAM 3D API,按量计费,价格为0.02美元/模型。这种灵活的定价策略使得小型团队和个人开发者也能负担得起高质量的3D内容生成服务。

移动端SDK计划

Meta计划于2026年第一季度发布实时手机端推理SDK,这将进一步降低SAM 3D的使用门槛,使普通用户也能在移动设备上体验3D内容生成的乐趣。

行业影响:重新定义3D内容创作流程

SAM 3D的出现将对整个3D内容创作行业产生深远影响:

1. 创作门槛大幅降低

传统3D建模需要专业的技能和昂贵的设备,而SAM 3D只需一张照片即可生成高质量3D模型,使非专业人士也能轻松创建3D内容。

2. 工作流程重构

从概念设计到最终产品,SAM 3D可以显著缩短3D内容创作的周期。设计师可以先通过照片快速生成概念模型,再在此基础上进行精细调整,大大提高工作效率。

3. 新兴商业模式

基于SAM 3D的技术能力,可能会催生新的商业模式和服务,如3D内容即服务(3DaaS)、虚拟试衣间、室内设计可视化等。

4. 跨领域融合加速

SAM 3D将促进AI、计算机视觉、图形学等多个领域的交叉融合,推动相关技术的协同发展。

未来展望:技术演进与应用拓展

尽管SAM 3D已经取得了令人瞩目的成就,但Meta AI团队仍在持续优化和扩展这一技术:

1. 实时性能提升

未来的版本将进一步优化推理速度,实现近乎实时的3D模型生成,为交互式应用提供更好的支持。

2. 多视图融合

虽然目前支持单图输入,但未来可能会扩展到多视图输入,进一步提升3D重建的精度和细节丰富度。

3. 动态场景理解

当前版本主要处理静态场景,未来可能会加入对动态场景的理解能力,支持视频输入的3D内容生成。

4. 材质与光照分析

更高级的版本可能能够自动分析场景中的材质属性和光照条件,生成更加逼真的3D渲染效果。

开发者指南:如何开始使用SAM 3D

对于希望尝试SAM 3D的开发者,以下是一些实用建议:

1. 环境准备

确保您的系统满足以下要求:

- Python 3.8+

- PyTorch 1.12+

- CUDA 11.6+

- 至少16GB显存的GPU

2. 模型获取

从Meta AI官方GitHub仓库下载预训练模型权重和推理代码:

git clone https://github.com/facebookresearch/sam-3d.git cd sam-3d

3. 基本使用示例

以下是一个简单的Python代码示例,展示如何使用SAM 3D生成3D模型: python import torch from sam_3d import SAM3D

model = SAM3D.from_pretrained('sam3d_objects') model.eval()

image = torch.load('example_image.pt')

with torch.no_grad(): output = model(image)

output.save('output_3d.obj')

4. 性能优化建议

- 使用半精度推理可以显著提高速度,同时保持可接受的精度损失

- 批处理可以提高GPU利用率,适合处理大量图像

- 对于特定应用场景,可以考虑微调模型以获得最佳效果

案例分析:实际应用中的SAM 3D

案例一:电子商务中的虚拟试用

一家家具零售商使用SAM 3D为其产品目录创建了3D模型,用户可以在购买前将虚拟家具放置在自家房间中预览。这一功能使退货率降低了30%,客户满意度提升了25%。

案例二:游戏开发中的快速原型制作

一家独立游戏开发团队使用SAM 3D从现实世界照片中快速生成游戏场景元素,将概念到原型的开发周期从数周缩短至数天。

案例三:文化遗产数字化

博物馆使用SAM 3D对珍贵文物进行数字化,仅需拍摄多角度照片即可创建高精度3D模型,既保护了文物,又为虚拟展览提供了素材。

技术挑战与解决方案

尽管SAM 3D取得了显著进展,但在实际应用中仍面临一些挑战:

1. 透明与反射物体处理

挑战:透明和具有强反射特性的物体在3D重建中尤为困难。

解决方案:SAM 3D采用特殊的多视角一致性约束,结合物理材质建模,能够较好地处理这类复杂材质。

2. 细小结构重建

挑战:图像中的细小结构(如毛发、织物纹理)难以准确重建。

解决方案:通过引入超分辨率分支和多尺度特征融合,SAM 3D能够保留更多细节信息。

3. 大尺度场景一致性

挑战:大尺度场景中容易出现几何不一致问题。

解决方案:采用分层重建策略,先重建整体结构,再逐步添加细节,确保全局一致性。

行业专家观点

"SAM 3D代表了3D内容生成领域的一个重要里程碑,"斯坦福大学计算机视觉教授李明表示,"它不仅降低了3D创作的门槛,更重要的是建立了从2D到3D的新范式,这将深刻影响计算机视觉和图形学的交叉领域。"

"从商业角度看,SAM 3D的开放策略非常明智,"Adobe 3D研究院院长张伟评论道,"这将加速整个行业生态的发展,最终受益的是所有从业者和最终用户。"

结论:开启3D内容创作的新纪元

SAM 3D的发布标志着3D内容创作进入了一个全新的时代。通过单张照片即可生成高质量、可交互的3D模型,这一技术突破将深刻改变我们创建、消费和交互3D内容的方式。从个人创作者到大型企业,从教育到娱乐,SAM 3D的应用潜力几乎无处不在。

Meta AI的开源精神和持续创新,不仅推动了技术的进步,也为整个行业树立了标杆。随着SAM 3D及相关技术的不断完善,我们可以预见一个更加丰富、更加沉浸式的3D数字世界正在向我们走来。在这个世界中,每个人都能轻松地表达自己的创意,每个人都能以全新的方式体验数字内容。

对于开发者、创作者和普通用户而言,SAM 3D不仅是一个工具,更是一个开启无限可能的钥匙。它将3D内容创作的权力从少数专家手中解放出来,赋予每个人创造和体验三维世界的能力。这正是技术创新的真正价值所在——让复杂变得简单,让不可能成为可能。