人工智能领域正经历前所未有的技术突破与资本狂潮。谷歌最新发布的Gemini 3 Pro模型以碾压性优势领跑多模态AI赛道,而微软与英伟达联手向Anthropic注资150亿美元,进一步加剧了科技巨头的AI军备竞赛。与此同时,AI教育应用斑马口语的上线,以及Cloudflare网络中断事件,共同勾勒出AI技术从实验室走向产业应用的全景图。

Gemini 3 Pro:多模态AI的里程碑

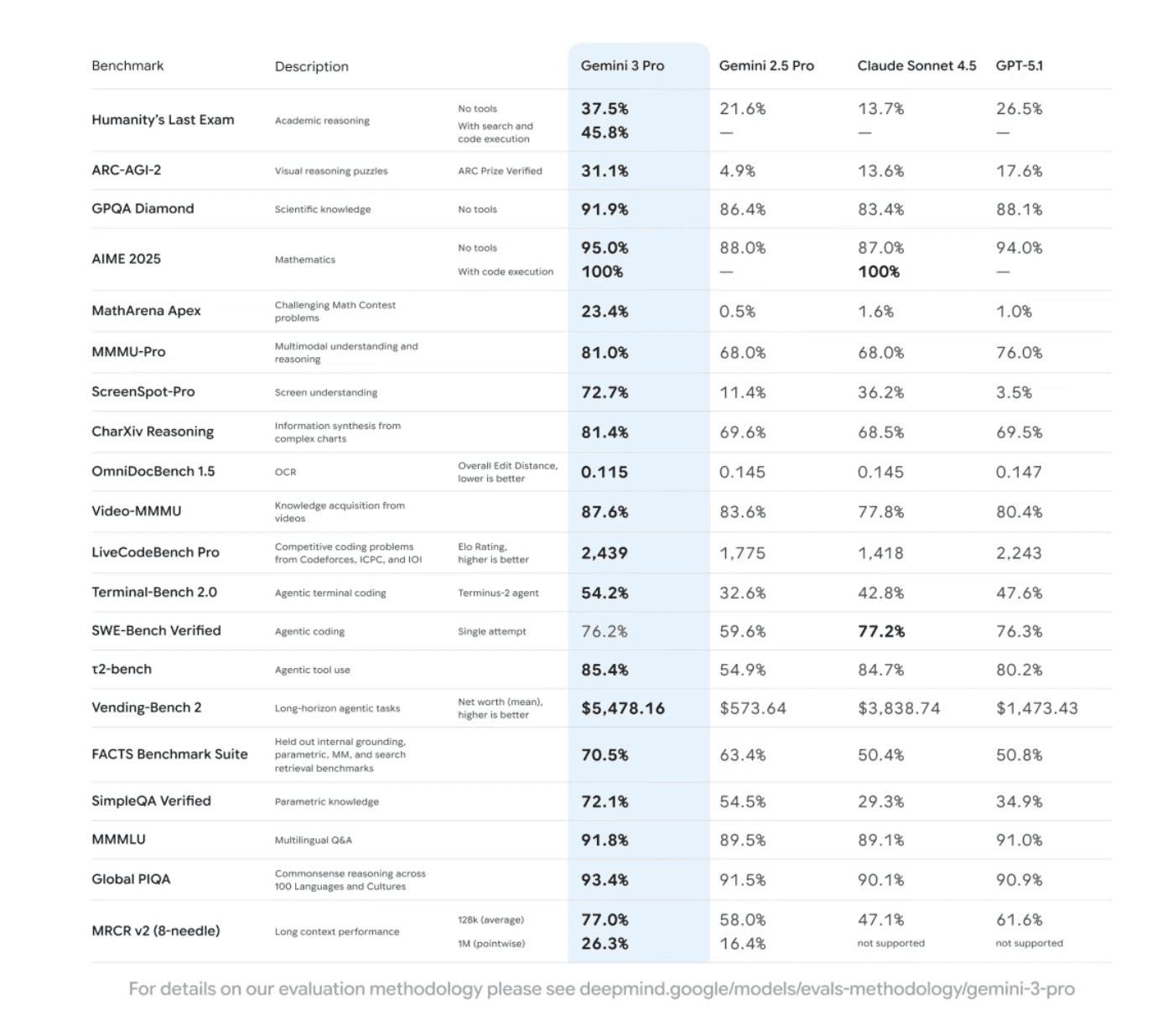

11月19日,Google在Google AI Studio上正式推出Gemini 3 Pro的Preview版本,这一旗舰模型凭借卓越性能成为当前全球最强AI大模型之一。根据Google公布的Model Card数据,Gemini 3 Pro在多个关键基准测试中展现出"碾压"级优势,彻底改变了AI技术的竞争格局。

数学与推理能力的飞跃

在极高难度的数学竞赛基准MathArena中,其他模型的正确率仍停留在1%左右,而Gemini 3 Pro直接达到23.4%,实现了数量级的突破。在Humanity's Last Exam(人类最终大考)上,Gemini 3 Pro以37.5%的成绩大幅领先于GPT-5.1和Claude Sonnet 4.5等竞品。Google还透露,未公开的Deep Think深度推理模式可进一步提升其表现,为解决复杂问题提供了全新可能。

视觉智能的革命性突破

最具突破性的是Gemini 3 Pro的视觉智能能力。在屏幕理解(ScreenSpot-Pro)测试中,它达到72.7%的准确率,几乎是GPT-5.1的20倍。这一突破意味着AI Agent能够首次"真正看懂屏幕",大幅提升自动化操作电脑的能力,为人机交互开辟了全新维度。

尽管在SWE-Bench Verified等纯编程测试中未能登顶,Gemini 3 Pro仍保持第一梯队的实力,特别擅长前端设计、交互动画与3D应用等更具创造性的任务,展现出多领域的技术适应性。

Agentic编程平台的推出

除模型本身外,Google同步发布了全新的Agentic编程平台Antigravity。这一平台提出"智能体优先"的编程范式,可让多个AI Agent并行执行任务,例如自动写代码、运行终端测试、打开浏览器验证UI,并能自主修复错误。这一创新被视为对Cursor等AI编程工具的直接挑战,有望彻底改变软件开发的工作流程。

科技巨头AI投资热潮:微软英伟达联手注资Anthropic

11月18日,微软、英伟达和Anthropic宣布建立新的战略合作伙伴关系,标志着AI领域投资规模的再次升级。根据协议,英伟达和微软将分别向Anthropic投资至多100亿美元和50亿美元,而Anthropic则承诺购买价值300亿美元的Azure计算能力。

这笔巨额投资反映了科技巨头对AI未来的坚定信心。Anthropic作为OpenAI的主要竞争对手之一,其专注于AI安全与对齐研究的定位,与微软和英伟达的云计算与AI芯片能力形成互补,三方合作有望加速AI技术的商业化进程。

AI教育创新:斑马口语开创一对一外教新模式

11月18日,全球首个AI外教一对一产品斑马口语正式上线,标志着AI技术在教育领域的深度应用。该产品基于猿力大模型打造,具备超人类教学能力、记忆力、知识储备和"超温暖人格",能实现低延迟实时对话、精准发音纠错,并根据学生兴趣动态调整教学内容。

斑马口语通过"2+1+1"学习模式和生活化场景设计,让孩子在真实语境中提升表达能力,有效解决了传统外教行业水平参差不齐、教学效果难以保障的痛点。作为教育领域首个实现规模化落地的AI Agent产品,斑马口语为AI在教育垂直领域的商业化提供了可复制的实践范本。

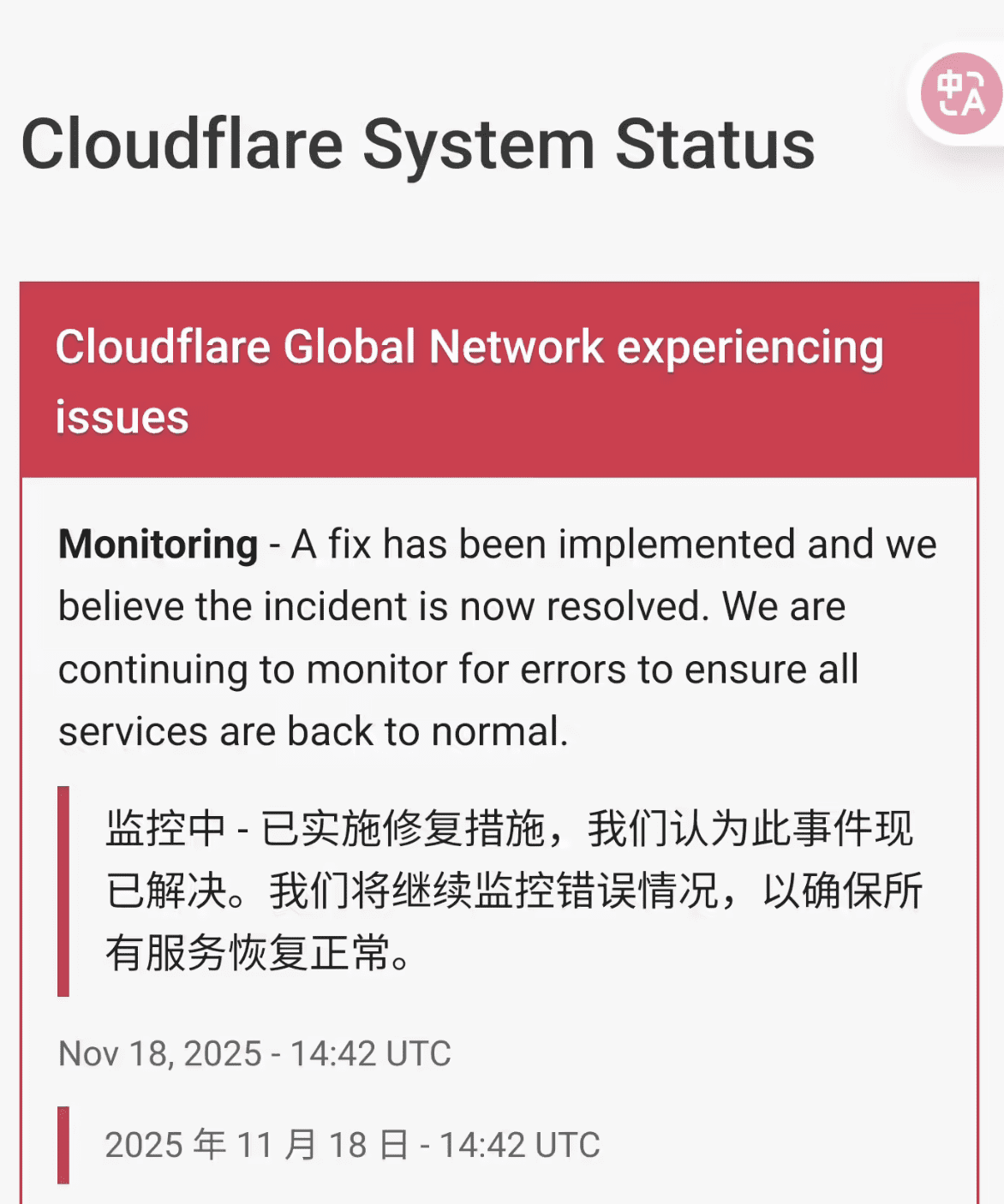

网络基础设施危机:Cloudflare故障引发连锁反应

11月18日,美国网络安全服务商Cloudflare遭遇波及全球的大规模网络故障,导致ChatGPT、社交媒体平台X等多家网站部分用户无法正常访问。这一事件凸显了AI时代网络基础设施的关键作用与潜在风险。

Cloudflare作为全球数十万家企业的软件服务提供商,扮演着网站与终端用户之间的"缓冲器"角色,旨在保护客户网站免受大流量攻击导致瘫痪的威胁。然而,其自身故障状态页面一度也无法打开,颇具讽刺意味。

据网络故障监测平台Downdetector.com数据显示,截至美东时间早上6:41,X平台已收到超过11500份问题报告。截至北京时间晚上九点,ChatGPT、X等平台的许多用户依旧无法正常使用相关应用。

AI泡沫风险与行业反思

在AI投资热潮中,理性声音同样值得关注。11月18日,谷歌CEO桑德尔·皮查伊在一次独家专访中警告,如果当前的AI投资泡沫破裂,其影响将波及每一家公司,包括Alphabet自身。

皮查伊指出,尽管AI投资的增长标志着一个"非凡的时刻",但目前的AI热潮中也存在一些"不理性"的现象。虽然Alphabet的市值在七个月内翻了一倍,达到3.5万亿美元,但皮查伊强调:"我认为没有哪家公司会免于影响,包括我们自己。"

他回顾互联网历史时表示:"我们可以回顾互联网的历史,明显存在过度的投资,但没有人会质疑互联网的深远影响。"因此他强调,AI将对工作产生深远影响,并呼吁人们在使用AI工具时不要"盲目相信",因为这些模型容易出错。

此外,皮查伊也对AI的巨大能源需求发出警告,指出去年AI消耗的电量已占全球总电力消耗的1.5%,并强调需要开发新的能源来源和扩大能源基础设施,以避免对全球经济造成约束。

传统科技企业的AI转型:小米与拼多多的财报表现

在AI技术浪潮中,传统科技企业也在积极转型。小米集团发布的2025年第三季度财报显示,该季度总收入达1131亿元,同比增长22.3%,连续4个季度突破千亿;经调整净利润为113亿元,同比大增80.9%,创历史新高。

小米汽车业务及AI等创新业务成为财报中的一大亮点,三季度收入飙升至290亿元,同比增长199.2%,创历史新高。尤为关键的是,该业务分部首次实现单季度经营盈利,实现单季经营收益7亿元。

小米集团合伙人、集团总裁卢伟冰在业绩电话会上透露,小米汽车预计将于本周完成全年35万台的年度交付目标。同时,小米17系列手机销量已破200万,是双十一期间唯一能对抗苹果iPhone的产品。

与此同时,拼多多发布2025年第三季度财报,公司第三季度营收1,082.8亿元,同比增长9%,预估1,075.9亿元;调整后净利润313.8亿元,同比增长14%,预估251.2亿元。"千亿扶持"计划继续加大对生态建设的投入,持续为商家减免服务费,提供流量和资源扶持。

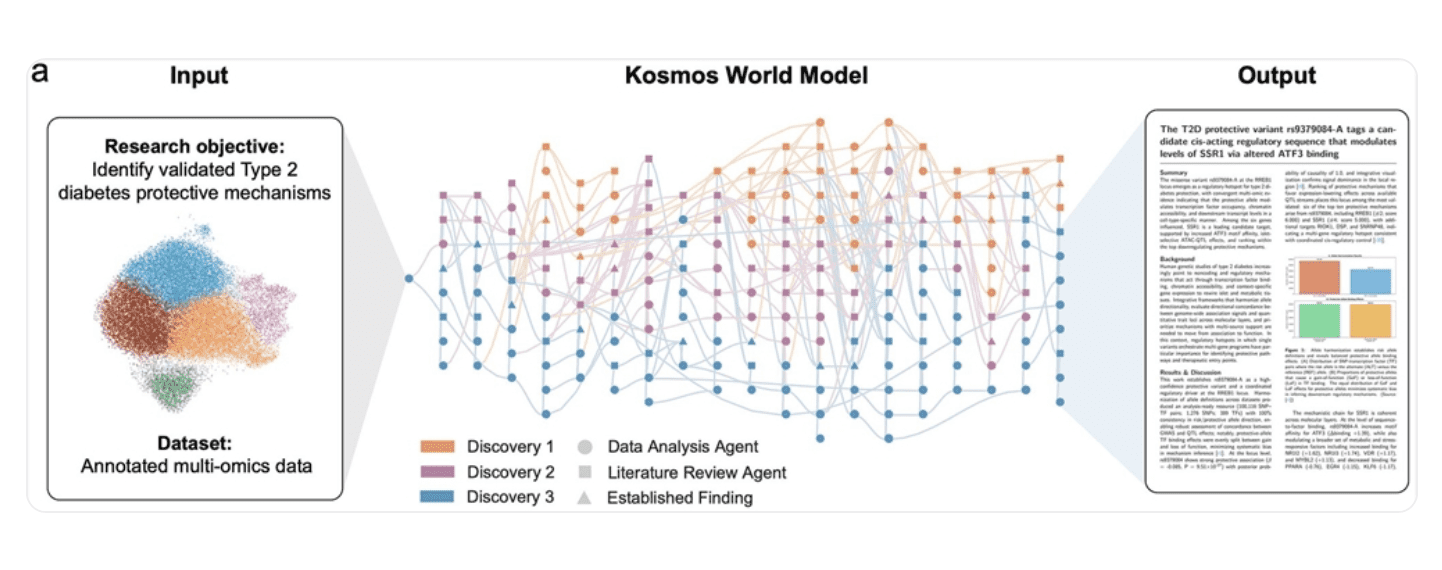

AI科研突破:Kosmos系统实现12小时完成半年科研量

11月17日,非营利研究机构FutureHouse发布AI科研系统Kosmos,单次12小时运行即可阅读1500篇论文、生成并执行4.2万行分析代码,输出可溯源报告,工作量相当于人类团队半年产出。

Kosmos采用自主循环架构:并行启动文献检索与数据分析任务→更新内部知识图谱→再规划下一轮探索,平均一次运行迭代166次数据分析与36次文献综述,结论引用精确到代码片段或原文,支持完整审计。实测中,Kosmos独立复现三项尚未发表的研究,包括确认核苷酸代谢为低温脑处理关键通路,并发现钙钛矿太阳能电池60g/m³以上绝对湿度失效阈值。

制造业创新:苹果3D打印技术引领行业变革

11月18日,苹果宣布Apple Watch Series 11和Ultra 3的钛金属表壳全面采用3D打印工艺制造。该技术相较传统工艺减少一半原材料使用,今年已节省400吨钛原料。

苹果历时十年攻克规模化生产难题,通过精密控制粉末粒径、含氧量及每层60微米的打印精度,实现高效低碳制造。成品经20小时900层打印后,还需脱粉、切割与光学检测。此工艺亦应用于iPhone Air的USB-C接口外壳,助力苹果2030年碳中和目标。

消费电子挑战:iPhone 17 Pro Max掉色问题引关注

11月18日,iPhone 17 Pro Max被湿巾擦掉色的相关话题登上热搜,引发网友热议。有苹果用户发帖称,其购买的iPhone 17 Pro Max星宇橙配色在使用普通湿巾擦拭后,镜头边缘及边框涂层大面积脱落,露出银色铝合金基材。

苹果客服对此表示,普通湿巾擦拭是不会影响机器颜色的,但是如果是含高浓度酒精或是其他含腐蚀性液体的湿巾则有可能造成掉漆。苹果客服还称,用普通自来水之类的是不会受影响的。

值得注意的是,今年10月,有网友在Reddit论坛反馈称,自己的iPhone 17 Pro Max星宇橙后盖褪色成了"玫瑰金",铝合金表面橙色几乎完全消失。媒体Wccftech分析认为,该问题或源于生产工艺缺陷,推测在生产后盖时,没有完全密封阳极氧化保护层,导致铝材暴露在空气中氧化变色。

AI与财务服务的深度融合

11月18日,商业和财务管理解决方案提供商Intuit与OpenAI签署一份为期多年的合作协议,合同总价值逾1亿美元(现汇率约合7.11亿元人民币)。该合作将使Intuit旗下的税务与财务应用(如TurboTax、Credit Karma、QuickBooks和Mailchimp)集成至ChatGPT平台。

根据协议,用户可通过ChatGPT直接调用Intuit的各项工具,提出问题并完成具体任务,例如估算退税金额、评估信贷方案,或管理企业财务。在获得用户明确授权的前提下,Intuit应用可调取其财务数据,生成定制化答案并执行操作,如发送营销信息或发出发票催缴提醒。

结论:AI技术的多维度影响

从Gemini 3 Pro的技术突破到科技巨头的战略投资,从AI教育应用到网络基础设施危机,AI技术正在以前所未有的速度和广度改变着各行各业。这些发展不仅展示了AI技术的巨大潜力,也揭示了其面临的挑战与风险。

随着AI技术的不断成熟,我们可以预见,未来几年将看到更多创新应用的出现,同时也需要关注数据安全、能源消耗、就业结构变化等议题。如何在享受AI带来便利的同时,确保其安全、可控、可持续发展,将是全社会需要共同思考的问题。

AI技术的竞赛刚刚开始,而真正的赢家将是那些能够将技术创新与社会需求紧密结合,推动人类共同进步的参与者。