科技行业近期迎来多重大事件,从Meta首席AI科学家杨立昆离职创办新公司,到英伟达超预期的财报表现,再到OpenAI推出新一代编程模型,这些事件共同勾勒出AI行业正在经历的深刻变革。本文将深入分析这些事件背后的行业趋势,探讨AI技术发展现状与未来方向。

杨立昆离职:AI研究的新篇章

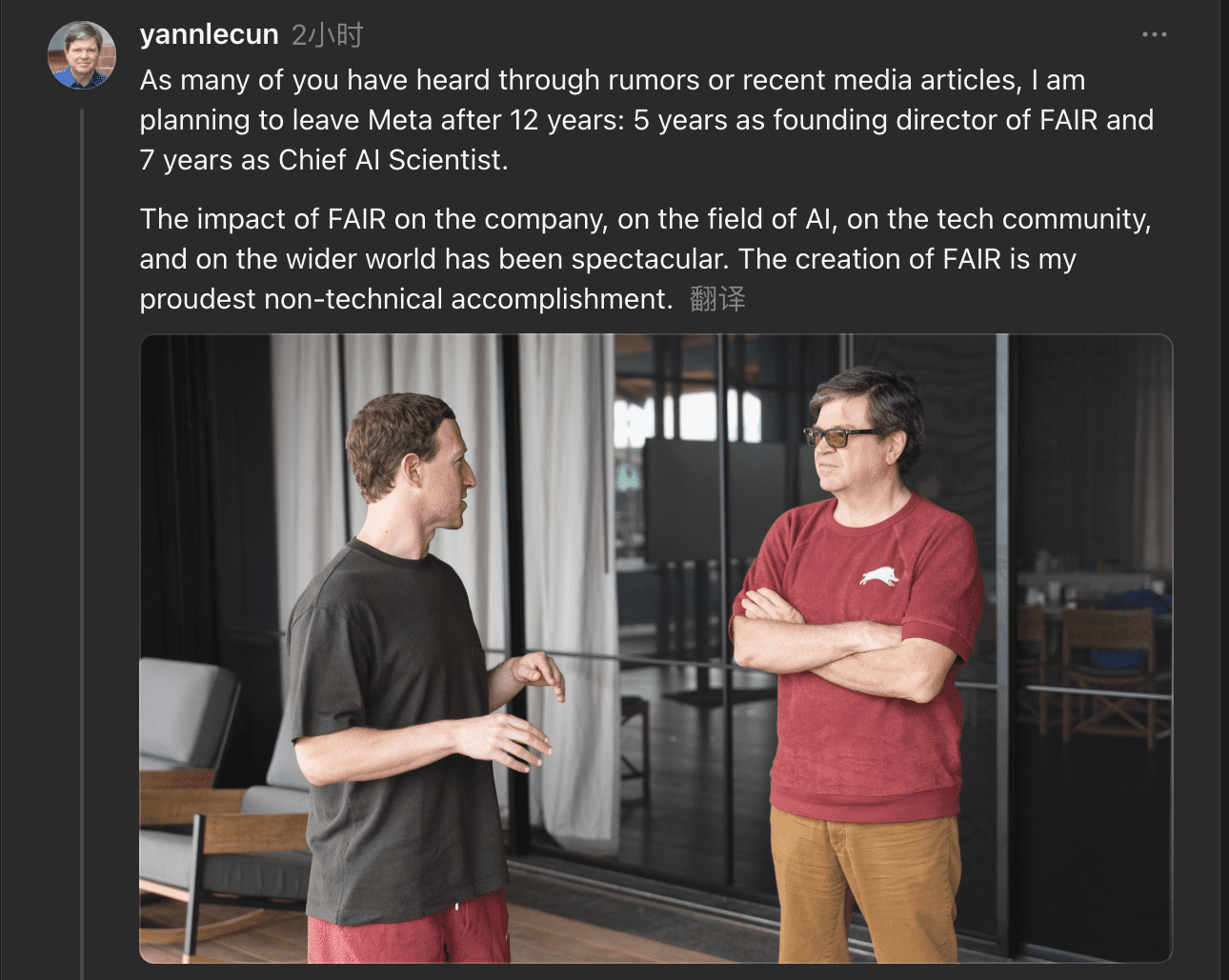

任职12年后,Meta首席AI科学家杨立昆宣布离职并创办自己的AI创业公司,这一消息在科技界引发震动。杨立昆长期在纽约大学任教,2013年加入Meta领导FAIR实验室,随后成为首席AI科学家。FAIR在深度学习研究、计算机视觉、基础模型以及大量前沿算法上奠定了Meta的核心技术路线,而杨立昆在整个阶段始终扮演关键角色。

杨立昆表示,新公司将承接他与FAIR、纽约大学及其他同行过去几年共同推进的Advanced Machine Intelligence(AMI)研究计划,并且会继续与Meta保持合作。新公司的目标是推动AI的下一次重大跃迁,让AI系统能够理解现实世界、具备长期记忆、能够进行推理,还能规划多步骤的行动流程。

这一离职背后反映了AI研究面临的深层次矛盾:长期基础研究与短期商业需求之间的张力。据彭博社报道,杨立昆近来在内部争取研究资源时愈发困难,因为Meta更专注于开发能应对OpenAI、Alphabet旗下谷歌以及Anthropic等竞争对手的产品式模型。这意味着AMI这种强调长期探索性质的研究,在大规模商业竞争的背景下较难得到优先支持。

杨立昆的选择代表了一种趋势:顶尖AI研究者正在寻求更自由的研究环境,以突破当前AI技术的局限。他的新公司可能会专注于那些短期内难以看到商业回报但对AI长远发展至关重要的研究方向。

英伟达财报:AI芯片需求的强劲证明

美东时间周三盘后,人工智能龙头股英伟达公布了超出预期的三季度财报,在美股市场因估值担忧而持续低迷之际,英伟达再次不负众望,交出了一份优异答卷。

财报显示,英伟达第三财季营收为570.1亿美元,超出市场预期的549.2亿美元;净利润为319.1亿美元,同比大涨65%,经调整后的每股收益为1.30美元,高于市场预期的1.25美元。

数据中心——英伟达最重要的业务——Q3营收为512亿美元,轻松超过分析师预测的490.9亿美元,同比增长66%。其中,「计算」(即GPU)业务贡献了430亿美元营收;网络业务(即允许多个GPU能协同工作的组件)贡献了82亿美元。

英伟达首席财务官Colette Kress在声明中表示,公司当前最畅销的芯片系列是Blackwell Ultra,这是Blackwell芯片的第二代产品。英伟达CEO黄仁勋还在声明中提到:「云端GPU已经全部售罄。」

英伟达的强劲表现证明了AI芯片需求的持续旺盛,也反映出企业对AI技术的投入正在加速。随着各大科技公司纷纷加大AI研发力度,对高性能计算芯片的需求预计将在未来几年继续保持强劲增长。

OpenAI新模型:编程AI的突破性进展

OpenAI今日发布了GPT-5.1-Codex-Max,这是一款面向长时间运行任务设计的新一代Agentic编码模型。相较于之前的模型,GPT-5.1-Codex-Max采用了「压缩(compaction)」技术,可在多个上下文窗口间工作,甚至能在单次任务中可靠处理百万级别的Token。OpenAI表示,该模型不仅性能提升,还实现了更快、更高效的Token利用率。

据了解,GPT-5.1-Codex-Max训练过程涵盖了真实世界的软件工程任务,如PR创建、代码评审、前端开发及问答等,并在众多前沿编程评测中表现超越此前的模型。除支持Unix平台外,GPT-5.1-Codex-Max还专门针对Windows环境进行了训练。

此外,得益于推理能力提升,GPT-5.1-Codex-Max在SWE-Bench Verified上完成相同任务时,使用的思考Token比GPT-5.1-Codex减少了30%。通过「Extra High(xhigh)」推理模式,模型在复杂任务中可投入更深入的思考。

目前,GPT-5.1-Codex-Max已在Codex CLI、IDE扩展、云端和代码评审等产品中上线,支持ChatGPT Plus、Pro、Business、Edu和Enterprise高级订阅用户。同时,OpenAI也将于近期将该模型引入API,并在Codex中替换为默认模型。

这一新模型的推出标志着AI在编程领域的应用正在从简单的代码补全向更复杂的任务处理演进,有望大幅提高软件开发效率,改变程序员的工作方式。

AI能力边界:从执行到决策

谷歌CEO桑达尔・皮查伊在最近的一次采访中表示,他认为人工智能有朝一日能胜任CEO的工作。这一观点与OpenAI首席执行官萨姆・奥尔特曼的言论不谋而合,后者也曾表示相信终将有那么一天,人工智能会比自己更胜任OpenAI CEO一职。

皮查伊指出,他相信人工智能将很快具备更高级别的自主任务执行能力,届时,AI模型将能像「智能体」(agent)一样代表用户行事。「我认为,未来12个月内,我们将见证一个重要演进:AI将能够为您处理更为复杂的任务。」他补充道。

这些言论反映了AI技术正在经历的关键转变:从执行明确的指令,到处理模糊、复杂的任务,再到做出具有一定判断力的决策。这一转变将带来深远的影响,不仅会改变工作方式,还可能重塑组织结构和决策流程。

然而,我们也需要认识到,AI在真正承担CEO级别的决策责任之前,仍面临诸多挑战,包括理解复杂的商业环境、处理伦理困境、以及在不确定条件下做出权衡等。这些能力可能还需要数年甚至数十年的发展才能达到人类水平。

AI内容管理:TikTok的新尝试

短视频平台TikTok宣布将支持减少用户看到的AI内容。该应用正在试验一项新设置,允许用户在他们的「为你推荐」信息流中「看到更少」的AI内容。这个新开关将在「未来几周」出现在应用的「Manage Topics」部分。

TikTok表示,Manage Topics功能已允许用户调整他们看到与舞蹈、体育、餐饮等超过10个类别相关内容的频率。与这些控制选项类似,AIGC设置旨在帮助用户定制他们信息流中的多样化内容,而不是完全移除或替换信息流中的内容。

为了加强AI生成内容标签,TikTok还在测试一种名为「隐形水印」的解决方案。在未来几周内,TikTok将开始向使用TikTok工具(如AI Editor Pro)生成的AI内容以及使用C2PA内容凭证上传的内容添加不可见的水印。这些水印将帮助TikTok更可靠地标记内容,并提供更多关于内容变更的背景信息。

这一举措反映了平台对AI生成内容日益增长的关注。随着AI生成内容的普及,如何区分人类创作与AI创作,如何管理用户对这些内容的期望,成为平台面临的重要挑战。TikTok的尝试可能会为整个行业提供有价值的参考。

硬件创新:从眼镜到耳环

除了软件层面的进步,AI硬件也在不断创新。据报道,三星内部正在开发两款智能眼镜,预计将在2026年和2027年推出。其中明年推出的智能眼镜型号为SM-O200P,将搭载变色镜片,在太阳光照射的情况下会自动变暗,类似太阳镜,回到室内等光照充足的环境则会增强透光率,保持透明。

硬件方面,这款眼镜将配备摄像头,可通过AI功能进行物体识别、实时翻译等,支持Wi-Fi和蓝牙连接,但并没有移动数据网络连接功能,意味着这款眼镜可能无法脱离手机使用。 与此同时,Lumia公司推出了智能耳环Lumia 2,号称「全球最小可穿戴设备」,重量不足1克,却能在耳内高精度追踪睡眠、体温、月经周期及身体准备度等关键健康数据。

Lumia 2集成了Lumia第二代PreciseLight传感器、处理器、电池及多种健康传感器。Lumia宣称,凭借在耳内佩戴的独特优势,Lumia 2能够实现比腕上设备更高精度和连续性的健康数据追踪,监测范围覆盖睡眠质量、体温变化、月经周期以及身体准备度等核心指标。

这些创新产品展示了AI硬件正在朝着更小、更隐蔽、更专业的方向发展,将AI能力整合到日常物品中,为用户提供无缝的智能体验。

行业趋势与未来展望

综合近期科技领域的重大事件,我们可以看到几个明显的趋势:

顶尖人才流动加速:以杨立昆离职为代表,顶尖AI研究者正在寻求更自由的研究环境,这可能会催生更多专注于长期基础研究的创新公司。

技术竞争白热化:英伟达的强劲财报和OpenAI的新模型都表明,AI领域的竞争正在加剧,各家公司都在努力推出更具创新性的产品和服务。

AI能力边界不断拓展:从编程到决策,AI正在从执行明确的指令向处理复杂任务转变,这将深刻改变工作方式和组织结构。

AI内容管理成为焦点:随着AI生成内容的普及,如何区分和管理这些内容成为平台面临的重要挑战。

硬件创新持续涌现:AI硬件正在朝着更小、更隐蔽、更专业的方向发展,将AI能力整合到日常物品中。

展望未来,我们可以预期AI技术将在更多领域实现突破,从简单的任务自动化到复杂的决策支持。同时,随着技术的普及,我们也需要更多地关注AI的伦理问题、隐私保护和就业影响,确保AI技术的发展能够造福人类社会。

结语

杨立昆离职、英伟达财报、OpenAI新模型等一系列事件,共同勾勒出AI行业正在经历的深刻变革。这些变化不仅反映了技术本身的进步,也体现了商业环境、人才流动和社会需求的变化。在这个快速发展的领域中,保持开放的心态、持续学习和适应变化,将是应对未来挑战的关键。