引言:AI外教的教育革命

真人外教会累、会忘、会不稳定,无法实现「千人千面」的颗粒度。这是AI Agent的机会。斑马口语的正式上线,标志着纯AI外教与学生一对一全英授课时代的到来,引发了行业不小的关注。

AI口语并不是一条新赛道,其中的玩家也良莠不齐:既有像Speak这样重投入打磨真人视频的,也有大量给大模型「套一层皮」就匆忙上阵的。斑马口语的目标与众不同——用AI打造一个超越真人的「AI原生」口语解决方案,让AI主导教学,发挥出真人没有的能力:针对性的纠正,个性化的话题,以及对学习结果的真实负责。

比真人外教还会教的AI外教

即时交互的真实语境

口语外教是一个被验证过的需求,用AI代替真人外教降低成本很合理,但真正的难点在于:AI如何能超越真人?

斑马口语从几个真人无法企及的核心点发力,首先是提供即时、可交互的真实语境。当AI老师想要教会小朋友生日派对相关的英语时,AI能无缝切换到一个生日派对现场,聊孩子爱吃的派对食物。AI让这种高成本、一次性的「真实世界」体验,变得轻盈、可控且无限重复。

高颗粒度的个性化进阶路径

人脑的记忆是有限的,但AI的记忆是无限的。斑马的AI Agent会把每个孩子当作一个系统来建设,它记得孩子上一次对话的每一个细节、每一个薄弱点。当孩子学口语遇到瓶颈时,AI能设计出「微小的一步」,在下一次对话中推着他往前走。

这种「长期积累的陪伴」和「微小颗粒度的进阶」,是任何真人老师都无法规模化实现的。

AI的高情商互动

AI做外教,肯定会有人担心,AI毕竟是「假人」,孩子怎么会愿意和它交流?但斑马团队的数据显示,传统真人外教一对一,孩子前三分钟的开口率大约是85%;而在斑马口语中,这个数字是98.8%。

这种高开口率来自细节的打磨。比如AI外教Jessica的形象设计,斑马团队反其道而行,选择了2D而非3D。「我们之所以选择二维,是因为3D角色更像是模仿真人,容易产生恐怖谷效应,影响孩子『入戏』。」

斑马团队挖掘了过往真人外教的数据,抽象出了「孩子最喜爱、学习效果最好」的外教特征——包括脸型、发色,设计了Jessica。

让孩子想开口只是第一步,斑马也希望用高情商让孩子更爱学习口语。在生日派对的课件里,一个正在学习的孩子突然说「我不想办生日party」。AI外教Jessica的回复情商极高:「Of course you can say No. Some people like quiet birthdays. That's OK too.」然后无缝地将话题切换到「参加别人的生日派对」,把教学进度自然地延续下去。

这种永远稳定、充满耐心、人格统一、且总能「捧场」的灵活性,恰恰是真人老师难以做到的。它让AI Agent从一个「工具」,变成了一个孩子愿意分享秘密的「新物种」。

学习动机的内化

这种「新物种」带来的信任感和情感连接,看似只是锦上添花,实则正触及了教育中最难的命题:动机。

如何让孩子有动力学下去?绝大多数教育产品,依赖的是「工具型动机」——奖励、打卡、游戏化。但通过与这个孩子真正「想聊」的AI外教交流,学英语的动机就变了。孩子不会想「我说英语会给我带来什么奖励」,他想的是「我必须说英语,才能完成这件事」——和虚拟的老师、小学伴们交流。

学习的成就感内化于这个过程,最终让说英语成为一种「必须」和「自然而然」。

「产模一体」的最佳实践

当斑马团队立下这个「200分」的雄心时,他们其实正站在一个十字路口——技术栈的选择。一个超越真人的AI Agent,到底需要一个什么样的「模型」?

在2023年立项时,最「聪明」的捷径,就是「套壳」——要么用最强的闭源模型,要么用顶尖的开源模型。但斑马团队很快发现,所有「捷径」都通向「80分」的平替,唯独通向不了「200分」的超越。

「我们很早就尝试过这个路径,但是最后发现,不同的模型总会有不同的问题。这背后是数据白点(data blind spots)的影响,你通过人设或者其他工作是很难根治的。在教育场景下,语言的正确性是第一位的。」

更别提迭代的鸿沟——「AI大模型,保守说每半年大模型的能力变化都很大,你选用一个具体版本的开源模型去做后训练,再去想跟上最新模型的效果,这个迭代的成本还是挺高的。」

数据驱动的模型优化

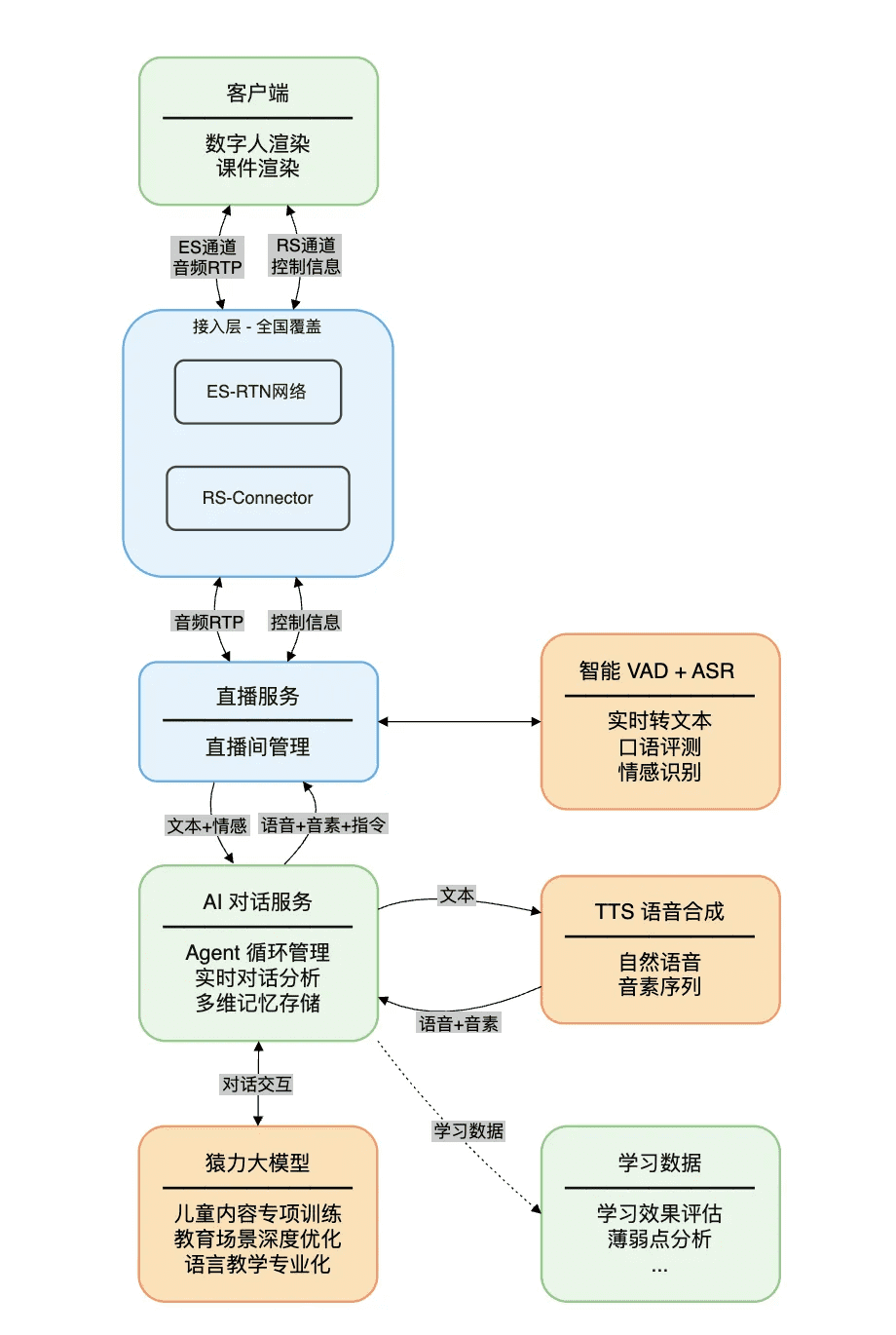

斑马真正的壁垒和核心资产,在于长期积累的、海量的、高质量的儿童教育数据——包括海量的儿童跟读数据。于是,他们的路径清晰地浮现出来:「猿力大模型」(预训练基座)+「斑马独有教育数据」(后训练/微调)。

这种「产模一体」的价值立竿见影:首先是数据带来的模型语料的准确和安全。「我们做了更严苛的数据筛选,首先能保证语料都是标准的英文语料,而且内容是符合儿童认知的,且价值观要非常积极向上的。我们又做了一些强化训练来保证它更可靠。」

而更能体现产模一体好处的,是AI知道怎么和不同水平的孩子沟通。比如当孩子问「为什么天是蓝的」,AI不会「吊书袋」讲一堆大气折射和瑞利散射,而是理解孩子可能只是想引起一个话题,需要更浅层的、比喻类的回答。

组织重塑的深层挑战

如果说「产模一体」是技术上的「必经之路」,那么一个更难的、也更底层的挑战,就是组织的重塑。这,或许才是AI时代最核心的命题。

我们聊过太多团队,为什么「产模一体」最后跑不通?因为他们只有「产模」,没有「一体」。模型团队和产品团队背着不同的KPI,互相拉扯。产品经理(PM)的价值感在消失,他们不再是为用户创造产品,而是沦为「给模型找活干」的「传话筒」。

斑马团队坦言:「我们之前也有传统互联网的流水线分工,但我们做这个事的时候就乱了。比如产品的需求文档(PRD),在新的产模一体的产品下,基本上就是一个课件。如果采用传统的流水线,产品经理所做的工作几乎就只是把教研的大纲『翻译』一下。」

网状连接的组织形态

斑马口语的解决方案是,教研和产品研发直接一起讨论教学层面的需求,研发在一个看似非标准的需求下,进行理解和开发。这种「边界模糊」不止发生在产品和教研之间。「教研可能直接跟AI工程师对接;动画直接跟研发去对,因为这里面的渲染有点复杂……有很多是跨部门交错来做。」

一旦这个「壁垒」被打破,整个组织的形态就全变了。流程不再是「PM -> RD -> 教研」的线性传导,而变成了「神经突触」式的网状连接。

斑马分享了一个最朴素、也最高效的组织解法:「坐在一起。」在物理邻近的高密度协作中,「教研」的神经末梢直接碰上了「AI工程师」的神经末梢,不断碰撞、擦出火花,形成新的组织脉络。

一个真正的AI Native产品,或许不是被「开发」出来的,而是被一个AI Native的组织中「长」出来的。为了实现那个「200分」的AI Agent,你必须先打造一个「200分」的AI Native组织。这,或许才是斑马口语在「产模一体」实践中,最坚实、也最难被复制的「壁垒」。

用AI拆掉巴别塔

斑马口语已经证明,AI可以成为一个比真人更稳定、记忆力更强、甚至情商更高的「老师」。但这只是一个开始,AI语言教育的未来,又会走向何方?

语言学习范式的迁移

在讨论中,修佳明为我们勾勒出了一条清晰的「范式迁移」路径。我们最熟悉的,是「外语学习」:以规则为先,上来先学语法、背单词,把语言当作一个「学科」来攻克。

斑马口语目前所做的,是「第二语言习得」:它不先教规则,而是强调「沉浸式」输入,先让你听、让你读、让你模仿,在大量的语料中「习得」。但它依然需要一个起点——孩子需要有最基础的认知和一些英语基础。

而这条路的「圣杯」,是「母语习得」:像母语一样,在真实的、全天候的环境中自然习得,你甚至意识不到自己在「学习」。

从「课程App」到「生活存在」

「母语习得」的本质,不是「上课」,而是「生活」。这意味着AI必须从一个「课程App」,变成一个「存在」。而这一点,斑马已经看到了雏形。

修佳明提到,他们已经能感受到孩子的主动分享。「有一次说到今年的目标,孩子主动分享了已经吃了两个月的健康食物了,还是没有长高,并主动给AI学伴看自己的身高。」

而要从「朋友」进化到「家庭成员」,斑马正在探索一个明确的方向:多模态理解,尤其是做更多的视觉理解。一旦AI Agent有了「眼睛」,能够观察到孩子的反应、表情和所处的真实环境,它就拥有了「嵌入生活」的能力。

全天候AI玩伴的未来

这带来了一个极具想象力的未来——当AI Agent可以成为一个真正的「AI玩伴」,全天候沉浸在孩子的生活中:当孩子拿起一个苹果时,它会用英语说「Apple」;当孩子在玩乐高时,它会用英语讨论「Blue block」。一个真正的母语环境形成了,语言学习被彻底内化到了生活本身。

而这个「AI玩伴」的未来,听起来遥远吗?修佳明告诉我们,他们已经在斑马口语的「数据闭环」中,看到了这个未来的「涌现」。当一个AI产品拥有海量的真实用户数据,它就开始在各方面「成长」了。

单就语音而言,就能看出差别。「通过获得更多数据,AI现在对小朋友不同的发音的判断比真人更准了,」修佳明说,「小朋友的口音或者本身年龄比较小,肌肉发育的原因等等,可能并没有办法像真实发音那样。但我们的产品不能因为学生发不出这个音,Jessica就判定他不会。」

语言学习的终极目标

「你怎么理解语言学习这个事的终极目标?」在采访的最后,我们问道。

「我个人是希望语言学习如果能对每一个人的自我产生影响。」修佳明说,「学习一门语言,你也会学会它背后代表的世界观、思维、文化。而当你的认知提升了,你也能更好地与这个世界产生连接。」

当AI Agent把语言学习的成本和难度无限拉低,当每一个孩子都能拥有一个高情商、高智商的「AI外教」时——我们或许正在见证的,是用AI,拆掉那座阻碍人类互相理解、互相启发的「巴别塔」。

结语:AI教育的无限可能

斑马口语的实践展示了AI在教育领域的革命性潜力。通过「产模一体」的技术路径和组织重塑,斑马不仅打造了超越真人的AI外教,更探索了语言学习从「外语学习」向「二语习得」乃至「母语习得」范式迁移的未来图景。

随着多模态理解技术的发展,AI将不再是单纯的「课程App」,而是融入生活的「AI玩伴」,全天候陪伴孩子成长,让语言学习彻底内化到生活本身。这种教育范式的转变,不仅会降低语言学习的门槛和成本,更可能重塑人类的认知方式和文化交流模式。

在AI技术的助力下,我们或许真的能够拆掉那座阻碍人类互相理解的「巴别塔」,让每个人都能通过语言学习拓展自己的认知边界,更好地与这个世界产生连接。这,或许才是AI教育最深远的意义所在。