谷歌最新发布的Gemini 3.0 Pro模型在AI领域掀起了一场革命性的风暴。经过近一个月的预热,这一模型终于在Google AI Studio上线Preview版,API同步开放,预示着谷歌将在其全线产品中逐步集成这一突破性技术。翻开Model Card,满眼只有两个字:碾压。这不仅是对当前AI市场的宣示,更是对整个行业未来发展方向的重新定义。

霸榜的暴力美学:全方位能力碾压

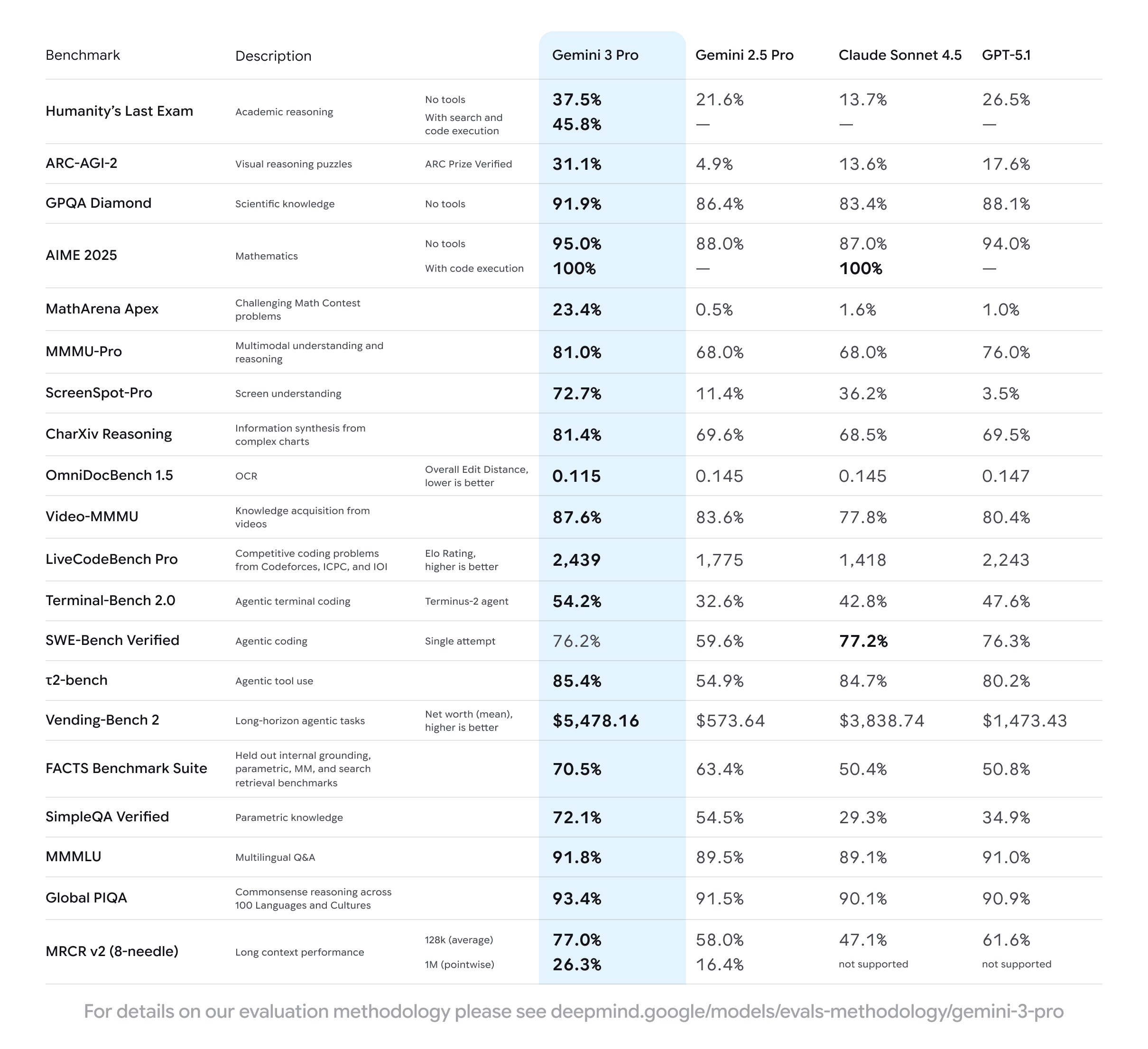

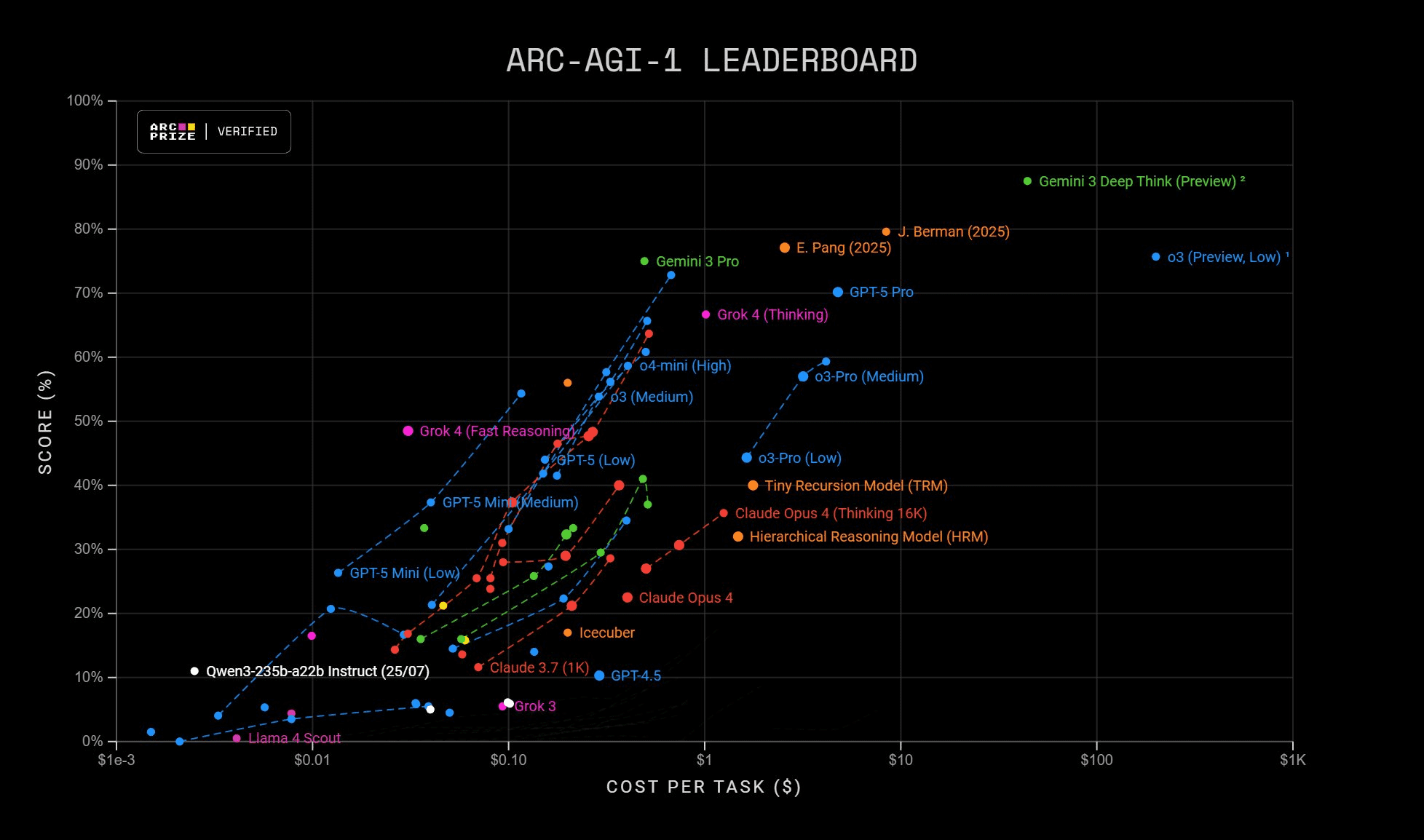

在AI模型竞争日益激烈的今天,各大厂商之间的优势往往微乎其微。然而,Gemini 3 Pro抛出的成绩单却令人瞩目,它在推理、多模态、Agent工具使用等关键基准上实现了全方位的霸榜。

人类智力"天花板"的突破

Humanity's Last Exam(人类最终大考)作为衡量学术推理极限的标尺,一直是各大AI模型挑战的焦点。在此之前,GPT-5.1在此项测试中得分为26.5%,Claude Sonnet 4.5仅为13.7%。而Gemini 3 Pro直接轰出了37.5%的高分,这10个百分点的差距意味着模型在处理复杂学术问题时已经具备了完全不同的理解深度。

更令人震惊的是,Google还展示了Gemini 3 Deep Think(深度推理模式),在不使用任何工具的情况下,它在HLE上的得分进一步飙升至41.0%。这一数据表明,AI模型在学术推理领域已经接近甚至可能超越人类专家的水平。

数理能力的绝对统治

在数理领域,Gemini 3 Pro的表现同样令人叹为观止。

AIME 2025(美国数学邀请赛):配合代码执行(Code Execution),Gemini 3 Pro的准确率达到了惊人的100%,即满分。即便是"裸考"(无工具模式),它也有95.0%的准确率,相比之下,GPT-5.1为94.0%,Claude Sonnet 4.5为87.0%。

MathArena Apex(数学竞赛地狱模式):当包括GPT-5.1在内的其他大模型还在1%上下挣扎时,Gemini 3 Pro直接干到了23.4%。这标志着在许多以前AI根本"看不懂题"的领域,Gemini 3已经开始解题。

视觉智能的革命性突破

Gemini系列一向在多模态能力上领先,这一代更是专门优化了屏幕理解(Screen Understanding)能力。这一能力对于下一代Agent能否真正接管人类电脑至关重要。

看ScreenSpot-Pro这一栏数据:

- GPT-5.1:3.5%(这基本意味着它是个"瞎子")

- Gemini 3 Pro:72.7%

这是近乎20倍的能力碾压!这标志着Gemini 3 Pro已经不再是一个单纯的对话框,它具备了真正意义上的"视觉智能",能够像人类一样理解复杂的操作系统界面。

实用能力的全面展现

除了学术和数理能力,Gemini 3 Pro在实用场景中也表现出色。在Vending-Bench 2这一模拟开店赚钱的基准测试中,Gemini 3 Pro最终赚取了$5,478.16的净资产,而GPT-5.1仅赚了$1,473.43。这一数据表明,在需要综合决策能力的商业场景中,Gemini 3 Pro具有明显优势。

在传统强项上,Gemini 3.0依然表现出色:支持1M Token的超大上下文窗口、对多模态数据的"原生支持"、长视频和多语言处理等。这些特性使得Gemini 3 Pro能够处理更加复杂的任务和场景。

编程能力:顶尖但非颠覆

关于Gemini 3.0的编程能力,网络上曾流传"彻底端到端终结程序员"的说法。然而,根据实际测试结果,Gemini 3.0 Pro在AI领域处于顶尖水平,但并未达到"颠覆编程"的程度。

在衡量软件工程能力的SWE-Bench Verified测试中,Gemini 3 Pro得分为76.2%,虽然很强,但未超越Claude Sonnet 4.5(77.2%)拿到SOTA。这表明在处理超长程、极其复杂的后端逻辑时,它依然存在局限性。

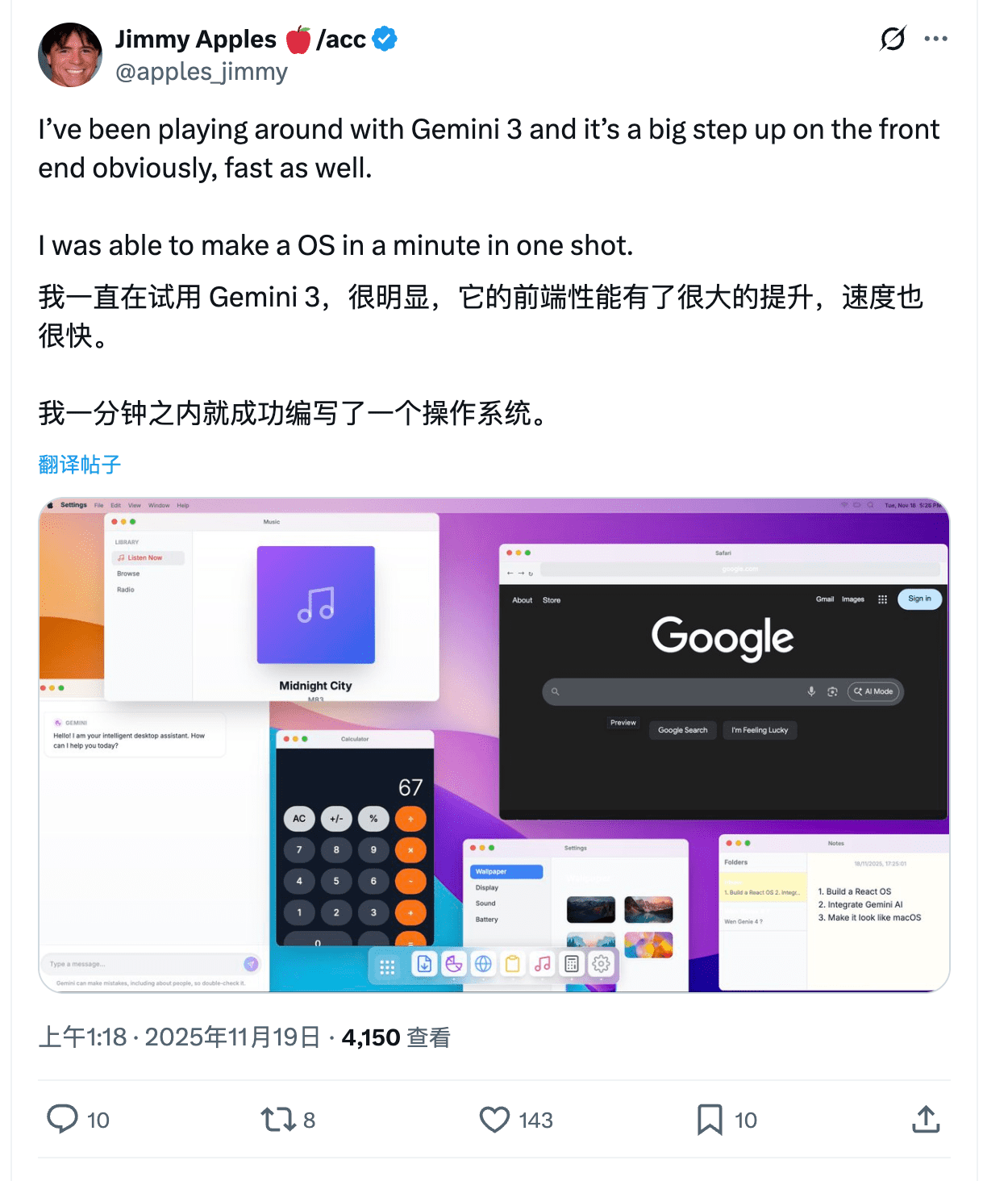

不过,Gemini 3 Pro在前端开发和创意编程方面表现出色。如果你想写一个极具现代设计美学的网站、一个3D飞船游戏,或者生成复杂的SVG交互动画,它能通过一次提示就给出极其惊艳的、可直接运行的结果。

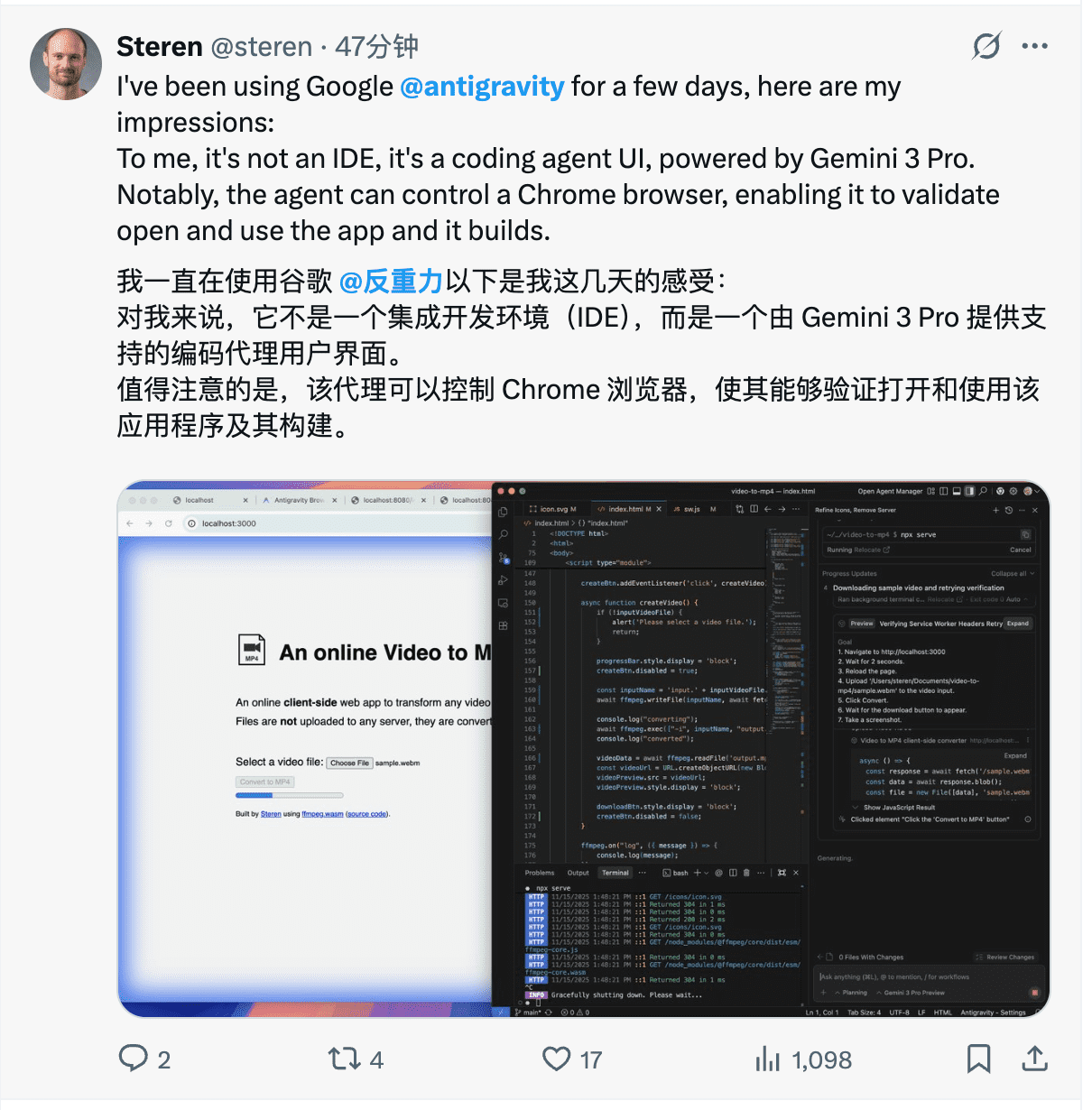

Antigravity:Agentic编程的探索

有了最强的模型和算力,谷歌开始在应用层"掀桌子"了。今晚,谷歌扔出了一个"小王炸"——Google Antigravity。这不仅仅是一个新的IDE,而是谷歌定义的Agent-first(智能体优先)开发平台。

在这一平台上,开发者从"码农"升级为"架构师",而Gemini 3则化身拥有编辑器、终端和浏览器完整权限的"执行合伙人"。为了实现这种体验,谷歌在后台配置了一个"模型军团"协同作战:

- Gemini 3:作为大脑,负责高级推理和代码编写

- Gemini 2.5 Computer Use:作为手眼,专门控制浏览器进行UI验证和测试

- Nano Banana:作为美工,负责生成图像和UI素材

这种打通了底层模型到顶层交互的闭环体验,对于Cursor等现有AI编辑器来说,无疑是一次降维打击。

并行Agent协作的革命

Antigravity最有趣的能力在于并行处理。官方材料明确提到,开发者可以与多个智能Agent协作,而这些Agent能够代表你同时自主规划并执行复杂的端到端软件任务。

想象一下这种工作流:你下达一个指令,Antigravity瞬间分裂出多个Agent——Agent A负责写后端逻辑,Agent B负责在终端跑测试用例,Agent C直接打开浏览器去验证前端UI的交互效果。它们并行不悖,像是一个配合默契的敏捷开发小组,而你只需要验收它们提交的"工件"。

Antigravity是一个免费平台,网络上目前对于Antigravity的使用体验不多,但基本上都是好评。要达到替代Cursor本身,肯定不太行——端到端的复杂编程体验,肯定还需要模型更成熟。但是简单的项目进行编程,或许会更简单了。

全家桶齐发力:TPU与搜索的完美结合

在大模型发展的后半程,比拼的不再是单一算法的灵光一闪,而是谁的算力更冗余、谁的数据更广阔、谁的投入更持久。Gemini 3 Pro的胜利,有一点是很特别的:它是使用Google TPU训练的。

TPU算力的优势

当全世界的AI公司都在苦苦等待英伟达GPU的发货周期时,谷歌依然坐在自家庞大的TPU矿山上。TPU专为LLM训练设计,拥有极高的高带宽内存(HBM),这让它能够轻松处理海量的模型参数和超大的Batch Size。正是TPU的算力冗余,给了Gemini 3 Pro肆意扩张参数规模的底气。

训练数据的全维度覆盖

有了算力,还要有"燃料"。Gemini 3 Pro的训练数据是全维度的覆盖:它吞噬了公共网络文档、代码库、图像、音频和视频。更关键的是,谷歌明确提到使用了User Data(用户数据)——当然是在隐私协议框架下,来自谷歌庞大产品生态的用户交互数据。

生成式搜索的革新

最后,这种溢出的智能被注入了Google Search。Google这次推出了一个全新的AI Mode in Search。当你搜索一个复杂概念(比如RNA聚合酶的工作原理)时,Gemini 3不再是给你扔一堆冷冰冰的链接,而是利用其强大的推理能力,即时生成一个沉浸式的互动图表或模拟工具。

从底层的TPU硅基霸权,到中间层的模型智能,再到顶层的Antigravity开发生态与生成式搜索——谷歌这一夜展示的,不仅仅是一个满分模型,而是一个只有巨头才能构建的、严丝合缝的未来。

实测体验:直出能力的飞跃

让我们看看网上的一些实测体验吧。

六边形测试的升级表现

不少帖子提及了Gemini 3在设计上的美感。相比之前的模型,Gemini 3在生成图像和UI设计时更加注重细节和美学,能够创造出更具视觉冲击力的作品。

物理世界建模能力

Gemini 3在物理世界的建模方面也有显著提升,能够更好地理解和模拟复杂的物理现象,为科学研究和工程设计提供了强大的工具。

用户界面理解与生成

前面提到的,Gemini对于用户界面数据这块做了特别的优化。在实际测试中,它能够准确理解复杂的UI界面,并生成符合用户意图的交互设计。

开发应用能力

在开发应用方面,Gemini 3展现了强大的代码生成和调试能力。它不仅能够编写高质量的功能代码,还能识别并修复常见的编程错误,大大提高了开发效率。

未来展望:AI能力边界的重新定义

在今天,大模型的性能已然超越了跑分的边界。即便是最顶尖、最复杂的前沿基准测试,其测量精度也开始失效。如何科学地量化模型之间的微妙差距,已经成为了一门专门的"量化科学",仅凭用户简单的实测手感,很难窥见其中的全部玄机。

实测案例更多的也就是用来看看模型本身的审美和one-shot直出的状态。Gemini 3.0在这次的更新上,显然在直出的情况下,赢面很大。

当模型直出能力越来越好,对于开发者来说,未来更多的是要看你的品味能不能跑过模型,你的点子是不是足够与众不同了。AI正在从"工具"向"合作伙伴"转变,人类的价值将更多地体现在创意、审美和战略思考上。

结语

Gemini 3.0的发布不仅是一次技术突破,更是AI发展史上的一个重要里程碑。它不仅在各项基准测试中取得了令人瞩目的成绩,更重要的是,它通过Antigravity平台和生成式搜索等产品,展示了AI技术如何与实际应用场景深度融合。

谷歌通过TPU算力优势、多模态数据处理能力以及搜索整合构建了一个完整的AI生态系统。这个系统不仅提升了AI模型的能力边界,更重要的是,它重新定义了人机交互的方式,为AI在各个领域的应用开辟了新的可能性。

随着Gemini 3.0及其相关产品的逐步落地,我们将看到AI在科学研究、软件开发、创意设计等领域的应用达到新的高度。这不仅将提高生产效率,更将激发人类创造力的新篇章。AI的未来,正在我们眼前徐徐展开。