在近期科技股和债券市场的抛售潮中,甲骨文(Oracle)遭受的打击远超其科技巨头同行,这引发了市场对其巨额AI投资策略的担忧。这家由拉里·埃里森创立的美国软件集团为全面转向人工智能领域已承诺投入数千亿美元,主要用于与OpenAI(ChatGPT的开发商)的合作协议。

甲骨文的AI豪赌

甲骨文在人工智能竞赛中的高调入场,承诺在未来几年投入数千亿美元用于芯片和数据中心建设,这主要作为向OpenAI提供计算能力交易的一部分。然而,其行动的速度和规模让一些投资者感到不安,尤其是在当前市场密切关注所谓超大规模科技公司(hyperscalers)支出的背景下。

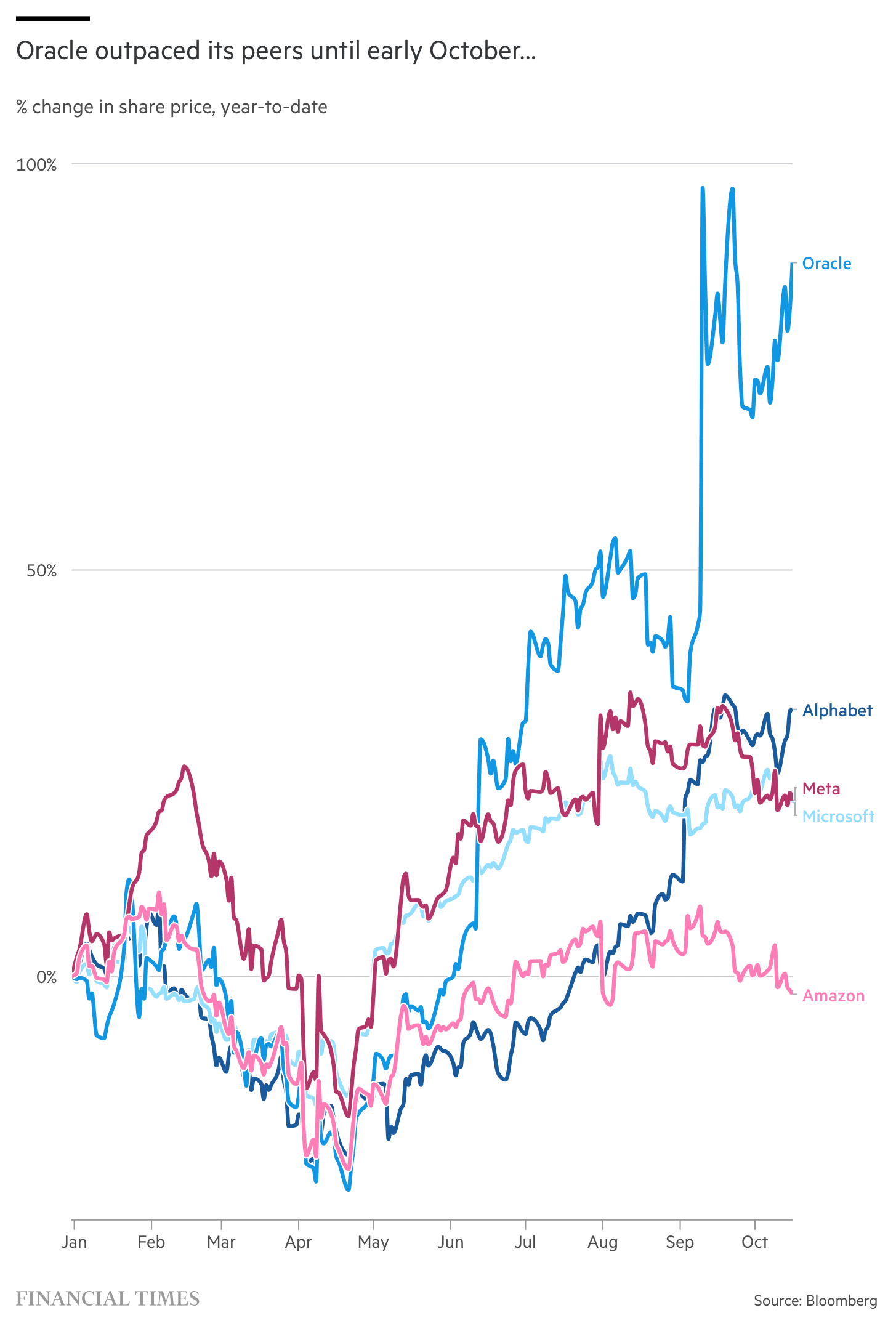

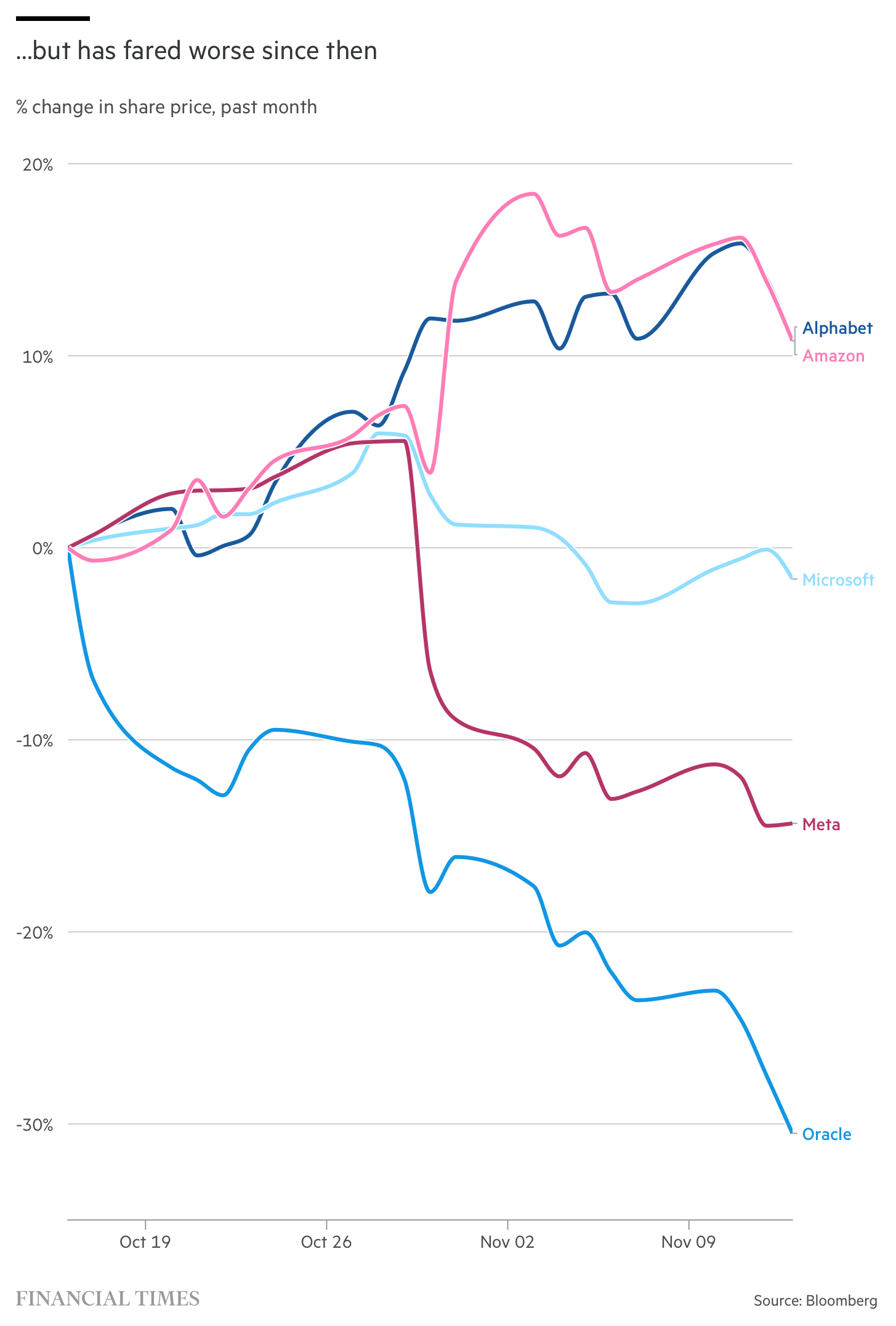

过去一个月,甲骨文股价下跌了25%,几乎是表现第二差的超大规模科技公司Meta跌幅的两倍。自9月该公司披露与OpenAI的交易以来,其市值已蒸发超过2500亿美元。自9月中旬以来,追踪甲骨文债务价格的金融时报指数下跌了约6%,表现明显差于其主要同行。

投资者担忧加剧

投资者对少数大型科技集团的高估值和巨额资本支出感到担忧,如果像OpenAI和Anthropic等少数几家亏损的AI初创公司未能兑现技术承诺,这些支出可能会适得其反。

周四,随着纳斯达克指数下跌2.3%,甲骨文股价下跌4.2%,这是科技股引领的一系列抛售中的最新一次。不过,该股票在周五收复了部分失地。

"这是一个与投资者重视的云服务业务模式完全不同的模式,"Rothschild & Co Redburn的Alex Haissl表示。"当你看收入数字时,这些交易看起来很棒,但它们非常资本密集,因此创造的价值很少。"

甲骨文的财务风险

甲骨文表示,其与OpenAI的交易将在2027年至2032年间产生3000亿美元的收入。其高管表示,由于 intense 且不断加速的AI需求远超现有计算能力供应,回报将证明风险是值得的。尽管如此,甲骨文股价今年仍上涨了30%。

根据S&P Visible Alpha汇编的估计,甲骨文的基础设施业务预计到2029年将增长超过10倍。华尔街分析师中大多数对其股票持乐观态度。

然而,甲骨文一直在积极利用债务市场来快速扩大其能力。

根据彭博数据,该公司的长期债务约为960亿美元,比一年前的750亿美元有所增加。摩根士丹利预测,到2028年,这一数字将飙升至约2900亿美元。甲骨文在9月出售了180亿美元债券,并正通过多家美国银行筹集380亿美元的债务融资。

"埃里森在支出方面现在已经完全脱离常规,"一位长期跟踪甲骨文股票但没有做空该股的卖空者表示。"市场显然不再对公司在AI上无限制烧钱的公司感兴趣。"

信用评级机构警告

本周,巴克莱分析师将其对甲骨文债务的评级从中性下调至低配,警告其AI基础设施的大额支出已超过其自由现金流。

信用评级机构穆迪也指出了甲骨文依赖少数几家AI公司的重大风险。标普全球警告称,到2028年,甲骨文三分之一收入将绑定在单一客户身上,这指的是其对OpenAI的依赖。

"这对甲骨文来说是一个巨大的负债和信用风险。你的主要客户,远超其他任何客户,是一家风险投资支持的初创公司,"标普全球的董事Andrew Chang表示。

OpenAI面临的问题是如何计划在未来八年实现其承诺的1.4万亿美元AI基础设施支出。它已与几家科技巨头达成交易,包括甲骨文的竞争对手。

在亚马逊、谷歌、微软和Meta等五家超大规模科技公司中,甲骨文是唯一一家自由现金流为负的公司。根据摩根大通的数据,其债务股本比已飙升至500%,远高于亚马逊的50%和微软的30%。

摩根大通分析师指出,"[甲骨文]激进的AI建设雄心与其投资级资产负债表的限制之间存在紧张关系。"

合同不匹配风险

分析师还指出,甲骨文的数据中心租约期限远长于其向OpenAI出售计算能力的合同。

甲骨文已签署至少五份美国数据中心的长期租赁协议,这些数据中心最终将由OpenAI使用,导致1000亿美元的表外租赁承诺。这些地点的建设进度各不相同,有些预计要到明年才会破土动工。

领导层变动

自2019年至9月卸任的甲骨文唯一首席执行官萨夫拉·卡茨(Safra Catz)曾因所需巨额费用而抵制扩大其云业务。作为甲骨文转向以AI为重点的新时代的一部分,她由联席首席执行官Clay Magouyrk和Mike Sicilia接替。

根据美国监管文件,卡茨现在是甲骨文董事会执行副主席,今年已行使股票期权并出售了25亿美元的甲骨文股票。她曾宣布计划在2024年底行使其股票期权。

市场反应与未来展望

尽管面临这些担忧,甲骨文高管坚称,由于AI需求远超供应,其长期战略将证明是正确的。然而,华尔街的短期反应表明,投资者对甲骨文激进的财务策略和业务模式转变持谨慎态度。

随着AI技术继续发展,甲骨文的命运将在很大程度上取决于OpenAI能否兑现其技术承诺,以及甲骨文能否有效管理其巨额债务和资本支出。这场豪赌的最终结果,可能不仅决定甲骨文的未来,也将影响整个科技行业对AI投资的看法。