在人工智能技术不断突破的今天,智能穿戴设备正迎来新一轮革新。11月27日,阿里巴巴旗下夸克AI眼镜正式发布S1和G1两个系列共六款单品,以创新技术和人性化设计重新定义智能眼镜行业标准。这一产品线的推出,标志着AI技术与日常穿戴设备的深度融合进入全新阶段。

双系列六款产品,满足多样化需求

夸克AI眼镜此次首发提供S1、G1两个系列共六款单品,针对不同用户群体的需求进行了精准定位。

S1系列提供三种不同框型和颜色的选择,最低到手价为3799元。该系列更注重性能表现和专业体验,采用双旗舰芯片配置,支持双光机双目显示技术,亮度可达4000nits,保证户外环境下显示清晰可见。

而G1系列则更侧重时尚和轻便设计,除提供两种框型选择外,还特别配有太阳镜款,最低到手价1899元起。G1系列重量仅为40克左右,在不牺牲核心功能的前提下,实现了极致轻量化,更适合日常长时间佩戴。

两款系列均搭载了阿里最新的千问AI助手,为用户提供智能语音交互和场景化服务,展现了AI技术在日常生活中的广泛应用潜力。

线上线下全渠道发售,构建完善销售网络

发布会当日,夸克AI眼镜S1系列已在天猫、抖音、京东等主流线上渠道正式开售。与此同时,全国82个城市的604家线下门店将陆续提供配镜、产品体验及购买服务,用户可通过夸克AI眼镜微信服务号查询具体门店地址。

这种线上线下相结合的销售模式,不仅扩大了产品的覆盖范围,也为消费者提供了更便捷的购买和体验渠道。智能眼镜作为新兴品类,线下体验尤为重要,消费者可以通过实际佩戴感受产品舒适度和功能性,从而做出更明智的购买决策。

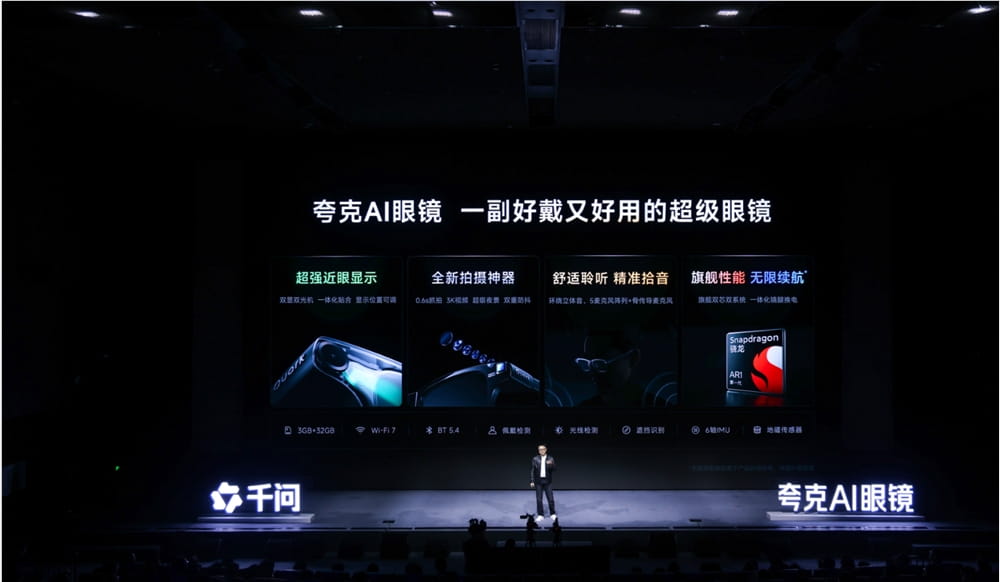

硬件创新:突破显示与交互技术边界

夸克AI眼镜S1系列在硬件层面实现了多项行业首创,代表了当前智能眼镜技术的最高水平。

显示技术方面,该产品采用双光机双目显示方案,国内首创合像距可调功能,亮度高达4000nits,即使在强光环境下也能保持清晰显示。这一参数远超市场上大多数智能眼镜产品,解决了户外使用时的可视性问题。

交互体验上,产品配备了五个麦克风阵列加骨传导技术,能够更精准地拾取人声、过滤环境噪音。这一创新设计使用户在地铁、街头等嘈杂场景下也能自然地与千问AI助手对话,大大提升了产品在复杂环境下的实用性。

拍摄功能是夸克AI眼镜的另一大亮点,产品可实现0.6秒的极速抓拍,3K视频录制,通过超分超帧技术可输出4K视频。更为突出的是,行业首创的Super Raw暗光增强技术首次将手机级影像技术引入智能眼镜领域,加上双重防抖系统,显著提升了暗光环境下的拍摄画质与稳定性。

极致轻薄设计:重新定义眼镜形态

在保持强大功能的同时,夸克AI眼镜在外观设计上也实现了重大突破。产品采用超细镜腿、超薄镜框的架构设计,外观上更接近普通眼镜,降低了智能穿戴设备的辨识度,提高了日常使用的接受度。

通过定制研发小型化扬声器、设计超窄一体化FPC等创新设计,使得镜腿宽度仅7.5毫米,是目前全球同类产品中最窄;镜框厚度仅3.3毫米,比行业主流薄约25%。这一成就得益于产品采用的二维衍射波导方案及高折射率镜片加镀膜工艺,使得镜片更为通透,视觉体验更接近普通眼镜。

人性化舒适设计:亚洲人专属佩戴体验

为了提升佩戴舒适感,夸克AI眼镜在细节设计上充分考虑了人体工学原理。鼻托、耳弯等部位采用仿生设计,高度匹配人体曲线;镜腿采用钛合金材质一体注塑成型,专为亚洲人头型设计,减轻了长时间佩戴的压力和不适感。

值得一提的是,夸克AI眼镜行业首创双电池可换电设计,用户只需拔下镜腿即可快速更换电池,有效解决了智能眼镜续航焦虑问题。这一创新设计大大延长了产品的使用时间,特别适合商务人士和旅行爱好者等长时间外出用户。

此外,产品还提供一体化贴合的配镜方案,满足不同用户的视力矫正需求,真正实现智能眼镜与视力矫正的无缝融合。

生态融合:构建全方位智能生活场景

夸克AI眼镜中的千问AI助手已深度融合支付宝、高德地图、淘宝、飞猪、阿里商旅等阿里生态核心场景,打造专属的操作体验。用户可以通过语音指令完成支付导航、购物查询、机票预订等多种操作,实现"解放双手"的智能生活体验。

除了阿里生态内部应用,夸克AI眼镜还与QQ音乐、网易云音乐、航班管家等外部合作伙伴建立了深度连接,持续丰富使用场景。这种开放合作的策略,有助于构建更完善的智能眼镜应用生态,提升产品的实用性和用户粘性。

据夸克AI眼镜产品负责人晋显透露,未来产品还将支持MCP协议,进一步打造开发者生态,吸引更多第三方开发者参与智能眼镜应用的创新开发,推动整个行业的繁荣发展。

技术突破:智能眼镜领域的里程碑

夸克AI眼镜的发布,代表了智能眼镜技术的一次重大突破。在显示技术方面,双光机双目显示和4000nits亮度解决了智能眼镜在强光环境下的可视性问题;在拍摄功能上,0.6秒极速抓拍和Super Raw暗光增强技术将手机级影像体验引入眼镜领域;在续航设计上,双电池可换电创新有效解决了智能眼镜的续航痛点。

这些技术创新不仅提升了产品本身的竞争力,也为整个智能眼镜行业树立了新的技术标杆,推动了相关产业链的升级和发展。随着技术的不断成熟和成本的降低,智能眼镜有望在未来几年内实现大规模普及,成为继智能手机之后的下一代个人计算平台。

市场前景:智能穿戴设备的新增长点

智能眼镜作为可穿戴设备的重要组成部分,近年来随着AI技术的快速发展而迎来新的增长机遇。根据市场研究机构的数据,全球智能眼镜市场规模预计在未来五年内将保持年均30%以上的增长率,到2028年有望达到数百亿美元规模。

夸克AI眼镜的推出,凭借阿里强大的技术背景和生态资源,有望在竞争日益激烈的市场中占据重要地位。特别是其与阿里生态的深度融合,以及针对亚洲市场的专属设计,使其在目标用户群体中具有独特的竞争优势。

随着5G网络的普及和AI技术的进一步发展,智能眼镜将不再局限于简单的信息显示和语音交互,而是会成为连接数字世界和物理世界的重要桥梁,为用户提供更加沉浸式和智能化的体验。

未来展望:AI眼镜的进化方向

展望未来,智能眼镜将朝着更加轻薄化、智能化和场景化的方向发展。在轻薄化方面,随着显示技术和材料科学的进步,智能眼镜将进一步缩小与普通眼镜的形态差距,提高佩戴舒适度和美观度。

智能化方面,AI技术的深度集成将使智能眼镜具备更强大的环境感知和理解能力,能够根据用户所处场景和需求提供更加精准的服务。例如,通过计算机视觉技术识别周围环境,通过自然语言处理技术实现更自然的人机交互。

场景化方面,智能眼镜将深入到更多专业领域,如医疗、教育、工业等,为特定场景下的用户提供定制化的解决方案。例如,在医疗领域,智能眼镜可以辅助医生进行手术导航和病例分析;在教育领域,可以为学生提供沉浸式的学习体验。

结语

夸克AI眼镜的发布,不仅是阿里在智能穿戴领域的一次重要布局,也是AI技术与日常消费品深度融合的典型案例。通过技术创新和生态构建,夸克AI眼镜有望成为智能眼镜市场的标杆产品,推动整个行业的发展。

随着技术的不断进步和用户需求的日益多样化,智能眼镜将迎来更加广阔的发展空间。未来,我们有理由相信,智能眼镜将像今天的智能手机一样,成为人们日常生活中不可或缺的智能伙伴,重新定义人机交互的方式和体验。