在数字技术不断演进的今天,谷歌正引领一场购物方式的革命。随着其AI搜索模式的商业化进程加速,对话式购物功能正式推出,标志着人工智能与零售业的深度融合。这一创新不仅改变了用户与品牌的互动方式,更重塑了整个数字购物生态系统的运作模式。

对话式购物:AI与消费体验的融合

谷歌在2025年I/O大会上首次宣布将对话式购物引入AI搜索模式,如今这一承诺正在变为现实。据谷歌官方介绍,其庞大的"购物图"(Shopping Graph)包含海量零售商数据,这使得其AI能够提供独特的购物建议。在未来几周内,美国用户将能够向AI搜索模式提出复杂的购物问题,系统将提供个性化建议、购物指南、比较表格等生成内容,帮助用户做出购买决策。

这种AI驱动的购物体验与传统搜索结果截然不同。传统搜索主要提供产品链接和基本描述,而AI搜索则通过理解用户意图,提供更加个性化和情境化的购物建议。例如,当用户询问"适合送给科技爱好者的生日礼物"时,AI不仅会列出相关产品,还会根据预算、兴趣和评价等因素提供定制化推荐。

广告模式的革新:AI搜索中的商业内容

随着AI搜索模式的推出,谷歌也在探索新的广告展示方式。公司明确表示,AI搜索结果中会出现赞助购物内容,这与传统搜索中的广告展示方式类似。目前,这一功能仍处于测试阶段,用户可能会看到不同形式的广告,也可能暂时看不到任何广告。

这一举措引发了关于AI搜索广告透明度的讨论。与传统搜索中明确的广告标识不同,AI生成的内容与广告之间的界限可能变得模糊。谷歌需要在提供个性化推荐与明确标识商业内容之间找到平衡,以维护用户信任。

值得注意的是,谷歌表示目前Gemini应用中的购物功能暂时不会包含赞助内容。这可能表明公司正在测试不同平台上的广告策略,以确定最适合AI环境下的商业化模式。

智能结账:从价格提醒到自动购买

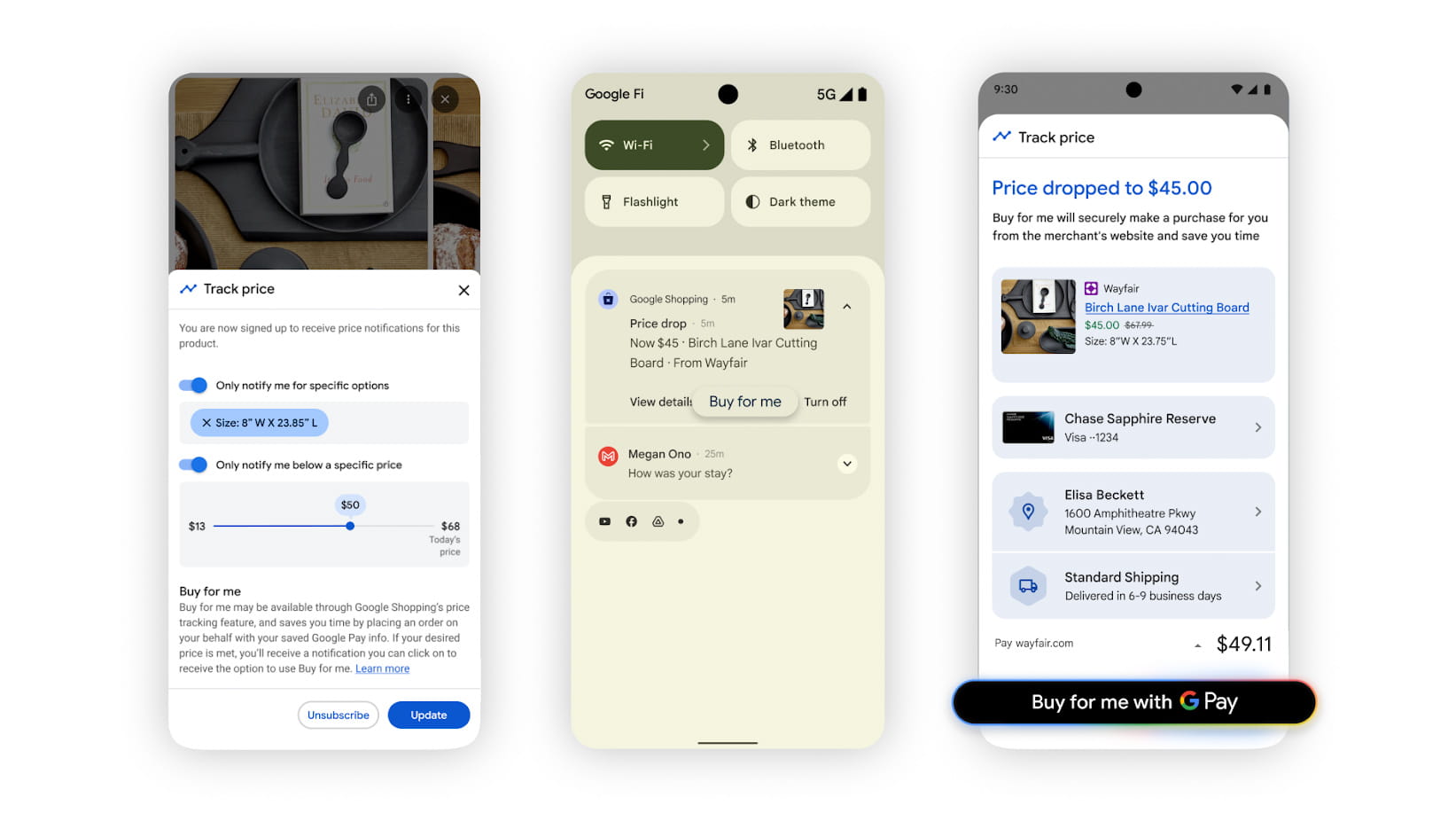

谷歌推出的"智能结账"(Agentic Checkout)功能代表了购物自动化的重要一步。这一功能允许用户为产品设置价格阈值,当商品达到该价格时,系统会发送提醒。与传统的价格跟踪不同,智能结账增加了AI元素:用户收到提醒后,可以通过谷歌支付授权自动购买。

目前,智能结账功能仅支持少数零售商,如Chewy、Wayfair和一些Shopify商家。谷歌解释称,这一功能之所以被称为"智能",是因为系统能够将网站上的视觉信息转化为行动,包括选择合适的产品款式、尺寸和颜色,添加到购物车并完成购买。

这一功能的推出标志着购物自动化的重要进展。通过减少购买过程中的决策摩擦,谷歌旨在提高转化率,同时为用户提供更便捷的购物体验。然而,这也引发了关于过度自动化可能导致的冲动消费问题的讨论。

重生Duplex:AI电话助手的新角色

在当前的AI热潮之前,谷歌曾热衷于展示Duplex技术——一款基于Assistant的AI,旨在通过电话执行现实世界任务。谷歌当时认为人们会信任AI来查询营业时间和预约,但这一功能并未获得太多关注,Duplex提示随时间推移逐渐从Assistant中消失。

如今,Duplex以"重大Gemini模型升级"的形式回归。虽然不再负责预约,但谷歌仍计划使用更新后的Duplex技术让用户打电话给商家查询库存情况。用户可以告诉机器人自己想要的产品,机器人将代为查询。

当用户搜索附近特定产品时,将看到"让谷歌打电话"的选项。用户需要指定具体想要的产品,机器人随后开始拨打电话。机器人会在通话时表明自己的身份,并且只会在营业时间和合理的冷却时间后进行呼叫。如果商家对频繁的机器人电话感到困扰,他们可以选择退出Duplex通话服务。

最终,用户将收到包含通话摘要的电子邮件或短信,这些摘要可能包含基于谷歌购物图的其他附近商店的本地库存数据。这一功能目前已在美国的玩具、化妆品和电子产品等类别开始推出。

技术挑战与用户隐私考量

尽管谷歌的AI购物功能带来了诸多便利,但也面临一系列技术和伦理挑战。首先是准确性问题——生成式AI可能提供错误的产品信息或价格,导致用户做出不当的购买决策。谷歌已在其功能说明中加入了关于可能错误的免责声明。

其次是隐私问题。AI购物功能需要收集和分析大量用户数据,包括搜索历史、购买偏好和位置信息等。如何在提供个性化服务与保护用户隐私之间取得平衡,是谷歌必须面对的挑战。

此外,广告与内容的界限模糊也引发了透明度问题。用户需要清楚了解哪些内容是AI生成的建议,哪些是商业广告,以便做出明智的决策。

对零售行业的影响

谷歌的AI购物功能可能对零售行业产生深远影响。一方面,它为中小型商家提供了接触更广泛受众的机会,特别是通过AI推荐功能。另一方面,大型电商平台可能会感受到来自谷歌搜索直接竞争的压力。

零售商需要适应这一新的购物环境,优化产品信息以适应AI理解,并考虑如何与AI推荐系统合作,提高产品曝光率。同时,实体零售商可能需要重新思考自身定位,强调体验式服务和即时满足等AI难以替代的优势。

未来展望:AI驱动的购物生态

随着AI购物功能的不断演进,我们可以预见几个关键发展趋势:

更个性化的购物体验:AI将能够理解更复杂的用户需求,提供高度个性化的购物建议。

多渠道整合:线上搜索、社交媒体、实体店体验将通过AI技术无缝整合,创造一致的购物旅程。

实时库存与价格优化:AI将能够实时分析库存数据,为商家提供动态定价策略,同时为消费者提供最佳购买时机。

语音与视觉购物:随着语音助手和图像识别技术的发展,购物将不再局限于文本搜索,而是扩展到语音和视觉领域。

可持续购物:AI可能帮助消费者做出更环保的购物选择,通过分析产品的碳足迹和可持续性因素。

假日购物季的AI变革

谷歌选择在假日购物季前推出这些AI购物功能,显然是经过深思熟虑的战略决策。在这一购物高峰期,消费者面临大量选择和决策压力,AI助手可以显著简化这一过程。

通过AI推荐、智能结账和库存查询等功能,谷歌旨在提高购物转化率,同时增强用户满意度。对于零售商而言,这意味着可能迎来销售高峰,但也需要适应这一新的购物方式,确保产品信息和库存数据的准确性。

结语:AI与消费的共生关系

谷歌推出的AI购物功能代表了技术与消费体验深度融合的新阶段。通过对话式交互、自动化决策和智能推荐,AI正在重塑我们与产品和服务的关系。这一变革不仅提高了购物效率,也创造了新的商业机会和挑战。

随着技术的不断进步,我们可以期待看到更加智能、个性化和无缝的购物体验。然而,这一发展也需要我们思考如何在享受技术便利的同时,保持对消费行为的理性思考,以及对个人隐私和数据安全的保护。

AI购物时代的到来,不仅是技术的革新,更是消费文化的转变。在这场变革中,用户、企业和平台都需要重新定位自身角色,共同构建一个更加智能、透明和可持续的购物生态系统。