苹果最新发布的Vision Pro M5头显设备,标志着公司在空间计算领域的持续探索。作为一名长期使用Vision Pro的用户,我既为它的创新感到惊叹,也为它的局限性感到失望。随着visionOS 26和新款硬件的推出,现在是重新审视这一产品的好时机。

初体验:从兴奋到理性

当第一代Vision Pro在2024年初发布时,我曾充满热情地投入使用:在飞机和酒店房间里观看电影,在家中放置应用程序窗口,测试新颖的工作方式,尝试各种有趣的游戏和教育应用,甚至自己开发应用程序。但随着时间的推移,新鲜感逐渐消退,实用性战胜了酷炫感。在苹果几周前寄送新款M5版本之前,我已经有几个月几乎没使用过最初的设备。

这种现象并不罕见。即使在Vision Pro拥有者的论坛上,最忠实的粉丝也在说:"这真的很酷,但我必须特意去使用它。"如果开发者和内容创作者的支持更加强大,或许更容易将其融入日常习惯,但这又是一个典型的鸡与蛋的问题。

M5升级:舒适性与性能的提升

全新Dual Knit头带

对于许多用户来说,最显著的变化是可以通过单独购买(尽管价格不菲)为旧款设备配备的新头带——Dual Knit Band。这个设计巧妙地平衡了设备在头部的重量,使长时间佩戴更加舒适。

这个头带带有简单的调节旋钮,可以收紧或放松头部后方的带子(类似于旧款)或头顶环绕的带子。虽然新款设备比前代略重,但其出色的设计使许多认为旧款设备太不舒服的用户能够更轻松地使用Vision Pro。

M5芯片:超越速度的提升

第一代Vision Pro搭载的是已经略显过时的M2芯片,而新款则升级为M5。它在图形处理和机器学习任务方面快得多,但对于大多数用户来说,这种性能提升并未显著改变使用体验。虽然有时能感觉到速度更快,但这种提升不足以改变对设备的整体态度。

M5芯片的最大优势是提高了效率,这是电池寿命适度增加的驱动力。最初使用M2 Vision Pro观看电影时,电池常常在片尾字幕耗尽;而新款设备可以额外提供30-60分钟的续航时间,终于可以使用户"观看任何想看的电影"。

此外,视野略有扩大(约10%)和透模式最高支持120Hz刷新率也是新款硬件的最佳改进。这些都是锦上添花的功能,但绝非革命性变化。

内容生态:质量优于数量

Vision Pro的吸引力主要来自软件,而非硬件。遗憾的是,软件表现仍未达到预期。

第一代Vision Pro发布时,我对平台前景持乐观态度,但这很大程度上依赖于强劲的内容节奏和第三方开发者支持。然而,第一年的内容发布节奏令人失望。虽然我期待TV应用中苹果沉浸式视频的每周更新,但这些短视频却相隔数月才出现。

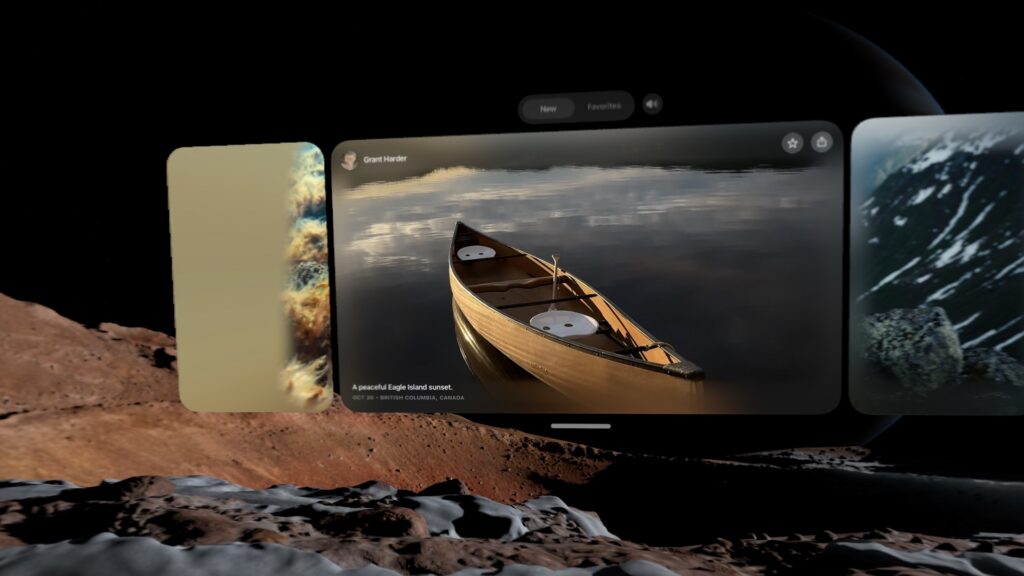

不过,第一年后的内容发布节奏有所加快。苹果还引入了空间库(Spatial Gallery),这是一个内置应用,聚合沉浸式3D照片等内容,类似于水平滚动的TikTok,正是平台在发布时急需的功能。

现有内容——无论是在TV应用还是空间库中——都非常出色,是专业制作且充分利用硬件优势的内容。例如,有一部关于U2主唱博诺的自传电影,在格式上做了创新尝试,是我从未见过甚至想象过的。

尽管内容状况比一年前好,但仍不足以让用户每天娱乐数小时,但足以让用户每周佩戴设备一次左右,这在一年前是不可能的。

应用支持:停滞在2024年

许多用户有一套日常生产力必备应用,但对于主要使用macOS的我来说,这些应用包括:Firefox、Spark、Todoist、Obsidian、Raycast、Slack、Visual Studio Code、Claude和1Password。

令人惊讶的是,几乎所有这些应用在visionOS上都可用——但这仅仅因为它能将iPad应用作为平面虚拟窗口运行。Firefox、Spark、Todoist、Obsidian、Slack、1Password甚至Raycast都可作为支持的iPad应用使用,但令人意外的是,尽管有iPad版本的Claude应用,Claude却不可用。(ChatGPT的iPad应用可以工作。)VS Code当然不可用,但我也没期望它能用。

没有一款应用是真正的visionOS原生应用。这很遗憾,因为我想象空间计算版本可以做得很有趣。想象一下在增强现实中浏览你的Obsidian图谱!唉,这只能是我的梦想。

即使不考虑生产力应用,专注于娱乐应用,仍有令人沮丧的缺口。近两年过去了,仍然没有Netflix或YouTube应用。虽然有足够好的YouTube第三方选项,但Netflix必须在浏览器中观看,质量低于原生应用,在Vision Pro的大虚拟屏幕上看起来很糟糕。

杀手级应用:虚拟显示器

尽管苹果在开发者支持方面没有重大突破,但在使Vision Pro成为Mac的便捷伴侣方面取得了长足进步。

从最初开始,它就有一个功能,只需看Mac的内置显示器,点击手指,就能启动一个可调整大小的虚拟大显示器。虽然我在家有自己的多显示器设置,但旅行时有时会这样使用Vision Pro。

visionOS现在支持三种不同的显示器尺寸:标准宽屏比例、类似标准超宽屏的更宽选项,以及一个巨大的、超超宽环绕式显示器,可以确保没有人会抱怨桌面空间不足。看起来很棒,问题解决了!同样,它现在会自动将Mac音频传输到Vision Pro或其蓝牙耳机。

通过一系列更新,苹果将一个巧妙的概念验证功能变成了真正有价值的东西——特别是对于喜欢超宽或多显示器设置但经常旅行(如我自己)或不愿在家投资显示硬件的用户。

你还可以在这个显示器上玩Mac游戏。我尝试用控制器在上面玩《无人深空》和《赛博朋克2077》,体验非常棒。

这加上空间视频和看电影功能,是Vision Pro目前最突出的杀手级应用,也是苹果明显投入大量精力改进平台的领域之一。

Personas与EyeSight:不必要的功能

苹果投入大量资源改进的另一个奇怪领域是Vision Pro作为通信和会议设备的实用性。Personas——为Zoom通话等创建的3D头像——在M2 Vision Pro发布时非常糟糕。

还有EyeSight功能,它使用你的Persona向周围的人展示你眼睛的模拟形象,让他们知道你意识到周围环境,甚至让他们跟随你的视线。我理解这个功能背后的想法——苹果不想让混合现实变得 socially isolating(社交隔离)——但它有时会把眼睛放在错误的位置,有点难以看清,老实说,这似乎是在浪费昂贵的硬件。

通过软件更新,我很高兴地报告Personas已经大幅改进。我的现在看起来真的像我本人,动作也更自然。

但我对EyeSight的评价不高,它看起来和以前一样。很难想象苹果在这款设备上放置了多个传感器和屏幕来支持这个功能。

在我看来,放弃EyeSight是苹果能为这款头显做的最好的事情。大多数人不喜欢它,大多数人也不想要它,但毫无疑问,它的加入显著增加了产品的价格和重量,这是产品采用的两大障碍。

同样,Personas理论上很酷,参加FaceTime通话并查看其工作方式是一种新颖有趣的经验。但仅此而已:一种新颖体验。一旦你尝试过,就永远不会觉得需要再次尝试。我几乎无法想象有人宁愿以Persona形象出现在通话中,而不是摘下头显30分钟,用电脑拨入。

这款设备的很大一部分都致力于它可以成为连接他人的设备,但保持这一优先级 simply 是错误的决定。混合现实是 isolating 的,苹果正在将其视为需要解决的问题,但我认为这是其吸引力的一部分。

如果这款头显支持任何涉及将其带出家门进入公共场所的应用程序,我不会这么认为,但Vision Pro不支持任何这样的应用。我能想到的许多酷炫的理论性AR应用都会涉及这一点,但在这里仍然没有实现。

元宇宙(这是我至少一年来第一次输入这个词)已经存在:它存在于我们的手机上,存在于Instagram、TikTok、微信和《堡垒之夜》中。它不需要被发明,也不需要新的巧妙方法来使其起飞。它已经被发明了,它已经在轨道上运行。

未来展望:希望这不是死胡同

据可靠行业分析师郭明錤预测,M5 Vision Pro是产品线中计划发布的四个新版本中的第一个。接下来,他预测将推出全面重新设计的Vision Pro 2和更轻便、更便宜的Vision Air。这些都将 precede 多年后的真正的智能眼镜。

我喜欢这个计划:为想要最优质混合现实体验的用户保留全功能Vision Pro(但可能放弃EyeSight),并推出更便宜的版本,与Meta的Quest系列产品或Valve新发布的Steam Frame VR头显以及谷歌、三星等计划中的竞争对手直接竞争。

真正的增强现实眼镜是一个令人惊叹的梦想,但在这些设备能够真正像蒂姆·库克预测的那样取代智能手机之前,我们还有很长的路要走解决光学和用户体验方面的严重问题。

然而,看起来这个计划已被质疑。10月彭博社的一篇报道称,苹果CEO蒂姆·库克告诉员工,公司正在将未来透射式HMD产品的资源重新分配,以加速智能眼镜的工作。

让我们现实一点:它永远只会是一个偶尔使用的设备,而不是日常驱动器。对于许多人来说,如果价格是1000美元,那会是可以接受的。在3500美元的价格下,它对大多数消费者来说仍然是一个无法接受的选择。

我相信这个产品在市场上仍有空间。我仍然认为它很棒。它不会像iPhone甚至iPad那样大,但它已经找到了一个小众受众,如果价格和重量能够降低,这个受众可能会显著扩大。移除与Personas和EyeSight相关的所有硬件将有助于实现这一目标。

我希望苹果继续研发它。当苹果发布Apple Watch时,它在用户生活中的定位并不完全明确。答案(健康和健身)随时间的推移变得清晰,设备的其他雄心逐渐消退,而公司开始建立在效果最好的基础上。

结论:苹果需要做出艰难选择

苹果在扩展Mac空间显示功能方面已经在这方面做了一些努力。这可以是一个引人入胜旅程的开始。但作家们有一个有些粗俗的说法:"kill your darlings"(杀死你的宝贝)。这意味着你需要对自己的作品有清醒的认识,无情地删除任何不起作用的东西,即使你个人喜欢它——即使它是让你最初对项目感到兴奋的主要原因。

苹果是时候开始对Vision Pro杀死一些宝贝了,但我真心希望它不要走得太远,而彻底杀死整个平台。

Vision Pro代表了空间计算的未来潜力,但它需要更清晰的市场定位、更丰富的内容生态和更合理的价格策略。苹果必须决定:是要继续追求全能型混合现实设备的梦想,还是要专注于让Vision Pro成为特定场景下的最佳工具。无论选择哪条路,都需要勇气和远见,而这正是科技创新所必需的。