科技巨头动态:从健康担忧到战略转型

苹果CEO库克手部颤抖引发的健康担忧成为本周科技圈热议话题。据知名科技记者古尔曼透露,库克的手会"时不时发抖",这一现象在苹果内部被越来越多地讨论。无论是高管还是普通员工,都在会议或大型公司活动中注意到了这一异常。

值得关注的是,随着库克即将年满65岁,关于苹果下一任CEO的关注度也随之提升。目前,苹果硬件工程高级副总裁约翰·特努斯被视为最有可能的接班人选。特努斯在苹果任职多年,主导了iPad全系产品、最新iPhone机型及AirPods的研发,也是Mac从英特尔转向自研芯片过程中最关键的领导者之一。

与此同时,阿里巴巴对"大消费平台"的战略转型也在持续推进。饿了么App全面焕新为"淘宝闪购",阿里集团合伙人、饿了么董事长兼CEO范禹在内部信中表示,这体现了阿里集团对"大消费平台"的战略决心和能力。"过去的18年征程,饿了么从朴素初心出发,一步步构建起覆盖亿级用户、连接百万商家、支持千万家庭的生活服务体系。"

科技监管与争议:马斯克与欧盟的激烈交锋

科技监管与企业发展之间的矛盾本周因马斯克与欧盟的交锋而达到高潮。当地时间12月6日,马斯克抨击欧盟针对其社交媒体平台X的1.2亿欧元罚款决定,称将对处罚决定相关的欧盟高级官员作出回应。

马斯克在个人社交平台上发文称:"欧盟不仅对X平台开出这笔荒唐的罚单,还将我本人列为处罚对象,这简直太荒唐了!因此,我们的反击措施不仅应该针对欧盟,也将直接对准那些针对我采取此番行动的个人。"随后他又发文称:"欧盟或许应当被废除,将主权归还各个国家,以便各国政府能更好地代表本国人民。"

当地时间12月5日,欧盟依据《数字服务法案》作出首份"不合规决定",认定马斯克旗下社交媒体平台X在透明度方面违法,将对其处以1.2亿欧元罚款。欧盟给予社交媒体平台X60天时间提供解决方案,以及90天时间实施整改。

技术突破与创新:从DNA存储到空中通信

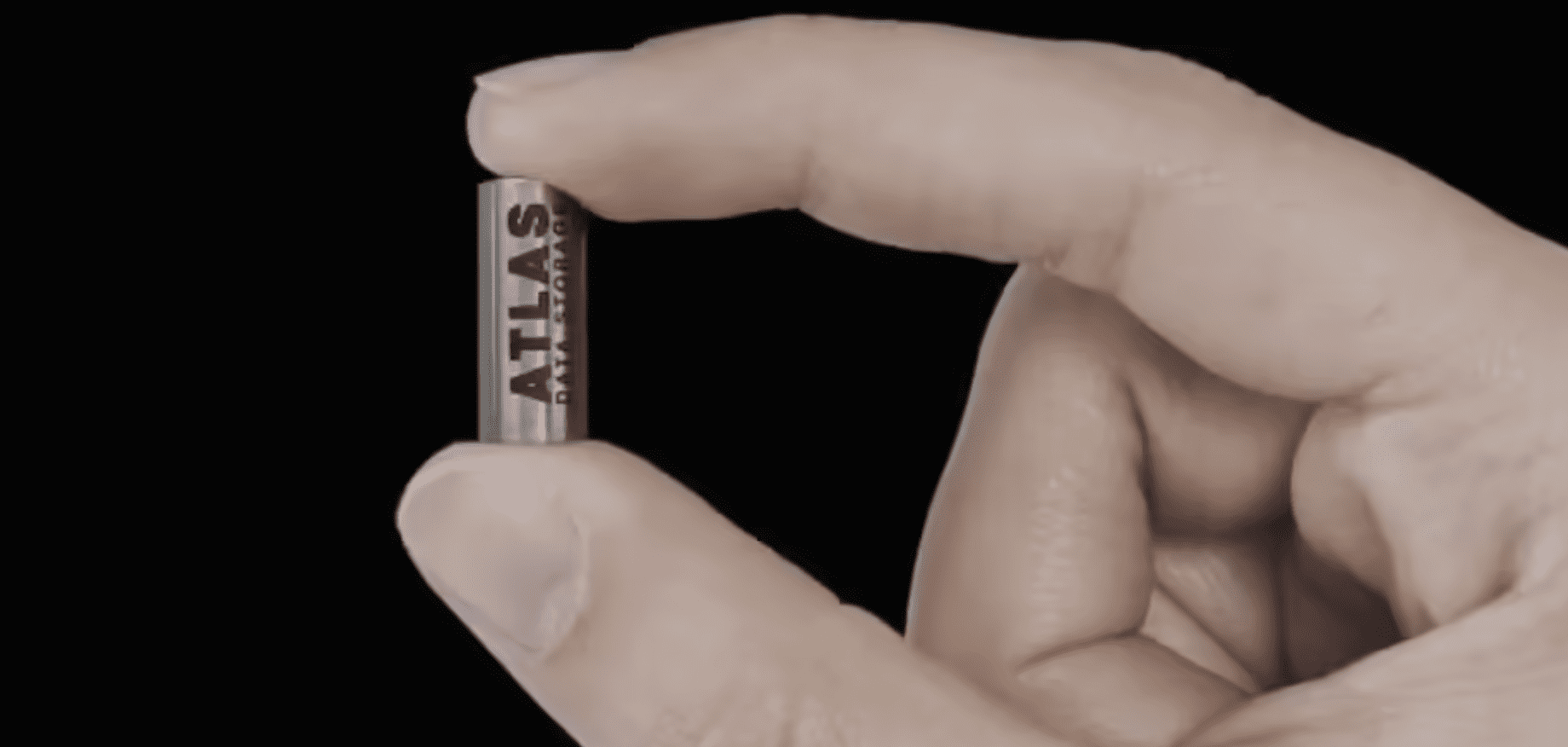

本周科技领域有多项重要技术突破值得关注。美国DNA存储技术初创公司Atlas Data Storage宣布推出其首款商业化产品"Atlas Eon 100",并宣称这是"全球首个可扩展的DNA数据存储解决方案"。该公司重点强调了DNA存储的超高密度与超长耐久性,其胶囊能够"存储(数据)数千年而无需刷新,且在高达104华氏度(约40摄氏度)的环境下保持稳定"。

华为在通信技术方面也有新突破。华为终端BG CTO李小龙发文分享,称在飞机上和同事测试了无网通信功能,实现了在天上也可以自由地发消息和打电话。据华为官网信息,有网络时畅连无网通信也可以使用,可以接收到附近无网联系人的发送的消息或畅连通话,并在24小时内回复无网用户发送的消息。

汽车与机器人:新技术展示与市场动态

在汽车领域,长城汽车欧拉5将于12月16日上市(原定于12月9日),预售价区间10.98-14.28万元。这款纯电SUV延续了欧拉"猫"系列车型的设计,尺寸方面,长宽高分别是4471*1833(1844)*1641mm,轴距为2720mm。动力方面,欧拉5配备最大功率150kW的电机,搭载蜂巢能源磷酸铁锂短刀动力电池,有45.3kWh和58.3kWh两种容量可选,对应续航里程分别为480km和580km。

机器人技术方面,众擎机器人放出了一段演示视频,展示了众擎T800体能输出与灵活操控能力。在视频中,众擎机器人公司创始人、董事长、CEO赵同阳在穿戴护具的情况下"正面硬抗T800一脚",但很显然75公斤级的重量仍是扛不住T800一脚。赵同阳本人评论称:"如果不戴护具绝对会骨折。"

娱乐产业与网红文化:票房表现与法律纠纷

娱乐产业方面,《疯狂动物城2》表现强劲。据猫眼专业版数据,截至12月7日17时41分,上映12天,该片中国内地总票房(含预售)突破30亿元,达到30.20亿,超越北美票房成绩,成为本片全球第一大票仓。这一成绩也让该片进入中国2025年度票房榜前三,离排名第二的《唐探1900》仅差不足6亿元。

网红文化方面,拥有超过5000万粉丝的网红IShowSpeed(中国网友称他为"甲亢哥")因在直播中暴力损毁人形机器人"Rizzbot"而被起诉。据科技媒体TechCrunch获取的诉状显示,Rizzbot的开发公司Social Robotics已于11月向法院提交诉状,对Speed本人、其经纪公司Mixed Management以及当天随行的一名制作人提起诉讼。

视频证据显示,Speed在直播期间反复击打Rizzbot面部、对其施以锁喉动作、一度将其按倒在沙发上,并最终将其摔至地面。诉状指出,此次事件直接导致Rizzbot"彻底损毁","完全丧失功能",其嘴部和颈部遭受严重损伤,头部摄像头已无法运作,颈部后方连接传感器的接口全部失效,机器人整体结构失稳,已无法正常行走。

科技产业趋势分析

本周科技热点反映了几个重要趋势:首先,科技巨头领导层健康问题引发企业战略规划思考;其次,数据存储技术向更长期、更稳定的方向发展;第三,科技监管与企业创新之间的矛盾日益凸显;第四,通信技术向无网络环境拓展;第五,机器人技术展示出强大的物理能力;最后,娱乐产业与网红文化相互影响,但也带来法律和伦理挑战。

这些趋势共同塑造了当前科技产业的发展方向,也预示着未来可能出现的技术突破和商业模式创新。随着DNA存储、无网通信等技术的成熟,我们有理由相信,未来的科技将更加注重长期保存、无处不在的连接以及人机交互的自然性。

未来展望

展望未来,科技领域将继续保持快速发展态势。DNA存储技术有望成为长期数据保存的重要解决方案,特别是在文化遗产保护和长期归档方面;无网通信技术将进一步扩展应用场景,特别是在应急通信和特殊环境下的通信需求;机器人技术将更加注重与人类的自然交互,减少伤害风险;而科技监管也将更加精细化,平衡创新与规范的关系。

同时,随着AI技术的快速发展,科技伦理和法律问题将更加突出,需要社会各界共同探讨和解决。如何在推动科技创新的同时,确保技术发展符合人类整体利益,将是未来科技发展的重要议题。

结语

本周科技热点展现了科技行业的活力与挑战,从技术创新到商业应用,从企业战略到监管环境,各个方面都在不断变化和发展。作为科技爱好者,我们应当保持关注,理解这些变化背后的深层含义,同时也要思考科技发展对人类社会的影响,共同推动科技向更加有利于人类福祉的方向发展。