在科技日新月异的今天,2025年的产品市场呈现出前所未有的创新活力。从人工智能到量子计算,从虚拟现实到生物科技,各个领域都在不断突破技术边界。本文将深入探讨那些在极客圈引起轰动的创新产品,分析它们的技术亮点、创新理念以及对未来科技发展的深远影响。

一、智能穿戴设备的革命性突破

1.1 无感健康监测系统

2025年,智能穿戴设备已经超越了简单的计步和心率监测功能。最新一代的智能手表配备了无感健康监测系统,能够通过微型传感器阵列实时监测用户的血糖水平、血压波动、睡眠质量等多项健康指标。

这些设备采用先进的机器学习算法,能够提前预警潜在健康风险,为用户提供个性化的健康建议。更令人惊叹的是,这些设备在保持轻薄设计的同时,电池续航时间达到了惊人的两周,彻底解决了智能穿戴设备续航短的痛点。

1.2 增强现实眼镜

增强现实眼镜在2025年实现了质的飞跃。新一代产品采用了超轻量级材料,重量不足50克,却能提供全息般的视觉体验。用户可以通过这款眼镜在现实世界中叠加虚拟信息,实现无缝的虚实融合体验。

这款AR眼镜配备了眼球追踪技术和手势识别功能,让用户无需任何物理控制器就能与虚拟世界互动。在教育、医疗、工业设计和娱乐等多个领域,这款产品已经开始展现出改变行业格局的潜力。

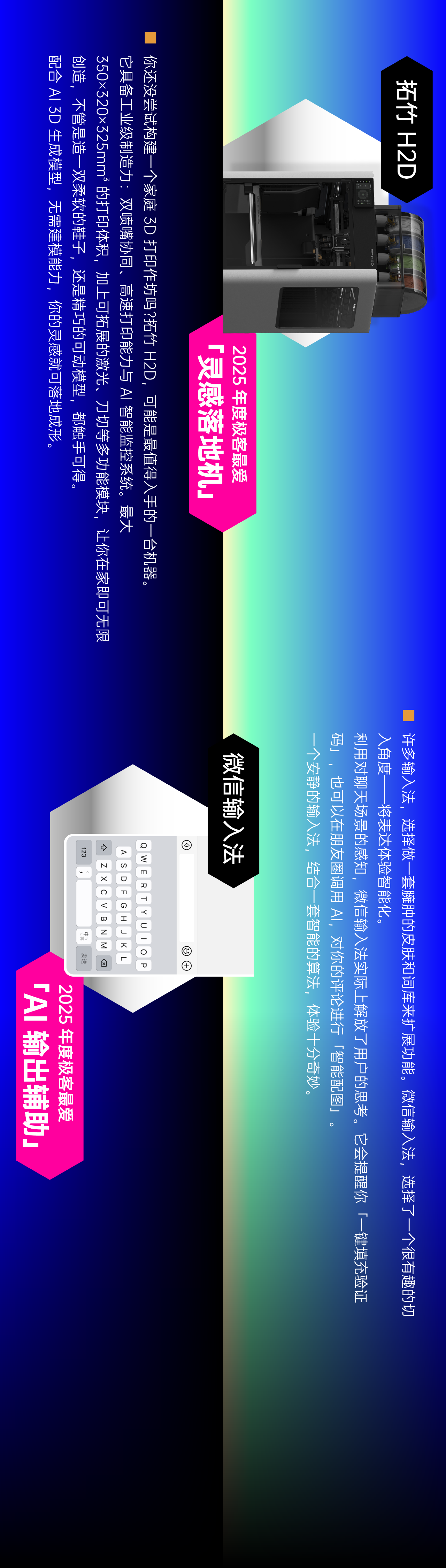

二、人工智能的深度应用

2.1 个人AI助手

2025年的个人AI助手已经不再是简单的语音问答工具,而是成为了真正理解用户需求的智能伙伴。这些AI助手能够通过长期学习用户的习惯、偏好和思维方式,提供高度个性化的服务和建议。

最新的AI助手能够跨设备无缝协作,从手机到电脑,从智能家居到汽车,它都能提供连贯一致的服务体验。更令人惊叹的是,这些AI助手已经具备了初步的情感识别能力,能够感知用户的情绪变化,提供适当的情感支持。

2.2 创意AI工具

创意领域的人工智能应用在2025年取得了突破性进展。从音乐创作到视觉艺术,从文学创作到建筑设计,AI工具已经成为专业创作者不可或缺的助手。

这些创意AI工具不仅能够模仿特定风格,更能理解创作意图,与人类创作者形成真正的协作关系。例如,一款音乐AI工具能够根据用户的情感状态和创作意图,生成符合特定氛围的旋律和和声,极大地拓展了创作的可能性。

三、智能家居的全面升级

3.1 智能家居中枢系统

2025年的智能家居已经实现了从单品智能到系统智能的跨越。新一代的智能家居中枢系统能够学习家庭成员的生活习惯,自动调整家居环境,创造最适合每个人的生活空间。

这套系统采用了边缘计算技术,即使在网络连接不稳定的情况下也能保证核心功能的正常运行。同时,它还具备强大的隐私保护机制,所有数据处理都在本地完成,确保用户数据的安全。

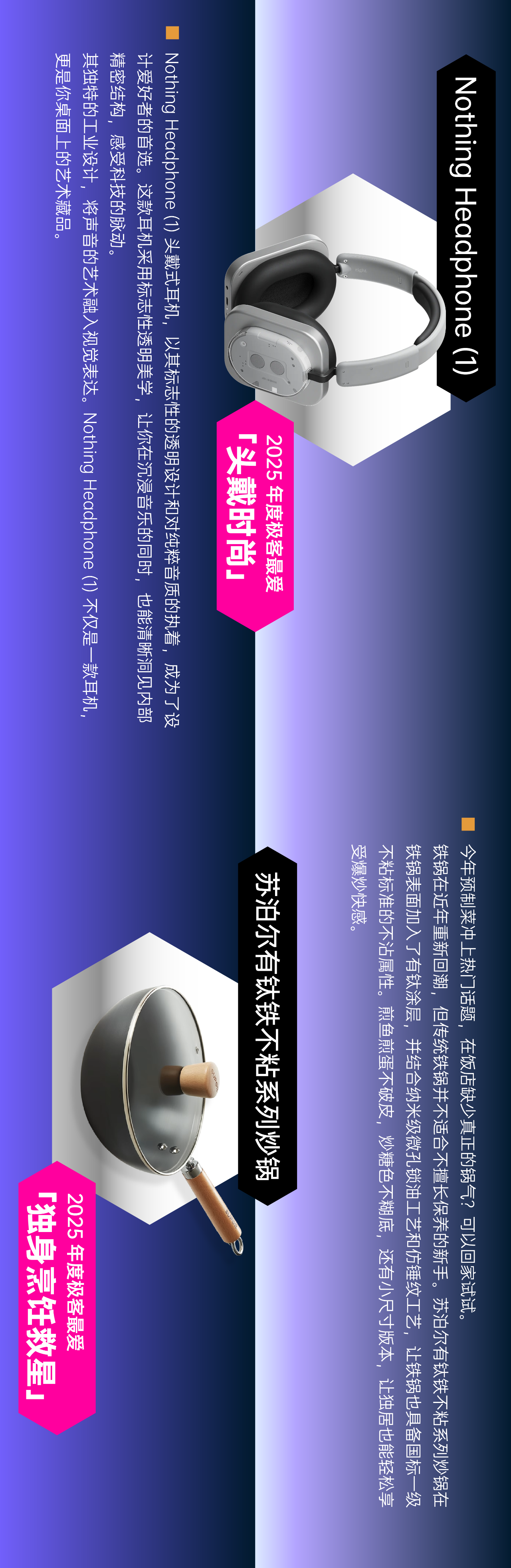

3.2 智能厨房设备

厨房作为家庭生活的中心,在2025年迎来了智能化革命。从智能冰箱到烹饪机器人,从智能烤箱到自动清洁系统,这些设备共同构成了一个完整的智能厨房生态系统。

智能冰箱能够通过摄像头识别食材,监测新鲜度,并根据家庭成员的健康状况和饮食偏好,提供个性化的食谱建议。烹饪机器人则能够根据食谱自动完成从切菜到烹饪的全过程,让烹饪变得简单而有趣。

四、沉浸式娱乐体验

4.1 虚拟现实游戏平台

2025年的虚拟现实技术已经达到了前所未有的高度。新一代VR游戏平台提供了超高清的视觉体验和逼真的触觉反馈,让用户能够完全沉浸在虚拟世界中。

这些VR设备采用了眼球追踪技术,能够根据用户的视线焦点动态调整渲染质量,既保证了视觉体验,又优化了性能表现。同时,先进的触觉反馈系统让用户能够感受到虚拟世界的触感,实现了真正的沉浸式体验。

4.2 家庭影院系统

家庭影院在2025年实现了质的飞跃。新一代家庭影院系统采用了8K分辨率和360度环绕声技术,提供了接近专业影院的视听体验。

更令人惊叹的是,这些系统还配备了实时渲染引擎,能够将普通电影转换为3D或全息格式,为用户带来全新的观影体验。智能内容推荐系统则能够根据用户的观影历史和偏好,推荐最适合的电影内容。

五、可持续科技的创新

5.1 太阳能充电设备

在环保意识日益增强的今天,太阳能技术在2025年取得了重大突破。新一代太阳能充电设备采用了高效钙钛矿太阳能电池,转换效率达到了40%,是传统硅基太阳能电池的两倍以上。

这些设备不仅能够为手机、平板等电子设备充电,还能为智能家居系统提供电力支持。柔性太阳能电池技术的进步使得这些设备可以集成到衣物、背包等日常用品中,实现随时随地充电的便利。

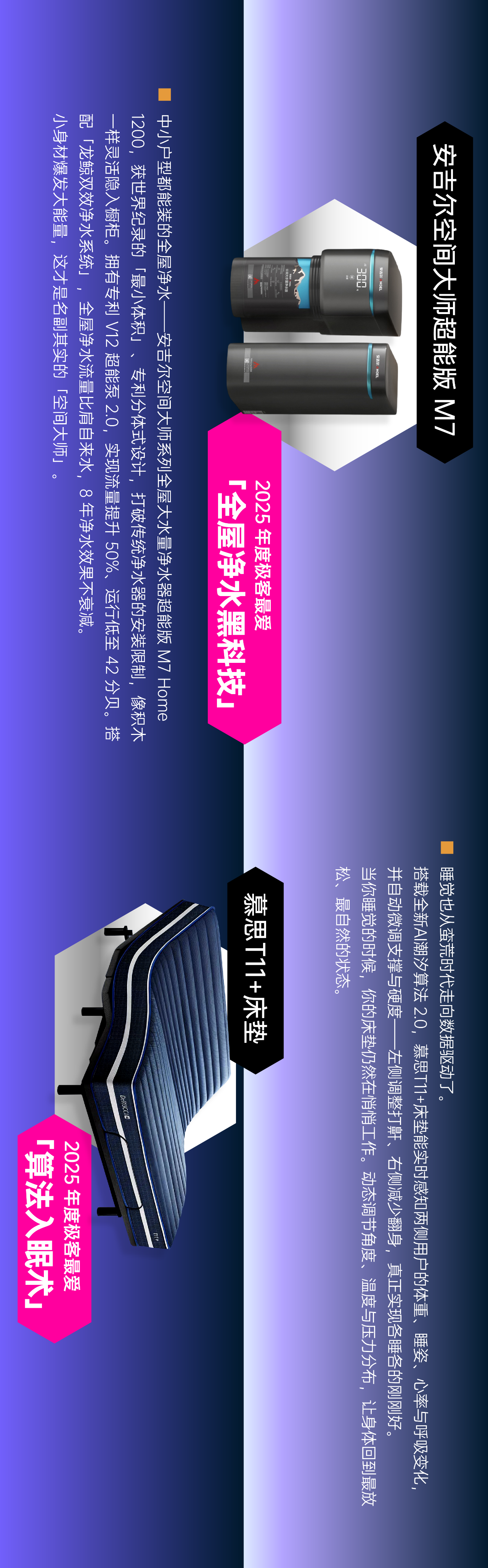

5.2 智能节水系统

水资源短缺是全球面临的重大挑战,智能节水系统在2025年成为了解决这一问题的关键技术。这些系统能够通过传感器网络实时监测家庭用水情况,识别异常用水行为,并提供节水建议。

先进的雨水收集和净化系统能够将雨水转化为生活用水,大幅减少对自来水的依赖。这些系统还配备了智能灌溉功能,能够根据天气预报和植物需求,精确控制灌溉水量,既节约水资源,又有利于植物生长。

六、健康科技的创新应用

6.1 远程医疗设备

远程医疗技术在2025年实现了质的飞跃。新一代远程医疗设备配备了高清摄像头和各种生理参数监测传感器,能够进行全面的远程诊断。

这些设备采用了先进的图像识别技术,能够通过皮肤状况、眼睛颜色等外观特征,初步判断用户的健康状况。同时,AI辅助诊断系统能够分析收集到的生理数据,提供专业的医疗建议,大大提高了医疗服务的可及性。

6.2 智能健身设备

健身科技在2025年迎来了新的突破。智能健身设备不仅能够监测运动数据,还能通过AI技术提供个性化的训练计划,并根据用户的身体状况实时调整训练强度。

这些设备配备了生物电阻抗传感器,能够精确测量体脂率、肌肉量等身体成分变化。更令人惊叹的是,它们还能通过分析用户的运动姿态,提供实时指导,帮助用户掌握正确的运动技巧,提高训练效果。

七、教育科技的创新

7.1 沉浸式学习平台

教育科技在2025年迎来了革命性的变化。沉浸式学习平台结合了VR/AR技术和AI教学系统,为学生提供了前所未有的学习体验。

学生可以通过这些平台进入虚拟实验室进行科学实验,探索历史场景,甚至与虚拟历史人物对话。AI教学系统能够根据学生的学习进度和兴趣,提供个性化的学习内容,激发学生的学习兴趣和创造力。

7.2 智能教育助手

智能教育助手在2025年成为了教师和家长的重要帮手。这些助手能够分析学生的学习数据,识别学习困难,并提供针对性的辅导建议。

这些助手还具备多语言能力,能够实时翻译教学内容,帮助语言障碍学生更好地理解课程内容。同时,它们还能与家长保持沟通,提供学生的学习进展报告,促进家校合作。

八、交通科技的进步

8.1 智能个人交通工具

城市交通拥堵问题在2025年得到了部分缓解,智能个人交通工具的普及是重要原因之一。这些交通工具采用了先进的导航系统和避障技术,能够在复杂的城市环境中安全行驶。

这些交通工具采用了模块化设计,用户可以根据需要更换不同的功能模块,如载货模块、载客模块等。同时,它们还具备自动充电功能,能够无线对接充电设施,大大提高了使用的便利性。

8.2 智能交通管理系统

城市交通管理系统在2025年实现了智能化升级。通过物联网技术和AI算法,这些系统能够实时监测交通状况,预测交通流量,优化信号灯配时,有效缓解交通拥堵。

这些系统还与个人导航设备无缝对接,能够为驾驶员提供最优路线建议,避开拥堵路段。同时,它们还能与紧急服务系统联动,为救护车、消防车等提供优先通行权,提高紧急救援效率。

九、未来展望

2025年的科技产品已经不仅仅是工具,更是人类智慧的延伸和生活的伙伴。从健康监测到娱乐体验,从智能家居到交通出行,科技创新正在全方位改变我们的生活方式。

这些创新产品不仅展示了科技的力量,更体现了以人为本的设计理念。它们不仅关注功能的实现,更注重用户体验的提升,致力于让科技更好地服务于人类。

展望未来,随着人工智能、量子计算、生物科技等领域的进一步发展,我们有理由相信,科技将继续推动人类社会向前发展,创造更加美好的未来。