智能手机中的神经处理单元(NPU)性能不断提升,但普通用户的AI体验却似乎没有明显改善。这背后隐藏着本地AI与云端AI之间复杂的竞争与合作关系。

NPU技术演进:从DSP到专用AI处理器

现代智能手机处理器系统(SoC)集成了多种计算单元,包括CPU核心、GPU和图像控制器等。NPU是SoC中较新的成员,但其发展有着深厚的技术渊源。

高通公司AI产品负责人Vinesh Sukumar表示:"我们进入AI处理领域大约在15到20年前,最初的关注点是信号处理。"高通的Hexagon NPU品牌实际上源自其数字信号处理器(DSP)系列,这种架构演变反映了AI计算需求的演变。

现代SoC中的NPU只是众多组件之一。

联发科助理副总裁Mark Odani解释道:"如果从广义上谈论DSP,是的,NPU是一种数字信号处理器。但它已经走了很长的路,在并行性、transformer工作原理以及处理大量参数方面进行了更多优化。"

尽管NPU在架构上与DSP有联系,但两者已有显著区别。NPU专为AI工作负载设计,强调并行计算能力,这是处理神经网络所必需的。

边缘计算的困境:硬件虽强,应用有限

尽管许多设备配备了强大的NPU,但这些芯片常常处于闲置状态。本地AI与云端AI工具的竞争中,后者占据了主导地位,因为大语言模型(LLM)的自然栖息地就在云端。

谷歌Pixel团队高级产品经理Shenaz Zack表示:"云服务总是比移动设备拥有更多的计算资源。"

Odani补充道:"如果你想要最准确的模型或最强大的模型,那都必须在云端完成。但我们发现,在许多用例中,比如总结文本或与语音助手对话,这些功能可以在30亿参数的模型内完成。"

将AI模型压缩到手机或笔记本电脑上需要一些妥协——例如减少模型包含的参数数量。云端模型运行着数千亿个参数,而目前消费级设备无法处理如此庞大的模型,开发者必须大幅缩减边缘设备的模型规模。

内存限制也是一个关键因素。移动优化的AI模型通常会被量化,这意味着模型对下一个token的估计运行精度较低。例如,要在设备上运行Llama或Gemma 7b等大型开源模型,标准是FP16(半精度),具有70亿参数的模型将占用13或14GB内存。而降至FP4(四分之一精度)可将模型内存占用减少到几GB。

Sukumar指出:"当压缩到大约3-4GB时,这是集成到智能手机等内存受限形态中的最佳平衡点。高通和整个生态系统已投入大量资金研究各种压缩模型的方法而不损失质量。"

隐私与信任:本地AI的核心价值

如果云端更快更简单,为什么还要费心优化边缘计算并使用NPU消耗更多能源?依赖云端意味着接受对AI数据中心运营商一定程度的依赖和信任,这种依赖并不总是适当的。

Sukumar强调:"我们始终将用户隐私作为首要考虑因素。"他解释说,最好的推理不是通用的——而是基于用户的兴趣和他们生活中发生的事情进行个性化定制。要实现这种体验需要对模型进行微调,这需要个人数据,而本地存储和处理这些数据更为安全。

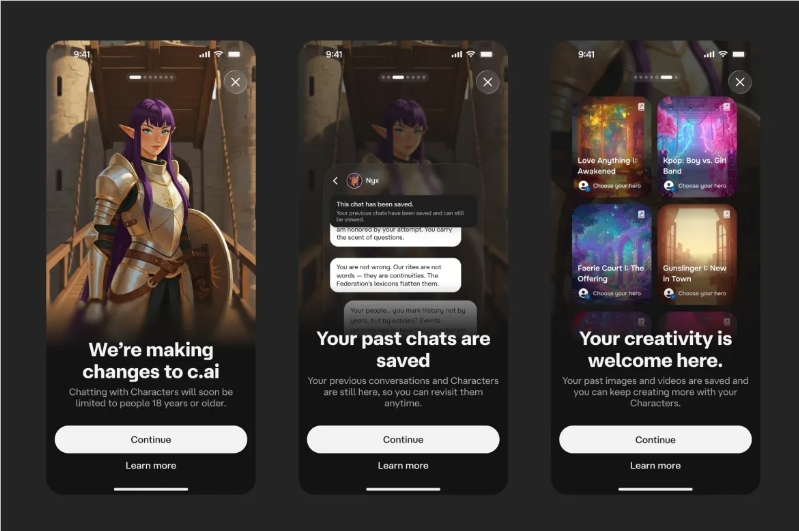

即使公司在云服务中关于隐私的承诺听起来很好,这些承诺远非保证。通用聊天bot的友好氛围也鼓励人们分享大量个人信息,如果这些助手在云端运行,您的数据也会存在于云端。OpenAI与《纽约时报》的版权诉讼可能导致数百万私人聊天记录被交给出版商。

Odani表示:"人们正在把这些生成式AI助手当作治疗师使用。你不知道有一天这些内容是否会全部出现在互联网上。"

尽管如此,并非所有人都如此担忧。Zack声称谷歌已构建了"世界上最安全的云基础设施",能够在提供最佳结果的地方处理数据。她以Video Boost和Pixel Studio为例,指出谷歌的云是使这些体验快速且高质量的唯一方式。

即使这是真的,边缘计算还有其他优势——边缘AI比云服务更可靠。Odani说:"本地处理很快。有时候我正在与ChatGPT交谈,我的Wi-Fi断了或其他问题,它就会卡顿。"

云端主导:现实与期望的差距

似乎每个人都认同混合方法是提供真正有用的AI功能所必需的(假设这些功能存在),在必要时将数据发送到更强大的云服务——谷歌、苹果和其他手机制造商都是这么做的。但对无缝体验的追求也可能掩盖了您的数据正在发生什么。通常情况下,您手机上的AI功能并没有以安全、本地的方式运行,即使设备有硬件能力也是如此。

以新发布的OnePlus 15为例。这款手机配备了高通全新的骁龙8 Elite Gen 5,其NPU比上一代快37%,无论这意味着什么。尽管有所有这些本地AI能力,OnePlus仍然严重依赖云端来分析您的个人数据。AI Writer和AI录音机等功能连接到公司服务器进行处理,OnePlus向我们保证这个系统绝对安全私密。

同样,摩托罗拉今年夏天发布了一系列新的折叠式Razr手机,搭载了来自多个提供商的AI功能。这些手机可以使用AI总结您的通知,但除非您阅读条款和条件,否则您可能会惊讶于其中有多少发生在云端。如果您购买Razr Ultra,这种总结在您的手机上进行。然而,RAM和NPU功能较少的较便宜型号使用云服务来处理您的通知。同样,摩托罗拉表示这个系统是安全的,但更安全的选择是为这些较便宜的 phone 重新优化模型。

即使原始设备制造商(OEM)专注于使用NPU硬件,结果也可能不尽如人意。看看谷歌的Daily Hub和三星的Now Brief。这些功能应该处理您手机上的所有数据并生成有用的建议和操作,但除了显示日历事件外,它们几乎不做什么。事实上,谷歌已暂时从Pixel手机中移除了Daily Hub,因为该功能功能太少,而谷歌是本地AI的先驱者,拥有Gemini Nano。实际上,谷歌最近几个月已将其移动AI体验的某些部分从本地处理转移到基于云的处理。

权衡与选择:我们能得到什么?

尽管对本地AI有浓厚兴趣,但迄今为止,这并未转化为口袋里的AI革命。我们迄今为止看到的大多数AI进步依赖于云系统规模的不断扩大和在那里运行的通用模型。行业专家表示,幕后正在努力将AI模型缩小到在手机和笔记本电脑上运行,但这需要时间才能产生影响。

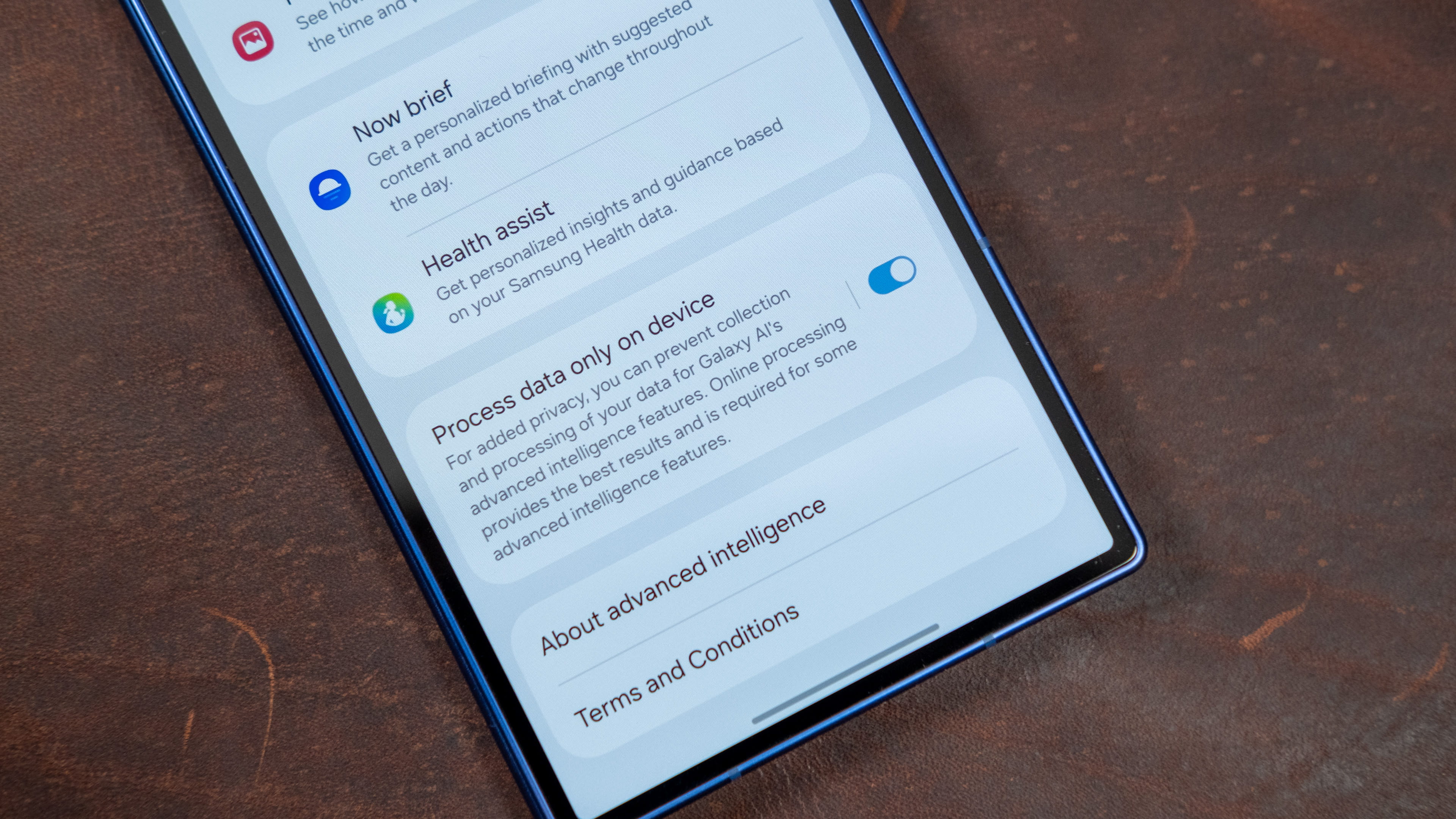

与此同时,本地AI处理以有限方式存在。谷歌仍然利用Tensor NPU处理Magic Cue等功能的敏感数据,而三星真正充分利用了高通的AI芯片组。虽然Now Brief的实用性值得怀疑,但三星意识到依赖云可能对用户的影响,在系统设置中提供了一个切换选项,将AI处理限制为仅在设备上运行。这限制了可用的AI功能数量,其他功能也无法正常工作,但您会知道没有个人数据被共享。没有其他智能手机提供此选项。

三星提供简单的切换选项,禁用云AI并在设备上运行所有工作负载。

三星发言人Elise Sembach表示,该公司的AI工作重点是增强体验同时保持用户控制。"One UI中的本地处理切换反映了这种方法。它为用户提供了在本地处理AI任务的选择,以获得更快的性能、增强的隐私性,即使在没有网络连接的情况下也能可靠运行。"

对边缘AI的兴趣可能是一件好事,即使您不使用它。为这个AI丰富的未来做准备可以鼓励设备制造商投资更好的硬件——比如更多内存来运行所有这些理论上的AI模型。

Sukumar确实表示:"我们 definitely 建议我们的合作伙伴增加他们的RAM容量。"确实,谷歌、三星等公司增加了内存容量,很大程度上是为了支持本地AI。即使云端正在获胜,我们也会接受额外的RAM。

未来展望:本地与云端的协同进化

随着技术的不断进步,本地AI和云端AI的界限将变得越来越模糊。未来的AI生态系统很可能是一种混合模式,其中敏感任务在设备上处理,而复杂计算则依赖云端资源。

高通、谷歌和三星等公司正在积极投资于更高效的模型压缩技术和更强大的边缘硬件,这将使本地AI能力在未来几年内显著提升。同时,云服务提供商也在不断优化其基础设施,减少延迟并提高能效。

对于消费者而言,这种竞争与合作并存的生态意味着更丰富的AI体验,同时也有更多关于数据隐私和使用的知情选择。随着技术的成熟,我们可能会看到更多像三星那样的用户控制选项,让用户根据自己的需求和信任级别决定如何处理AI任务。

最终,手机NPU的进步不仅仅是关于技术规格的提升,而是关于如何将这些计算能力转化为真正有用且尊重用户隐私的AI体验。这个过程可能比我们想象的要长,但方向是明确的——未来的AI将更加智能、更加个性化,并且更加平衡地利用本地和云端资源。