引言:AI信任现状

近年来,人工智能技术迅猛发展,从ChatGPT到自动驾驶,AI正在改变我们的生活方式。然而,权威调查显示,公众对AI的信任度却呈现出令人担忧的下降趋势。Edelman和Pew Research的最新研究表明,美国及西方国家民众对AI的接受度普遍偏低,这与AI行业内部的高度乐观形成鲜明对比。这种信任鸿沟不仅阻碍了技术的普及应用,更可能对AI的长期发展产生深远影响。

全球AI信任度热图显示了不同国家民众对AI解决贫困和气候变化等问题的信心差异,直观反映了地区间AI接受度的巨大差距。

调查数据揭示的信任危机

Edelman调查结果

Edelman的调查数据显示,在美国,49%的人拒绝AI的日益广泛应用,只有17%的人拥抱这一技术。相比之下,中国的数据呈现出截然不同的图景——只有10%的人拒绝AI,而54%的人对其持积极态度。这种差异不仅存在于中美之间,在全球范围内,许多国家对AI的接受度都明显高于美国。

Pew Research的发现

Pew Research的数据同样证实了这一趋势,显示美国以外许多国家对AI采用的热情远超美国。这种信任差距不仅影响AI技术的市场渗透,还可能成为国家竞争力的关键因素——对AI的积极态度已成为国家优势的重要组成部分。

AI信任缺失的深远影响

个人采纳缓慢

Edelman的数据表明,在美国,那些很少使用AI的人群中,70%的人表示"信任"是主要障碍,远高于缺乏动机和访问渠道(55%)或技术 intimidating(12%)。这表明,即使技术易于获取,公众的疑虑仍然是阻碍AI普及的关键因素。

社会项目受阻

AI技术的许多重要应用需要社会支持,但公众的不信任导致这些项目难以推进。以印第安纳州为例,当地社区的抗议最终迫使谷歌放弃了在该地区建设数据中心的计划。数据中心的短缺将直接制约AI的发展,而公众对AI的不信任只是更广泛担忧的一部分。

法律法规风险增加

随着AI信任度的下降,针对AI的反对声音日益高涨,这增加了通过限制性法规的风险。 populist 情绪可能导致立法者通过仓促制定的法规,这些法规虽然可能出于好意,但实际上可能阻碍AI的创新和发展。

信任危机的根源分析

夸大其词的宣传

AI行业内部存在一种令人不安的趋势——过度夸大技术的危险性和能力。一些领先的AI公司为了使自己的技术显得异常强大,不惜将其比作核武器等具有毁灭性潜力的技术。这种做法虽然可能带来短期商业利益,但长远来看却严重损害了公众对AI的信任。

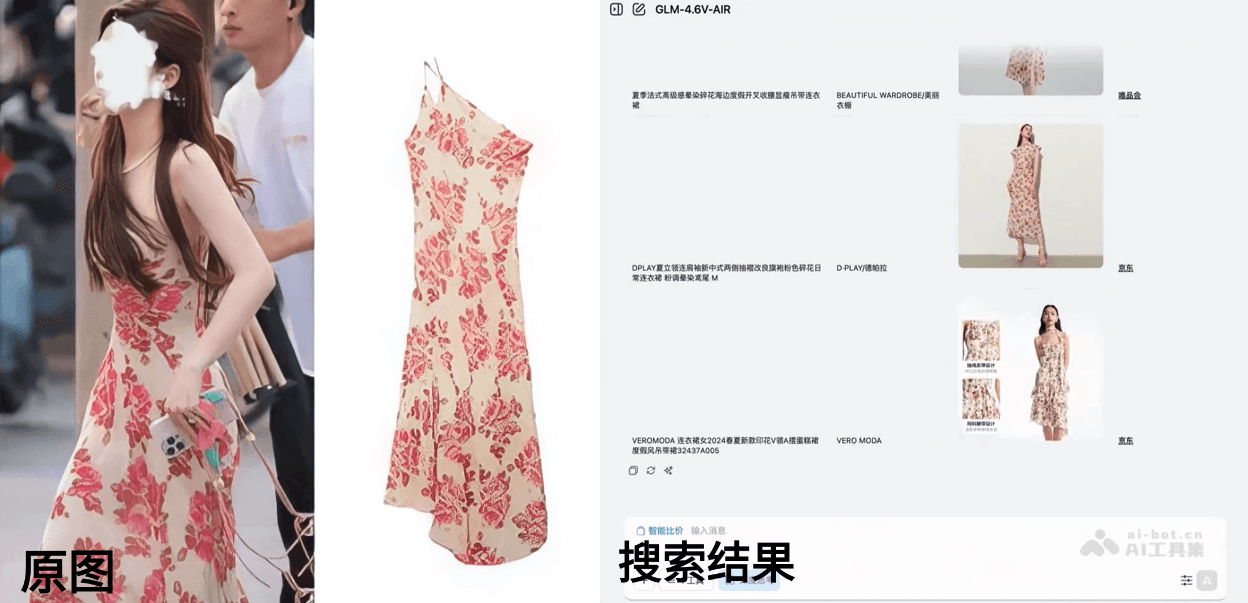

媒体误导性报道

媒体对AI的报道往往缺乏平衡,倾向于强调风险而忽视益处。例如,Nirit Weiss-Blatt在一篇文章中指出,_60 Minutes_对Anthropic研究的报道极具误导性。该研究是一项红队测试,研究人员经过大量努力才使Claude表现出"敲诈"行为,但新闻报道却让许多人误以为这种行为是AI自然发生的,从而严重夸大了AI"策划"行为的频率。

技术透明度不足

AI系统,特别是大型语言模型,往往被视为"黑盒",用户难以理解其决策过程。这种不透明性加剧了公众的疑虑,当AI系统做出错误或有害的决策时,用户无法理解原因,从而进一步削弱信任。

解决AI信任危机的路径

确保AI普惠发展

要赢得公众信任,AI社区必须确保技术能够广泛惠及每个人。"提高生产力"这样的表述往往被普通受众理解为"我的老板会赚更多钱",甚至是裁员。我们需要开发真正对人们生活产生积极影响的应用,而不仅仅是提高效率的工具。

提供全面的AI教育

教育培训是解决信任危机的关键一环。DeepLearning.AI将继续在AI培训领域发挥领导作用,但单靠一家机构是不够的。我们需要建立多层次的教育体系,帮助公众理解AI的基本原理、能力和局限性,从而做出明智的决策。

提升技术透明度

AI开发者需要更加注重系统的可解释性和透明度。当用户能够理解AI系统的决策过程时,他们更可能信任这些系统。这包括开发更好的可视化工具,解释AI的推理过程,以及明确说明系统的能力和局限性。

避免夸大其词和恐吓营销

AI社区的每个成员都有责任避免过度炒作或散布恐惧。尽管有时为了宣传或游说政府可能存在这种诱惑,但这种短视行为最终会损害整个行业的声誉。我们需要以诚实、客观的方式讨论AI的潜力和风险。

呼吁负责任的媒体报道

AI社区应当积极呼吁媒体进行更加负责任的报道。当发现误导性或不准确的报道时,应当及时指出并纠正。这不仅有助于公众获得准确的信息,也有助于建立AI社区与媒体之间的良性互动。

面向未来的AI信任建设

作为AI社区的一员,我们需要认识到,生活在技术爱好者组成的"泡沫"中是有风险的。虽然这种环境有利于创意交流和相互激励,但我们也必须正视AI存在的问题,并积极解决它们。

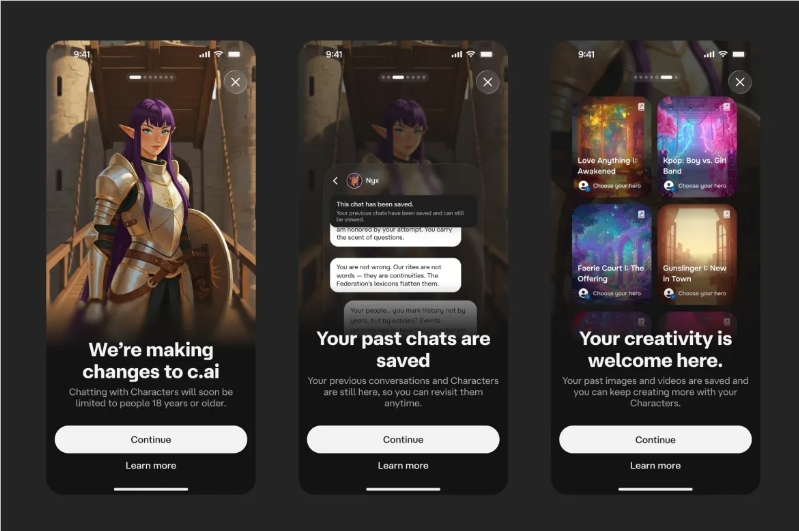

与不同背景的人交流可以帮助我们更好地理解公众的担忧。我曾与艺术家讨论AI如何影响他们的创作价值,与即将毕业的大学生探讨AI对就业市场的影响,以及与父母交流孩子使用聊天机器人可能面临的成瘾风险和有害建议问题。

结语:共建可信AI未来

解决AI信任危机没有简单的答案,但我们需要共同努力。通过确保AI技术的普惠性、提升透明度、加强教育、避免夸大其词,以及呼吁负责任的媒体报道,我们可以逐步重建公众对AI的信任。

这不仅关乎AI行业的健康发展,更关乎我们能否充分发挥AI解决全球性挑战的潜力。只有赢得公众的信任,AI才能真正成为推动社会进步的积极力量。让我们携手努力,共同构建一个可信、可靠、负责任的人工智能未来。