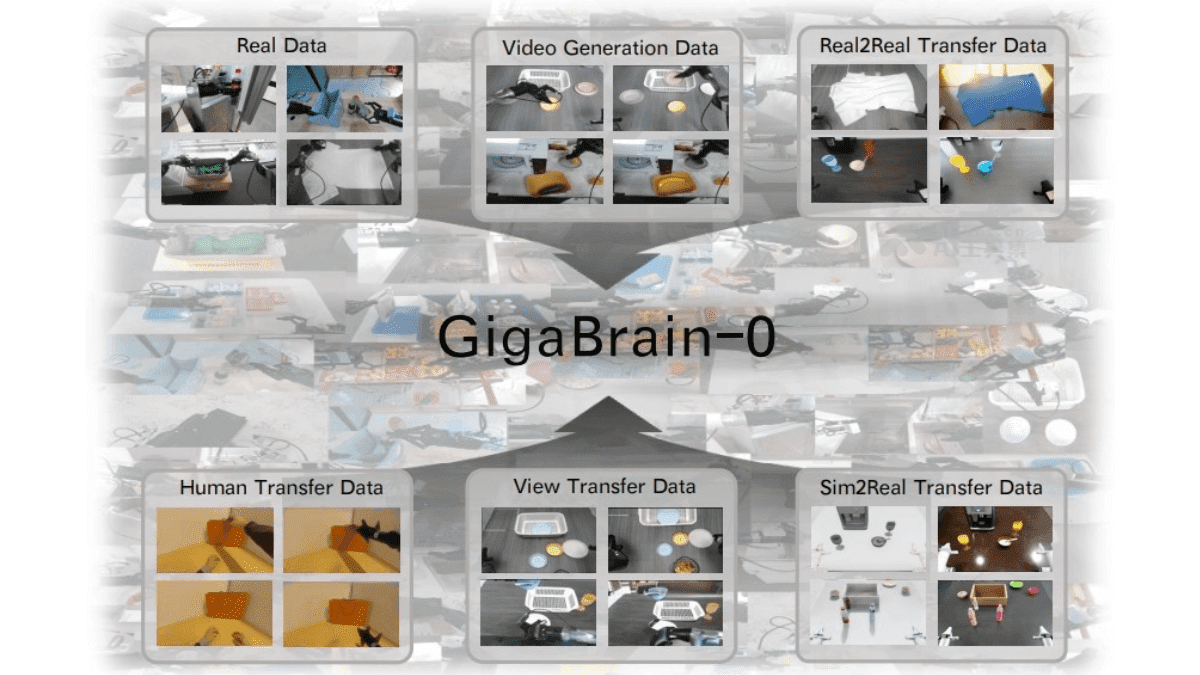

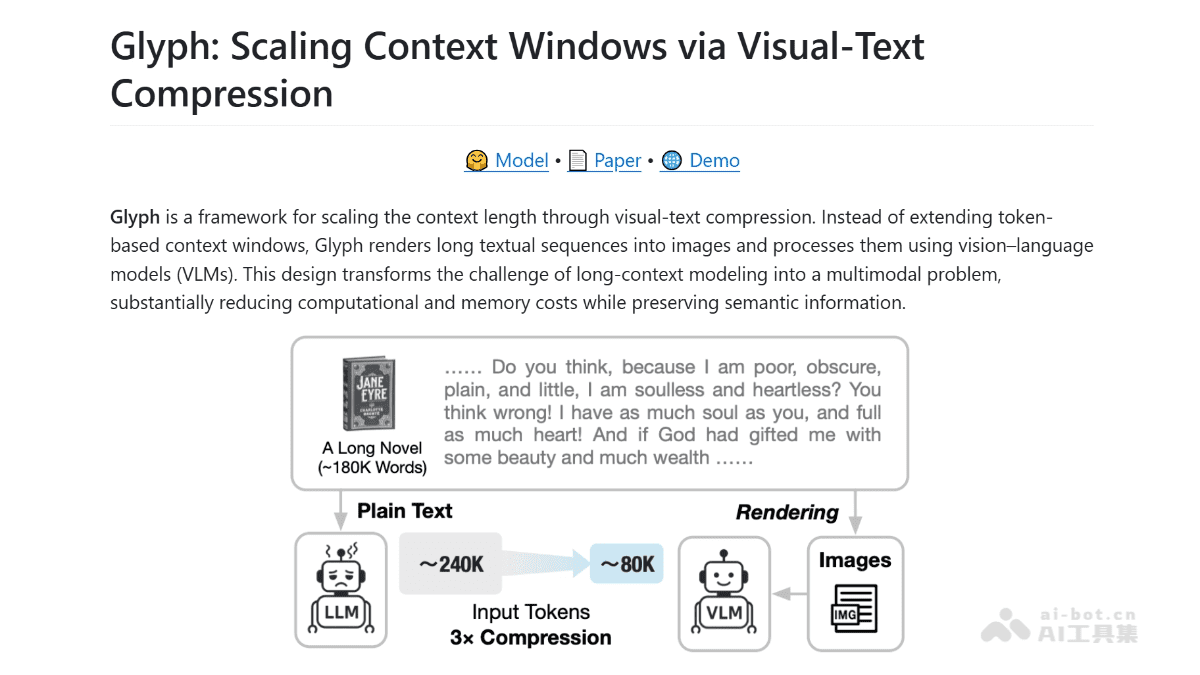

在人工智能领域,大语言模型(LLM)的上下文窗口限制一直是制约其处理长文本的关键瓶颈。随着智谱AI与清华大学CoAI实验室联合推出开源框架Glyph,这一难题得到了创新性的解决方案。Glyph通过将文本转化为图像的方式,实现了惊人的3-4倍上下文压缩,同时大幅提升了推理速度并降低了显存占用。本文将全面解析Glyph的技术原理、性能优势及广泛应用前景。

视觉文本压缩:突破传统LLM的限制

传统大语言模型在处理长文本时面临着显著的挑战:上下文窗口有限、计算资源消耗巨大、推理速度缓慢等问题严重制约了其实际应用。Glyph框架提出了一种颠覆性的解决思路——将文本转化为视觉信息进行处理。

传统LLM的局限性

当前主流的大语言模型在处理长文档时存在明显瓶颈:

- 上下文窗口限制:即使是最新一代模型,其上下文窗口通常也限制在十万token以内

- 计算资源需求高:处理长文本需要大量GPU显存和计算能力

- 推理速度慢:随着输入长度增加,推理时间呈指数级增长

- 信息处理效率低:纯文本表示的信息密度有限

Glyph的创新思路

Glyph采用"视觉-文本压缩"技术,其核心思想是将长文本渲染为图像,然后利用视觉语言模型(VLM)进行处理。这种方法基于一个关键洞察:图像的信息密度远高于纯文本,一个视觉Token能够承载多个文本Token的语义信息。

Glyph的核心技术原理

Glyph框架的成功依赖于其独特的技术架构和训练流程,这一创新方法将文本处理从纯语言领域扩展到了视觉-语言跨模态领域。

视觉-文本压缩机制

Glyph的技术核心在于将文本信息转化为视觉表示:

- 文本渲染:将长文本按照特定参数(字体、DPI、行距等)渲染为图像

- 视觉Token化:使用VLM的视觉编码器将渲染图像转化为视觉Token

- 信息压缩:由于视觉Token的信息密度更高,实现了3-4倍的压缩率

- 语义保留:通过精心设计的渲染策略,确保关键语义信息不丢失

三阶段训练流程

Glyph的训练过程分为三个精心设计的阶段,每个阶段都针对特定目标进行优化:

1. 持续预训练阶段

在这一阶段,系统将海量长文本渲染成不同风格的图像,训练VLM理解这些图像中的文本内容:

- OCR任务:训练模型准确识别图像中的文字

- 跨模态语言建模:建立视觉表示与文本语义之间的关联

- 段落生成:训练模型根据上下文生成缺失的文本内容

这一阶段的目标是让VLM能够"看懂"图像中的文字信息,为后续处理奠定基础。

2. LLM驱动的渲染搜索

通过遗传算法优化文本渲染参数,Glyph找到了压缩率与准确率之间的最佳平衡点:

- 参数优化:字体大小、DPI分辨率、行间距、页边距等

- 多目标优化:在保持语义准确性的同时最大化压缩率

- 风格多样性:确保模型对不同渲染风格具有鲁棒性

3. 后训练阶段

在最优渲染配置下,Glyph进行有监督微调(SFT)和强化学习(RL):

- OCR辅助任务:确保模型能精准"看清"文字细节

- 端到端训练:优化从文本输入到视觉表示再到输出的完整流程

- 质量控制:引入人工评估和自动化指标确保输出质量

视觉Token的优势

视觉Token相比传统文本Token具有显著优势:

- 信息密度高:一个视觉Token可包含多个文本Token的语义

- 排版信息保留:能同时处理文字内容、布局和格式信息

- 跨模态统一:为纯文本和图文混合内容提供统一处理框架

- 计算效率高:减少处理长文本所需的计算资源

Glyph的性能优势分析

Glyph框架在实际应用中展现出卓越的性能,其优势体现在多个维度,从计算效率到任务表现都有显著提升。

推理速度大幅提升

Glyph在推理阶段表现出色,具体数据如下:

- Prefill速度提升4.8倍:显著减少初始处理时间

- 解码速度提升4.4倍:加快生成过程

- 端到端加速:整体推理时间大幅缩短

这种加速效果使得处理超长文本任务变得更加高效,特别适合需要实时响应的应用场景。

显存占用显著降低

由于视觉Token的信息密度更高,Glyph在显存使用方面表现出色:

- 显存占用减少约2/3:大幅降低硬件需求

- 家用级GPU支持:可在4090、3090等消费级显卡上运行

- 成本效益提升:降低大规模部署的硬件门槛

这一特性使得Glyph能够被更广泛的用户群体所使用,不再局限于拥有顶级计算资源的机构。

多模态任务表现优异

Glyph在处理混合内容时展现出强大能力:

- PDF文档理解:准确率提升13%

- 图文混合处理:统一框架处理多种模态

- 泛化能力强:在不同任务类型间保持稳定表现

这种多模态能力使得Glyph能够处理现实世界中更复杂的文档类型,如包含图表、公式和图像的学术文献。

低成本建模方案

Glyph提供了一种经济高效的长上下文建模方案:

- 无需训练超大模型:避免高昂的训练成本

- 现有VLM复用:利用成熟的视觉语言模型

- 渲染策略优化:通过算法而非规模提升效率

这一特点使得研究者和开发者能够以较低成本实现长文本处理能力,加速创新应用的开发。

Glyph的技术实现细节

深入Glyph的技术实现,我们可以发现其架构设计和工程考量都经过精心优化,以确保在实际应用中的高效性和稳定性。

文本渲染策略

Glyph的文本渲染是将抽象文本转化为视觉表示的关键步骤:

- 字体选择:根据文本类型和内容特点选择合适字体

- 布局优化:调整行距、页边距等参数提高可读性

- 分辨率设置:平衡图像质量和文件大小

- 分页策略:将长文本合理分割为可管理的页面单元

视觉语言模型集成

Glyph与现有VLM的集成方式体现了工程上的巧妙设计:

- 模块化架构:便于替换不同VLM实现

- 接口标准化:统一输入输出格式简化集成

- 性能优化:针对文本理解场景定制模型参数

- 扩展性设计:支持未来VLM的快速迭代更新

计算效率优化

Glyph在计算效率方面进行了多项优化:

- 批处理机制:充分利用GPU并行计算能力

- 内存管理:优化数据加载和缓存策略

- 计算图优化:减少冗余计算和中间结果存储

- 精度平衡:在性能和精度间找到最佳平衡点

Glyph的广泛应用场景

Glyph框架的多项优势使其在多个领域都有广阔的应用前景,从教育到医疗,从企业应用到创意产业,都能带来显著的效率提升。

教育领域的革新应用

在教育领域,Glyph能够:

- 教材内容分析:快速提取教材重点和难点

- 在线课程处理:高效分析长视频课程对应的文字材料

- 学术论文总结:帮助研究人员快速把握长篇论文核心内容

- 个性化学习:根据学生需求定制内容摘要和重点提取

企业级应用场景

企业环境中,Glyph可以:

- 商业报告分析:快速提取长篇报告中的关键数据和结论

- 客户支持优化:高效处理大量客户咨询记录

- 法律文书处理:快速分析复杂合同和法律文件

- 知识管理:构建企业知识库的高效索引和检索系统

创意写作辅助

对于创意工作者,Glyph提供:

- 长篇故事规划:帮助作家把握整体故事结构和情节发展

- 剧本创作辅助:高效处理长剧本的连贯性和一致性检查

- 内容创作加速:为内容创作者提供快速素材整理能力

- 创意灵感激发:通过不同视角的内容呈现激发新想法

专业领域应用

在专业领域,Glyph展现出独特价值:

- 医疗文献分析:帮助医生快速提取医学研究关键信息

- 金融数据处理:高效分析市场报告和财务文档

- 法律文件审查:快速识别合同中的关键条款和风险点

- 科研文献综述:加速科研人员对大量文献的整理和分析

Glyph与其他技术的比较

将Glyph与现有的长文本处理技术进行比较,可以更清晰地理解其创新点和优势所在。

与传统扩展上下文方法的比较

传统扩展LLM上下文的方法包括:

- 模型架构优化:如FlashAttention等注意力机制改进

- 位置编码创新:如ALiBi、RoPE等位置编码方法

- 分层处理:将长文本分层或分块处理

Glyph相比这些方法的优势:

- 计算效率更高:视觉处理天然并行化

- 硬件需求更低:适合消费级硬件

- 信息保留更完整:视觉表示包含排版等额外信息

与其他压缩技术的比较

其他文本压缩技术包括:

- 摘要生成:提取关键信息生成简短摘要

- 关键句提取:保留文档中的核心句子

- 层次化压缩:不同层次保留不同粒度信息

Glyph的独特之处:

- 无损压缩:保留原始文档的完整信息

- 多模态统一:同时处理文本和视觉元素

- 结构保持:保留文档的原始结构和格式

与多模态模型的比较

现有多模态模型如GPT-4V、Gemini等:

- 原生多模态支持:从设计上就支持多种输入类型

- 统一架构:使用单一模型处理不同模态

Glyph的差异化优势:

- 专业文本处理:针对文本视觉化专门优化

- 计算效率更高:专注于特定任务实现更高效率

- 部署成本更低:可以使用更小的VLM实现

Glyph的未来发展方向

Glyph框架虽然已经展现出强大能力,但仍有多方面的改进空间和潜在发展方向。

技术优化方向

Glyph未来可以在以下方面进行技术优化:

- 渲染算法改进:开发更智能的文本渲染策略

- 模型轻量化:进一步降低计算资源需求

- 多语言支持:扩展支持更多语言和文字系统

- 实时渲染:实现文本到图像的实时转换

应用场景扩展

Glyph可以探索的新应用场景包括:

- 实时会议记录:结合语音识别处理会议内容

- 智能文档管理:构建下一代文档处理系统

- 跨语言信息处理:打破语言障碍的信息传递

- 教育个性化:根据学习者特点定制内容呈现

生态系统建设

Glyph的长期发展需要构建完整生态系统:

- 工具链完善:提供从文本处理到结果解析的全套工具

- 社区建设:吸引开发者和研究人员贡献创新应用

- 标准制定:推动视觉文本处理领域的技术标准

- 产业合作:与各行业伙伴共同探索应用价值

结论:视觉文本压缩技术的深远影响

Glyph框架代表了大语言模型处理长文本问题的一个创新解决方案,通过视觉-文本压缩技术实现了计算效率和信息保留的平衡。其3-4倍的上下文压缩能力、4.8倍的Prefill速度提升以及2/3的显存占用减少,为AI应用开辟了新的可能性。

随着技术的不断发展和应用场景的持续扩展,Glyph有望在多个领域带来革命性的变化。从教育到医疗,从企业应用到创意产业,视觉文本压缩技术都将显著提升信息处理的效率和深度。未来,随着多模态AI技术的进一步发展,类似Glyph的框架可能会成为处理长文本内容的标准方法之一。

Glyph的开源特性也为研究社区提供了宝贵的实验平台,可以预见,将有更多基于这一思路的创新应用涌现,共同推动AI技术在信息处理领域的边界不断拓展。对于开发者和研究人员来说,Glyph不仅是一个工具,更是一个启发思考的起点,探索如何通过跨模态思维解决传统AI领域的挑战。