在人工智能技术飞速发展的今天,提升模型处理能力与效率已成为行业内的核心挑战。月之暗面近日发布的Kimi Linear混合线性注意力架构,正是针对这一挑战提出的革命性解决方案。这一创新技术不仅重新定义了AI模型对信息的处理方式,更为整个行业带来了性能上的飞跃式提升。

技术突破:Kimi Linear的核心创新

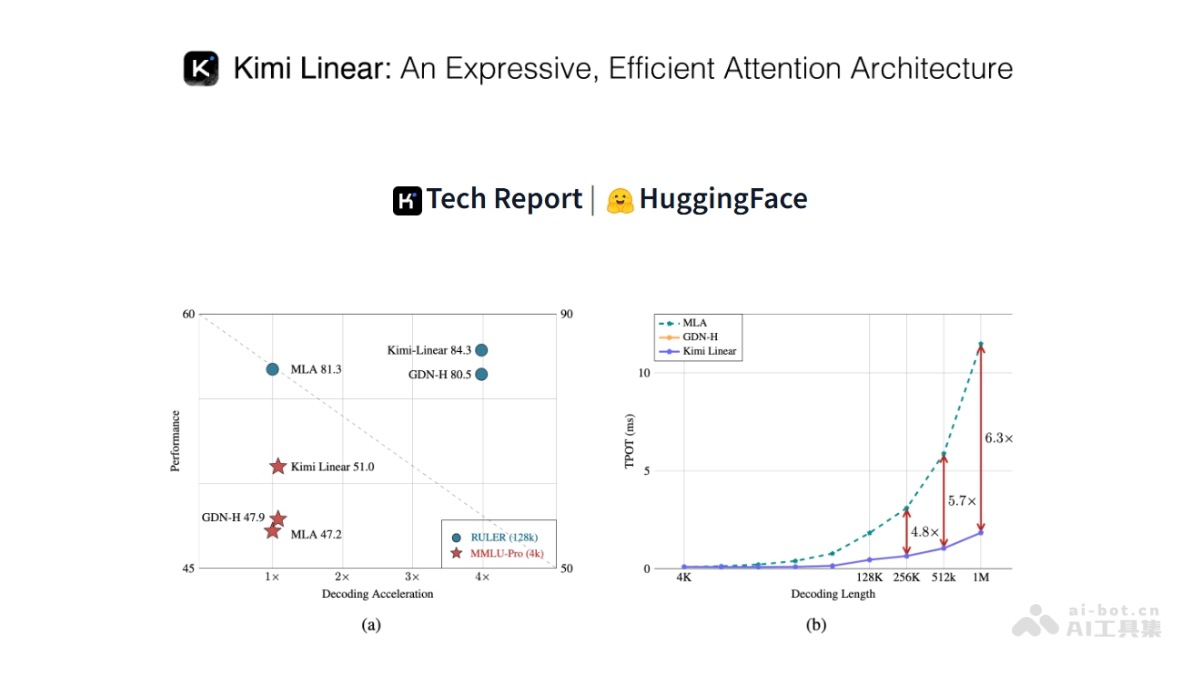

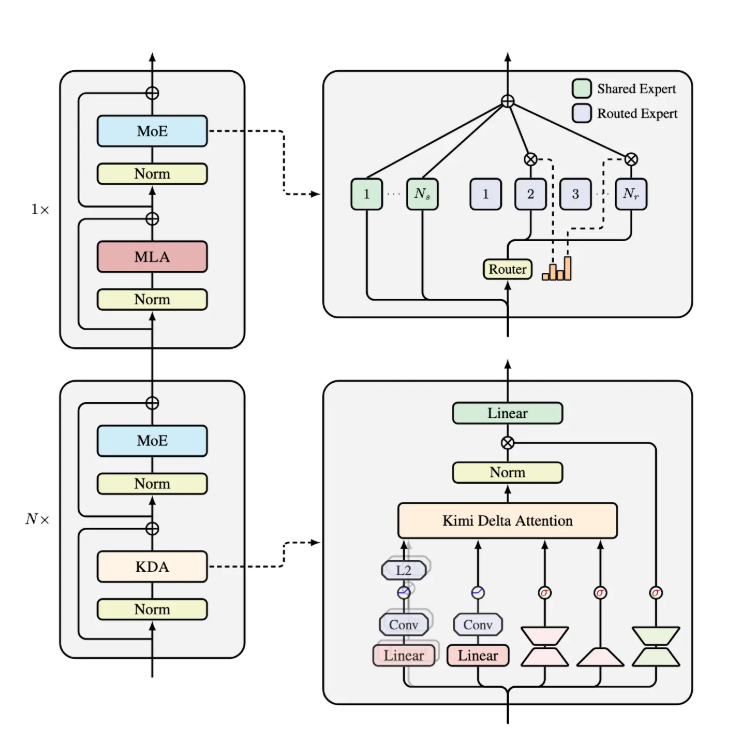

Kimi Linear架构最引人注目的创新在于其独特的"Kimi Delta Attention"(KDA)机制。作为对Gated DeltaNet的优化升级,KDA引入了更高效的门控机制,显著提升了有限状态RNN记忆的使用效率。这一突破性设计使得模型能够在处理信息时更加精准地分配计算资源,从而实现前所未有的性能提升。

架构设计:三份KDA与一份MLA的完美结合

Kimi Linear的架构设计独具匠心,由三份Kimi Delta Attention和一份全局多层感知机(MLA)组成。这种组合方式使得模型能够在不同距离的信息处理中保持高效性,既关注局部细节,又把握全局关系。通过对Gated DeltaNet的改良,KDA能够通过细粒度的门控机制,显著压缩有限状态RNN的记忆使用,实现了计算资源的最优分配。

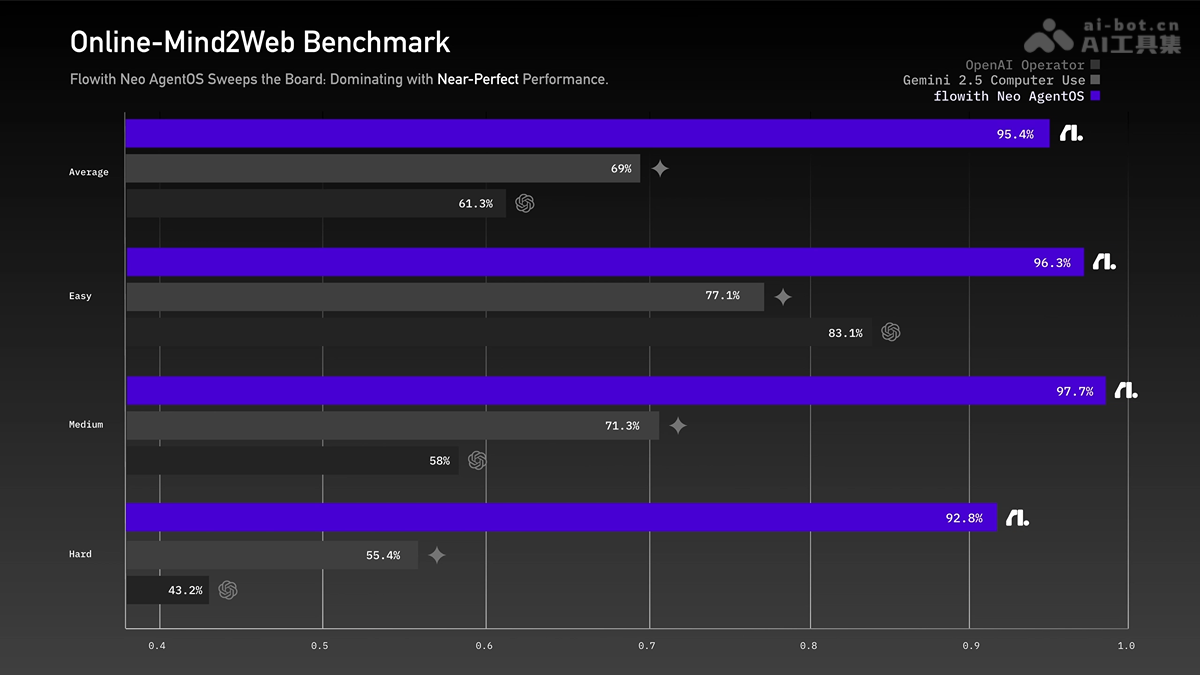

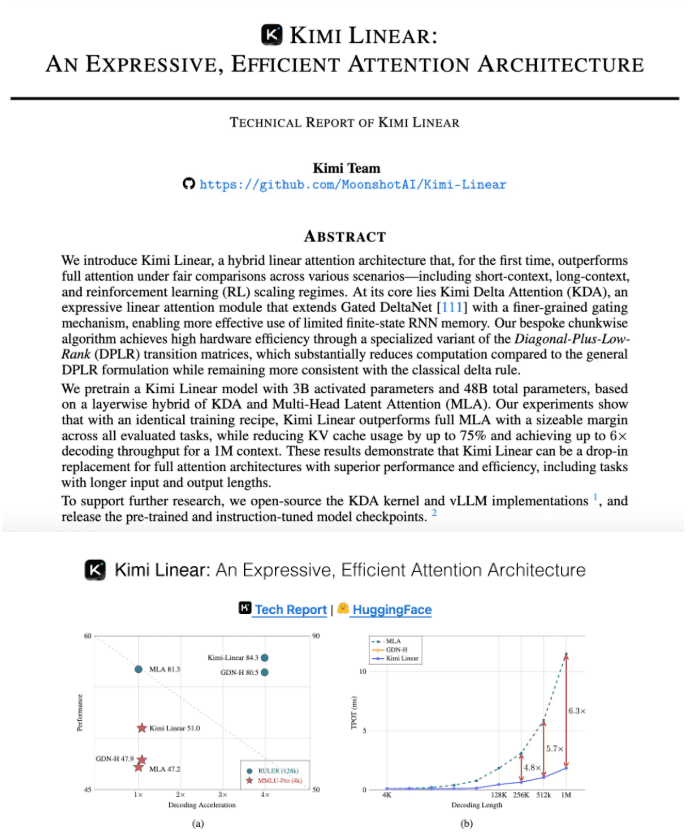

性能提升:数据说话的惊人效果

官方数据显示,Kimi Linear在各项性能指标上均取得了突破性进展。在处理1M token的场景下,Kimi Linear的KV cache占用量减少了75%,这意味着模型在处理大规模数据时能够显著减少内存占用,为资源受限环境下的AI应用提供了可能。

解码速度的革命性提升

在解码吞吐量方面,Kimi Linear实现了最高6倍的提升。这一进步对于实时应用场景尤为重要,如在线翻译、即时对话系统等需要快速响应的AI应用。6倍的解码速度提升意味着用户体验的质的飞跃,也为AI应用开辟了更广阔的应用场景。

训练效率的显著改善

除了推理速度的提升,Kimi Linear在训练速度(TPOT)方面同样表现卓越。相较于传统的多层感知机(MLA),Kimi Linear实现了6.3倍的加速。这一提升不仅意味着模型训练时间的缩短,更降低了AI开发的成本和门槛,加速了AI技术的迭代和创新。

技术原理:细粒度门控机制的奥秘

Kimi Linear的核心优势在于其创新的细粒度门控机制。这一机制允许模型在处理信息时做出更精细的决策,决定哪些信息需要被保留,哪些可以被丢弃。这种智能的信息筛选和处理方式,使得模型能够在保持高性能的同时,大幅减少不必要的计算和内存消耗。

有限状态RNN记忆的高效利用

传统的RNN模型在处理长序列信息时往往面临记忆容量有限的问题。而Kimi Linear通过其创新的门控机制,能够更有效地利用有限的记忆资源,捕捉长距离依赖关系。这一突破对于处理长文本、长视频序列等需要长期记忆能力的AI应用具有重要意义。

全局与局部注意力的平衡

Kimi Linear架构巧妙地平衡了全局注意力与局部注意力的关系。通过三份KDA和一份全局MLA的组合,模型既能够关注局部细节,又能够把握全局上下文。这种平衡使得Kimi Linear在多种场景下都能表现出色,无论是短距离的精细处理,还是长距离的关联分析,都能游刃有余。

应用前景:多场景下的广泛适用性

Kimi Linear架构的多场景适应性使其具有广阔的应用前景。无论是在短距离、长距离处理场景,还是在强化学习(RL)等复杂任务中,Kimi Linear都展现出了优于传统全注意力方法的性能。这一特性使其成为AI领域多场景应用的理想选择。

大规模语言模型的加速器

对于大规模语言模型(LLM)而言,Kimi Linear的KV缓存减少和推理速度提升特性意味着能够以更低的资源消耗处理更大规模的数据。这将直接推动大模型在更多领域的落地应用,从智能客服到内容创作,从代码生成到科学研究,Kimi Linear都有潜力成为这些应用的加速引擎。

资源受限环境下的AI应用

在移动设备、边缘计算等资源受限环境中,AI应用往往面临计算能力和内存容量的双重挑战。Kimi Linear通过减少75%的KV缓存占用,为这些环境下的AI应用提供了新的可能性。未来,我们可能会看到在智能手机、物联网设备上运行更加复杂的AI模型,实现更智能的本地化应用体验。

强化学习的新突破

强化学习是AI领域的重要分支,但在训练过程中往往面临样本效率低、收敛速度慢等问题。Kimi Linear在强化学习场景中的优异表现,有望解决这些长期困扰业界的难题。通过更高效的注意力机制,强化学习模型能够更快地从环境中学习,适应更复杂的任务,为自动驾驶、机器人控制等领域带来新的突破。

行业影响:AI效率竞赛的新标杆

Kimi Linear的发布标志着AI行业在效率提升方面迈出了重要一步。在模型规模不断扩大的今天,如何提升计算效率、降低资源消耗已成为AI发展的关键瓶颈。月之暗面的这一创新,为行业树立了新的技术标杆,也将推动整个行业向更高效、更可持续的方向发展。

计算效率与模型规模的平衡

近年来,AI模型规模呈现爆炸式增长,从GPT-3到GPT-4,参数量从千亿级跃升至万亿级。然而,模型规模的扩大也带来了计算资源的巨大消耗。Kimi Linear通过优化注意力机制,在保持模型性能的同时大幅提升了计算效率,为解决模型规模与计算效率之间的矛盾提供了新思路。

AI产业化的加速器

AI技术的产业化应用需要兼顾性能与成本。Kimi Linear在提升性能的同时降低了资源消耗,这将直接降低AI应用的开发和部署成本,加速AI技术的产业化进程。未来,我们可能会看到更多基于Kimi Linear技术的AI产品和服务进入市场,改变各行各业的运作方式。

开源生态的推动力量

月之暗面已将Kimi Linear的技术报告开源,这一举措将促进AI技术的共享与交流。开源不仅能够加速技术的迭代和完善,还能吸引更多研究者和开发者参与到这一创新生态中,共同推动AI技术的发展。可以预见,Kimi Linear的开源将成为AI领域的一个重要里程碑,激发更多创新和突破。

未来展望:AI注意力机制的演进方向

Kimi Linear的成功证明了注意力机制仍有巨大的优化空间。未来,随着对注意力机制研究的深入,我们可能会看到更多创新性的架构和算法出现。这些创新将进一步推动AI技术的发展,拓展AI的应用边界。

注意力机制的多样化发展

当前,注意力机制主要分为自注意力、交叉注意力等几种类型。未来,随着Kimi Linear等创新架构的出现,注意力机制可能会朝着更加多样化、专业化的方向发展。针对不同任务、不同数据类型的注意力机制将成为研究热点,为AI系统提供更加精准、高效的信息处理能力。

硬件与算法的协同优化

AI性能的提升离不开硬件与算法的协同优化。Kimi Linear的架构设计充分考虑了现代计算硬件的特点,实现了算法与硬件的高效匹配。未来,随着专用AI芯片的发展,算法与硬件的协同优化将更加紧密,推动AI性能实现质的飞跃。

多模态注意力机制的探索

随着AI应用从单一模态向多模态发展,能够处理文本、图像、音频等多种信息类型的注意力机制将成为重要研究方向。Kimi Linear在单模态处理上的成功经验,可以为多模态注意力机制的设计提供有价值的参考,推动AI系统向更加全面、智能的方向发展。

技术细节:深入理解Kimi Linear

对于技术爱好者而言,深入了解Kimi Linear的技术细节有助于把握AI发展的前沿趋势。月之暗面已发布详细的技术报告,通过GitHub页面可以获取完整的技术文档。这些文档不仅包含了Kimi Linear的架构设计和实现细节,还提供了丰富的实验数据和性能对比分析,为研究者和开发者提供了宝贵的技术参考。

KDA机制的技术原理

Kimi Delta Attention(KDA)作为Kimi Linear的核心组件,其技术原理值得深入探讨。KDA通过对Gated DeltaNet的改良,引入了更高效的门控机制,使得模型能够在处理信息时做出更精准的决策。这种门控机制不仅能够有效压缩有限状态RNN的记忆使用,还能提高模型对长距离依赖关系的捕捉能力。

全局MLA的设计考量

全局多层感知机(MLA)在Kimi Linear架构中扮演着重要角色。与传统的注意力机制不同,MLA采用多层感知机的结构,能够更好地捕捉全局上下文信息。这种设计使得Kimi Linear在处理需要全局理解的任务时具有明显优势,如文本摘要、机器翻译等需要把握全文语义的应用场景。

实验设计与性能评估

Kimi Linear的技术报告包含了严谨的实验设计和全面的性能评估。通过在多种数据集和任务上的测试,Kimi Linear展现出了优异的性能和广泛的适用性。这些实验不仅验证了Kimi Linear的有效性,还为后续研究提供了有价值的基准和参考。

总结:AI效率革命的新篇章

Kimi Linear架构的发布标志着AI领域在效率提升方面迈出了重要一步。通过创新的Kimi Delta Attention机制,Kimi Linear实现了KV缓存减少75%,推理速度提升6倍的惊人性能,为AI行业带来了新的解决方案。这一突破不仅将推动AI技术在更多领域的应用,还将促进整个行业向更高效、更可持续的方向发展。

随着月之暗面开源Kimi Linear技术报告,我们有理由相信,这一创新架构将为AI研究者和开发者提供新的思路和工具,激发更多创新和突破。未来,随着对注意力机制研究的深入,我们可能会看到更多类似Kimi Linear的革命性架构出现,不断拓展AI技术的边界,推动人工智能进入新的发展阶段。

在AI技术日新月异的今天,Kimi Linear的出现为我们展示了注意力机制仍有巨大的优化空间。这一创新不仅是对现有技术的突破,更是对未来AI发展方向的指引。随着Kimi Linear等创新架构的成熟和应用,我们有理由期待一个更加智能、高效的AI时代的到来。