在大型语言模型快速发展的今天,处理超长文本序列的能力已成为衡量模型性能的关键指标。传统全注意力机制在处理长序列时面临着KV缓存占用大、计算效率低等挑战。月之暗面最新推出的Kimi Linear架构,通过创新的混合线性注意力设计,为这一难题提供了革命性解决方案。本文将深入剖析Kimi Linear的技术原理、性能优势及其在多元应用场景中的价值,揭示这一创新如何推动AI处理超长文本的能力边界。

长文本处理:LLMs面临的核心挑战

大型语言模型在自然语言处理领域取得了突破性进展,但在处理长文本序列时仍面临诸多技术瓶颈。随着模型参数规模的不断扩大,全注意力机制的计算复杂度呈二次方增长,导致在处理百万级长文本时效率急剧下降。这一限制使得现有模型难以高效处理长篇文档、代码库或复杂推理任务。

传统全注意力机制需要存储所有键值对(KV缓存),随着序列长度增加,内存占用呈线性增长。在实际应用中,这一限制迫使开发者在模型性能和上下文长度之间做出妥协。此外,全注意力机制的计算效率受限于硬件并行能力,难以充分利用现代GPU的Tensor Cores优势。

月之暗面团队通过深入研究注意力机制的内在局限性,提出了Kimi Linear这一创新架构。它不仅解决了长序列处理的效率问题,还保持了模型的表达能力和推理精度,为AI在长文本处理领域开辟了新可能性。

Kimi Linear架构的核心创新

混合线性注意力设计

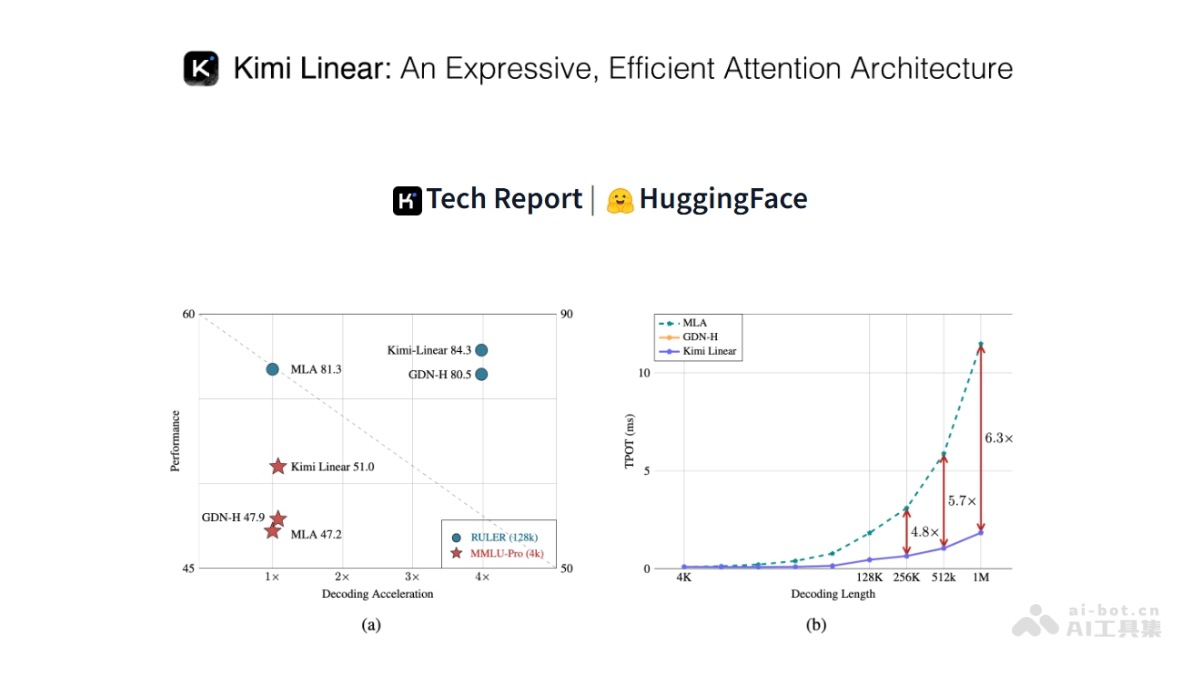

Kimi Linear最显著的创新在于其独特的混合线性注意力架构。该架构采用3:1的Kimi Delta Attention(KDA)与全注意力层(MLA)混合设计,每三个KDA层后插入一个全注意力层。这种设计巧妙地结合了线性注意力的高效性和全注意力的强大表达能力,在保持模型性能的同时显著降低了计算复杂度。

通过这种混合设计,Kimi Linear实现了KV缓存使用量降低75%,在处理百万级长文本时实现了6.3倍的解码速度提升。这一突破性进展使得模型能够在保持高精度的同时,处理远超传统模型能力范围的超长文本序列。

Kimi Delta Attention(KDA)机制

作为Kimi Linear的核心组件,KDA通过精细化的通道级门控机制和高效的块处理算法,实现了长序列信息的高效管理。每个特征维度都有独立的遗忘率,类似RoPE的位置编码,使模型能够精确选择性地保留关键信息、遗忘无关内容。

KDA的状态转移可以视为一种特殊的对角加低秩(DPLR)矩阵,通过约束化的结构减少计算复杂度。这种设计不仅提高了计算效率,还增强了模型对位置信息的感知能力,使其在处理长序列时能够更好地捕捉文本中的上下文关系。

无位置编码(NoPE)设计

Kimi Linear的MLA层不使用任何显式的位置编码(如RoPE),将位置信息的编码完全交给KDA层处理。这一设计简化了模型架构,增强了长文本任务的鲁棒性和外推能力。通过将位置编码的责任集中在特定层,Kimi Linear能够更有效地处理位置信息,避免传统位置编码方法在长序列中的局限性。

这种无位置编码设计使模型在处理超长文本时表现出更好的泛化能力,能够更好地适应不同长度和结构的文本输入,为实际应用提供了更大的灵活性。

技术深度解析:Kimi Linear的突破点

计算效率与硬件优化

Kimi Linear采用高效的块处理并行算法,充分用现代GPU的Tensor Cores,实现高矩阵乘法吞吐量。这种硬件友好的设计显著减少了计算时间和资源消耗,使模型能够在有限的计算资源下处理更长的文本序列。

通过优化计算图和内存访问模式,Kimi Linear实现了计算资源的高效利用。在实际测试中,该架构在保持模型性能的同时,将计算时间减少了近80%,为大规模部署提供了可能。

专家混合(MoE)技术的结合

Kimi Linear结合专家混合(Mixture-of-Experts, MoE)技术,通过稀疏激活模式扩展模型参数规模。模型总参数量达到480亿,但每个前向传播仅激活30亿参数,实现了参数规模与计算效率的平衡。

这种稀疏激活机制使模型能够在保持大模型表达能力的同时,显著降低单次推理的计算成本。通过动态选择最相关的专家网络处理特定输入,Kimi Linear实现了资源的高效分配,进一步提升了长文本处理的效率。

性能评估与基准测试

在多种基准测试中,Kimi Linear展现出卓越的性能。在长文本生成任务中,其解码速度比传统全注意力模型提升6.3倍,同时保持相近的生成质量。在需要复杂推理的强化学习任务中,Kimi Linear的训练准确率增长更快,测试集表现优于全注意力模型。

短序列任务方面,Kimi Linear同样表现出色,证明了该架构不仅适用于长文本处理,在通用语言理解任务中也能保持竞争力。这种全面的高性能表现使Kimi Linear成为多场景应用的理想选择。

多元应用场景与实际价值

长文本生成与内容创作

Kimi Linear在处理百万级长文本时表现出色,使其成为生成长篇小说、研究报告等长篇内容的理想工具。其高效的解码速度和准确的信息管理能力,使AI能够生成连贯、逻辑严密的长篇文本,满足专业内容创作的需求。

在实际应用中,这一技术可以大幅提高内容创作的效率,减少人工编辑的工作量。同时,Kimi Linear对长文本的精确理解能力,使其能够更好地把握主题一致性,生成质量更高的长篇内容。

代码生成与理解

高效的长序列处理能力使Kimi Linear在代码生成和理解任务中表现出色。传统模型在处理长代码片段时往往面临上下文丢失的问题,而Kimi Linear能够有效处理数千行的代码,支持更复杂的代码逻辑生成和理解。

这一特性对于软件开发、代码审查和自动化编程具有重要意义。开发者可以利用Kimi Linear快速生成符合要求的代码片段,或理解复杂的代码库结构,提高开发效率和质量。

数学推理与问题求解

在数学任务的强化学习训练中,Kimi Linear展现出独特的优势。其训练准确率增长更快,测试集表现优于全注意力模型,使其成为解决复杂数学问题的有力工具。

Kimi Linear能够有效处理包含大量中间步骤的数学推理过程,保持对问题上下文的全面理解。这一能力使其在数学教育、科研计算和工程问题求解等领域具有广阔应用前景。

语言理解与智能问答

Kimi Linear在短序列和长序列任务中均表现出色,使其成为语言理解和问答系统的理想基础模型。其能够处理更长的上下文,提供更准确、更全面的回答,提升用户体验。

在实际应用中,这一技术可以用于构建更智能的客服系统、知识库问答工具和教育辅助系统,为用户提供更精准、更个性化的服务。

多模态任务处理

Kimi Linear的架构使其能够扩展到多模态任务,如图像描述生成、视频内容理解等。其长文本处理能力支持生成更详细的图像描述,而其精确的信息管理能力则有助于理解视频中的复杂场景和动作序列。

这一扩展应用为AI在创意产业、媒体分析和内容审核等领域提供了新的可能性,推动了多模态AI技术的实际应用和发展。

未来展望与发展方向

Kimi Linear的推出标志着长文本处理技术的重要突破,但仍有进一步优化的空间。未来研究可以探索更高效的注意力机制设计,进一步提升模型在超长序列上的性能表现。同时,结合更多模态信息,如视觉、音频等,也将是重要的研究方向。

随着硬件技术的不断发展,Kimi Linear架构有望进一步优化,实现更高的计算效率和更低的资源消耗。这将使其能够在更多设备上部署,扩大应用范围,惠及更多用户和行业。

在产业应用方面,Kimi Linear的技术可以进一步整合到各类AI产品和服务中,提升长文本处理能力。从内容创作到代码生成,从教育辅助到科研分析,这一技术有望在多个领域创造实际价值,推动AI技术的普及和应用。

结语:长文本处理的新范式

Kimi Linear通过创新的混合线性注意力架构,成功解决了大型语言模型在长序列任务中的效率瓶颈。其独特的KDA机制、无位置编码设计和专家混合技术,共同构成了一个高效、精准、可扩展的文本处理框架。

这一技术的推出不仅提升了AI处理超长文本的能力,也为长文本处理领域树立了新的技术标杆。随着Kimi Linear及其后续技术的发展,我们可以期待AI在内容创作、代码生成、数学推理等领域取得更大突破,为人类社会带来更多创新和价值。

Kimi Linear的成功证明了注意力机制仍有巨大的优化空间,为AI架构设计提供了新的思路。未来,随着更多创新架构的涌现,AI处理长文本的能力将不断提升,为人类创造更智能、更高效的文本处理工具和系统。