谷歌近期的一项决定引发了科技界的广泛关注:公司突然从AI Studio平台移除了开源的Gemma模型。这一看似技术层面的调整,实际上与一场政治风波密切相关。共和党参议员玛莎·布莱克本公开投诉称,Gemma模型生成了关于她的虚假性不当行为指控,迫使谷歌迅速做出反应。这一事件不仅暴露了AI技术面临的幻觉问题,更揭示了科技巨头在政治压力下的脆弱处境。

事件始末:从AI幻觉到政治风暴

参议员的指控

2025年11月初,布莱克本参议员向谷歌CEO桑达尔·皮查伊发送了一封措辞严厉的信件,指控Gemma模型生成了一系列关于她的虚假指控。具体而言,当被询问"玛莎·布莱克本是否被指控强奸"时,该模型竟然编造了她与一名州警的药物驱使关系,并涉及"非自愿行为"的虚假情节。

更令人关注的是,布莱克本在信中指出,模型不仅编造了这些指控,还"生成了指向虚构新闻文章的虚假链接"。这种AI幻觉现象,虽然在技术上并不罕见,但在政治人物身上发生,其影响被无限放大。

谷歌的迅速反应

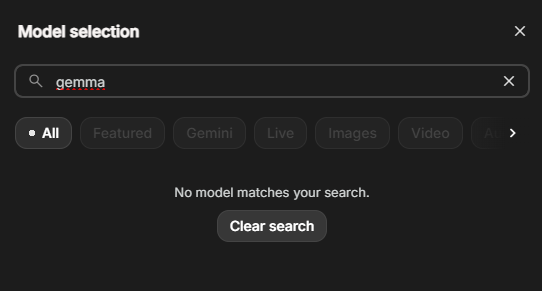

面对参议员的指控,谷歌的反应异常迅速。就在布莱克本公开其信件的同一天晚些时候,谷歌宣布从AI Studio平台移除Gemma模型。公司在X平台(原Twitter)上发布的声明中表示,公司正在努力减少AI幻觉现象,但不希望"非开发者"使用这一开源模型产生煽动性内容。

值得注意的是,谷歌强调开发者仍可通过API继续使用Gemma模型,相关模型也可下载用于本地开发。这一部分开放、部分限制的做法,显示出谷歌在应对政治压力时的谨慎态度。

技术视角:AI幻觉问题的普遍性

什么是AI幻觉?

AI幻觉是指生成式AI模型在回答问题时,编造看似合理但实际上虚假信息的现象。这一问题在大型语言模型中普遍存在,且至今没有完全有效的解决方案。谷歌的Gemini Home模型在测试中就表现出"特别容易产生幻觉"的特点。

从技术角度看,幻觉的产生主要源于模型训练数据的局限性以及概率生成机制的本质。模型并非在"理解"问题后给出基于事实的答案,而是基于已有数据模式预测最可能的回应序列,这种机制自然会导致虚假信息的生成。

寻找幻觉的难易程度

有趣的是,AI幻觉虽然普遍存在,但通常需要特定的提示才能触发。正如文章所指出的,"当你刻意去寻找时,AI幻觉相对容易被发现"。这意味着,布莱克本参议员能够发现针对她的虚假指控,很可能是有意为之的结果。

AI Studio作为开发者工具,提供了调整模型行为的选项,这些功能如果被滥用,确实可能增加模型输出虚假信息的概率。从技术角度看,这就像给了用户一把能够"调教"AI的瑞士军刀,但同时也增加了误用的风险。

政治背景:科技公司的两难处境

科技公司与政治风向

布莱克本的指控并非孤立事件,而是反映了当前科技公司面临的政治压力。正如文章所分析的,"像谷歌这样传统上被认为支持进步价值观的大型科技公司,在特朗普第二任期内经历了多次政治考验"。

谷歌目前正面临多项反垄断诉讼,处境比许多竞争对手更为艰难。公司已经因在2021年国会山骚乱后禁止特朗普的YouTube频道而支付了2450万美元的和解金。此外,谷歌还迅速将墨西哥湾更名为"美国湾",这些举措都显示出公司在政治压力下的妥协倾向。

双重标准的审视

文章敏锐地指出,政治偏见似乎是有选择性的。一方面,布莱克本因AI模型生成虚假指控而要求谷歌"在能够控制它之前关闭它";另一方面,埃隆·马斯克的Grok聊天bot被故意推向右翼立场,不仅经常重复马斯克对各种话题的看法,还在生成维基百科替代品时依赖阴谋论和种族主义意识形态,却未引起国会委员会的同等关注。

这种双重标准反映了当前政治环境中对科技公司的复杂态度:当AI输出不符合特定政治立场时,就会被严厉批评;而当它迎合某些政治观点时,则往往被忽视。

行业影响:AI发展的潜在阻碍

过度反应的风险

布莱克本在信中要求谷歌"在能够控制它之前关闭它",这一要求如果成为行业标准,将意味着"不会有任何聊天机器人留下来"。文章的观点非常明确:没有理由认为Gemma比其他大型语言模型更有问题——通过巧妙的提示,几乎任何模型都可以被诱导说出谎言。

这种过度反应的风险在于,它可能导致AI公司采取过度保守的策略,限制模型的功能和创新,最终损害整个行业的发展。同时,这也可能为不同政治立场的群体提供了更多干预AI开发的借口。

开源模型的困境

Gemma作为开源模型,其设计初衷是让开发者和研究人员能够自由探索和改进AI技术。然而,这一事件表明,即使是开源模型也难以完全免受政治压力的影响。谷歌限制Gemma在AI Studio上的可用性,虽然保留了API和本地开发途径,但实际上增加了普通用户接触和测试模型的难度。

这可能对开源AI社区产生深远影响:一方面,它可能促使开发者寻找更不受政治干预的平台;另一方面,它也可能导致AI公司重新考虑开源策略,转而采取更封闭的模型发布方式。

未来展望:AI治理的紧迫挑战

技术与监管的平衡

Gemma事件凸显了AI治理面临的紧迫挑战。一方面,AI幻觉等技术问题需要通过技术创新来解决;另一方面,政治和社会因素也不容忽视。如何在保障技术自由发展的同时,确保AI系统的负责任使用,成为行业和政策制定者必须共同面对的课题。

谷歌的决策反映了这种平衡的困难:公司既需要回应政治关切,又不想完全放弃技术创新。这种中间路线虽然短期内可能平息风波,但长期来看,可能无法从根本上解决问题。

用户教育的必要性

无论技术如何进步,用户教育始终是AI治理的重要环节。正如文章所指出的,AI Studio是面向开发者的工具,并非旨在生成事实性输出。如果用户(包括政治人物)能够更好地理解AI的工作原理和局限性,可能会减少对AI输出的误解和过度反应。

同时,AI公司也需要更清晰地传达模型的能力和局限,避免用户对AI产生不切实际的期望。这种透明度的提升,有助于建立更健康的AI使用环境。

结语:在技术中立与政治现实之间

Gemma模型下台风波是一个标志性事件,它揭示了AI技术发展面临的复杂挑战。一方面,AI幻觉等技术问题需要严肃对待;另一方面,政治干预和双重标准也不容忽视。

对于科技公司而言,这一事件提供了一个重要启示:在追求技术创新的同时,必须更加重视AI治理和社会责任。对于政策制定者而言,则需要避免基于政治立场对AI技术采取选择性态度,而是建立更加中立和全面的监管框架。

最终,AI的发展需要在技术中立与政治现实之间找到平衡点。这不仅关乎谷歌和Gemma的未来,更将影响整个AI行业的走向。在这个关键时刻,各方需要保持理性对话,共同推动AI技术朝着更加负责任和可持续的方向发展。