在人工智能领域,大型语言模型(LLM)的开源无疑为技术的进步和创新注入了强大的动力。近日,小红书宣布开源其首个大规模模型dots.llm1,这一举措不仅展示了小红书在人工智能领域的实力,也为中文自然语言处理的研究和应用带来了新的机遇。dots.llm1以其独特的混合专家模型(MoE)架构和卓越的中文性能,在众多开源大模型中脱颖而出。

dots.llm1模型拥有1420亿个参数,但其精妙之处在于,在实际推理过程中,仅激活其中的140亿参数。这种设计不仅保证了模型的高性能,还显著降低了训练和推理的成本。与传统的稠密模型相比,混合专家模型能够更有效地利用计算资源,实现更高的效率和更低的能耗。这一创新性的架构为大模型的轻量化和普及提供了新的思路。

dots.llm1的另一个显著特点是其训练数据的高质量和大规模。该模型使用了11.2万亿个非合成的高质量训练数据,这在当前的开源大模型中是极为罕见的。高质量的数据是训练出高性能模型的关键。小红书在数据方面的强大实力为dots.llm1的卓越性能奠定了坚实的基础。在中文测试中,dots.llm1的表现尤为出色,平均得分达到91.3,超越了多个竞争对手,如DeepSeek的V2、V3和阿里巴巴的Qwen2.5系列。这一成绩充分证明了dots.llm1在中文语言理解和生成方面的强大能力。

dots.llm1的技术架构也颇具亮点。该模型采用了单向解码器Transformer结构,并将传统的前馈网络替换为MoE。Transformer结构是当前自然语言处理领域最流行的模型架构之一,其强大的并行计算能力和长程依赖建模能力为大模型的训练提供了可能。而MoE的引入则进一步提升了模型的效率和性能。与传统模型不同,MoE将多个专家网络分开,每个专家网络专注于输入数据的不同特征,从而在推理时只激活一小部分网络进行计算,大幅度节省了算力需求。

具体来说,dots.llm1包含128个路由专家和2个共享专家。每个专家都是一个具有两层前馈结构的网络,使用SwiGLU激活函数以捕捉数据中的复杂关系。SwiGLU激活函数是一种新型的激活函数,相比于传统的ReLU激活函数,它能够更好地捕捉数据中的非线性关系,从而提升模型的性能。在处理输入标记时,模型会动态选择出6个最相关的专家和2个共享专家进行运算。这种动态选择机制使得模型能够根据不同的输入数据自适应地调整其计算方式,从而实现更高的效率和更强的泛化能力。

为了进一步提升模型的性能,dots.llm1在训练过程中还引入了改进的RMSNorm归一化操作,以稳定模型性能和输出。RMSNorm是一种常用的归一化技术,它可以有效地缓解梯度消失和梯度爆炸问题,从而加速模型的训练过程并提升模型的性能。此外,在MoE模块中,负载平衡策略的引入确保了所有专家网络的使用均衡,从而避免了过度依赖某些专家的问题。负载平衡策略可以有效地避免某些专家网络过载而其他专家网络闲置的情况,从而提升模型的整体性能。

在优化算法方面,dots.llm1使用了AdamW优化器。AdamW是一种常用的优化算法,它在Adam算法的基础上引入了权重衰减,从而可以有效地防止模型过拟合并控制梯度爆炸。AdamW优化器的使用进一步提升了模型的训练效率和性能。

数据处理是训练大模型的关键环节。dots.llm1经过了严格的三级数据处理流水线,确保了训练数据的高质量。这三级数据处理流水线包括数据清洗、数据过滤和数据增强。数据清洗用于去除数据中的噪声和错误,数据过滤用于筛选出高质量的数据,数据增强用于扩充数据量并提升数据的多样性。经过一系列的过滤和处理,最终形成了11.2万亿个高质量token的训练数据。此外,小红书还开源了每1万亿token的中间训练检查点,促进学术研究的进一步发展。这些中间训练检查点可以帮助研究人员更好地理解模型的训练过程,并为后续的研究提供参考。

小红书开源dots.llm1的举动,无疑将为中文自然语言处理领域带来深远的影响。通过开放源代码和数据,小红书希望能够与学术界和工业界的研究人员共同推动大模型技术的发展,并为中文自然语言处理的应用创新注入新的活力。dots.llm1的开源,不仅是小红书自身技术实力的展示,更是对整个社区的贡献。相信在dots.llm1的推动下,中文自然语言处理领域将迎来更加美好的未来。

总的来说,小红书开源的dots.llm1大模型,凭借其独特的混合专家模型架构、高质量的训练数据和卓越的中文性能,为中文自然语言处理领域带来了新的突破。它的开源不仅加速了大模型技术的发展,也为研究者和开发者提供了宝贵的资源和参考。未来,我们期待看到更多基于dots.llm1的创新应用,为人们的生活带来更多便利。

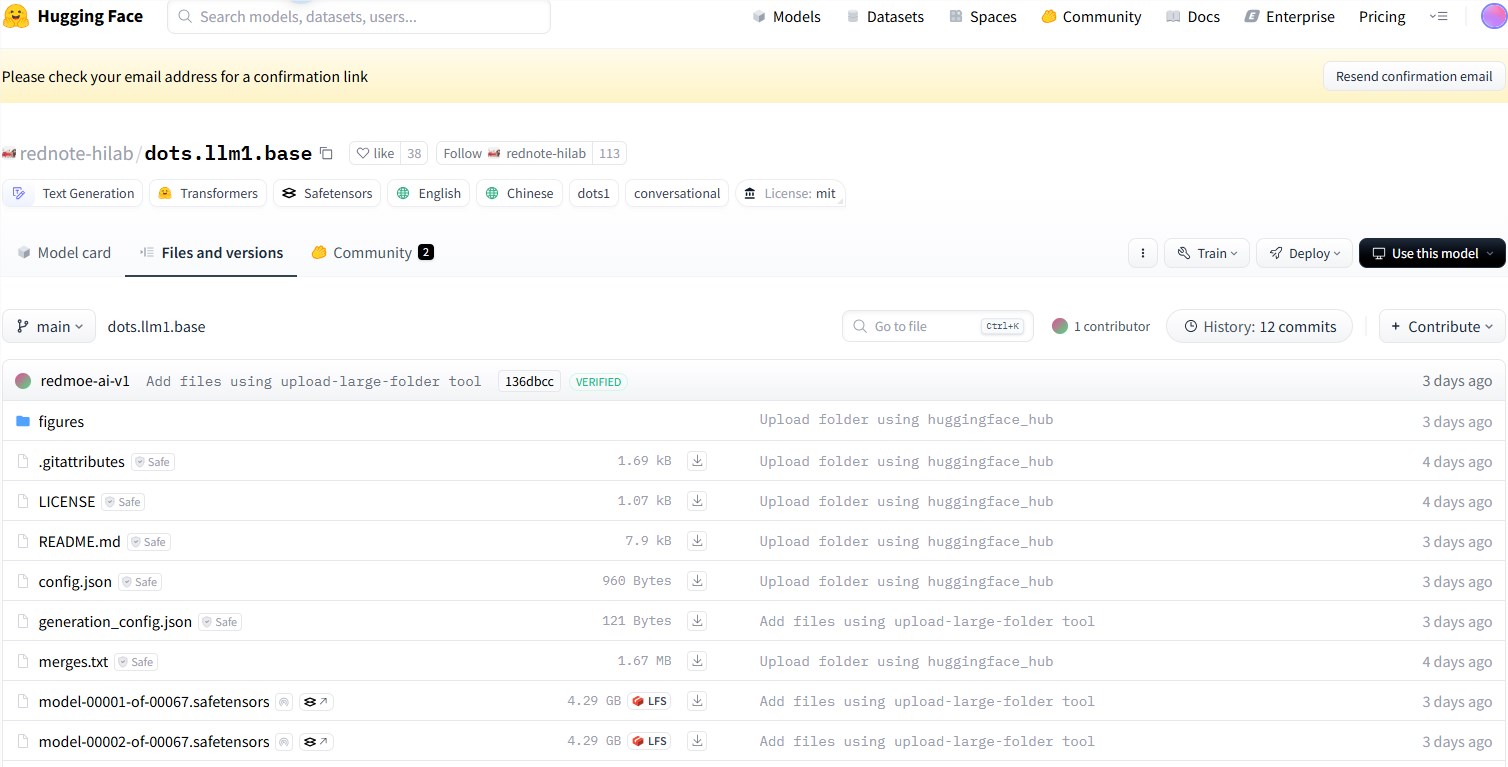

开源地址:https://huggingface.co/rednote-hilab/dots.llm1.base/tree/main