在人工智能视频生成领域,字节跳动开源的 ContentV 模型框架无疑是一项引人注目的创新。ContentV 以其 80 亿参数的规模,为文生视频技术带来了新的可能性。它不仅能够根据文本描述生成视频,还在视频风格迁移、内容续写和编辑等方面展现出强大的功能。本文将深入探讨 ContentV 的技术原理、功能特性以及潜在的应用场景,带你全面了解这一前沿的 AI 模型。

ContentV:技术架构与核心特性

ContentV 的核心在于其独特的架构设计。它并没有完全从零开始构建视频生成模型,而是巧妙地利用了现有的图像生成模型 Stable Diffusion 3.5 Large。通过将 Stable Diffusion 3.5 Large 的 2D-VAE 替换为 3D-VAE,并引入 3D 位置编码,ContentV 使得图像模型能够快速获得视频生成的能力。这种做法不仅降低了开发成本,还充分利用了现有图像生成技术的优势。

在训练策略上,ContentV 采用了多阶段训练方法。首先,利用大量的视频数据建立时间表示,使模型能够理解视频中的时间关系。然后,进行图片和视频的联合训练,进一步提升模型的生成能力。为了优化内存使用,ContentV 还采用了按视频时长和宽高比分桶,并使用动态批量大小机制。此外,ContentV 还采用了渐进式训练方法,先增加视频时长,再提高分辨率,从而使模型能够更好地学习视频中的时间动态和空间细节。

为了提高生成效率,ContentV 使用了 Flow Matching 算法。这种算法通过连续时间内的直接概率路径实现高效采样,使得模型能够更快地生成高质量的视频。在强化学习方面,ContentV 采用了成本效益高的框架,无需额外的人工标注,通过监督微调和强化学习人类反馈,进一步提升生成质量。

ContentV 的高效训练还得益于其强大的硬件支持。它利用 64GB 内存的 NPU 构建分布式训练框架,实现了 480P、24FPS、5 秒视频的高效训练。在 VBench 评测中,ContentV 的长视频总得分达到 85.14,仅次于 Wan2.1-14B。在人类偏好评分方面,ContentV 在多个维度上优于 CogVideoX 和混元视频,展现出卓越的性能。

ContentV 的主要功能

ContentV 提供了丰富的功能,满足了用户在视频生成方面的各种需求:

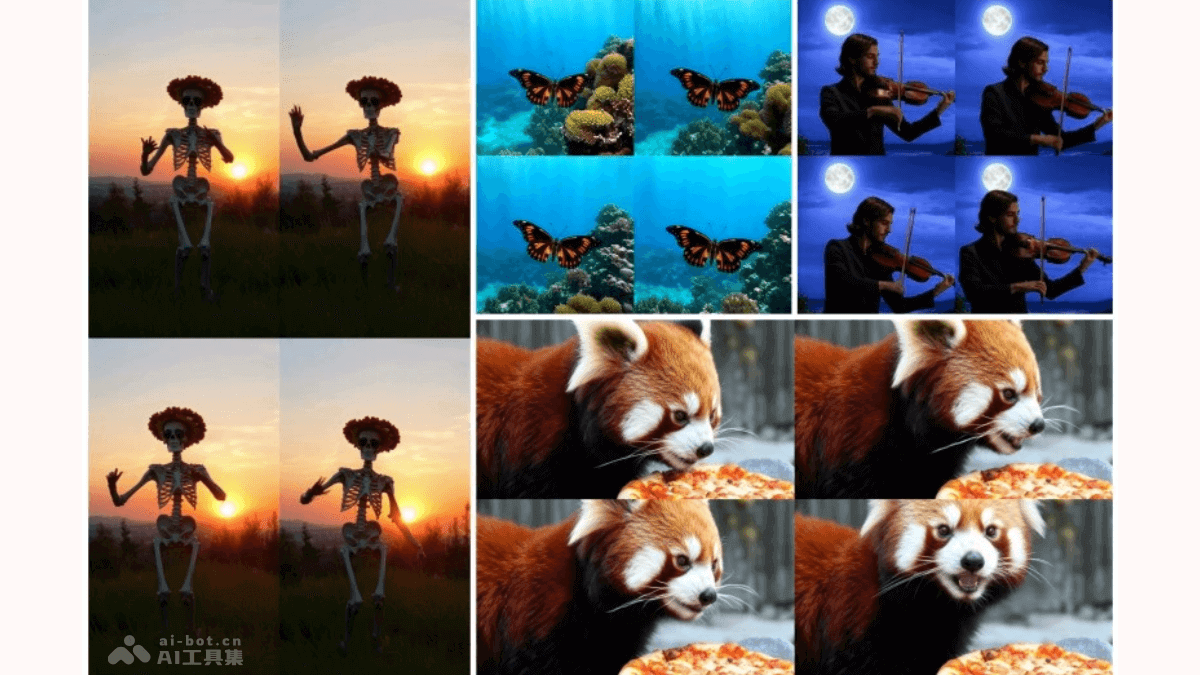

文本到视频生成:这是 ContentV 的核心功能。用户只需输入一段文本描述,ContentV 就能根据文本内容生成相应的视频。例如,输入“一只小猫在草地上玩耍”,ContentV 就能生成一段小猫在草地上嬉戏的视频。

自定义视频参数:用户可以根据自己的需求,指定视频的分辨率、时长、帧率等参数。例如,可以生成高清的 1080p 视频,或者制作适合社交媒体的 15 秒短视频。这种自定义功能使得用户能够更好地控制视频的生成过程。

风格迁移:ContentV 支持将某种特定的风格应用到生成的视频中。例如,可以将油画风格、动漫风格或复古风格等应用到视频内容上,使生成的视频具有独特的艺术效果。这一功能为视频创作带来了更多的可能性。

风格融合:用户可以将多种风格融合在一起,创造出独特的视觉效果。例如,可以将科幻风格与赛博朋克风格结合,生成具有未来感的视频内容。这种风格融合功能为用户提供了更大的创作空间。

视频续写:用户可以提供一段视频作为输入,ContentV 能够根据输入视频的内容和风格,续写出后续的视频情节,实现视频内容的扩展。这一功能在视频创作中非常实用,可以帮助用户快速生成连续的视频内容。

视频修改:用户可以对生成的视频进行修改,例如改变视频中的场景、人物动作等,以满足不同的创作需求。这种视频修改功能为用户提供了更大的灵活性,使得用户能够更好地控制视频的最终效果。

视频到文本描述:ContentV 可以对生成的视频进行文本描述,帮助用户更好地理解视频内容,实现视频与文本之间的双向交互。这一功能在视频分析和理解方面具有重要的应用价值。

ContentV 的技术原理详解

ContentV 的技术原理可以概括为以下几个方面:

极简架构:ContentV 采用极简架构,最大化地复用预训练的图像生成模型进行视频生成。其核心改动是将 Stable Diffusion 3.5 Large 中的 2D-VAE 替换为 3D-VAE,并引入 3D 位置编码。这种架构设计使得 ContentV 能够快速获得视频生成能力,并降低开发成本。

流匹配(Flow Matching):ContentV 使用流匹配算法进行训练,通过连续时间内的直接概率路径实现高效采样。模型经过训练以预测速度,该速度引导噪声样本向数据样本转变,通过最小化预测速度与真实速度之间的均方误差来优化模型参数。这种算法提高了生成效率,使得 ContentV 能够更快地生成高质量的视频。

渐进式训练:ContentV 采用渐进式训练策略,先从低分辨率、短时长的视频开始训练,逐步增加时长和分辨率。这种训练策略有助于模型更好地学习时间动态和空间细节,从而提高视频生成的质量。

多阶段训练:训练过程分为多个阶段,包括预训练、监督微调(SFT)和强化学习人类反馈(RLHF)。预训练阶段在大规模数据上进行,学习基本的图像和视频生成能力;SFT 阶段在高质量数据子集上进行,提高模型的指令遵循能力;RLHF 阶段则通过人类反馈进一步优化生成质量。这种多阶段训练方法能够充分利用不同类型的数据,从而提高模型的整体性能。

人类反馈强化学习:ContentV 采用成本效益高的强化学习与人类反馈框架,在无需额外人工标注的情况下提升生成质量。通过优化模型以最大化奖励模型的分数,正则化与参考模型的 KL 散度,模型能生成更符合人类期望的视频。这种方法能够有效地提高视频生成的质量和用户满意度。

高效分布式训练:ContentV 利用 64GB 内存的 NPU 构建分布式训练框架,通过解耦特征提取和模型训练、整合异步数据管线和 3D 并行策略,实现了高效的 480P 分辨率、24FPS、5 秒视频训练。这种高效的分布式训练框架为 ContentV 的快速发展提供了有力的支持。

ContentV 的项目地址

ContentV 作为一个开源项目,其代码、模型和文档都可以在以下地址找到:

- 项目官网:https://contentv.github.io/

- Github 仓库:https://github.com/bytedance/ContentV

- HuggingFace 模型库:https://huggingface.co/ByteDance/ContentV-8B

- arXiv 技术论文:http://export.arxiv.org/pdf/2506.05343

ContentV 的应用场景展望

ContentV 的强大功能使其在多个领域具有广泛的应用前景:

视频内容创作:教师可以通过输入简单的文本描述,生成与课程内容相关的动画或实拍视频,增强教学的趣味性和互动性。例如,可以生成一段关于细胞分裂的动画视频,或者一段关于历史事件的实拍视频。

游戏开发:在游戏开发中,ContentV 可以生成游戏中的动画片段或过场视频,帮助开发者快速创建丰富的游戏内容。例如,可以生成一段角色升级的动画,或者一段游戏剧情的过场视频。

虚拟现实(VR)和增强现实(AR):ContentV 生成的视频可以用于 VR 和 AR 应用中,为用户提供沉浸式的体验。例如,可以生成一段虚拟旅游的视频,或者一段 AR 游戏的场景。

特效制作:在影视制作中,ContentV 可以生成复杂的特效场景,如科幻场景、奇幻元素等,帮助特效团队快速实现创意。例如,可以生成一段宇宙飞船飞行的场景,或者一段魔法施法的特效。

总而言之,字节跳动开源的 ContentV 模型框架,以其独特的技术架构、丰富的功能和广泛的应用前景,为文生视频领域带来了新的活力。随着技术的不断发展,我们有理由相信,ContentV 将在未来的视频创作中发挥越来越重要的作用。