在人工智能领域,大型语言模型(LLM)正以惊人的速度发展。字节跳动最新推出的豆包大模型1.6(Doubao-Seed-1.6)无疑是这一领域的又一里程碑。作为一款多模态深度思考模型,豆包1.6不仅支持多种输入形式,如文字、图片和视频,还能输出高质量的文字内容,为各行各业带来了前所未有的AI生产力。

豆包大模型1.6:核心功能解析

豆包大模型1.6最引人注目的特点之一是其强大的推理能力。相比之前的版本,豆包1.6在推理速度、准确性和稳定性方面都得到了显著提升,能够更好地支撑复杂的业务场景。这意味着,无论是在金融领域的风险评估,还是在医疗领域的辅助诊断,豆包1.6都能提供更可靠、更高效的解决方案。

边想边搜与DeepResearch

豆包1.6还具备独特的“边想边搜”功能。当模型遇到信息缺失的情况时,它能够主动进行搜索,并通过多轮思考和搜索,为用户提供更全面的推荐。这一功能极大地提高了模型的实用性,使其能够更好地适应现实世界中复杂多变的情况。此外,DeepResearch功能支持快速生成调研报告,帮助用户节省大量时间和精力。

多模态理解能力

作为一款多模态模型,豆包1.6全系列原生支持多模态思考能力,能够理解和处理文本、图像、视频等多种模态的数据。这意味着,用户可以通过上传一张图片,让模型生成相关的文字描述;或者通过输入一段视频,让模型分析其中的关键信息。这种多模态理解能力为内容创作、智能交互等领域带来了全新的可能性。

图形界面操作能力(GUI操作)

豆包1.6还具备强大的图形界面操作能力。通过视觉深度思考和精准定位,模型能够与浏览器及其他软件进行交互和操作,高效执行各类任务。例如,用户可以通过简单的指令,让模型自动完成网页浏览、数据录入等操作,极大地提高了工作效率。

豆包大模型1.6:三大模型版本

为了满足不同用户的需求,豆包大模型1.6提供了三个不同的模型版本:doubao-seed-1.6、doubao-seed-1.6-thinking和doubao-seed-1.6-flash。

doubao-seed-1.6:全能综合型模型

doubao-seed-1.6是一款全能型的综合模型,也是国内首个支持256K上下文的思考模型。它具备深度思考、多模态理解及图形界面操作等多项能力。用户可以根据需求灵活选择开启或关闭深度思考功能,也可以选择自适应思考模式。自适应模式能够根据提示词的难度自动判断是否开启深度思考,在提升效果的同时,大幅减少tokens的消耗。

doubao-seed-1.6-thinking:深度思考强化版

doubao-seed-1.6-thinking是豆包大模型1.6系列中专注于深度思考的强化版本。该模型在代码编写、数学计算、逻辑推理等基础能力上进行了进一步提升,能够处理更复杂的任务。同时,它也支持256K的上下文,能够理解和生成更长的文本内容,适合需要深度分析和复杂推理的场景。

doubao-seed-1.6-flash:极速响应版本

doubao-seed-1.6-flash是豆包大模型1.6系列中的极速版本,具备深度思考和多模态理解能力,支持256K上下文。该模型的延迟极低,TOPT(Top-of-Pipeline Time)仅需10ms,能够快速响应用户的请求。模型的视觉理解能力与友商旗舰模型相当,适合对响应速度要求极高的场景,例如实时交互和视觉任务处理。

豆包大模型1.6:卓越的性能表现

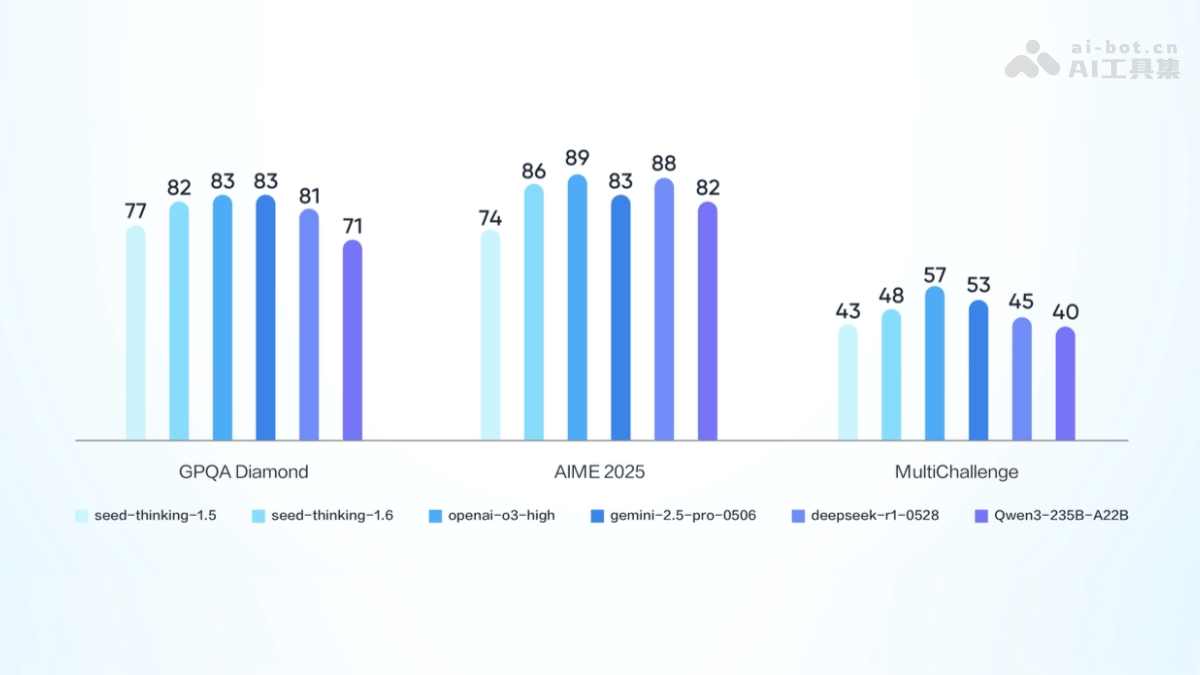

豆包大模型1.6在多个权威测评中表现出色,展现了其强大的实力。

GPQA Diamond测试

在GPQA Diamond测试中,豆包1.6-thinking模型取得了81.5分的成绩,达到全球第一梯队水平,是目前最好的推理模型之一。这一成绩充分证明了豆包1.6在复杂推理任务上的卓越能力。

数学测评AIME25

在数学测评AIME25中,豆包1.6-thinking模型的成绩达到86.3分,相比豆包1.5深度思考模型提升12.3分。这一提升表明,豆包1.6在数学计算和问题解决能力方面有了显著的进步。

豆包大模型1.6:灵活的定价模式

豆包大模型1.6采用了统一的定价模式,无论是否开启深度思考模式,无论是文本还是视觉输入,tokens价格均一致。这种定价模式更加透明和易于理解,方便用户根据自身需求进行选择。

以下是豆包大模型1.6的具体定价:

- 输入长度0-32K:

- 输入价格:0.8元/百万tokens。

- 输出价格:8元/百万tokens。

- 输入长度32K-128K:

- 输入价格:1.2元/百万tokens。

- 输出价格:16元/百万tokens。

- 输入长度128K-256K:

- 输入价格:2.4元/百万tokens。

- 输出价格:24元/百万tokens。

- 输入32K、输出200 tokens以内:

- 输入价格:0.8元/百万tokens。

- 输出价格:2元/百万tokens。

如何使用豆包大模型1.6

使用豆包大模型1.6需要经过以下步骤:

- 注册并登录火山引擎平台:访问火山引擎官方网站,按提示完成注册和登录。

- 开通豆包大模型服务:进入服务页面,找到豆包大模型1.6的服务页面。

- 开通服务:根据页面提示,开通豆包大模型1.6服务。

- 选择版本:根据需求选择合适的模型版本(如doubao-seed-1.6、doubao-seed-1.6-thinking或doubao-seed-1.6-flash)。

- 获取API密钥:在开通服务后,平台提供一个API密钥,用在在调用模型时进行身份验证。

- 调用模型:

- 使用API接口:豆包大模型1.6基于API接口进行调用。

- 构建请求:根据需求构建请求数据,包括输入文本、参数设置等。

- 发送请求:使用HTTP请求将数据发送到模型的API接口。

- 接收响应:模型处理完成后,返回响应数据,包括生成的文本或其他结果。

示例代码(Python)

以下是使用Python调用豆包大模型1.6的示例代码:

import requests

import json

api_key = "your_api_key"

api_secret = "your_api_secret"

model_version = "doubao-seed-1.6" # 或doubao-seed-1.6-thinking、doubao-seed-1.6-flash

api_url = f"https://api.volcengine.com/v1/model/{model_version}"

data = {

"input": "你的输入文本",

"parameters": {

"max_length": 256, # 输出的最大长度

"temperature": 0.7, # 随机性参数

"top_p": 0.9, # 核心采样参数

"top_k": 50, # 核心采样参数

"do_sample": True # 是否采样

}

}

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

response = requests.post(api_url, headers=headers, data=json.dumps(data))

if response.status_code == 200:

result = response.json()

print("模型输出:", result["output"])

else:

print("请求失败,状态码:", response.status_code)

print("错误信息:", response.text)豆包大模型1.6:广泛的应用场景

豆包大模型1.6凭借其强大的功能和卓越的性能,在多个领域都有着广泛的应用前景。

内容创作

豆包1.6可以用于生成广告文案、新闻报道、故事、小说等,帮助用户快速产出高质量的内容。无论是营销人员还是内容创作者,都可以从中受益。

智能对话

豆包1.6可以应用于智能客服和聊天机器人,提供自然流畅的多轮对话体验,提升用户交互效率。这将极大地改善用户体验,提高客户满意度。

代码生成

豆包1.6可以根据需求生成前端代码片段,辅助开发者排查错误,提高开发效率。这对于软件开发人员来说,无疑是一个强大的助手。

教育辅导

豆包1.6可以解答学科问题,生成教学资源,辅助学生学习和教师备课。这将为教育领域带来革命性的变革,让学习更加个性化和高效。

多模态内容生成

豆包1.6可以结合图片或视频输入,生成相关文字描述或创意内容,助力多媒体创作。这为广告、电影、游戏等行业带来了无限的创作灵感。

总而言之,字节跳动推出的豆包大模型1.6,以其多模态深度思考能力、卓越的性能表现和广泛的应用场景,正在成为AI领域的一颗耀眼的新星。随着技术的不断发展,我们有理由相信,豆包1.6将在未来为各行各业带来更多的惊喜和价值。