字节跳动豆包大模型1.6:多模态深度思考的新标杆

在人工智能技术日新月异的今天,大型语言模型(LLM)正逐渐成为推动各行各业创新发展的重要引擎。字节跳动近期推出的豆包大模型1.6(Doubao-Seed-1.6),凭借其卓越的多模态处理能力、强大的推理性能以及灵活的应用模式,再次刷新了人们对AI技术潜力的认知。本文将深入剖析豆包大模型1.6的技术特点、功能优势、应用场景以及未来发展趋势,力求为读者呈现一个全面而深入的解读。

豆包大模型1.6的技术架构与核心功能

豆包大模型1.6是字节跳动倾力打造的多模态深度思考大模型,它不仅支持处理文字,还能理解和生成图像、视频等多种形式的内容。这种多模态能力使得豆包大模型1.6在处理复杂任务时更具优势,能够更好地模拟人类的感知和认知过程。

该模型最大的亮点之一是其支持auto、thinking和non-thinking三种思考模式。Auto模式能够根据任务的复杂程度自动选择是否开启深度思考,从而在保证效果的同时,最大限度地降低计算资源的消耗。Thinking模式则专注于深度推理,适用于需要复杂逻辑分析和计算的场景。Non-thinking模式则适用于对响应速度要求较高的场景,能够快速生成结果。

此外,豆包大模型1.6还拥有高达256k的长上下文窗口,这意味着它可以处理更长的文本序列,从而更好地理解上下文信息,生成更连贯、更精准的内容。模型支持最大224k tokens的输入长度和16k tokens的输出长度,这为处理复杂的创作任务提供了充足的空间。

三大模型版本:满足不同场景需求

为了满足不同用户的需求,豆包大模型1.6提供了三个不同的模型版本:doubao-seed-1.6、doubao-seed-1.6-thinking和doubao-seed-1.6-flash。这三个版本各有侧重,能够应对各种不同的应用场景。

- doubao-seed-1.6:全能综合型模型

作为全能型的综合模型,doubao-seed-1.6集成了深度思考、多模态理解和图形界面操作等多项能力。用户可以根据实际需求灵活选择开启或关闭深度思考功能。更值得一提的是,该模型还支持自适应思考模式,能够根据提示词的难度自动判断是否开启深度思考,从而在提升效果的同时,大幅减少tokens的消耗。这种自适应能力使得doubao-seed-1.6在各种场景下都能表现出色。

- doubao-seed-1.6-thinking:深度思考强化版

doubao-seed-1.6-thinking是豆包大模型1.6系列中专注于深度思考的强化版本。它在代码编写、数学计算、逻辑推理等基础能力上进行了进一步的提升,能够处理更为复杂的任务。同时,该模型也支持256K的上下文,能够理解和生成更长的文本内容,非常适合需要深度分析和复杂推理的场景。

- doubao-seed-1.6-flash:极速响应版本

对于对响应速度有极高要求的应用场景,doubao-seed-1.6-flash无疑是最佳选择。作为豆包大模型1.6系列中的极速版本,它不仅具备深度思考和多模态理解能力,还支持256K上下文。该模型的延迟极低,TOPT(Top-of-Pipeline Time)仅需10ms,能够快速响应用户的请求。在视觉理解能力方面,doubao-seed-1.6-flash的表现也与友商的旗舰模型相媲美,非常适合实时交互和视觉任务处理。

卓越的性能表现:领先的技术实力

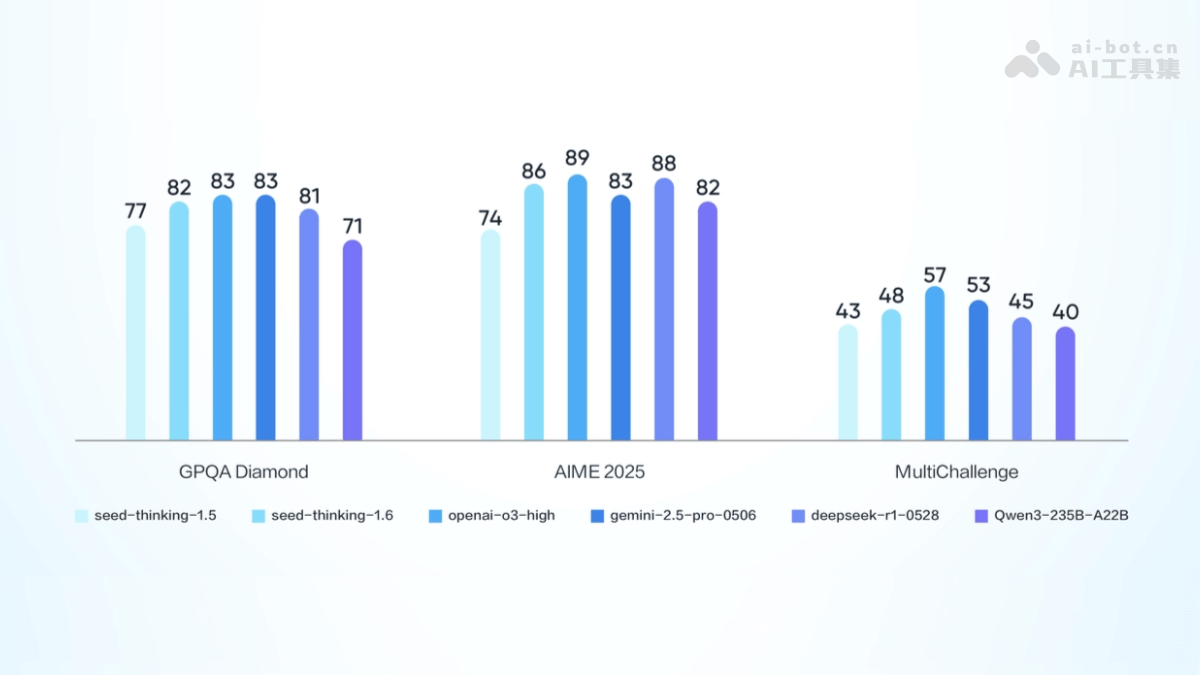

豆包大模型1.6在多个权威测评中都取得了优异的成绩,充分展现了其领先的技术实力。

- GPQA Diamond测试: 在GPQA Diamond测试中,豆包1.6-thinking模型取得了81.5分的成绩,达到了全球第一梯队水平,是目前最好的推理模型之一。这一成绩充分证明了豆包大模型1.6在复杂推理任务上的卓越表现。

- 数学测评AIME25: 在数学测评AIME25中,豆包1.6-thinking模型的成绩达到了86.3分,相比豆包1.5深度思考模型提升了12.3分。这一显著的提升表明豆包大模型1.6在数学计算能力方面取得了重大突破。

这些优异的性能表现不仅证明了豆包大模型1.6的技术实力,也为它在更广泛的应用场景中发挥作用奠定了坚实的基础。

灵活的定价模式:满足不同规模需求

在定价方面,豆包大模型1.6采用了统一的定价模式,无论是否开启深度思考模式,无论是文本还是视觉输入,tokens价格均保持一致。这种定价模式的优势在于简单透明,方便用户根据自身需求进行选择和预算。

具体的定价标准如下:

- 输入长度0-32K:

- 输入价格:0.8元/百万tokens

- 输出价格:8元/百万tokens

- 输入长度32K-128K:

- 输入价格:1.2元/百万tokens

- 输出价格:16元/百万tokens

- 输入长度128K-256K:

- 输入价格:2.4元/百万tokens

- 输出价格:24元/百万tokens

- 输入32K、输出200 tokens以内:

- 输入价格:0.8元/百万tokens

- 输出价格:2元/百万tokens

这种分段定价模式能够满足不同规模用户的需求,使得豆包大模型1.6的应用更加灵活和经济。

广泛的应用场景:赋能各行各业

凭借其强大的功能和灵活的应用模式,豆包大模型1.6在多个领域都展现出了巨大的潜力。

- 内容创作: 豆包大模型1.6可以用于生成广告文案、新闻报道、故事、小说等各种类型的内容,帮助用户快速产出高质量的文本。其强大的语言理解和生成能力使得它能够轻松驾驭各种写作风格,满足不同用户的创作需求。

- 智能对话: 豆包大模型1.6可以应用于智能客服和聊天机器人,提供自然流畅的多轮对话体验,提升用户交互效率。其强大的上下文理解能力和快速响应速度使得它能够更好地理解用户意图,提供更精准的回答。

- 代码生成: 豆包大模型1.6可以根据需求生成前端代码片段,辅助开发者排查错误,提高开发效率。对于程序员来说,这无疑是一个强大的助手,能够帮助他们更快地完成开发任务。

- 教育辅导: 豆包大模型1.6可以解答学科问题,生成教学资源,辅助学生学习和教师备课。它的知识储备和逻辑推理能力使得它能够成为一个优秀的学习伙伴,帮助学生更好地理解和掌握知识。

- 多模态内容生成: 豆包大模型1.6可以结合图片或视频输入,生成相关的文字描述或创意内容,助力多媒体创作。这种多模态能力使得它能够更好地理解和表达图像、视频中的信息,为用户提供更丰富的创作选择。

如何使用豆包大模型1.6:详细步骤指南

要使用豆包大模型1.6,您需要按照以下步骤进行操作:

- 注册并登录火山引擎平台: 首先,访问火山引擎官方网站,按照提示完成注册和登录。

- 开通豆包大模型服务: 登录后,进入服务页面,找到豆包大模型1.6的服务页面。

- 开通服务: 根据页面提示,开通豆包大模型1.6服务。

- 选择版本: 根据您的需求选择合适的模型版本(如doubao-seed-1.6、doubao-seed-1.6-thinking或doubao-seed-1.6-flash)。

- 获取API密钥: 在开通服务后,平台会提供一个API密钥,用于在调用模型时进行身份验证。

- 调用模型:

- 使用API接口: 豆包大模型1.6基于API接口进行调用。

- 构建请求: 根据您的需求构建请求数据,包括输入文本、参数设置等。

- 发送请求: 使用HTTP请求将数据发送到模型的API接口。

- 接收响应: 模型处理完成后,返回响应数据,包括生成的文本或其他结果。

以下是一个使用Python调用豆包大模型1.6的示例代码:

import requests

import json

api_key = "your_api_key"

api_secret = "your_api_secret"

model_version = "doubao-seed-1.6" # 或doubao-seed-1.6-thinking、doubao-seed-1.6-flash

api_url = f"https://api.volcengine.com/v1/model/{model_version}"

data = {

"input": "你的输入文本",

"parameters": {

"max_length": 256, # 输出的最大长度

"temperature": 0.7, # 随机性参数

"top_p": 0.9, # 核心采样参数

"top_k": 50, # 核心采样参数

"do_sample": True # 是否采样

}

}

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

response = requests.post(api_url, headers=headers, data=json.dumps(data))

if response.status_code == 200:

result = response.json()

print("模型输出:", result["output"])

else:

print("请求失败,状态码:", response.status_code)

print("错误信息:", response.text)总结与展望

总而言之,字节跳动的豆包大模型1.6凭借其多模态处理能力、强大的推理性能以及灵活的应用模式,为人工智能领域带来了新的突破。无论是在内容创作、智能对话、代码生成还是教育辅导等领域,豆包大模型1.6都展现出了巨大的应用潜力。随着人工智能技术的不断发展,我们有理由相信,豆包大模型1.6将在未来发挥更加重要的作用,为各行各业带来更多的创新和价值。

在未来,我们可以期待豆包大模型1.6在以下几个方面取得更大的进展:

- 更强的多模态能力: 进一步提升对图像、视频等多模态信息的理解和生成能力,实现更复杂的跨模态任务。

- 更高效的推理性能: 通过优化模型结构和算法,进一步提升推理速度和效率,降低计算成本。

- 更广泛的应用场景: 探索在更多领域的应用,如医疗、金融、交通等,为各行各业赋能。

我们有理由相信,在字节跳动的持续投入和不断创新下,豆包大模型1.6将不断进化,成为人工智能领域的一颗璀璨明星。