在数字内容创作领域,人工智能(AI)技术的飞速发展正以前所未有的方式重塑着行业的格局。特别是视频生成领域,谷歌的Veo 3等先进模型,以其卓越的逼真度和创作能力,引发了广泛关注。然而,伴随技术进步而来的,往往是伦理和社会责任的挑战。本文将深入探讨Veo 3模型在TikTok等社交媒体平台上的滥用现象,剖析其中涉及的监管难题、技术伦理困境,并展望未来AI内容治理的可能方向。

AI视频生成技术的双刃剑

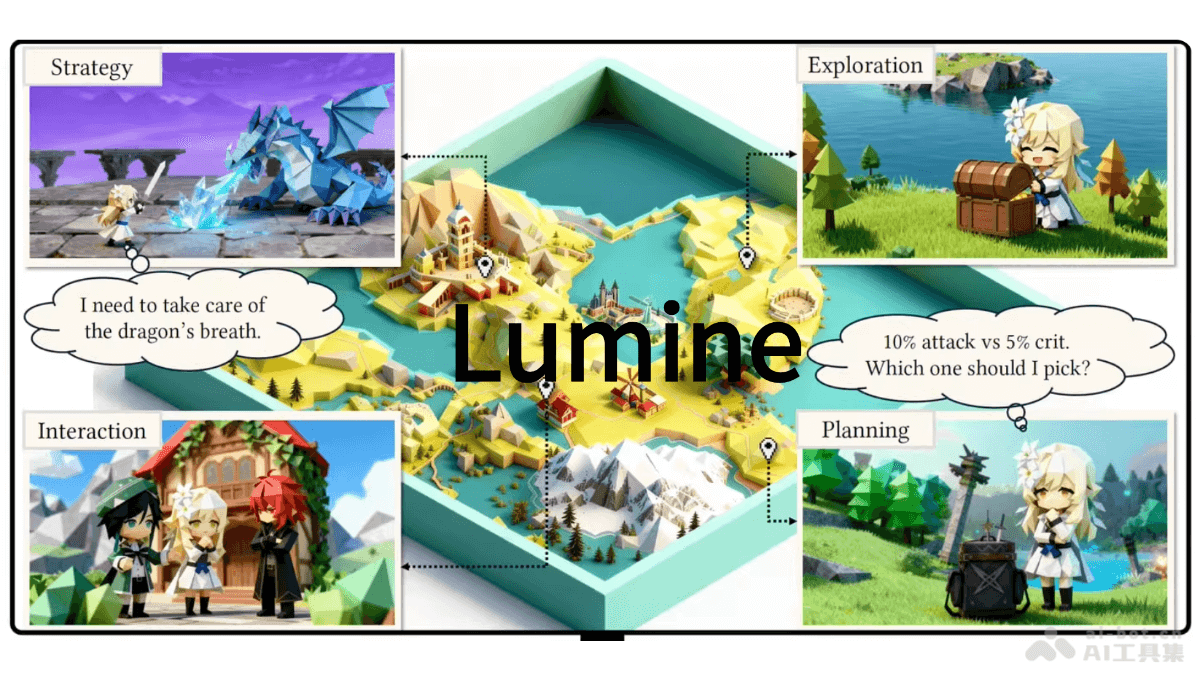

自2025年5月谷歌发布Veo 3以来,AI视频生成技术的能力边界再次被刷新。Veo 3不仅能够生成高度逼真的视频内容,还能在一定程度上理解和执行复杂的创作指令。这种强大的能力使得AI视频在娱乐、教育、营销等领域展现出巨大的应用潜力。例如,企业可以利用AI快速生成产品宣传片,教育机构可以制作生动有趣的教学视频,个人创作者则可以借助AI实现创意表达。

然而,任何技术都具有双面性。Veo 3的强大能力也为恶意 использования создават и разпространяват расистки и дискриминационни материали. В частности, случаите на разпространение на расистки AI видеа в TikTok, създадени с Veo 3, предизвикаха сериозна загриженост в обществеността и предизвикаха дебати относно етичните граници на AI технологиите и необходимостта от ефективни мерки за контрол.

TikTok платформите面临的监管挑战

社交媒体平台,如TikTok,作为信息传播的重要渠道,面临着日益严峻的内容监管挑战。一方面,平台需要保障用户的言论自由,鼓励多元化的内容创作;另一方面,平台有责任维护健康的网络生态,防止有害信息的传播。然而,在实际操作中,这两者之间常常存在冲突。

根据TikTok的服务条款,平台明确禁止仇恨言论、歧视行为以及任何形式的攻击性内容。然而,尽管有明确的规定,平台上仍然出现了大量由Veo 3生成的种族歧视视频。这些视频通常利用AI技术生成带有种族偏见的角色形象和故事情节,并通过算法推荐传播给更广泛的用户群体。这种现象暴露了社交媒体平台在内容审核和监管方面存在的不足。

TikTok声称,平台采用技术手段和人工审核相结合的方式来识别违规内容。然而,面对海量的视频上传,人工审核的效率往往难以跟上内容生产的速度。与此同时,AI算法在识别微妙的种族主义信息方面也存在局限性。例如,一些视频可能 не използват директни обиди или стереотипи, но чрез фини намеци и контекстуални подсказки предават дискриминационни послания. Това прави откриването и премахването на подобни видеа изключително трудно.

Google在AI伦理方面的责任

作为Veo 3的开发者,谷歌在防止AI技术被滥用方面负有重要责任。谷歌在其《禁止使用政策》中明确规定,禁止利用其服务宣传仇恨言论、骚扰、欺凌、恐吓和虐待行为。然而,从实际情况来看,Veo 3似乎并未能有效阻止种族主义视频的生成。

一个可能的原因是,种族主义信息的表达方式具有多样性和隐蔽性。AI模型在理解人类语言和文化背景方面仍然存在局限性,难以准确识别隐藏在文本和图像中的种族偏见。例如,用户可以通过使用隐晦的提示语或 символични образи заобикалят ограниченията на AI модела и да генерират расистки съдържание.

此外,AI模型的训练数据也可能存在偏见。如果训练数据中包含了大量的种族 стереотипи или дискриминационни изрази, AI моделът може неволно да възпроизведе тези偏见 в генерираните от него видеа. Затова е изключително важно да се обърне внимание на качеството и разнообразието на тренировъчните данни, както и да се прилагат техники за намаляване на偏见 в AI модела.

AI内容治理的未来方向

面对AI内容滥用的挑战,我们需要从技术、伦理和监管等多个层面入手,构建更加完善的AI内容治理体系。

首先,技术层面需要不断提升AI模型的内容审核能力。通过引入更先进的自然语言处理和图像识别技术,AI模型可以更准确地识别和过滤有害信息。此外,还可以开发专门的AI工具,用于检测和 предупреждаване за расистки или дискриминационни видеа.

其次,伦理层面需要加强对AI开发者的伦理约束。AI开发者应 четко разбират потенциалните рискове и вреди, които могат да бъдат причинени от техните технологии, и да прилагат мерки за намаляване на тези рискове. Освен това, AI разработчиците трябва да бъдат прозрачни относно функционирането на техните модели и да позволяват на обществеността да ги проверява и оценява.

最后,监管层面需要建立健全的法律法规,明确AI内容生成的法律边界。对于利用AI技术制造和传播有害信息的行为,应依法追究法律责任。同时,监管机构应加强对社交媒体平台的监管,要求平台建立完善的内容审核机制,并对违规行为进行严厉处罚.

此外,还应加强国际合作,共同应对AI内容治理的挑战。由于AI技术的跨国性特点,单一国家的监管措施往往难以有效应对全球性的问题。因此,各国需要加强信息共享和政策协调,共同打击利用AI技术进行的违法犯罪活动。

结论

AI视频生成技术在带来创新与便利的同时,也带来了伦理与监管的挑战。谷歌的Veo 3在TikTok上的滥用案例,再次警示我们,技术发展必须与伦理规范和社会责任并重。只有通过技术创新、伦理约束和有效监管的协同作用,我们才能确保AI技术真正服务于人类,而不是成为 злоупотребите и дискриминацията.

展望未来,AI内容治理将是一个长期而复杂的任务。我们需要不断学习和适应新的技术发展,及时调整监管策略,以应对不断变化的挑战。同时,我们也需要加强公众教育,提高公众对AI技术的认识和理解,共同参与到AI内容治理的 дискусия и взимането на решения.