在2025年7月4日,昆仑万维再次宣布开源其第二代奖励模型Skywork-Reward-V2系列,这一举动无疑再次引发了AI界的广泛关注。该系列模型包含了8个不同规模和基座模型的版本,参数范围从6亿到80亿不等,一经推出便迅速在七大主流奖励模型评测榜单中占据领先地位,成为开源奖励模型领域的新焦点。那么,Skywork-Reward-V2究竟有何独特之处,又将对人工智能领域产生怎样的影响呢?

奖励模型在强化学习(RLHF)中扮演着至关重要的角色,它直接影响着AI系统如何学习和优化以更好地符合人类的偏好。为了构建新一代的奖励模型,昆仑万维投入了大量资源和精力,构建了一个包含4000万对偏好对比的混合数据集,命名为Skywork-SynPref-40M。这个数据集的构建过程并非简单的堆砌数据,而是采用了人机协同的两阶段流程,将人工标注的高质量与模型的规模化处理能力相结合,从而保证了数据的质量和规模。

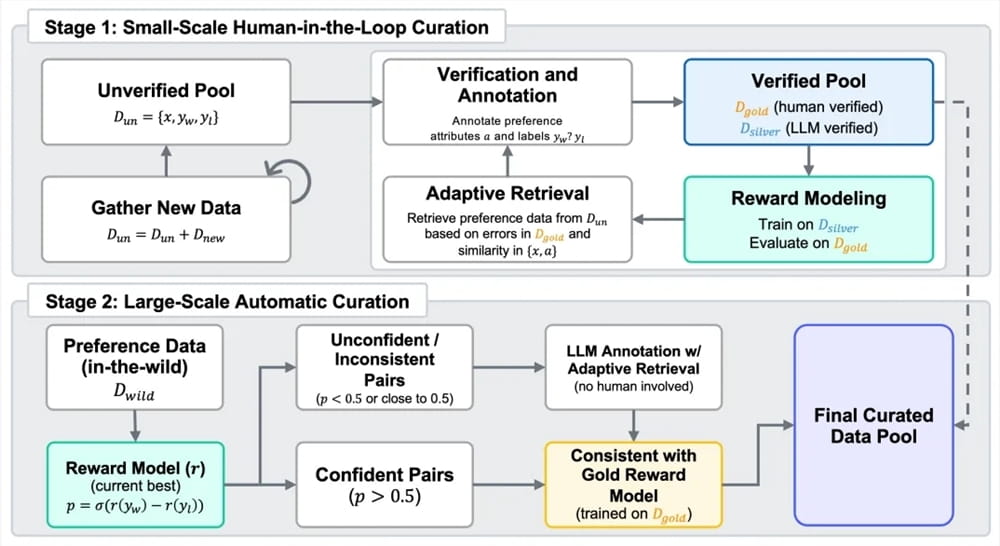

在第一阶段,团队首先构建了一个未经完全验证的初始偏好池。随后,借助大语言模型生成辅助属性,人工标注者依照严格的协议和外部工具,并利用大语言模型对部分数据进行精细审核,最终构建出一个小规模但高质量的“金标准”数据集。这个“金标准”数据集成为了后续数据扩展的基础。紧接着,团队以金标准数据的偏好标签为引导,结合大语言模型大规模生成高质量的“银标准”数据,并通过多轮迭代优化,不断提升数据的质量。

第二阶段则侧重于自动化的大规模数据扩展。通过使用已经训练完成的奖励模型执行一致性过滤,团队在减少人工标注负担的同时,实现了偏好数据规模与质量的平衡。这种人机协同的数据构建方式,充分发挥了人工智能和人类智慧的优势,为Skywork-Reward-V2系列的成功奠定了坚实的基础。

基于这个优质的混合偏好数据,昆仑万维开发出了Skywork-Reward-V2系列模型。该系列模型展现出广泛的适用性和卓越的能力,涵盖了对人类偏好的通用对齐、客观正确性、安全性、风格偏差抵抗能力以及best-of-N扩展能力等多个维度。在Reward Bench v1/v2、PPE Preference & Correctness、RMB、RM-Bench、JudgeBench等七个主流奖励模型评估基准上,Skywork-Reward-V2系列全面达到了当前最优(SOTA)水平,这充分证明了其在奖励模型领域的领先地位。

值得一提的是,即使是基于最小模型Skywork-Reward-V2-Qwen3-0.6B,其整体性能也几乎达到了上一代最强模型的平均水平。而Skywork-Reward-V2-Qwen3-1.7B更是超越了当前开源奖励模型的SOTA。最大规模的Skywork-Reward-V2-Llama-3.1-8B在所有主流基准测试中全面超越,成为了当前整体表现最优的开源奖励模型。这些数据充分展示了Skywork-Reward-V2系列的强大实力。

除了在各项基准测试中表现出色外,Skywork-Reward-V2系列模型还具备广泛覆盖多维人类偏好能力。在通用偏好评估基准上,它优于多个参数更大的模型及最新生成型奖励模型。在客观正确性评估方面,其在知识密集型任务中表现突出。此外,在多项高级能力评估中,包括Best-of-N任务、偏见抵抗能力测试、复杂指令理解及真实性判断等,Skywork-Reward-V2系列均取得了领先成绩,展现出卓越的泛化能力与实用性。这些都使得该系列模型在实际应用中具有更大的潜力。

数据筛选流程的高度扩展性也显著提升了奖励模型的性能。经过精细筛选和过滤的偏好数据,在多轮迭代训练中能够持续有效地提升模型整体性能,尤其是在第二阶段全自动数据扩展中表现显著。早期版本实验显示,仅使用1.8%的高质量数据训练8B规模模型,其性能就超过了当前70B级SOTA奖励模型,这充分印证了Skywork-SynPref数据集在规模和质量上的优势。高质量的数据是模型成功的关键,而Skywork-Reward-V2系列在这方面无疑做得非常出色。

那么,Skywork-Reward-V2系列的开源,又将对人工智能领域产生怎样的影响呢?

首先,它将加速奖励模型技术的发展。通过开源,昆仑万维将自己的技术成果分享给整个社区,这将吸引更多的研究者和开发者参与到奖励模型的研发中来,共同推动该领域的技术进步。同时,Skywork-Reward-V2系列的出色性能,也将为其他研究者提供一个优秀的参考基准,促进更多创新性工作的涌现。

其次,它将降低奖励模型的使用门槛。开源意味着任何人都可以免费使用和修改Skywork-Reward-V2系列模型,这无疑将大大降低了奖励模型的使用门槛。更多的开发者可以利用这些开源模型来构建自己的AI应用,而无需从零开始进行研发。这将极大地促进人工智能技术的普及和应用。

此外,Skywork-Reward-V2系列的开源还将促进人工智能的伦理发展。奖励模型在很大程度上决定了AI系统的行为方式,因此,其设计和训练必须考虑到伦理因素。通过开源,我们可以更好地审查和改进奖励模型,确保其符合人类的价值观和伦理规范。这将有助于构建更加安全、可靠和负责任的人工智能系统。

当然,Skywork-Reward-V2系列的开源也面临着一些挑战。例如,如何保证开源模型的安全性,防止其被用于恶意用途?如何构建一个健康和可持续的开源生态系统,吸引更多的贡献者参与?这些问题都需要我们认真思考和解决。

为了更好地理解Skywork-Reward-V2系列的技术细节,我们可以进一步分析其所采用的数据构建方法。人机协同的两阶段流程,是保证数据质量的关键。在第一阶段,人工标注者不仅要对数据进行标注,还要利用大语言模型生成的辅助属性进行审核,这可以有效地提高标注的准确性和一致性。同时,金标准数据的构建,为后续的大规模数据扩展提供了可靠的指导。

在第二阶段,自动化的大规模数据扩展,可以有效地降低人工成本,并提高数据的规模。通过使用已经训练完成的奖励模型执行一致性过滤,可以去除低质量的数据,保证数据的整体质量。这种人机协同的数据构建方法,充分结合了人工智能和人类智慧的优势,为Skywork-Reward-V2系列的成功奠定了坚实的基础。

此外,Skywork-Reward-V2系列在模型设计上也进行了一些创新。例如,它采用了多种不同的基座模型,包括Qwen3和Llama-3.1,这使得它可以适应不同的应用场景。同时,它还提供了不同规模的模型版本,从6亿到80亿参数不等,这使得开发者可以根据自己的需求选择合适的模型。这些灵活的设计,使得Skywork-Reward-V2系列具有更广泛的适用性。

总的来说,昆仑万维再次开源Skywork-Reward-V2系列,是人工智能领域的一件大事。它不仅展示了昆仑万维在奖励模型技术方面的领先地位,也将加速整个领域的技术发展,降低使用门槛,并促进人工智能的伦理发展。我们期待Skywork-Reward-V2系列在未来的应用中发挥更大的作用,为人类社会带来更多的福祉。

HuggingFace地址:

https://huggingface.co/collections/Skywork/skywork-reward-v2-685cc86ce5d9c9e4be500c84

GitHub地址: