在人工智能(AI)迅速发展的背景下,AI模型生成不实信息的问题日益凸显。近日,音乐平台Soundslice便经历了一次由ChatGPT“捏造”功能引发的有趣事件,并最终促使该公司开发了一项原本不在计划内的全新功能。这一事件不仅揭示了AI模型在信息生成方面存在的潜在风险,也引发了关于产品开发策略的新思考。

Soundslice是一家专注于乐谱数字化的平台,其主要功能是将照片或PDF格式的乐谱转换为数字格式,并与音频或视频录音同步,方便音乐爱好者学习和练习。该平台还提供诸如慢速播放和段落循环等实用工具,以辅助用户更好地掌握乐曲。

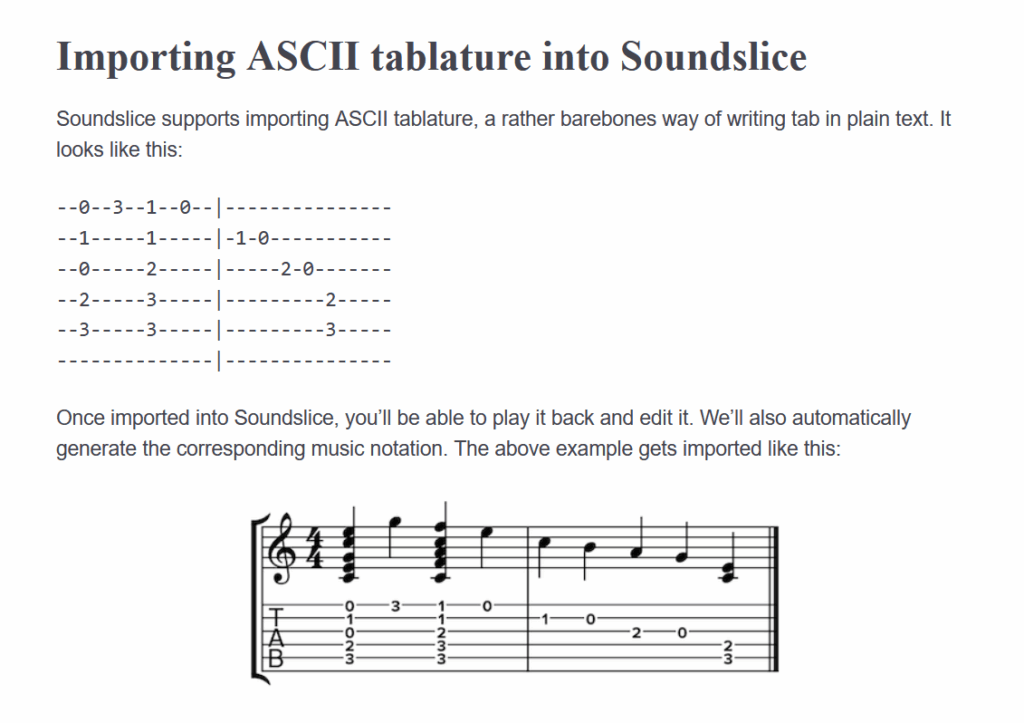

然而,几个月前,Soundslice的联合创始人Adrian Holovaty开始注意到公司错误日志中出现异常活动。用户上传的内容并非传统的乐谱文件,而是包含ASCII tablature(一种文本吉他谱格式)的ChatGPT对话截图。这种格式并非Soundslice平台所支持的。

为了探究原因,Holovaty亲自测试了ChatGPT,结果发现该AI模型错误地指示用户创建Soundslice账户,并使用该平台导入ASCII谱以进行音频播放。事实上,Soundslice从未支持过ASCII谱的导入功能。ChatGPT的这一虚假信息不仅误导了用户,也损害了Soundslice的声誉。

在AI研究领域,这种AI模型生成虚假信息并表现出自信的现象被称为“幻觉”或“虚构”。自2022年11月ChatGPT公开发布以来,AI模型虚构信息的问题一直困扰着研究人员和用户。许多人开始错误地将聊天机器人视为搜索引擎的替代品,从而导致了更多不准确信息的传播。

大型语言模型(LLM)本质上是预测机器,它们通过在海量文本数据集上进行训练来学习。这些模型能够生成看似合理但实际上完全不准确的内容。当面对训练数据中缺乏充分信息的领域时,模型会进行统计性的即兴创作,基于统计模式而非事实准确性来生成文本。在Soundslice的案例中,ChatGPT通过捏造一个Soundslice并不存在的功能,向用户提供了他们“想听到”的信息。

AI模型的虚构行为已经造成了一些实际问题。例如,在2023年,一些律师因提交包含ChatGPT生成的虚假案例引用的法律文件而受到制裁。2024年2月,加拿大民事决议法庭责令加拿大航空公司向一位客户支付赔偿金,并遵守一项由其支持聊天机器人虚构的丧亲机票政策。

面对ChatGPT的虚构信息,Soundslice并没有选择发布声明来澄清事实,而是选择了一条不同的道路。“我们最终决定:不妨顺应市场需求,”Holovaty解释道。于是,Soundslice团队着手开发ASCII谱导入器——一项原本被Holovaty列为“2025年最不可能开发的软件”的功能。他们还更新了用户界面,以告知用户有关这项新功能的可用性。

Soundslice的解决方案为我们提供了一个“变废为宝”的有趣案例。然而,对于Holovaty来说,这种情况也引发了关于产品开发的哲学问题。“我对这件事的感受很矛盾,”他写道。“我很高兴添加一个可以帮助人们的工具。但我觉得我们的手以一种奇怪的方式被束缚了。我们真的应该根据错误信息来开发功能吗?”

尽管存在争议,Soundslice的这一举动无疑是应对AI虚构信息的一种创新方式。它不仅满足了用户的潜在需求,也为其他企业提供了一个应对类似情况的新思路。与其被动地纠正AI模型的错误,不如主动地适应并利用这些错误,将其转化为产品开发的机遇。

此外,Soundslice的案例也提醒我们,在人工智能时代,企业需要更加关注AI模型的信息生成能力,并采取相应的措施来应对潜在的风险。这包括加强对AI模型的训练数据的审查,提高模型的事实准确性,以及建立有效的反馈机制,以便及时纠正模型生成的错误信息。

更重要的是,企业需要重新审视其产品开发策略,并在传统的需求分析方法之外,探索新的思路。AI模型的“幻觉”或许可以被视为一种潜在的市场需求信号,企业可以通过分析这些“幻觉”来发现用户未被满足的需求,并据此开发出更具创新性的产品。

当然,这种基于AI虚构信息进行产品开发的策略也存在一定的风险。企业需要谨慎评估这些“幻觉”的真实性和可行性,避免盲目跟风,导致资源浪费。此外,企业还需要建立完善的风险管理机制,以应对可能出现的法律和伦理问题。

总而言之,Soundslice的案例为我们提供了一个关于人工智能时代产品开发的宝贵启示。面对AI模型的虚构信息,企业不应仅仅将其视为一种威胁,而应将其视为一种机遇,通过创新性的思维和行动,将其转化为推动产品发展的动力。这不仅有助于企业在激烈的市场竞争中脱颖而出,也有助于推动人工智能技术的健康发展。