在2025年的盛夏,人工智能领域再次迎来激动人心的时刻。阿里巴巴正式宣布开源其最新的视频生成模型——通义万相Wan2.2,这不仅是技术上的一次飞跃,更是AI视频生成领域 democratize 的一次大胆尝试。此次开源包含了三个核心模型:文生视频(Wan2.2-T2V-A14B)、图生视频(Wan2.2-I2V-A14B)以及统一视频生成模型(Wan2.2-IT2V-5B),预示着视频创作的未来将更加智能化和普及化。

MoE架构:计算效率的革新

通义万相2.2最引人注目的创新在于其采用了业界首创的MoE(Mixture of Experts)架构。在视频生成领域,处理长Token序列一直是计算资源消耗的瓶颈。MoE架构的引入,巧妙地通过将不同任务分配给不同的“专家”模型,有效缓解了这一问题。文生视频和图生视频模型总参数量高达27B,但激活参数仅为14B,这种设计在同等参数规模下,实现了约50%的计算资源节省。更重要的是,MoE架构在处理复杂运动生成、人物交互以及美学表达方面表现出色,为视频内容的丰富性和表现力带来了质的提升。

MoE架构的核心思想在于“分而治之”。高噪声专家模型专注于视频的整体布局和结构,确保视频内容的连贯性和逻辑性;而低噪声专家模型则负责精雕细琢,提升视频的细节表现和视觉效果。这种协同工作模式不仅提高了计算效率,也使得模型能够更好地理解和生成复杂场景。

电影美学控制系统:艺术与技术的融合

通义万相2.2的另一大亮点是其首创的“电影美学控制系统”。该系统允许用户通过简单的关键词输入,精确控制视频的光影、色彩、构图以及人物微表情,从而达到专业电影级别的视觉效果。例如,通过输入“黄昏”、“柔光”、“边缘光”、“暖色调”、“中心构图”等关键词,模型能够自动生成具有浪漫氛围的金色落日余晖画面。相反,使用“冷色调”、“硬光”、“平衡图”、“低角度”的组合,则可以生成接近科幻电影的视觉效果。

这一创新性的系统,实际上是将电影制作中的艺术指导原则转化为可量化的技术参数。它不仅降低了视频创作的门槛,也为专业人士提供了更强大的创作工具。通过对美学元素的精确控制,创作者可以更加自由地表达自己的想法,实现个性化的视觉风格。

5B统一模型:消费级显卡的福音

除了大型模型外,通义万相还开源了一款5B小尺寸的统一视频生成模型。该模型最大的特点在于其对硬件资源的低要求,仅需22G显存的消费级显卡即可运行,并在数分钟内生成5秒高清视频。这一突破性的进展,使得AI视频生成技术不再是少数专业人士的专属,而是可以走进千家万户。

该模型采用高压缩率3D VAE架构,时间与空间压缩比达到4×16×16,信息压缩率提升至64,均实现开源模型的最高水平。这意味着在保证视频质量的前提下,模型能够以更小的体积运行,从而降低了对硬件的要求。同时支持文生视频和图生视频功能,进一步提升了其通用性和实用性。

5B统一模型的推出,无疑将极大地推动AI视频生成技术的普及。无论是个人用户还是小型团队,都可以轻松利用这一工具进行视频创作,从而激发更多的创意和创新。

多渠道开放使用:拥抱开源生态

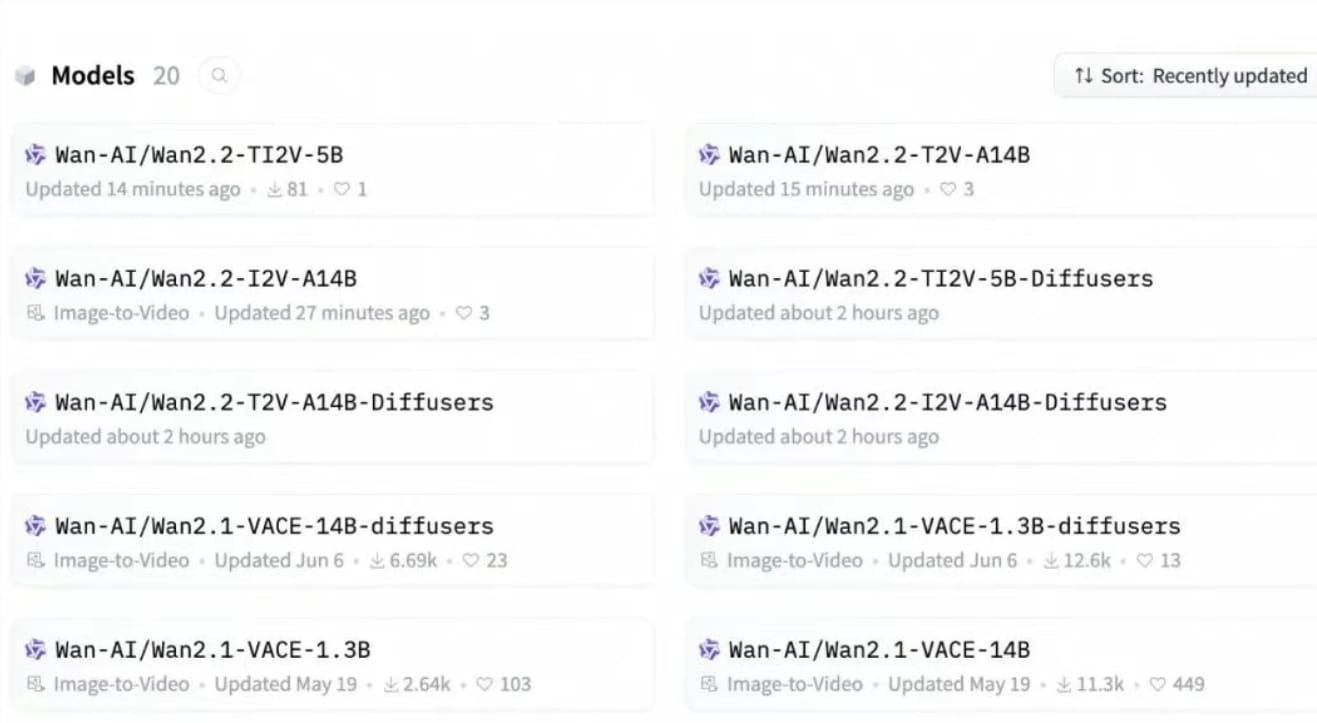

阿里巴巴对通义万相的开源策略,体现了其拥抱开源生态的决心。开发者可以通过GitHub、HuggingFace以及魔搭社区下载模型和代码,企业可以通过阿里云百炼调用模型API,普通用户则可以在通义万相官网和通义APP直接体验。这种多渠道开放的使用方式,旨在让更多的人参与到AI视频生成技术的发展中来。

自今年2月以来,通义万相已连续开源多款模型,累计下载量超过500万次。这一数字充分说明了开源策略的成功,以及通义万相对AI视频生成技术普及的巨大贡献。

技术细节剖析

深入了解通义万相2.2,需要关注其在技术上的几个关键创新点:

MoE架构的精细化设计:通义万相2.2的MoE架构并非简单地将模型划分为多个“专家”,而是根据视频生成的不同阶段和任务,对专家模型进行了精细化设计。高噪声专家模型主要负责处理视频的全局信息,如场景布局、主体运动等,而低噪声专家模型则专注于细节的优化,如光影效果、纹理细节等。这种分工合作的模式,使得模型能够更好地平衡计算效率和生成质量。

电影美学控制系统的参数化:电影美学控制系统并非简单的关键词匹配,而是将电影制作中的美学原则转化为可量化的参数。例如,光照效果可以通过调整光照强度、方向、颜色等参数来实现,构图可以通过调整主体的位置、大小、视角等参数来实现。这种参数化的设计,使得用户可以更加精确地控制视频的视觉风格。

高压缩率3D VAE架构的优化:通义万相2.2的5B统一模型采用了高压缩率3D VAE架构,该架构能够在保证视频质量的前提下,大幅降低模型的体积。为了实现这一目标,研究人员对3D VAE架构进行了多方面的优化,包括优化编码器和解码器的结构、改进损失函数的设计、采用更高效的量化方法等。

应用场景展望

通义万相2.2的开源,将为各行各业带来巨大的机遇。以下是一些潜在的应用场景:

内容创作:无论是短视频、广告片还是电影,都可以利用通义万相2.2快速生成高质量的视频内容。这不仅可以降低创作成本,还可以提高创作效率。

教育培训:教师可以利用通义万相2.2制作生动有趣的教学视频,帮助学生更好地理解知识。企业可以利用通义万相2.2制作培训视频,提高员工的技能水平。

游戏开发:游戏开发者可以利用通义万相2.2快速生成游戏场景、角色动画等,从而加快游戏开发进度。

虚拟现实:通义万相2.2可以用于生成虚拟现实场景,为用户提供更加沉浸式的体验。

社交媒体:用户可以利用通义万相2.2创作个性化的视频内容,分享自己的生活和想法。

面临的挑战与未来发展

尽管通义万相2.2在技术上取得了显著的进展,但仍然面临着一些挑战。例如,如何提高生成视频的真实感和自然度,如何解决生成视频中的伦理问题,如何保护生成视频的版权等。为了应对这些挑战,需要从多个方面入手,包括改进模型的设计、加强数据的管理、完善法律法规等。

展望未来,AI视频生成技术将朝着以下几个方向发展:

更高的生成质量:随着技术的不断进步,生成的视频将越来越逼真,越来越难以与真实视频区分。

更强的可控性:用户将能够更加精确地控制生成视频的各个方面,从而实现个性化的创作。

更广泛的应用:AI视频生成技术将在更多的领域得到应用,为各行各业带来变革。

更智能的交互:用户将能够通过更加自然的方式与AI视频生成系统进行交互,例如语音、手势等。

通义万相Wan2.2的开源,是AI视频生成技术发展历程中的一个重要里程碑。它不仅展示了阿里巴巴在人工智能领域的强大实力,也为全球的开发者和研究者提供了一个宝贵的学习和交流平台。我们有理由相信,在开源社区的共同努力下,AI视频生成技术将迎来更加美好的未来。