在人工智能领域,新一轮的技术革新正以惊人的速度席卷而来。智谱公司最新发布的GLM-4.5基座模型,不仅代表了该公司在AI技术上的又一次飞跃,更预示着大模型应用的新方向——智能体(Agent)。与以往单纯追求模型参数规模不同,GLM-4.5将重点放在了智能体应用设计、高性价比的技术优化以及全面拥抱开源和开发者生态的战略布局上,这无疑为整个行业的发展注入了新的活力。

智谱公司在今年4月发布的“AutoGLM沉思”已经展示了其在自主智能体方面的探索。而GLM-4.5的推出,则标志着智谱在模型矩阵上的重要升级。更重要的是,它反映了AI行业发展的一个趋势性变化:大模型的价值正在加速向解决实际问题和降低应用门槛的方向转移。

面向智能体的模型设计:GLM-4.5的技术亮点

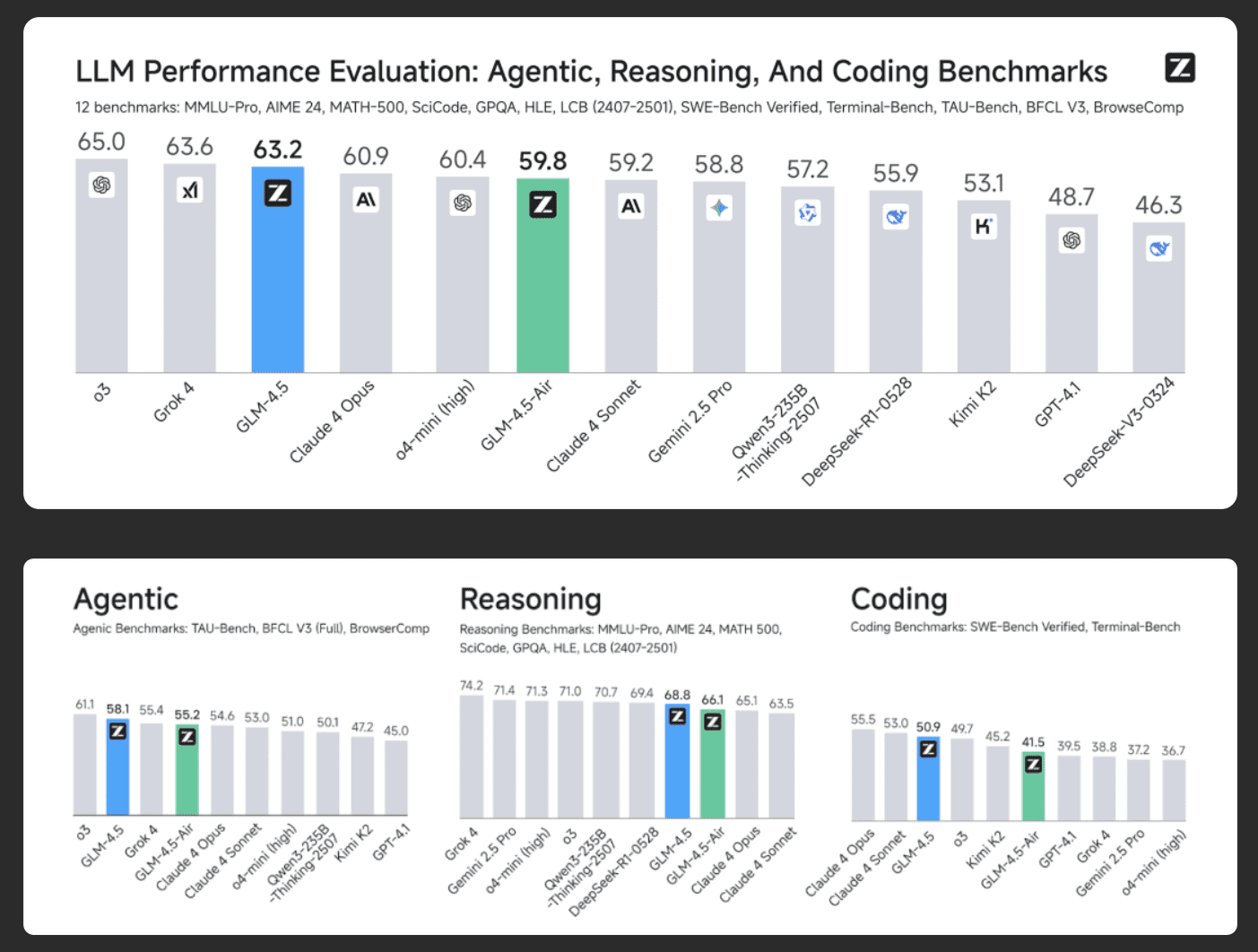

在评估大模型的能力时,综合能力基准评测是业内普遍采用的方法。智谱公司公布的GLM-4.5在一系列评测集上的表现引人注目。这些评测涵盖了推理、代码、科学、智能体等12个不同维度,旨在全面评估模型的综合素质。根据智谱公司提供的数据,GLM-4.5在这些测试中的综合得分位列全球参评模型的第三位,在开源模型中排名第一,展示了其强大的综合实力。

然而,比评测成绩更重要的是其背后的设计理念。GLM-4.5从一开始就将目标锁定在“智能体应用”。智能体需要模型具备任务理解、规划分解、工具调用和执行反馈等一系列复杂能力,这已经超越了传统聊天机器人的范畴。智谱公司将“在不损失原有能力的前提下融合更多通用智能能力”作为其对AGI(通用人工智能)的理解,而GLM-4.5正是这一理念的实践。

为了支持智能体所需的强大而灵活的能力,GLM-4.5在技术架构上做出了针对性的选择。

1. 混合专家(MoE)架构:

GLM-4.5采用了MoE架构,总参数量达到3550亿,而单次推理中被激活的参数量为320亿。这种架构允许模型在保持巨大知识储备和能力上限的同时,能够根据具体任务只调用部分“专家”网络进行计算。这种设计的直接好处是在保证高质量输出的前提下,有效控制推理成本和能耗,为大规模应用部署提供了可行性。MoE架构的引入,使得GLM-4.5在处理复杂任务时能够更加高效,同时也降低了运行成本,为实际应用提供了坚实的基础。

2. 双模式运行:

GLM-4.5被设计为两种工作模式——“思考模式”和“非思考模式”。“思考模式”专为复杂的推理和工具调用任务设计,允许模型投入更多计算资源进行深度规划;“非思考模式”则服务于需要快速响应的场景。这种设计兼顾了智能体在执行复杂任务时的“深度”与日常交互时的“速度”,是对实际应用场景需求的细致考量。通过双模式运行,GLM-4.5能够在不同场景下灵活切换,从而更好地满足用户的需求。

3. 针对性数据训练:

模型的训练过程也体现了其应用导向。在15万亿token的通用数据预训练之后,智谱团队使用了8万亿token的高质量数据,在代码、推理、智能体等领域进行了针对性训练,并通过强化学习进行能力对齐。这种“通识教育+专业深造”的训练路径,旨在让模型不仅知识渊博,更在特定专业领域具备解决实际问题的能力。这种训练方式使得GLM-4.5在处理特定任务时能够更加精准和高效。

综合来看,GLM-4.5并非一个泛泛的通用模型,其技术选型和训练策略都清晰地指向了构建高效、可靠的AI智能体这一具体目标,这也反映了智谱公司对大模型下一阶段应用形态的判断。

商业逻辑:成本、效率与生态

性能是技术层面的核心,而成本和生态则是决定一项技术能否被市场广泛接纳的关键。GLM-4.5在发布中,清晰地展现了其商业逻辑。

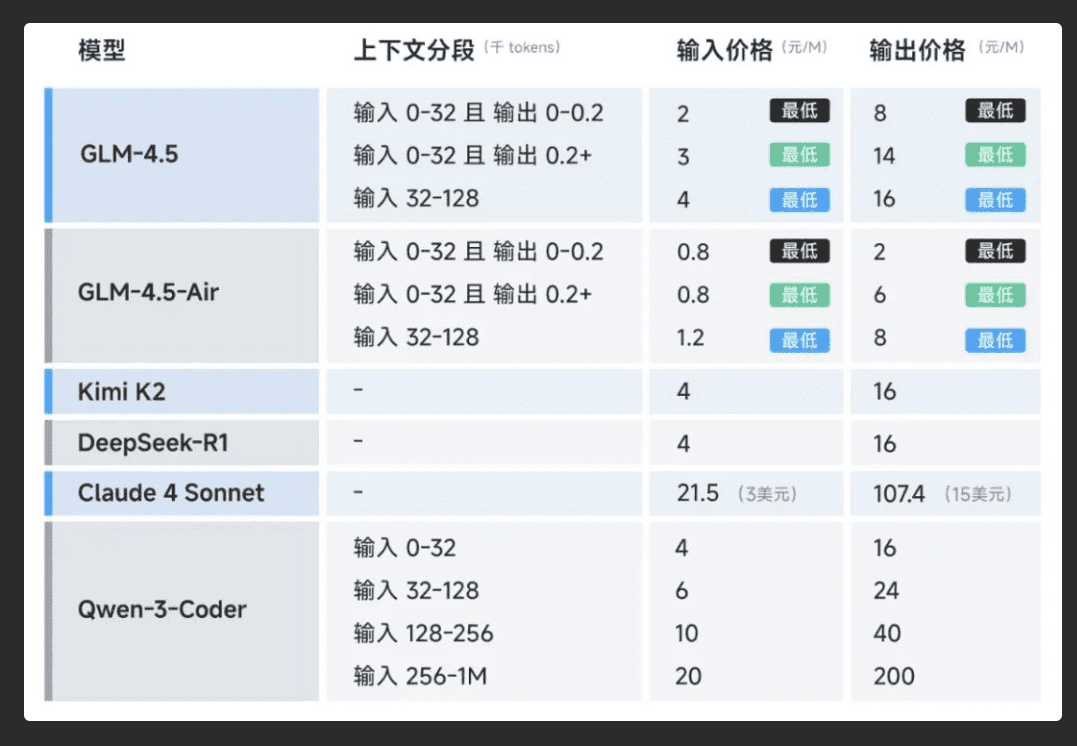

首先是参数效率带来的成本优势。“参数效率”是评估模型训练水平和架构设计的重要指标,即用相对更少的计算资源实现同等或更优的性能。智谱公司的数据显示,GLM-4.5的参数量显著低于部分业界同类模型,但在多项基准测试中表现更佳。在代码能力榜单SWE-bench Verified上,其性能与参数量的比值处于帕累托前沿,这证明了其较高的训练和推理效率。更高的效率直接转化为更低的部署和使用成本。此次公布的API定价——输入0.8元/百万tokens,输出2元/百万tokens——显著低于当前市场主流闭源模型的定价水平。配合高速版可达100 tokens/秒的生成速度,GLM-4.5为开发者提供了一个兼具高性能和低成本的选择。

其次是降低门槛、构建开发者生态的战略意图。低廉的价格并非目的,而是吸引开发者、繁荣生态的手段。AI应用的普及,根本上依赖于开发者社区的创造力。高昂的API费用一直是阻碍许多中小型团队和个人开发者进行创新的主要障碍之一。通过大幅降低价格,能够降低AI应用的开发门槛,激发更广泛的创新。

在生态构建上,智谱公司采取了务实的策略。例如,GLM-4.5的API被设计为可以兼容主流的Claude Code框架。这一举措使得已经熟悉该框架的开发者能够以极低的成本将工作流迁移至GLM-4.5,有效减少了技术选型和切换的阻力。

此外,将模型权重在Hugging Face和ModelScope等平台遵循MIT License进行开源,也体现了其开放的姿态。MIT License对商业使用限制极少,这为企业和个人基于GLM-4.5进行二次开发和商业化应用铺平了道路。通过“高参数效率”实现“低使用成本”,再以“低成本”和“高兼容性”吸引开发者,从而构建起一个活跃的应用生态——这是一条清晰且务实的商业路径。

从功能演示到实际应用的距离

衡量一个模型最终价值的,仍然是它在真实世界中的表现。智谱公司展示了多个基于GLM-4.5原生能力构建的应用案例,如可交互的搜索引擎、社交媒体网站,以及Flappy Bird小游戏等。这些案例证明,GLM-4.5模型已经具备了相当程度的全栈开发和工具调用能力,能够理解需求并自主生成可运行、可交互的应用程序。

这些演示作为技术能力的验证是成功的,它们展示了GLM-4.5在智能体方向上的潜力。不过从功能演示到稳定可靠的生产级应用,仍然存在一段距离。在智谱公司自己公布的真实场景对比测试中,这一点也得到了反映。测试结果显示,GLM-4.5在编程任务中的表现优于其他参评的开源模型,尤其在工具调用的可靠性方面。但报告也同时指出,与顶尖的闭源模型Claude-4-Sonnet相比,GLM-4.5在提供近似效果的同时,仍存在一定的提升空间。

这种对比是对当前AI技术发展普遍现状的一种反应:顶尖的开源模型正在快速追赶,但在部分能力上与最前沿的闭源模型相比,尚有差距。智能体在开放环境中的稳定性、对模糊指令的理解能力、以及在遭遇未知情况时的纠错和适应能力,都是决定其真正成为“可靠的工具”的核心挑战。

智谱公司选择公开评测题目和Agent轨迹,邀请行业共同验证和改进,也体现了一种积极和开放的态度。GLM-4.5的发布,没有将重点放在参数规模的数字上,而是聚焦于智能体这一明确的应用方向,并通过技术优化和商业策略,为开发者社区提供了一个高性价比的基础平台。大模型行业正进入更加注重实际应用,更加注重成本效益,也更加注重开发者生态建设的阶段。接下来,GLM-4.5的市场表现,以及在其之上能诞生出多少创新的AI原生应用,将是检验其最终成功与否的关键。