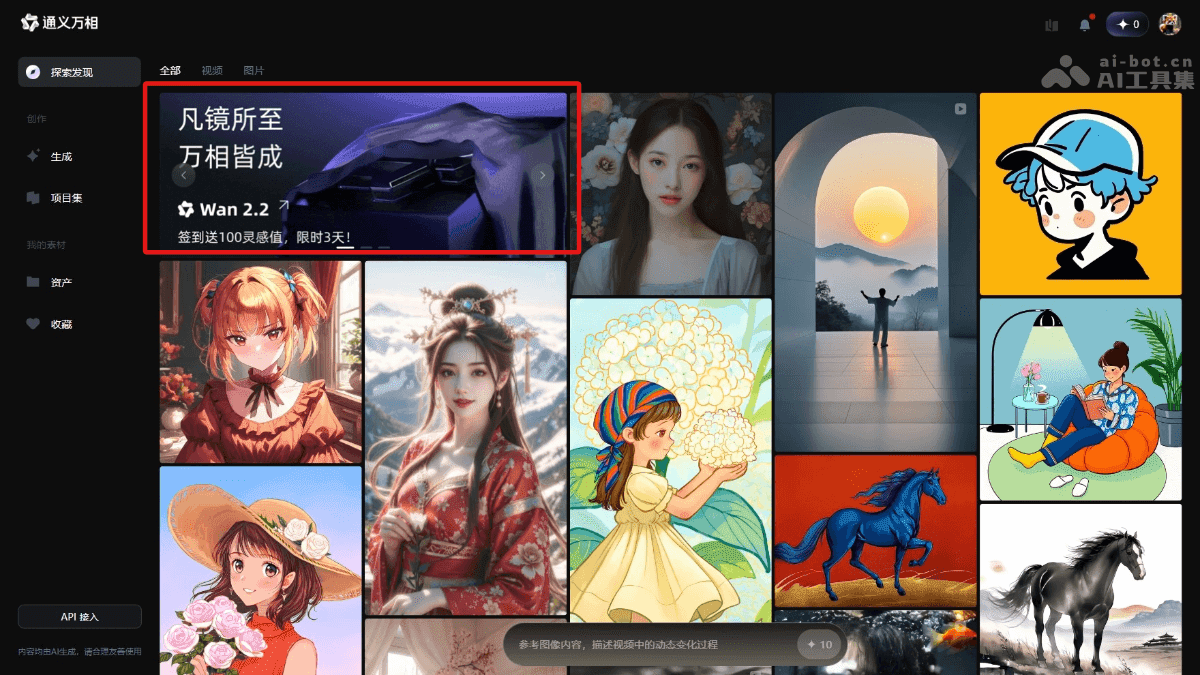

通义万相Wan2.2:阿里开源AI视频生成模型深度解析

在人工智能技术日新月异的今天,视频生成领域也迎来了新的突破。阿里巴巴开源的通义万相Wan2.2模型,以其强大的功能和创新技术,吸引了业界的广泛关注。本文将深入剖析通义万相Wan2.2的技术原理、功能特点、应用场景以及使用方法,为开发者和用户提供全面的了解。

通义万相Wan2.2的核心功能

通义万相Wan2.2作为一款先进的AI视频生成模型,其核心功能主要体现在以下几个方面:

文生视频(Text-to-Video)

文生视频是通义万相Wan2.2最基本也是最重要的功能之一。通过输入文本描述,模型能够智能地生成与之对应的视频内容。例如,当输入“一只猫在草地上奔跑”时,模型能够生成一段生动、自然的视频,展示猫在草地上奔跑的场景。这一功能极大地降低了视频创作的门槛,使得即使没有专业技能的用户也能轻松创作出高质量的视频内容。

图生视频(Image-to-Video)

图生视频功能允许用户通过上传一张图片,让模型根据图片的内容生成动态的视频场景。这一功能不仅能够让静态的图片“活”起来,还能为用户提供更多的创作灵感。例如,上传一张风景图片,模型可以生成一段微风拂过树梢、阳光洒在湖面的动态视频,极大地增强了图片的表现力。

统一视频生成(Text-Image-to-Video)

统一视频生成功能是通义万相Wan2.2的一大亮点。它能够同时结合文本描述和图片信息,生成更加精准、符合用户需求的视频内容。例如,用户可以上传一张猫的图片,并输入文本描述“一只可爱的猫在阳光下打盹”,模型便能生成一段猫在阳光下悠闲地打盹的视频。这种结合文本和图像的生成方式,大大提高了视频内容的准确性和丰富度。

电影级美学控制

通义万相Wan2.2还具备强大的电影级美学控制能力。通过对光影、色彩、构图等美学元素的精准控制,模型能够生成具有专业电影质感的视频。用户可以通过输入相关的关键词,如“暖色调”、“中心构图”等,来定制视频的美学风格。这一功能使得用户能够轻松创作出具有艺术感的视频作品。

复杂运动生成

除了静态场景的生成,通义万相Wan2.2还能生成复杂的运动场景和人物交互。这使得生成的视频更具动态表现力和真实感。无论是人物的奔跑、跳跃,还是物体之间的碰撞、摩擦,模型都能够逼真地模拟出来,从而提升视频的观赏性。

通义万相Wan2.2的技术原理

通义万相Wan2.2之所以能够实现如此强大的功能,离不开其背后的先进技术原理。

混合专家(MoE)架构

通义万相Wan2.2首次引入了混合专家(MoE)架构。MoE架构将模型分为高噪声专家和低噪声专家,其中高噪声专家负责视频的整体布局,低噪声专家负责细节的完善。这种分工合作的方式,能够在保持计算成本不变的情况下,大幅提升模型的参数量和生成质量。MoE架构的引入,是通义万相Wan2.2在视频生成领域的一大创新。

扩散模型(Diffusion Model)

扩散模型是通义万相Wan2.2的基础架构。扩散模型通过逐步去除噪声来生成高质量的视频内容。具体来说,模型首先将视频图像添加噪声,使其逐渐变为随机噪声,然后通过学习逆向过程,逐步从噪声中恢复出原始的视频图像。通过与MoE架构的结合,扩散模型能够进一步优化生成效果,提高视频的质量和逼真度。

高压缩率3D VAE

为了提高模型的效率,通义万相Wan2.2采用了高压缩率的3D变分自编码器(VAE)。3D VAE架构实现了时间、空间的高压缩比,使得模型能够在消费级显卡上快速生成高清视频。这一技术突破,降低了视频生成的硬件门槛,使得更多的用户能够体验到AI视频生成的乐趣。

大规模数据训练

模型的训练需要海量的数据支持。通义万相Wan2.2在大规模数据集上进行了训练,包括更多的图像和视频数据。这使得模型在多种场景下都具备了强大的泛化能力和生成质量。通过不断地学习和优化,模型能够更好地理解用户的需求,生成更加符合用户期望的视频内容。

美学数据标注

为了使生成的视频更具美感,通义万相Wan2.2基于精心标注的美学数据(如光影、色彩、构图等)进行训练。这使得模型能够生成具有专业电影质感的视频内容,满足用户对视频美学的定制需求。通过对美学元素的精准把握,模型能够创作出更具艺术价值的视频作品。

如何使用通义万相Wan2.2

使用通义万相Wan2.2非常简单,只需按照以下步骤操作:

- 访问官网或下载APP:用户可以通过访问通义万相的官方网站或下载通义APP进行体验。

- 选择模型:在模型选择下拉框中选择通义万相Wan2.2。

- 选择体验模式:

- 文生视频(Text-to-Video):输入文本描述,例如“一只猫在草地上奔跑”,点击生成按钮,即可看到生成的视频。

- 图生视频(Image-to-Video):上传一张图片,模型会根据图片内容生成动态视频。

- 统一视频生成(Text-Image-to-Video):结合文本描述和上传的图片,生成更精准的视频内容。

- 调整参数(可选):用户可以根据需要调整视频的分辨率、帧率等参数。利用电影级美学控制系统,通过输入关键词(如“暖色调”、“中心构图”)定制视频的美学风格。

- 查看生成结果:生成的视频会直接在网页上显示,用户可以下载或分享生成的视频。

通义万相Wan2.2的应用场景

通义万相Wan2.2的应用场景非常广泛,几乎涵盖了所有需要视频内容的领域。

- 短视频创作:短视频平台是目前最热门的社交媒体之一。通义万相Wan2.2可以帮助创作者快速生成吸引人的短视频内容,节省创作时间和成本,从而更好地在社交媒体平台上进行推广。

- 广告与营销:广告公司和品牌可以利用通义万相Wan2.2生成高质量的广告视频,提升广告效果和品牌影响力。通过对美学风格的定制,可以使广告视频更具吸引力,从而提高用户的购买欲望。

- 教育与培训:教育机构和企业可以利用通义万相Wan2.2生成生动的教育视频和培训材料,提升学习效果和培训质量。相比于传统的文字和图片,视频更具表现力,能够更好地吸引学生的注意力。

- 影视制作:影视制作团队可以利用通义万相Wan2.2快速生成场景设计和动画片段,提升创作效率,降低制作成本。通过对复杂运动的生成,可以使影视作品更具视觉冲击力。

- 新闻与媒体:新闻机构和媒体可以利用通义万相Wan2.2生成动画和视觉效果,增强新闻报道的视觉效果和观众参与度。通过对新闻事件的生动还原,可以使观众更好地理解新闻内容。

总结与展望

通义万相Wan2.2作为阿里巴巴开源的AI视频生成模型,以其强大的功能和创新技术,为视频创作领域带来了新的可能性。通过文生视频、图生视频、统一视频生成等功能,用户可以轻松创作出高质量的视频内容。而MoE架构、扩散模型、高压缩率3D VAE等技术,则为模型的性能提供了保障。随着人工智能技术的不断发展,相信通义万相Wan2.2将会在更多的领域得到应用,为人们的生活带来更多的便利和乐趣。