GLM-4.5:智谱AI打造的推理、代码与智能体原生融合开源模型

在人工智能领域,模型的能力边界不断被拓展。智谱AI最新推出的GLM-4.5,堪称是新一代旗舰模型的代表作,尤其在智能体应用方面表现突出。这款模型最大的亮点在于其原生融合了推理、代码和智能体能力,并且以开源的形式呈现,无疑为AI研究和应用打开了新的局面。

GLM-4.5并非孤军奋战,它拥有两个版本:GLM-4.5(3550亿参数,320亿激活)和GLM-4.5-Air(1060亿参数,120亿激活)。这种配置使得模型在性能和效率之间取得了良好的平衡。在各种评测基准中,GLM-4.5展现出了卓越的性能,尤其是在代码智能体场景中,更是达到了开源模型的顶尖水平。更值得一提的是,GLM-4.5支持混合推理模式,可以根据任务的复杂程度和响应时间的要求,灵活选择思考模式或非思考模式。

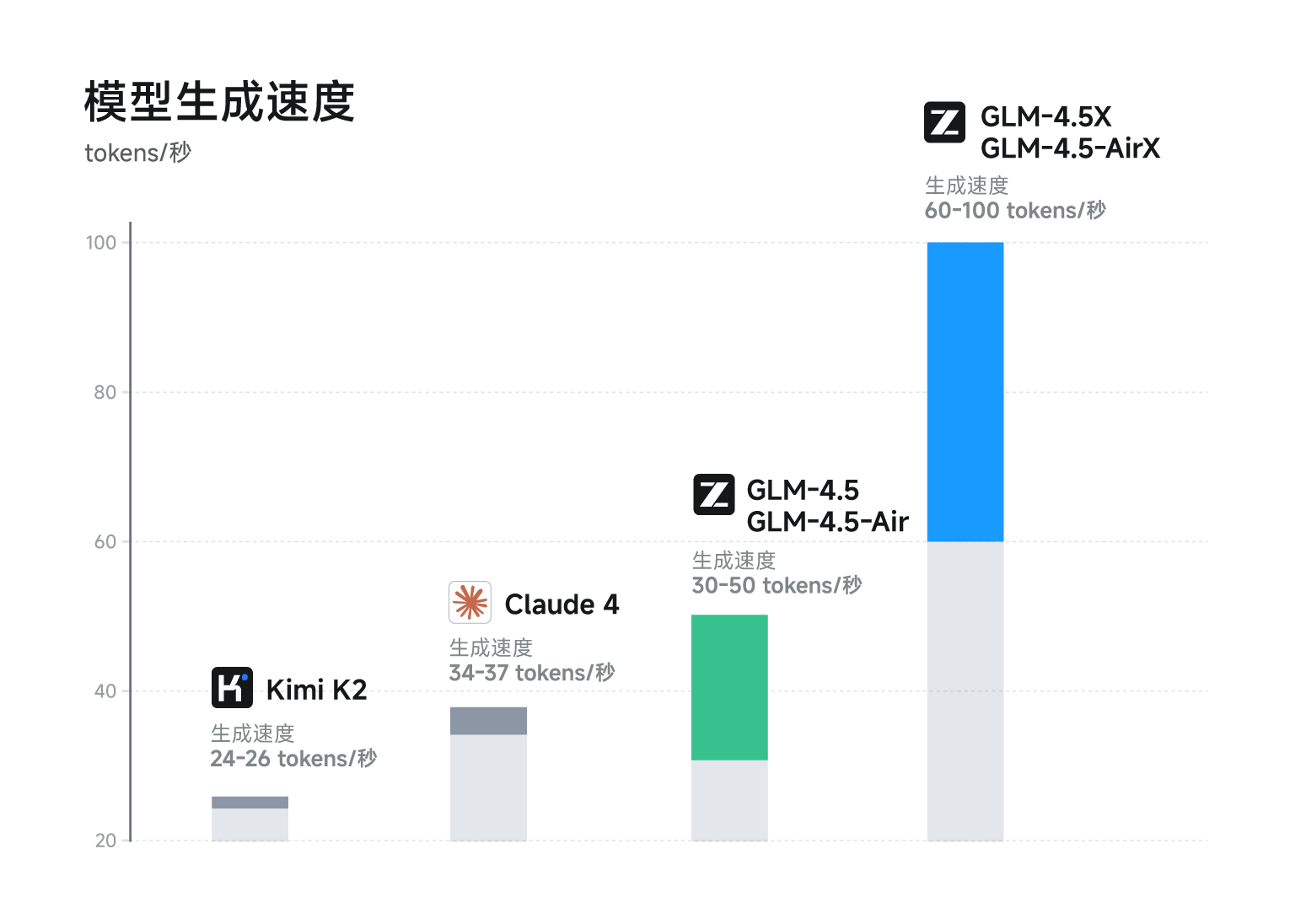

参数效率的提升是GLM-4.5的一大亮点,API价格仅为Claude的1/10,速度最快可达100tokens/秒,这无疑降低了使用成本,提高了响应速度。GLM-4.5率先在一个模型中实现了多能力的原生融合,例如推理、代码、智能体等能力。目前,用户已经可以在智谱清言和Z.ai平台上免费体验这款强大的模型。

GLM-4.5的核心优势

GLM-4.5之所以备受关注,在于其独特的技术特点和多方面的优势。

多能力融合:GLM-4.5首次在单个模型中实现了推理、代码生成和智能体能力的原生融合。这意味着,该模型可以更好地满足复杂智能体应用的需求,无需依赖多个模型的组合。

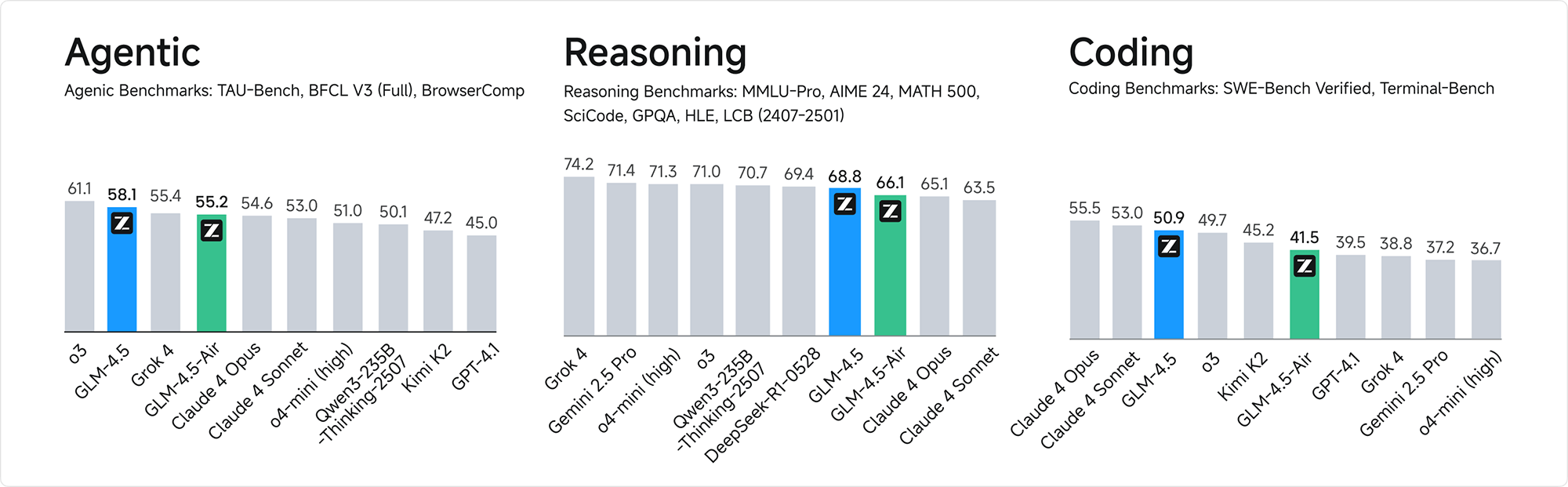

强大的推理能力:在多个推理评测基准中,GLM-4.5表现优异,能够胜任各种复杂的推理任务。无论是逻辑推理、常识推理还是数学推理,GLM-4.5都展现出了强大的实力。

高效的代码生成:GLM-4.5在代码生成和编程任务中表现出色,支持多种编程语言,并能够生成高质量的代码片段。无论是前端开发、后端开发还是全栈开发,GLM-4.5都能够胜任。

智能体应用:GLM-4.5支持工具调用、网页浏览等功能,可以无缝接入各种代码智能体框架,如Claude Code和Roo Code。这使得GLM-4.5在智能体任务中具有广泛的应用前景。

灵活的混合推理模式:GLM-4.5提供“思考模式”和“非思考模式”两种推理模式。思考模式适用于复杂推理和工具使用,模型会进行更深入的思考和推理,以生成更准确的结果。非思考模式适用于即时响应,模型会快速生成结果,满足低延迟的需求。这种混合推理模式兼顾了效率和性能,使得GLM-4.5在各种应用场景中都能够发挥出最佳效果。

GLM-4.5的技术亮点

GLM-4.5的技术亮点主要体现在以下几个方面:

混合专家(MoE)架构:GLM-4.5采用了混合专家(Mixture of Experts, MoE)架构,这是一种高效的模型扩展方法。MoE架构将模型参数划分为多个专家模块(Experts),在每个前向传播过程中动态选择部分专家进行激活,从而实现参数的稀疏激活。这种架构在保持模型强大表达能力的同时,显著降低了计算成本和内存占用。具体来说,GLM-4.5的总参数量为3550亿,激活参数为320亿;GLM-4.5-Air的总参数量为1060亿,激活参数为120亿。

多模态能力:GLM-4.5支持多模态输入和输出,能够处理文本、图像等多种数据类型。这使得模型能够更好地理解和生成复杂的智能体应用内容,例如在智能体任务中处理网页浏览、工具调用等多模态交互场景。多模态能力的加入,无疑为GLM-4.5的应用场景带来了更多的可能性。

混合推理模式:GLM-4.5提供了两种推理模式:思考模式(Thinking Mode)和非思考模式(Non-Thinking Mode)。思考模式适用于复杂推理和工具使用场景,模型会进行更深入的思考和推理,以生成更准确的结果。非思考模式适用于即时响应场景,模型会快速生成结果,满足低延迟的需求。这两种推理模式的结合,使得GLM-4.5在各种应用场景中都能够发挥出最佳效果。

高效的训练流程:GLM-4.5的训练流程包括三个阶段:通用数据预训练、针对性训练和强化学习优化。在通用数据预训练阶段,模型在15万亿token的通用数据上进行预训练,以学习语言和知识的基础表示。在针对性训练阶段,模型在代码、推理、智能体等领域的8万亿token数据上进行针对性训练,以增强模型在特定任务上的表现。在强化学习优化阶段,通过强化学习进一步优化模型的推理、代码生成和智能体能力,以提升模型在实际应用中的表现。这种精细化的训练流程,保证了GLM-4.5在各种任务中都能够表现出色。

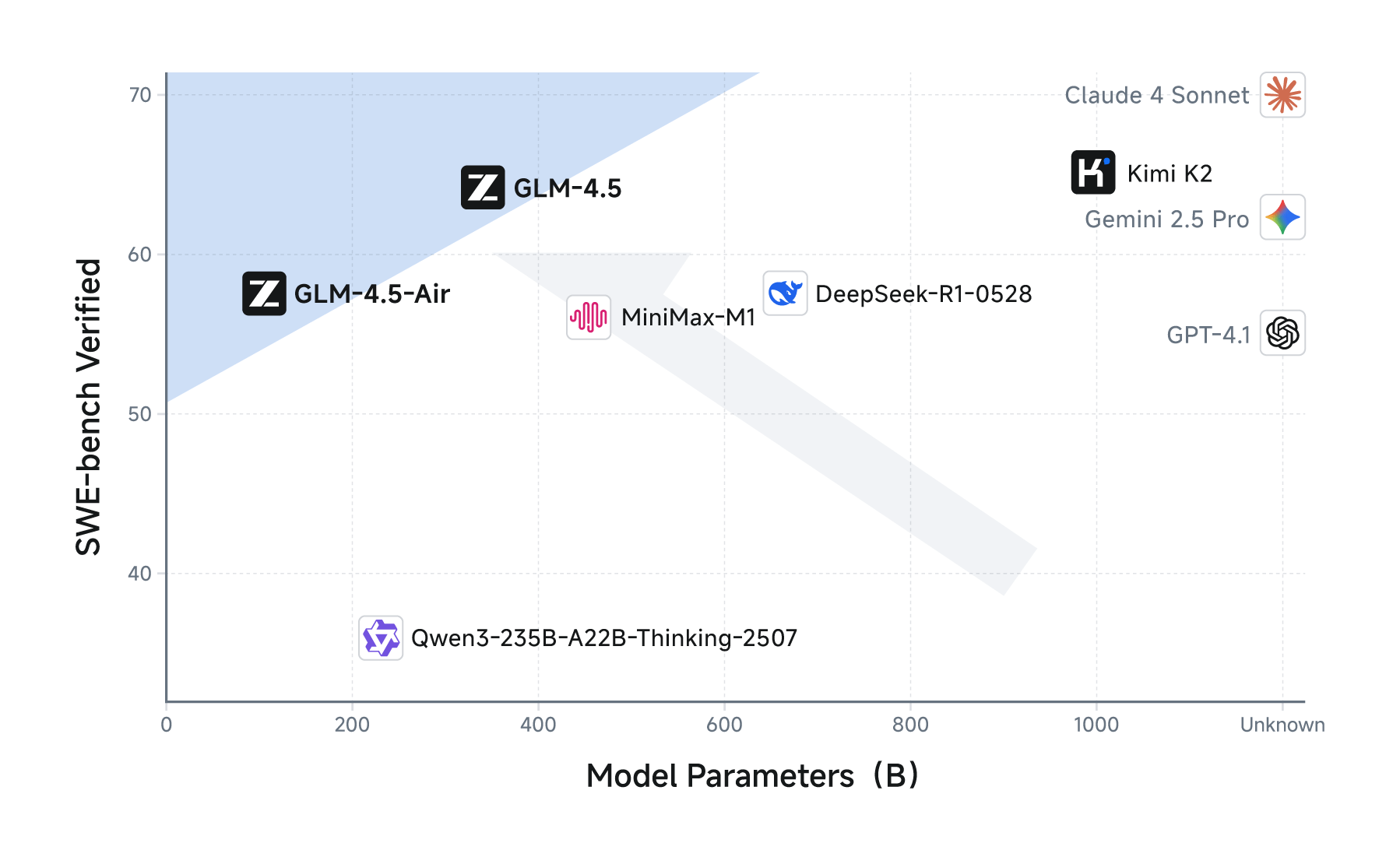

参数效率优化:GLM-4.5在参数效率上实现了显著提升。尽管参数量仅为DeepSeek-R1的1/2和Kimi-K2的1/3,但在多项标准基准测试中表现更为出色。例如,在100B总参数 – 10B激活参数规模的模型系列中,GLM-4.5在Artificial Analysis基准测试中的推理性能媲美甚至超越了其他国际顶级模型。这充分说明了GLM-4.5在参数利用率方面的优势。

GLM-4.5的技术指标

GLM-4.5在多个技术指标上都表现出色,以下是一些关键指标:

- 综合性能SOTA:在最具代表性的12个评测基准(包括MMLU Pro、AIME 24、MATH 500、SciCode、GPQA 、HLE、LiveCodeBench、SWE-Bench Verified、Terminal-Bench、TAU-Bench、BFCL v3 和BrowseComp)的综合平均分中,GLM-4.5取得了全球模型第三、国产模型第一、开源模型第一的优异成绩。这充分证明了GLM-4.5在综合性能方面的领先地位。

- 更高的参数效率:GLM-4.5的参数量仅为DeepSeek-R1的1/2、Kimi-K2的1/3,但在多项标准基准测试中表现得更为出色,这得益于GLM模型的更高参数效率。在衡量模型代码能力的SWE-bench Verified榜单上,GLM-4.5系列位于性能/参数比帕累托前沿,这表明在相同规模下,GLM-4.5系列实现了最佳性能。这意味着,用户可以使用更少的计算资源,获得更高的性能。

- 低成本、高速度:在性能优化之外,GLM-4.5系列也在成本和效率上实现突破,API调用价格低至输入0.8元/百万tokens,输出2元/百万tokens。同时,高速版本实测生成速度最高可至100 tokens/秒,支持低延迟、高并发的实际部署需求,兼顾成本效益与交互体验。这使得GLM-4.5在实际应用中具有更高的性价比。

如何使用GLM-4.5

目前,用户可以通过多种方式使用GLM-4.5:

体验平台

智谱清言 (chatglm.cn):用户可以直接访问智谱清言平台,免费体验GLM-4.5的满血版功能。用户可以进行对话生成、代码生成、推理任务等多种操作,感受模型的强大能力。

Z.ai:用户也可以通过Z.ai平台体验GLM-4.5的功能。

API 调用

- BigModel.cn:智谱AI提供了API接口,用户可以通过BigModel平台进行API调用。API接口支持多种功能,包括文本生成、代码生成、推理任务等。通过API调用,用户可以将GLM-4.5集成到自己的应用中,实现更强大的功能。

GLM-4.5的模型定价

GLM-4.5的API调用价格非常具有竞争力,低至输入0.8元/百万tokens、输出2元/百万tokens。同时,生成速度最高可达100 tokens/秒,支持低延迟和高并发部署。这种低成本、高效率的特点,使得GLM-4.5在各种应用场景中都具有很高的性价比。

GLM-4.5的应用场景

GLM-4.5的应用场景非常广泛,以下是一些典型的应用场景:

全栈开发任务:GLM-4.5能够胜任复杂的全栈开发任务,支持编写较为复杂的应用、游戏、交互网页等。无论是前端代码、后端代码还是数据库设计,GLM-4.5都能够提供强大的支持。

代码生成:GLM-4.5在代码生成方面表现出色,能够生成高质量的代码片段,支持多种编程语言。可以帮助开发者快速生成代码框架、修复代码错误、优化代码结构等。这大大提高了开发效率,降低了开发成本。

编程辅助:GLM-4.5可以作为编程辅助工具,提供代码补全、代码生成建议、代码注释等功能,提高开发效率。通过与IDE的集成,GLM-4.5可以为开发者提供实时的代码建议,帮助开发者编写更高效、更可靠的代码。

内容生成:GLM-4.5可以生成各种类型的内容,如文章、新闻报道、创意文案等,适用于内容创作、文案撰写等场景。无论是长篇文章、短文案还是社交媒体帖子,GLM-4.5都能够生成高质量的内容,满足用户的需求。

学术研究:GLM-4.5可以用于学术研究,帮助研究人员探索自然语言处理、人工智能等领域的前沿问题。通过GLM-4.5,研究人员可以更方便地进行实验、验证理论,推动人工智能领域的发展。

总而言之,GLM-4.5的出现,为人工智能领域带来了新的活力。其强大的性能、高效的参数利用率、广泛的应用场景以及具有竞争力的价格,都使得GLM-4.5成为备受关注的焦点。相信在不久的将来,GLM-4.5将在各个领域发挥出更大的作用,为人类带来更多的便利。