在人工智能飞速发展的今天,我们常常惊叹于其在内容生成、数据分析等方面的强大能力。然而,当AI的触角伸向过去,能否为我们重现历史的真实面貌?宾夕法尼亚州穆伦堡学院的计算机科学学生Hayk Grigorian的实验,为我们提供了一个意想不到的答案。他所构建的“时间胶囊大语言模型”(TimeCapsuleLLM),在没有任何明确历史输入的情况下,竟成功“回忆”并描述了1834年伦敦的真实抗议活动,这一发现被戏称为“事实偶得”(factcident),深刻揭示了AI在历史重建领域的巨大潜力。

“时间胶囊”模型的构建与突破

Hayk Grigorian的项目始于对维多利亚时代英语的浓厚兴趣。他并非旨在训练一个现代化的AI,而是希望其能够以19世纪初至中期(1800-1875年)的伦敦口吻进行交流。为此,他采集了超过7000本图书、法律文献和报纸作为训练数据,总计约6.25GB,并开发了“选择性时间训练”(Selective Temporal Training, STT)方法。与主流AI模型基于现代文本进行微调不同,Grigorian从零开始构建模型,确保其语言体系不受现代词汇污染。他甚至设计了定制化的分词器,排除所有现代词汇,使模型真正“沉浸”在维多利亚时代的语言环境中。

这一独特策略的背后,是对语言模型本质的深刻理解。如果仅仅对像GPT-2这样的预训练模型进行微调,其固有的现代知识结构将难以彻底清除,无法实现纯粹的“时间穿越”效果。而从头训练,则确保了模型所习得的语言和知识完全源自特定历史时期,如同一个数字化的考古学家,从浩瀚的历史文本碎片中拼凑出过去的图景。

Grigorian的TimeCapsuleLLM项目并非孤例,它与近年来兴起的“历史大语言模型”(HLLMs)研究不谋而合。例如,MonadGPT能够基于1400至1700年间的文本,以17世纪的知识框架探讨各种议题;而XunziALLM则致力于生成符合古代格律的古典中文诗歌。这些前沿研究共同指向一个宏伟目标:利用AI技术,让历史文本“开口说话”,重现不同历史时期的语言模式、思想体系乃至社会风貌。

意外的“时间旅行”:1834年的伦敦回响

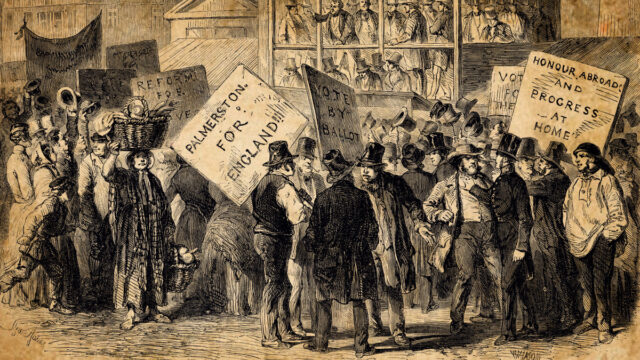

TimeCapsuleLLM最令人称奇的输出,源于一次看似简单的测试。当Grigorian输入“那是我们的主1834年”(It was the year of our Lord 1834)时,模型自动生成了一段详细描述:

“那是我们的主1834年,伦敦的街道上充满了抗议和请愿。原因正如许多人所复述的,并非局限于私人事务,而是在帕默斯顿勋爵就职当天就已出现,公众将收到一份关于我们所面临的法律困境的简短声明。令人深感遗憾的是,世界历史上的当前事件清晰可见,因此将会为人所知。并非那些最初在耶路撒冷传播福音的人,理应拥有如此广泛和有趣的繁荣与兴盛记录。”

这段由AI生成的文本,立即引起了Grigorian的兴趣。他通过谷歌搜索进行事实核查后,惊喜地发现AI提及的细节与历史高度吻合:1834年,英国确实因《1834年济贫法修正案》的颁布而引发了大规模的公民骚乱。而文本中提到的“帕默斯顿勋爵”(Lord Palmerston),在这一动荡时期恰好担任英国外交大臣,后来更成为首相。

重要的是,Grigorian强调自己并未刻意训练模型识别或记录1834年的抗议事件。AI是通过从6.25GB的维多利亚时代文本中学习到的零散模式,自行将特定年份与真实事件和人物关联起来。这种从海量非结构化数据中重构连贯历史瞬间的能力,无疑超越了简单的文本拼接,展现出AI深层次的“理解”与“推理”潜力。Grigorian感叹:“这仅仅来自5-6GB的数据。想象一下如果数据量达到30GB或更多,结果会怎样?我不敢确定单纯增加数据是否能带来真正的推理能力,但即便如此,现在它已经有点像数字时间旅行了。”

统计学驱动的语言时间旅行

Grigorian的TimeCapsuleLLM并非一蹴而就。他利用nanoGPT和微软的Phi 1.5等小型语言模型架构,循序渐进地训练了三个版本:

- 版本0:仅基于187MB数据训练,输出的只是带有维多利亚风格的乱码。

- 版本0.5:实现了语法正确的时代散文,但在事实层面仍存在严重的“幻觉”(hallucination)现象,即生成虚构的信息。

- 当前7亿参数版本:在租用的A100 GPU上训练,已经能够生成具有历史参考价值的文本,例如1834年伦敦抗议的细节。

随着训练数据质量和规模的提升,模型的“幻觉”现象显著减少,对事实的记忆能力逐渐增强。这印证了AI研究领域的一个普遍规律:数据规模的扩展,尤其是在高质量数据上的扩展,对于提升模型的准确性和减少错误信息至关重要,即使是小型模型也不例外。Hayk Grigorian在GitHub上指出:“早期模型(v0和v0.5)可以模仿19世纪的写作风格,但总是会编造事件、人物和事实。这表明模型开始从数据集中记住事物了。”这种从“幻觉”到“事实偶得”的演变,是AI能力提升的关键里程碑。

对历史学和数字人文的深远意义

Hayk Grigorian的实验为历史学家和数字人文研究者提供了新的视角和工具。通过在特定时期文本上训练AI语言模型,我们可以构建出能够模拟特定历史时期语言模式的互动模型。这些模型虽然可能无法达到百分之百的事实严谨性,因为“幻觉”问题仍是当前AI的挑战,但它们在风格上无疑是极具启发性的。研究人员可以借此深入探讨古老的句法结构、词汇使用习惯,甚至感受特定时代人们的表达方式和思维逻辑。

想象一下,一位历史学者可以与一个“维多利亚时代人”进行对话,了解那个时代人们对社会变革、科学发现或日常生活的看法。这不仅仅是文本分析,更是对历史场景的沉浸式体验。它为我们提供了一个全新的窗口,去理解那些已经消逝的语言和文化。通过AI的重建,那些尘封已久的古籍和文献,或许能以一种全新的、互动的方式,再次鲜活起来。

Grigorian的愿景不止于此,他计划尝试构建更多不同城市、不同文化背景下的历史AI模型,例如中国、俄罗斯或印度的城市模型,并公开代码、模型权重和文档,邀请全球研究者共同参与。这种开放协作的精神,将加速历史AI领域的发展,共同探索“数字时间旅行”的无限可能。在AI“幻觉”频发的时代,一个能够偶然揭示历史真相的模型,无疑为我们带来了新的思考——这不仅仅是“纠错”,更是一种由数据驱动的“历史回响”,为我们理解AI与历史的交织关系,打开了新的篇章。

总结而言,Hayk Grigorian的TimeCapsuleLLM项目,通过严格的“选择性时间训练”和逐步扩大的高质量数据集,展现了小型AI模型在历史文本分析与重建方面的惊人能力。它证明了AI不仅仅是未来的工具,也能够成为连接过去与现在的桥梁,让那些沉默已久的历史以全新的方式向我们诉说。这种“事实偶得”的现象,促使我们重新审视AI的“记忆”与“理解”边界,也预示着数字人文领域将迎来一场深刻的变革。未来的历史研究,或许将不再局限于传统文献的解读,而能通过AI模拟,与历史进行一场跨越时空的“对话”。