当前,人工智能(AI)技术以前所未有的速度发展,正深刻地重塑着全球经济、社会乃至地缘政治格局。随着AI能力的日益强大,其潜在的应用范围也随之拓宽,从效率提升到国家安全,无所不包。然而,这种 transformative 力量并非没有风险。在国际局势复杂多变、大国竞争日益加剧的背景下,领先的AI技术提供商正面临严峻挑战,尤其是在确保其尖端技术不被滥用,并符合其核心价值观方面。为了应对这些挑战,越来越多的AI公司开始审慎评估并强化其服务在特定区域的销售限制,这标志着全球AI治理进入了一个新的阶段。

地缘政治背景下的AI技术壁垒

AI技术的战略价值使其成为地缘政治博弈的焦点。国家间的竞争已不仅仅是经济或军事层面的对抗,更延伸到科技主导权的争夺,其中AI技术无疑是核心。一些国家视AI为未来军事、情报、网络安全以及社会治理的关键工具。因此,确保本国AI技术的领先性,同时阻止竞争对手获取或利用本国技术,成为各国政府和科技公司的共同目标。

AI技术在未经授权或监管不力的区域使用,可能带来多重国家安全风险:

- 数据安全与情报收集:某些国家可能通过强制性法律要求,迫使在其境内运营或受其控制的企业共享敏感数据,或与情报机构合作。这使得存储在AI系统中的用户数据、训练数据乃至模型本身面临泄露的风险,可能被用于情报收集、渗透甚至战略分析。

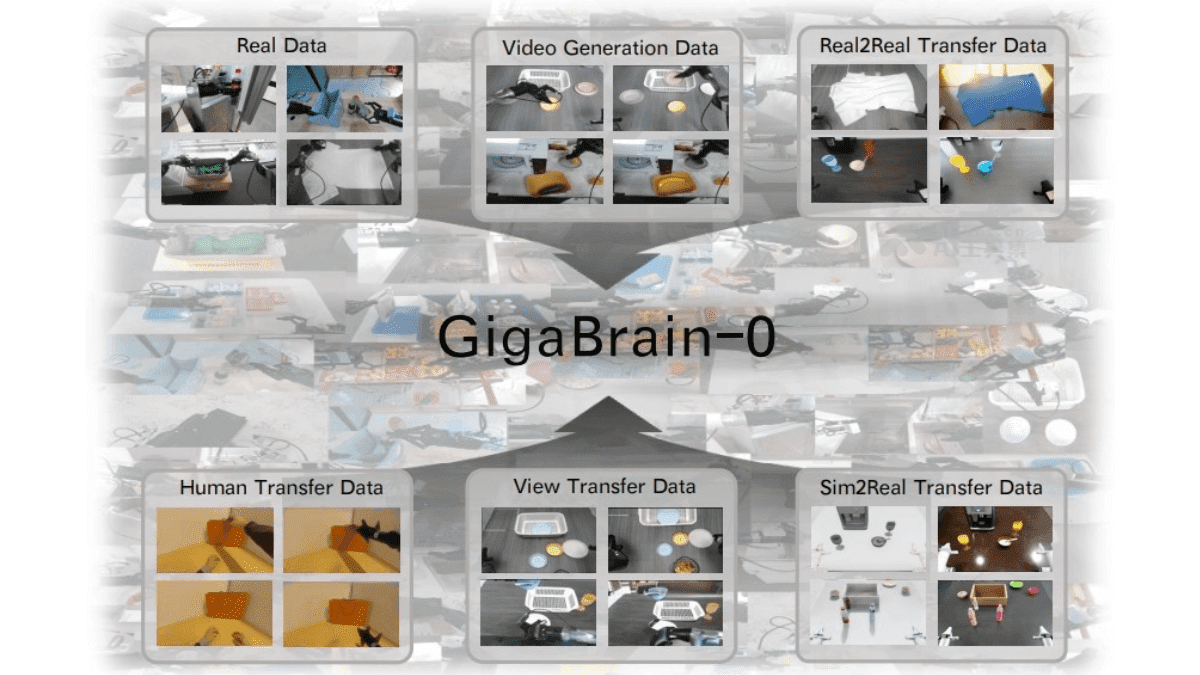

- 技术“蒸馏”与逆向工程:领先的AI模型和算法是经过巨额投资和长时间研发的成果。若这些模型在受控区域被广泛使用,即使是简单的API访问,也可能被不法实体用于“蒸馏”其核心技术,即通过分析模型的输出行为来逆向推导出其内部工作机制或训练数据特征,从而加速自身AI技术的发展,绕过研发投入。

- 军事与监控应用:强大的AI能力可能被用于开发先进的军事武器、大规模监控系统或网络攻击工具。若这些技术落入对立或非民主政权手中,可能助长威权主义,甚至对全球和平与稳定构成威胁。

- 竞争优势削弱:允许受限制区域的实体无限制地访问先进AI服务,无异于将自身多年积累的竞争优势拱手相让。这些实体可能利用所获取的技术,在全球市场上与西方科技公司展开不公平竞争,进而削弱创新生态系统的健康发展。

规避行为与识别挑战

尽管AI公司设定了明确的服务限制区域,但实际操作中仍面临诸多规避手段。最常见的一种便是通过在非限制区域设立子公司或合资企业来获取服务。这些子公司在表面上遵守当地法律,但其最终控制权、股权结构或运营决策可能仍然受到母公司所在地的影响。

这种复杂的控制权结构带来了巨大的识别挑战:

- 股权追溯的复杂性:跨国股权结构层层嵌套,追踪最终受益人或实际控制方往往极为困难。这使得AI公司难以有效识别那些表面上位于支持区域,但实际由受限区域实体控制的公司。

- 法律与监管套利:一些实体可能利用不同国家间法律和监管体系的差异,进行“套利”。例如,在数据隐私、出口管制或国家安全审查相对宽松的国家注册公司,以获取受限技术。

- 技术供应链中的渗透:AI技术研发与应用涉及庞大的供应链,从硬件、软件到数据服务,环环相扣。受限区域的实体可能通过投资、合作或收购等方式,渗透到供应链的各个环节,间接获取敏感技术或数据。

为了应对这些规避行为,AI服务提供商不得不采取更严格的措施,例如将限制范围扩大到那些股权结构显示其受控于非支持区域实体的公司,即便这些公司注册地在支持区域。这通常意味着超过一定股权比例(如50%)的直接或间接所有权,都将触发服务限制。

行业应对与政策建议

面对日益严峻的风险,AI行业和政府机构正共同探索多方面策略,以确保AI技术的发展能够真正服务于民主利益和战略安全:

强化服务限制与合规审查

- 透明化股权结构:AI公司需要投入更多资源,建立更完善的客户尽职调查体系,要求客户披露其详细的股权结构和最终控制方信息,以识别潜在的风险实体。

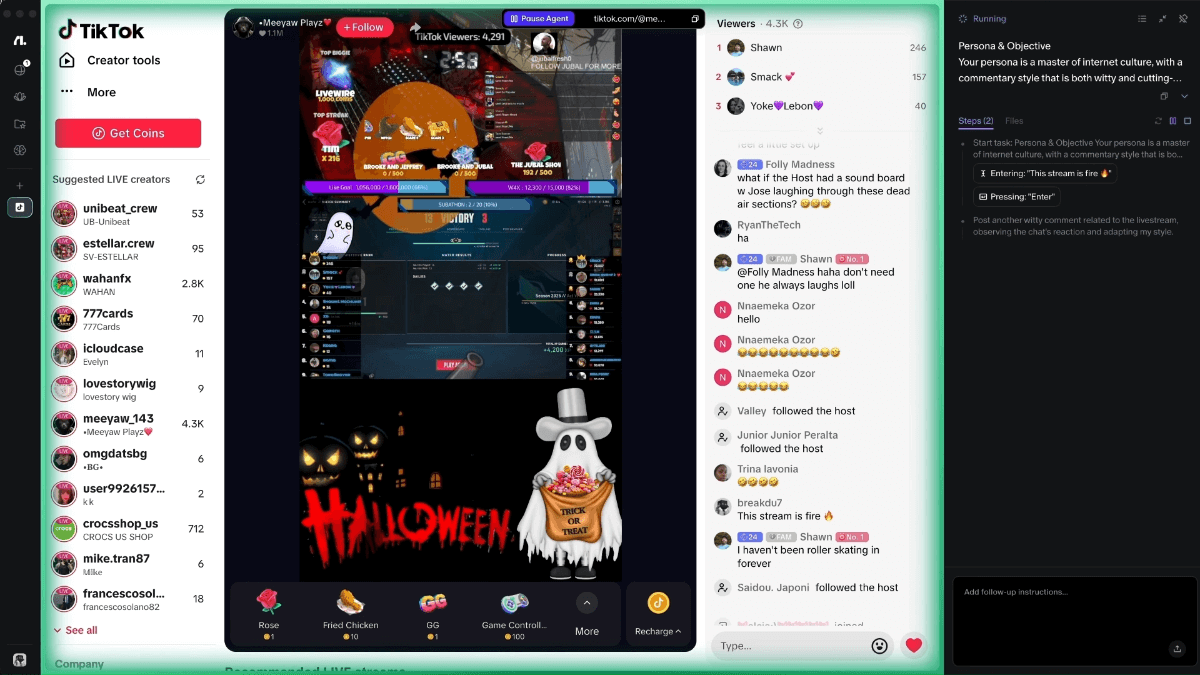

- 行为模式分析:除了股权结构,还需结合客户的实际业务行为、数据使用模式以及地理位置信息,进行综合风险评估。例如,若一家位于支持区域的公司,其绝大部分数据流向或服务最终使用者集中在受限区域,则应引起警惕。

- 持续监控与迭代:鉴于地缘政治和技术威胁的动态变化,AI公司需要建立持续的监控机制,并定期审查和更新其服务限制政策,确保其始终与现实风险保持一致。

推动出口管制与技术保护

政府层面,加强对前沿AI技术和相关基础设施的出口管制至关重要。这包括:

- 明确的出口管制清单:建立并持续更新关键AI技术、模型、芯片及相关软件的出口管制清单,防止其未经授权地流向战略竞争对手。

- 国际合作与协调:与盟友国家加强合作,协调出口管制政策,形成统一战线,堵塞漏洞,防止技术通过第三方国家被转让。

- 投资国内AI基础设施:加速本国在AI计算能力、数据中心、能源供应等方面的基础设施建设,确保关键AI能力掌握在自己手中,降低对外部依赖。

模型安全与伦理评估

- 严格的模型安全评估:对AI模型进行系统性的安全风险评估,识别其潜在的滥用风险,特别是可能被用于生成有害内容、进行网络攻击或增强军事能力的潜在路径。

- 构建安全沙盒环境:在受控环境中对高风险AI模型进行测试和验证,模拟潜在的攻击场景和滥用模式,提前发现并缓解风险。

- 行业标准与最佳实践:推动AI行业制定统一的安全标准、伦理准则和最佳实践,促进负责任的AI创新。

深远影响与未来展望

AI服务限制的加强无疑将对全球AI生态系统产生深远影响:

- 全球AI格局重塑:可能加速形成以地缘政治联盟为基础的“AI阵营”,导致全球AI技术生态系统出现碎片化或“脱钩”的趋势。这将促使各国加速构建自己的独立AI产业链和生态系统。

- 创新速度与合作模式:短期内,这可能阻碍全球范围内的技术合作和知识流动,影响AI创新的速度。但长期来看,这也可能刺激各国在内部加速创新,寻求自主可控的发展路径。

- 伦理与价值观的冲突:这种限制政策不仅是技术和经济的考量,更是价值观和治理模式冲突的体现。AI公司在作出此类决策时,需要在商业利益、国家安全和普世伦理之间找到平衡点。

- 负责任AI的集体承诺:AI的未来发展,需要所有参与者共同承诺,防止其被用于对抗民主价值观或威胁人类福祉的目的。负责任的AI公司有义务采取果断行动,确保变革性技术服务于美国及其盟友的战略利益,并支持民主价值观。

人工智能技术的发展正站在一个关键的历史节点。如何平衡创新与安全、开放与控制,是全球共同面临的挑战。通过加强服务限制、推动出口管制、完善安全评估以及深化国际合作,我们才能确保AI的强大力量被引向正途,为构建一个更安全、更繁荣、更民主的未来贡献力量。这将是一场持续的努力,需要行业、政府和国际社会共同担当,携手前行。