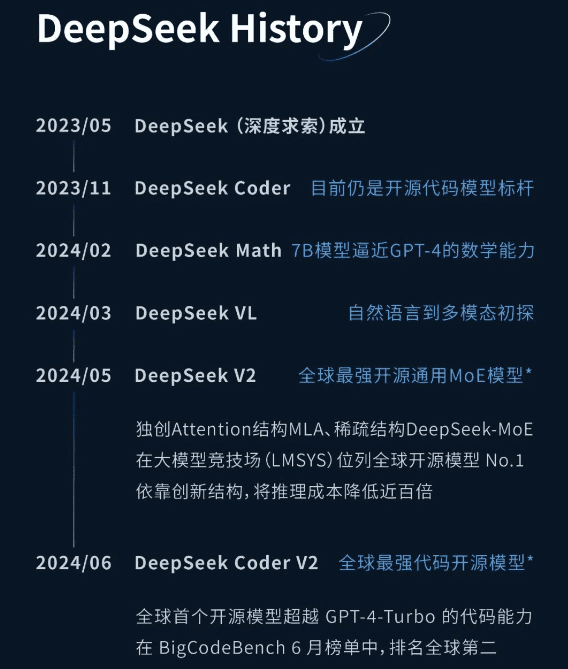

2024年岁末,DeepSeek震撼发布了其最新一代大型语言模型——DeepSeek-V3。这不仅仅是DeepSeek在探索通用人工智能(AGI)道路上的又一关键里程碑,更再次确立了其在开源AI领域的领军地位。短短数月,DeepSeek完成了从V2.5的通用与代码能力融合到V3的全面性能飞跃,这背后蕴藏着怎样的技术突破和战略思考?

DeepSeek的初心:探索AGI的本质

DeepSeek始终秉持着“投身于探索AGI的本质,不做中庸的事,带着好奇心,用最长期的眼光去回答最大的问题”的理念。这种长期主义的追求,驱动着DeepSeek在技术研发上不断突破。从V2.5的通用与代码能力融合,到V3的全面性能提升,每一步都彰显了其对技术创新的执着。DeepSeek的愿景并非仅仅是构建一个强大的AI模型,而是真正理解并实现通用人工智能,这需要对AI的底层逻辑和发展方向有深刻的洞察。

从V2.5到V3:性能的全面飞跃

DeepSeek-V3是一款拥有惊人6710亿参数的混合专家模型(MoE),激活370亿参数,并基于14.8T token的庞大数据集进行预训练。这种规模的模型设计,旨在模拟人脑的复杂结构,从而实现更高级的智能功能。与V2.5相比,V3的生成速度提升了3倍,从20TPS跃升至60TPS。这意味着用户可以更快地获得AI的响应,极大地提升了使用体验。这种速度的提升,得益于DeepSeek在模型架构和训练方法上的创新。

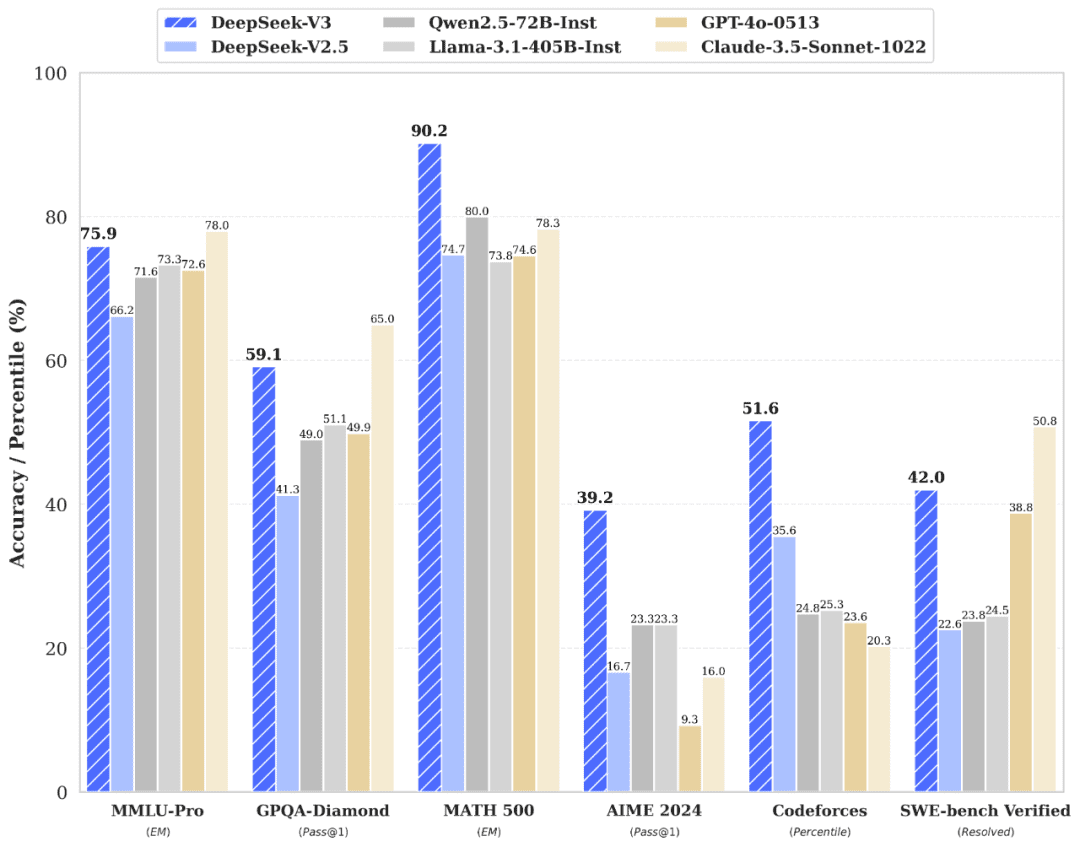

在性能方面,DeepSeek-V3在多项基准测试中超越了Qwen2.5-72B和Llama-3.1-405B等一众开源模型,并与GPT-4和Claude-3.5-Sonnet等顶尖闭源模型不相上下。尤其在数学、代码和中文任务上,V3表现尤为突出,成为当前最强的开源模型。这意味着DeepSeek-V3不仅在通用能力上表现出色,还在特定领域具有更强的专业性。这种卓越的性能,使得DeepSeek-V3在各种实际应用中都能发挥重要作用。

技术创新:高效训练与推理

DeepSeek-V3采用了多项创新技术,包括多头潜在注意力(MLA)架构、无辅助损失的负载均衡策略以及多token预测(MTP)目标。这些技术不仅提升了模型的推理效率,还大幅降低了训练成本。MLA架构允许模型在处理信息时更加关注重要的部分,从而提高效率。无辅助损失的负载均衡策略,则确保了模型的各个部分都能得到充分的训练,避免出现性能瓶颈。MTP目标则让模型能够一次性预测多个token,进一步提升了生成速度。令人瞩目的是,V3的整个训练过程仅耗费了278.8万H800 GPU小时,总成本约为557.6万美元,远低于其他前沿大模型。这表明DeepSeek在模型训练方面具有卓越的效率和成本控制能力。

API服务:价格调整与优惠

随着V3的发布,DeepSeek调整了API服务价格。在优惠期内(即日起至2025年2月8日),API价格为每百万输入tokens 0.1元(缓存命中)/1元(缓存未命中),每百万输出tokens 2元。优惠期结束后,价格将恢复至每百万输入tokens 0.5元(缓存命中)/2元(缓存未命中),每百万输出tokens 8元。这种定价策略旨在吸引更多的开发者使用DeepSeek-V3,并推动其在各个领域的应用。

| 时期 | Token类型 | 缓存命中 | 缓存未命中 |

|---|---|---|---|

| 优惠期内(至2025年2月8日) | 输入tokens(每百万) | ¥0.1 | ¥1 |

| 输出tokens(每百万) | ¥2 | ¥2 | |

| 优惠期后 | 输入tokens(每百万) | ¥0.5 | ¥2 |

| 输出tokens(每百万) | ¥8 | ¥8 |

应用场景:多轮对话与功能调用

DeepSeek-V3支持多轮对话、对话前缀续写、FIM补全、JSON输出及Function Calling等功能。这些功能在以下场景中具有广泛应用:

- 多轮对话:适用于客服、教育等需要连续交互的场景。在这些场景中,AI需要能够理解用户的意图,并根据上下文进行回复。DeepSeek-V3的多轮对话能力,使得AI能够更好地完成这些任务。

- 对话前缀续写:用于文本生成、创作辅助等任务。这种功能可以帮助用户快速生成文章、故事等文本内容,极大地提升了创作效率。

- FIM补全:在代码生成和文本补全中表现优异。FIM(Fill In Middle)补全技术,可以让AI根据已有的代码或文本,自动补全缺失的部分。这在代码编写和文本编辑中非常有用。

- JSON输出与Function Calling:为开发者提供了灵活的接口调用方式,适用于自动化任务和复杂逻辑处理。JSON输出可以让AI以结构化的方式返回数据,方便开发者进行处理。Function Calling则允许AI调用外部函数,从而实现更复杂的功能。

开源与社区支持

DeepSeek-V3不仅开源了原生FP8权重,还提供了BF16转换脚本,方便社区适配和应用。SGLang、LMDeploy、TensorRT-LLM等工具已支持V3模型推理,进一步降低了用户的使用门槛。这种开源策略,旨在吸引更多的开发者参与到DeepSeek-V3的生态建设中来,共同推动AI技术的发展。

DeepSeek-V3的实际应用

1. 官方对话平台体验

DeepSeek-V3对话已在官网上线,用户可以通过chat.deepseek.com直接体验。这个平台提供了一个方便快捷的方式,让用户可以亲身体验DeepSeek-V3的强大功能。

2. API能力与开发接入

DeepSeek API 接口,支持以下功能:

- 多轮对话能力

- 对话前缀续写(Beta)

- FIM(Fill In Middle)补全

- 结构化输出 JSON output

- 多语言支持

开发者可以通过API文档了解详细的接入方式和示例代码:api-docs.deepseek.com。DeepSeek API为开发者提供了一个灵活的方式,可以将DeepSeek-V3的功能集成到自己的应用中。

DeepSeek-V3的发布,无疑为人工智能领域注入了新的活力。它不仅在技术上取得了显著的突破,还在开源和社区支持方面做出了积极的贡献。DeepSeek的长期主义精神和对AGI本质的探索,值得我们敬佩和学习。

随着人工智能技术的不断发展,我们有理由相信,DeepSeek将会在未来的AGI探索道路上取得更大的成就,为人类带来更多的福祉。