2025年10月10日-12日,2025上海国际智家生活博览会在上海新国际博览中心盛大启幕。本届博览会由"ACE 2025 第七届人工智能应用产业博览会"和"KIB 2025中国国际厨卫家居博览会"战略融合升级而成,以"All in AI

AI重塑家居生态:2025上海智家博览会引领行业新风向

0

最新文章

最新文章

SAM 3D:Meta革新3D生成领域的开源模型解析

8小时前

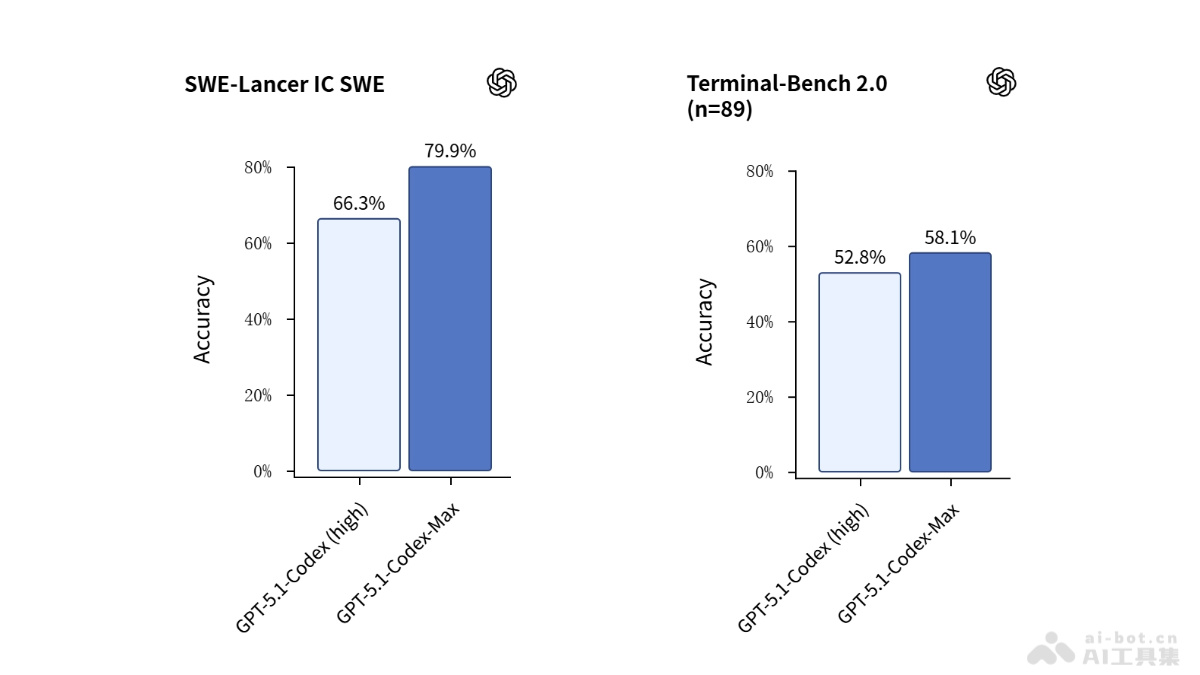

GPT-5.1-Codex-Max:OpenAI智能编程模型的革命性突破

8小时前

SAM 3:Meta开源视觉分割模型如何重塑计算机视觉未来

8小时前

PinMe:开源静态网站部署工具,实现永久托管与零成本分享

8小时前

Seekdb:AI原生混合搜索数据库如何革新多模态数据处理

8小时前

Nano Banana Pro:谷歌图像生成技术的革命性突破

8小时前

腾讯HunyuanVideo 1.5:8B参数轻量级视频生成模型的革命性突破

8小时前

MiMo-Embodied:小米跨领域具身大模型的技术突破与应用前景

8小时前

Supertonic:开源离线TTS系统如何重塑语音合成技术

8小时前

AI监管与突破:2025年内容创作与安全的双重变革

8小时前