近年来,人工智能系统在生物学领域,特别是蛋白质结构与功能关系方面取得了显著成就。这些成就包括预测大多数蛋白质结构以及设计具有特定功能的蛋白质。然而,所有这些努力都集中在蛋白质本身以及构成它们的氨基酸上。

但生物学并非在蛋白质层面生成新蛋白质,而是需要先在核酸酸层面发生变化,最终才通过蛋白质体现出来。DNA层面的信息与蛋白质之间存在相当大的距离,包含大量关键的非编码序列、冗余性和一定程度的灵活性。因此,学习基因组的组织是否有助于AI系统理解如何制造功能性蛋白质,这一点并不明显。

最新研究表明,使用细菌基因组进行训练确实可以帮助开发一种能够预测蛋白质的系统,其中一些蛋白质看起来前所未见。

基因组模型训练

这项新研究由斯坦福大学的一个小型团队完成。它依赖于细菌基因组中一个常见特征:功能相关基因的聚集。通常,细菌会将给定功能所需的所有基因——如糖类的摄取和消化、氨基酸的合成等——紧密排列在基因组中。在许多情况下,所有基因都被转录成一条大型信使RNA。这为细菌提供了一种简单的方式来同时控制整个生化通路的活性,提高细菌代谢效率。

研究人员开发了一个他们称为"基因组语言模型"的系统,命名为Evo,使用大量细菌基因组进行训练。训练方式类似于大型语言模型,Evo被要求输出序列中下一个碱基的预测,预测正确时获得奖励。它也是一个生成式模型,可以接受提示并输出具有一定程度随机性的新序列,即相同的提示可以产生一系列不同的输出。

研究人员认为,这种设置使Evo能够"将核苷酸水平的模式与千碱基尺度的基因组上下文联系起来"。换句话说,如果你给它提供一大段基因组DNA作为提示,Evo可以像LLM解释查询一样解释它,并在基因组意义上产生适当的输出。

研究人员推测,鉴于在细菌基因组上的训练,他们可以使用已知基因作为提示,Evo应该输出包含编码具有相关功能蛋白质区域的序列。关键问题是,它是否会简单地输出我们已经知道的蛋白质序列,或者产生不太可预测的输出。

新型蛋白质

为了开始测试该系统,研究人员用已知蛋白质基因片段作为提示,确定Evo是否能完成它们。在一个例子中,如果给出已知蛋白质基因序列的30%,Evo能够输出剩余部分的85%。当给出序列的80%作为提示时,它可以返回所有缺失序列。当从功能簇中删除单个基因时,Evo也能正确识别并恢复缺失的基因。

大量训练数据还确保Evo正确识别了蛋白质最重要的区域。如果它对序列进行修改,这些修改通常位于蛋白质中可变性容忍度高的区域。换句话说,它的训练使系统能够纳入已知基因变化的进化限制规则。

因此,研究人员决定测试当Evo被要求输出新内容时会发生什么。为此,他们使用了细菌毒素,这些毒素通常与抗毒素一起编码,以防止细胞在激活基因时自杀。自然界中有很多这样的例子,它们作为细菌与竞争对手之间军备竞赛的一部分迅速进化。因此,团队开发了一种与已知毒素只有微弱关联且没有已知抗毒素的毒素,并将其序列作为提示提供给Evo。这次,他们过滤掉任何看起来与已知抗毒素基因相似的响应。

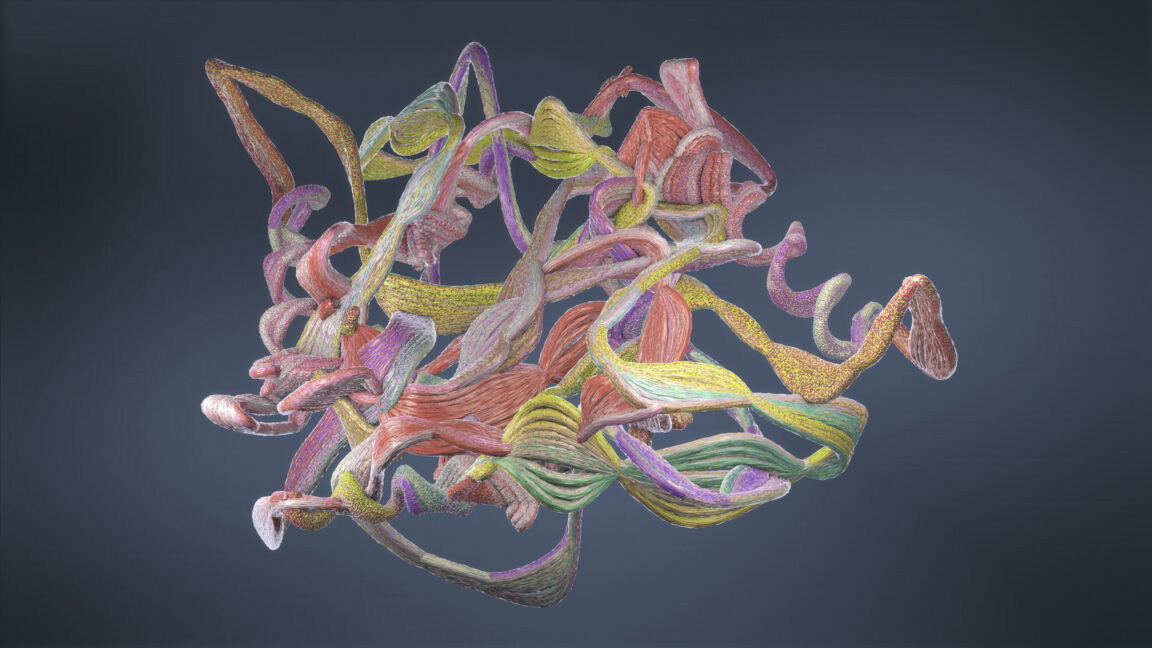

在测试Evo返回的10个输出中,发现其中一半能够挽救一些毒性,其中两个完全恢复了产生毒素的细菌的生长。这两个抗毒素与已知抗毒素的序列相似性极低,仅约25%的序列一致性。它们不仅仅是将少量已知抗毒素片段拼接在一起;至少,它们似乎是由15到20个不同蛋白质的部分组装而成。在另一个测试中,输出需要从40个已知蛋白质的部分拼接而成。

Evo的成功不仅限于蛋白质。当他们测试具有RNA抑制剂的另一种毒素时,该系统能够输出编码具有正确结构特征的RNA的DNA,即使特定序列与已知序列没有密切关联。

全新蛋白质

团队对CRISPR系统的抑制剂进行了类似的测试,CRISPR是我们用于基因编辑的技术,但细菌进化出这种系统作为对抗病毒的保护机制。天然存在的CRISPR抑制剂非常多样化,其中许多彼此之间似乎没有关联。同样,团队过滤输出,只包含编码蛋白质的序列,并过滤掉任何看起来我们已经知道的蛋白质。在他们制造蛋白质的输出列表中,17%成功抑制了CRISPR功能。其中两个与众不同之处在于,它们与任何已知蛋白质都没有相似性,并且让旨在预测蛋白质三维结构的软件感到困惑。

换句话说,除了预期类型的输出外,Evo似乎能够输出完全全新的功能性蛋白质。而且它似乎这样做时完全没有考虑蛋白质的结构。

鉴于他们的系统似乎有效,研究人员决定用几乎所有东西作为提示:来自细菌及其捕食病毒的170万个独立基因。结果是1200亿个碱基对的AI生成DNA,其中一些包含我们已经知道的基因,一些可能包含真正新颖的内容。目前尚不清楚如何有效利用这一资源,但我可以想象会有一些富有创造力的生物学家会想出一些用途。

目前尚不清楚这种方法是否适用于更复杂的基因组,比如我们人类的基因组。像脊椎动物这样的生物体大多不聚集功能相关的基因,它们的基因结构也更为复杂,可能会试图学习碱基频率统计规则的系统感到困惑。而且需要明确的是,它解决了与定向设计不同的问题,后者已经开发出具有消化塑料等有用功能的酶。

尽管如此,这种方法能够工作本身就已经很令人惊奇了。从概念上讲,它很有趣,因为它将寻找功能性蛋白质的问题降低到了核酸水平,这正是进化通常发挥作用的地方。

技术意义与未来展望

这项研究的意义远超单纯的蛋白质设计技术突破。它代表了AI在生物领域应用的全新方向——从核酸层面而非蛋白质层面进行设计。这种方法有几个关键优势:

更高的创新性:从DNA层面设计可以产生自然界中不存在的蛋白质组合,突破进化限制。

功能导向:基于基因簇的设计方法能够确保生成的蛋白质在功能上相互协调,形成完整的生化通路。

效率提升:通过一次生成整个基因簇,可以大大加速复杂生物系统的设计和优化过程。

然而,这项技术目前仍处于早期阶段,面临诸多挑战:

适用范围有限:目前主要适用于细菌等简单基因组,复杂真核生物基因组中的应用仍需突破。

验证成本高:AI生成的蛋白质需要大量实验验证其功能和安全性,成本高昂。

可解释性不足:AI如何从基因组模式中推断出蛋白质功能,这一过程仍缺乏清晰解释。

未来,随着技术的进步,这种方法可能会扩展到更复杂的生物系统,甚至应用于人类健康领域。例如,设计针对特定疾病的全新蛋白质药物,或者优化微生物用于生物燃料生产或环境修复。

结论

斯坦福大学团队开发的Evo基因组语言模型代表了AI与生物学交叉领域的重要突破。通过训练细菌基因组,该系统能够生成具有全新功能且与已知蛋白质几乎没有相似性的蛋白质。这一发现不仅拓展了我们对蛋白质设计可能性的认识,也为生物技术领域开辟了全新途径。虽然目前该技术主要适用于简单基因组,但其核心理念——从核酸层面而非蛋白质层面进行设计——可能会引领未来生物工程的发展方向。