Google近日推出的Nano Banana Pro图像生成模型,凭借其基于Gemini 3的先进技术,正在重新定义AI图像创作的可能性。这一升级版的图像生成工具不仅继承了前代模型的易用性,更在图像质量、文本处理能力和编辑功能方面实现了质的飞跃,为用户带来了前所未有的创作体验。

技术革新:从概念到现实的跨越

Nano Banana Pro作为Google最新推出的图像生成模型,其核心优势在于对复杂指令的理解和执行能力。与早期版本相比,新模型能够更准确地理解用户意图,将抽象的概念转化为视觉呈现。这种进步不仅体现在图像的整体质量上,更反映在对细节的精准把握上,尤其是文本内容的生成。

"我们致力于让AI图像生成工具成为创意工作者的得力助手,"Google AI团队表示,"Nano Banana Pro的设计理念就是将用户的想象力转化为现实,同时保持创作的灵活性和可控性。"

实用功能:专业创作的新工具

精准文本生成

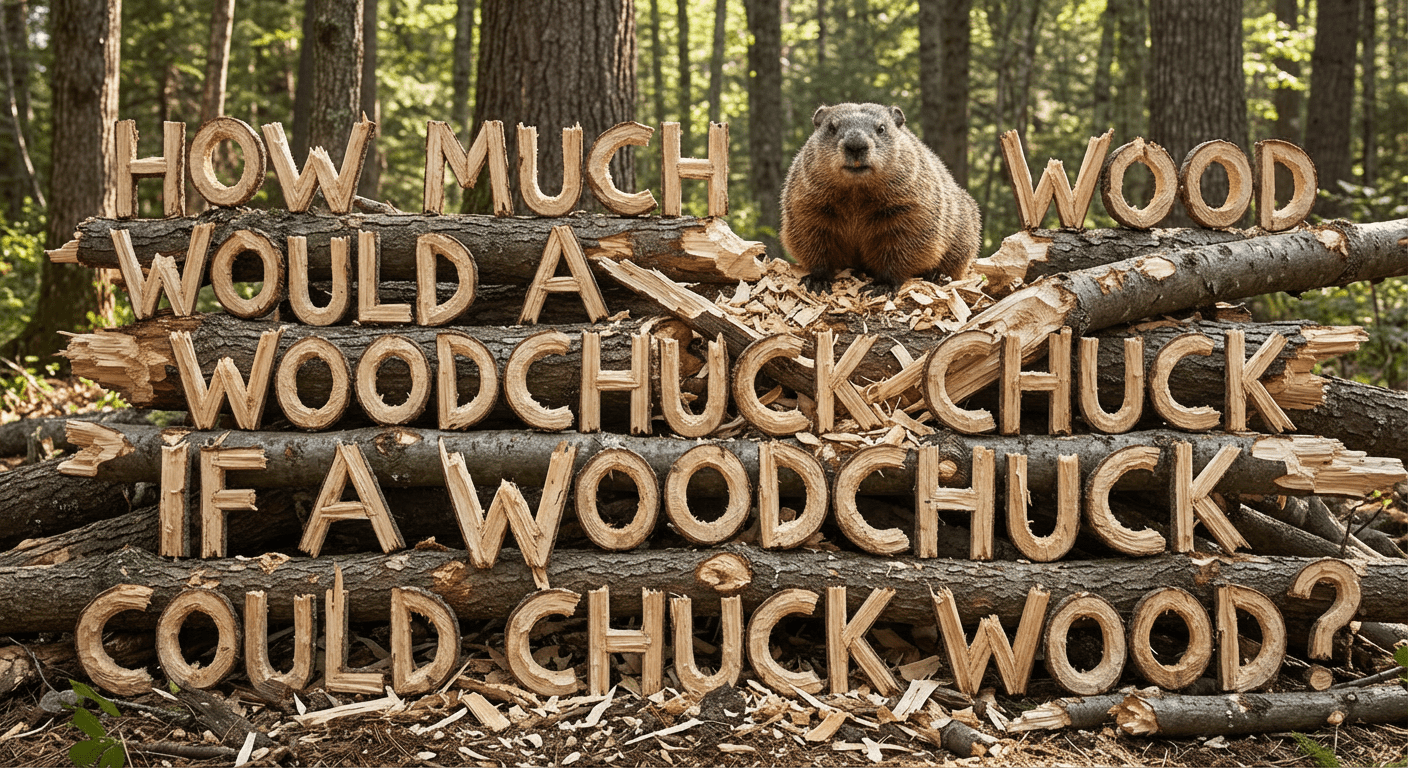

Nano Banana Pro最引人注目的突破之一是其文本生成能力。早期AI图像生成工具在处理文本内容时常常出现错字、变形或无法识别的问题,而新模型能够生成清晰、准确的文本内容,甚至可以创建完整的可用信息图表,无需后期编辑修正。

示例:Nano Banana Pro成功生成包含复杂文本的图像,"How much wood would a woodchuck chuck if a woodchuck could chuck wood"文字由木块构成

图像一致性保持

在多人物或复杂场景的生成中,保持图像一致性一直是AI图像生成的挑战。Nano Banana Pro通过先进的算法,能够在融合最多14张图像的同时,保持最多5个人物的一致外观,这对于创作连续性要求高的内容(如故事板、角色设计等)具有重要意义。

精确编辑能力

新模型提供了前所未有的图像编辑功能。用户不仅可以对现有图像进行局部调整,还能改变图像的核心元素,如相机角度、色彩分级和光照效果,而不会影响其他部分。这种非破坏性编辑方式大大提高了创作效率,使专业级图像调整变得更加便捷。

画质提升:4K分辨率的专业呈现

Google特别强调了Nano Banana Pro在图像质量方面的提升。新模型支持最高4K分辨率的图像渲染,这意味着生成的图像不仅细节丰富,而且适合专业用途,如印刷品、高清视频制作等。这一进步使AI图像生成工具从娱乐级向专业级转变,为设计师、艺术家和内容创作者提供了更强大的创作工具。

内容识别:平衡创新与真实性

随着AI图像生成技术的进步,如何识别AI生成的内容成为行业关注的焦点。Google采取了双管齐下的策略:一方面,通过技术手段强化AI内容的标识;另一方面,为专业用户提供更灵活的使用选项。

SynthID水印技术

所有由Nano Banana Pro生成的图像都嵌入了SynthID数字水印,这是一种肉眼不可见但可通过特定工具检测的技术。Google表示,这种水印即使在图像经过编辑、裁剪或压缩后仍然有效,为AI内容的追溯提供了可靠的技术保障。

C2PA元数据增强

除了SynthID水印外,Google还在AI生成的图像中添加了更多C2PA(Coalition for Content Provenance and Authenticity)元数据。这些元数据详细记录了图像的生成过程、使用的工具和参数等信息,为内容的真实性验证提供了更全面的依据。

Gemini应用的AI检测功能

Google还在Gemini应用中新增了AI图像检测功能。用户可以上传任意图像,询问"这是AI生成的吗?"应用会检查图像中是否存在Google的SynthID水印,并给出相应答案。这一功能不仅帮助普通用户识别AI内容,也为媒体机构提供了内容审核的工具。

访问权限:分层服务模式

Nano Banana Pro已向全球用户开放,但Google采用了分层的服务模式,不同级别的用户享有不同的使用权限:

- AI Ultra订阅用户:享有最高使用限制,可移除图像上的可见水印,仅保留不可见的SynthID标记

- Gemini Pro用户:享有中等使用权限,功能完整但使用次数有限制

- 免费用户:可体验基础功能,但使用次数受限,超出后将切换到非专业版本

这种分层模式既保证了技术的广泛普及,又为专业用户提供了更优质的服务,体现了Google在商业利益与技术普惠之间的平衡考量。

行业影响:AI创作工具的新标杆

Nano Banana Pro的推出不仅是Google技术实力的展示,也为整个AI图像生成行业树立了新的标杆。其突破性的文本处理能力、专业的图像编辑功能和高质量的输出结果,将推动行业向更专业化、更精细化的方向发展。

"AI图像生成技术正在从'能生成'向'生成好'转变,"行业分析师指出,"Nano Banana Pro代表了这一转变的最新成果,它不仅关注生成结果的质量,还注重创作过程的可控性和专业性。"

未来展望:AI图像生成的可能性

随着技术的不断进步,AI图像生成工具将朝着更加智能化、个性化的方向发展。Nano Banana Pro作为当前技术的前沿探索,为我们展示了AI在创意领域的巨大潜力。未来,我们可以期待:

- 更精准的文本生成能力,支持更多语言和复杂排版

- 更强的3D理解和生成能力,实现从2D到3D的无缝转换

- 更好的跨模态理解,实现文本、图像、视频等多种创作形式的一体化

- 更完善的版权保护和内容溯源机制,解决AI创作的法律和伦理问题

结语

Google Nano Banana Pro的推出,标志着AI图像生成技术进入了一个新的发展阶段。它不仅提升了技术本身的性能,更关注用户体验和实际应用场景,使AI工具真正成为创意工作者的得力助手。在技术创新与内容真实性之间寻找平衡,Google通过Nano Banana Pro展示了对行业未来的深刻理解和负责任的态度。随着这一技术的普及和应用,我们有理由相信,AI将在创意领域释放更大的潜力,为人类带来更多惊喜和可能。