DeepSeek R1 本地部署完全指南:Ollama、Docker 与 OpenWebUI 整合方案

2025年1月,DeepSeek 推出了 DeepSeek-R1 大模型,以其卓越的性能和亲民的成本,在人工智能领域掀起了一股热潮。DeepSeek 提供了多种灵活的使用方式,以适应不同用户和应用场景的需求。其中,本地部署因其在数据安全、性能优化、高度定制、成本控制、离线可用性以及技术自主性等方面的显著优势而备受青睐。

本文将深入探讨基于 Ollama、Docker 和 OpenWebUI 的 DeepSeek-R1 本地化部署流程,并结合具体的代码实例进行演示,助您轻松搭建属于自己的 AI 应用环境。

1. 硬件与软件需求

在开始部署之前,务必确保您的系统满足以下硬件和软件需求:

1.1 硬件配置

运行 DeepSeek R1 的硬件配置直接关系到模型的性能和响应速度。以下是推荐的配置:

- 基本推荐配置:

- CPU:8 核或以上

- 内存:32GB 或以上

- 存储:100GB SSD 或以上

- GPU:NVIDIA GTX 1080 或同等性能显卡

- DeepSeek-7B 推荐配置:

- NVIDIA RTX 3060 以上显卡

- 16GB 以上内存

- 50GB SSD 存储空间

- DeepSeek-70B 推荐配置:

- NVIDIA RTX 4060 以上显卡

- 32GB 以上内存

- 200GB SSD 存储空间

本教程所使用的硬件配置为:

- CPU:Intel i5-12490/3.00GHz

- 内存:32GB

- 存储:500GB SSD

- GPU:NVIDIA GTX 3060

1.2 软件环境

除了硬件,软件环境也至关重要。本教程采用以下软件版本:

- 操作系统:Windows 10

- 编程语言:Python 3.8

- 深度学习框架:PyTorch 1.7

此外,还涉及到容器化工具 Docker,以及用于模型运行的 Ollama。这些组件将在后续步骤中详细介绍。

2. Ollama 下载与安装

2.1 Ollama 简介

Ollama 是一款强大的开源工具,旨在简化本地大型语言模型的运行。它支持一键下载和运行各种开源模型,如 Llama、Qwen 和 DeepSeek 等。Ollama 提供高效、灵活的大模型部署和管理解决方案,显著降低了模型部署的复杂性,让开发者可以更专注于模型的应用和创新。

本教程选择 Ollama Windows 版本 进行下载。

2.2 Ollama 安装步骤

- 下载安装包: 从 Ollama 官网下载适用于 Windows 的安装包 (OllamaSetup.exe)。

- 运行安装程序: 双击下载的安装包,按照提示完成安装过程。通常情况下,直接采用默认设置即可。

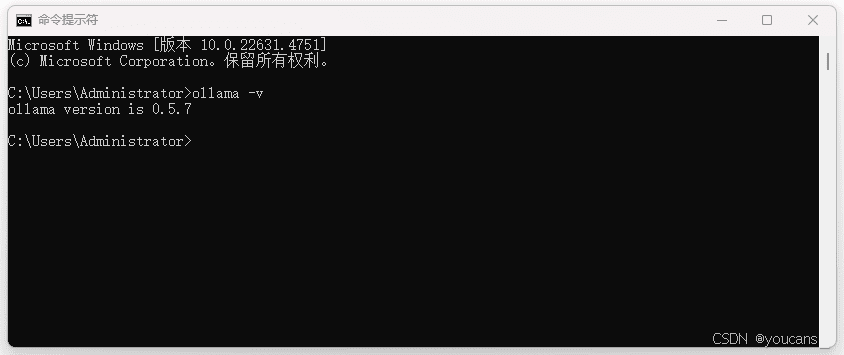

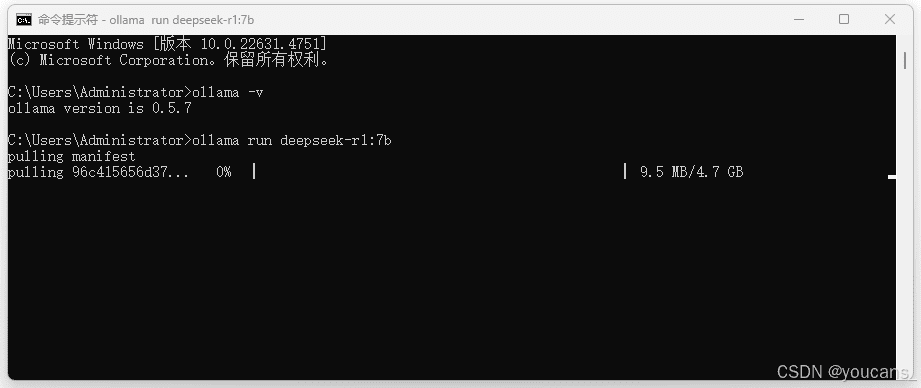

- 验证安装: 安装完成后,打开命令提示符(CMD)窗口,输入

ollama -v命令。如果成功显示 Ollama 的版本号,例如0.5.7,则表示安装成功。

2.3 Ollama 运行方式

Ollama 在后台运行,没有图形用户界面。您可以通过命令行与其交互。

- 启动 Ollama: Ollama 安装完成后会自动启动,您可以在系统托盘中看到 Ollama 的图标。

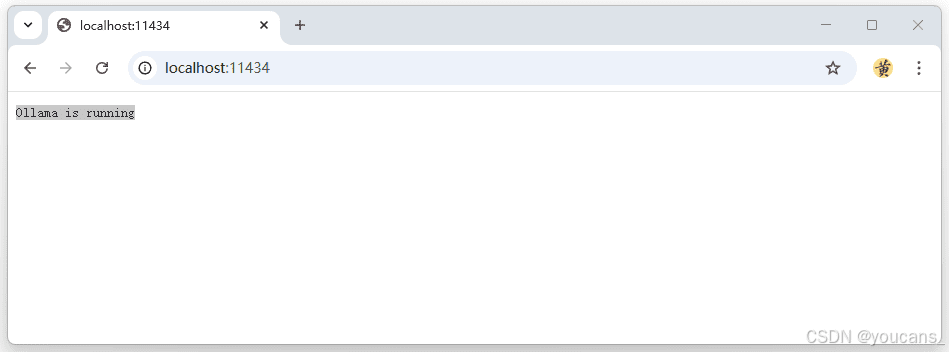

- 验证 Ollama 运行状态: 打开浏览器,输入

http://localhost:11434/。如果页面显示 “Ollama is running”,则表示 Ollama 正在正常运行。

3. DeepSeek-R1 模型安装

3.1 使用 Ollama 安装 DeepSeek-R1 模型

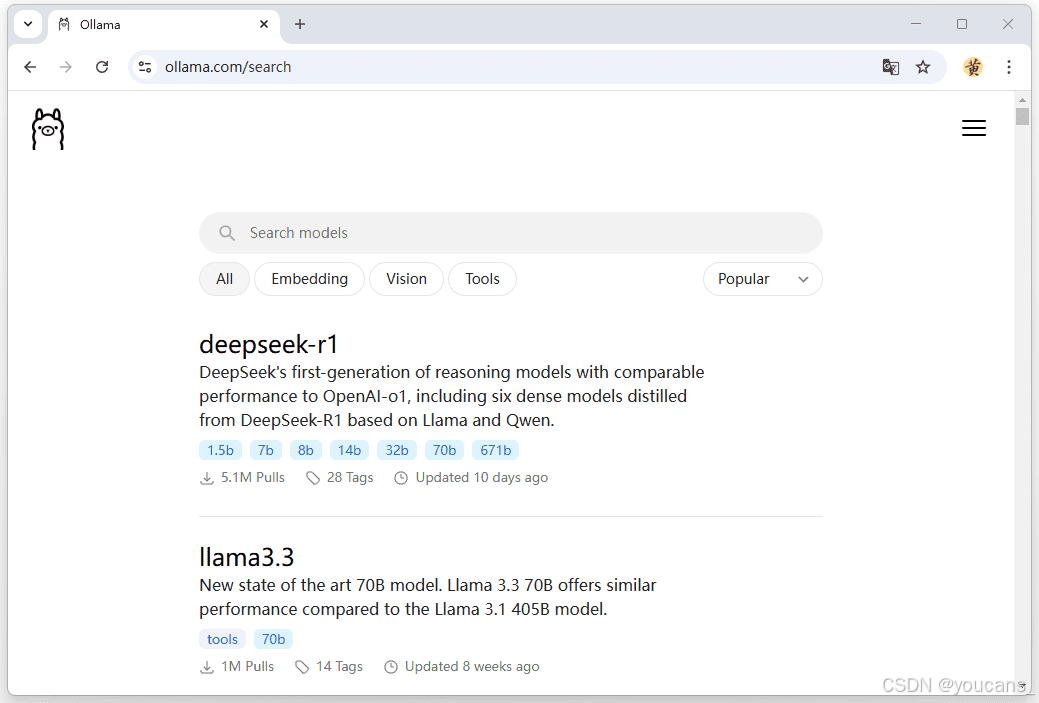

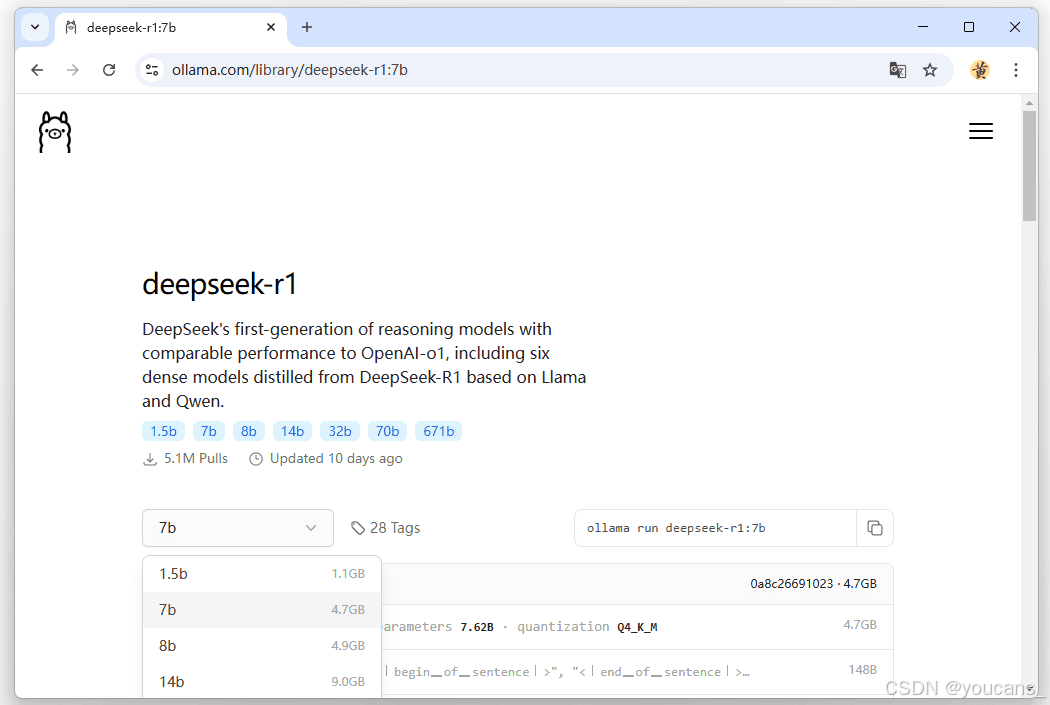

- 查找 DeepSeek-R1 模型: 访问 Ollama 官网 搜索 DeepSeek-R1 模型。Ollama 提供了多种 DeepSeek-R1 的模型版本,包括 1.5b、7b、14b、32b、70b 等,分别对应不同的参数规模。

- 选择模型版本: 点击进入 DeepSeek-R1 模型页面,选择适合您硬件配置和需求的版本。一般来说,参数量越大,模型性能越强,但同时也需要更多的存储和计算资源。以下是一些常用版本的参数和大小:

- DeepSeek-R1 1.5b:参数量 15 亿,模型大小 1.1GB

- DeepSeek-R1 7b:参数量约 70 亿,模型大小 4.7GB

- DeepSeek-R1 14b:参数量约 140 亿,模型大小 9GB

建议初学者先下载较小的 1.5b 模型,验证整个安装流程是否畅通,然后再根据实际需求和硬件配置选择更合适的版本。

- 安装模型: 在命令提示符窗口运行相应的安装命令。例如,要安装 7b 模型,可以执行以下命令:

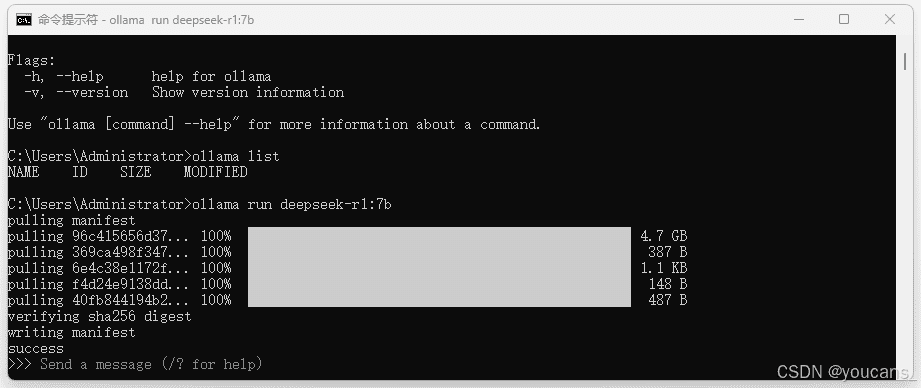

ollama run deepseek-r1:7bOllama 会自动下载并安装该模型。

默认情况下,模型会保存在 C:\Users\%username%\.ollama\models 目录下。您可以通过设置系统环境变量 OLLAMA_MODELS 来修改模型的保存路径。例如,要将模型保存在 C:\Model 目录下,您可以:

* 新建一个文件夹 C:\Model。

* 在系统环境变量中添加一个系统变量,变量名为 OLLAMA_MODELS,变量值为 C:\Model。

- 验证安装: 安装完成后,命令行会显示 “success”,表示模型安装成功。

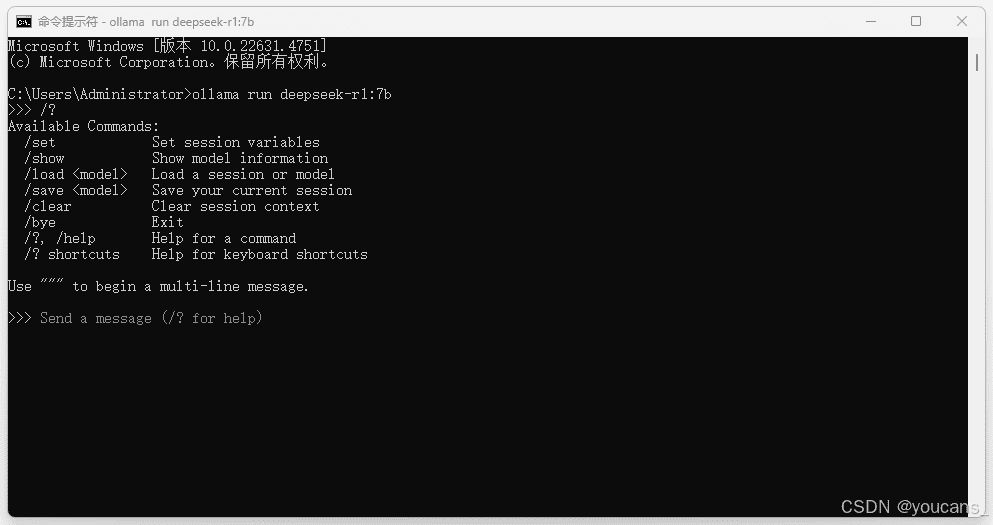

3.2 使用 DeepSeek-R1 模型

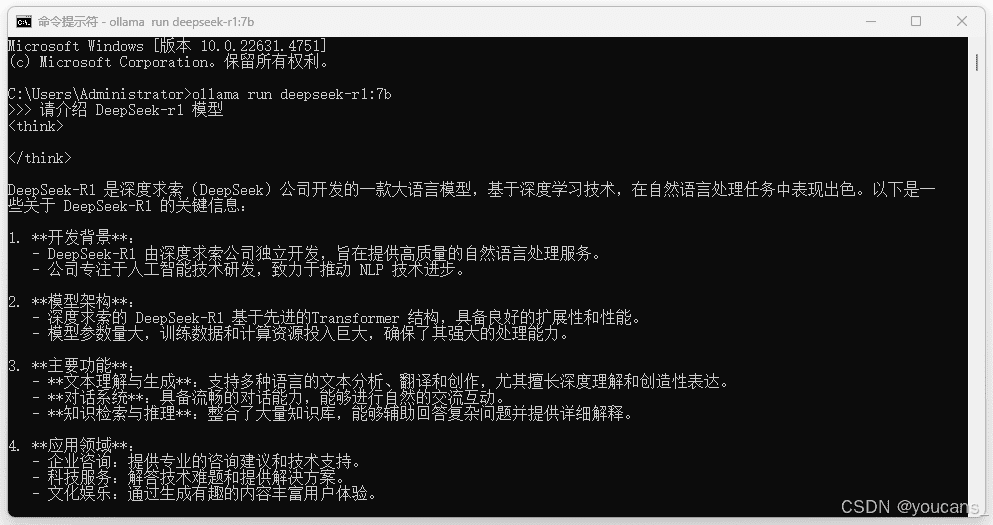

- 运行模型: 在命令提示符窗口运行以下命令来启动 DeepSeek-R1 模型:

ollama run deepseek-r1:7b启动后,您就可以在提示行输入内容,与 DeepSeek-R1 模型进行交互了。

- 获取帮助: 在交互过程中,您可以输入

/?命令来获取帮助信息,了解可用的命令和选项。

虽然通过本地命令行窗口可以使用 DeepSeek-R1 模型,但这种交互方式不够直观和便捷。为了提升用户体验,接下来我们将介绍如何通过 Docker 和 Open WebUI 搭建图形用户界面,从而更轻松地使用 DeepSeek-R1 模型。

4. Docker 安装与配置

Docker 是一种流行的容器化技术,可以帮助您快速构建、部署和运行应用程序。在本教程中,我们将使用 Docker 来部署 Open WebUI。

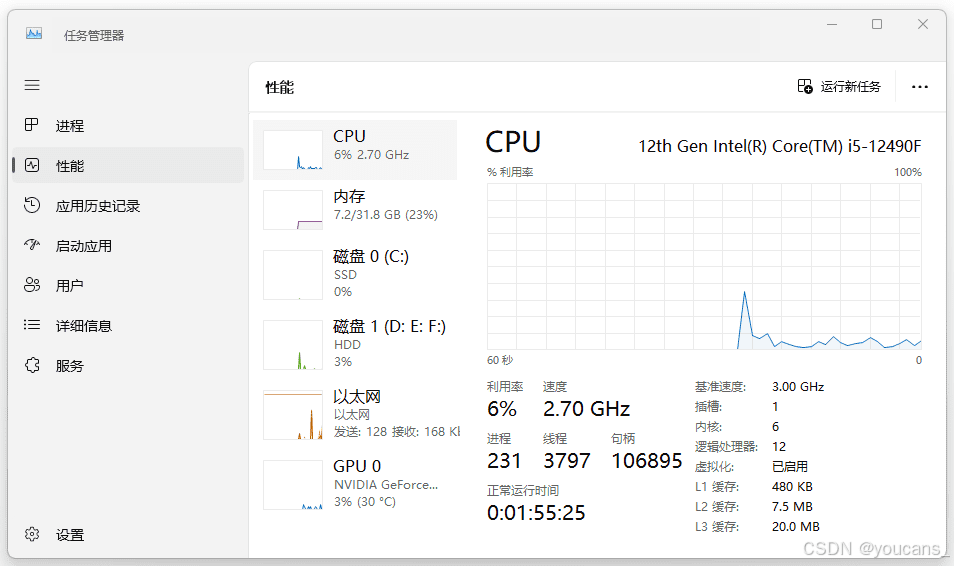

4.1 检查安装环境

在安装 Docker 之前,需要确保您的系统满足以下条件:

- 开启虚拟化: 打开任务管理器(Ctrl+Alt+Delete),选择 “性能” 选项卡,然后点击 “CPU”。在 “虚拟化” 旁边,确认显示为 “已启用”。

如果未启用虚拟化,您需要在开机时进入 BIOS 设置,找到 “Advanced” -> “CPU Configuration” -> “Secure Virtual Machine”,将其设置为 “Enabled”。

- 启用 Hyper-V: 打开 “控制面板”,选择 “程序”,然后点击 “启用或关闭 Windows 功能”。勾选 “Hyper-V 管理工具” 和 “Hyper-V 平台”。

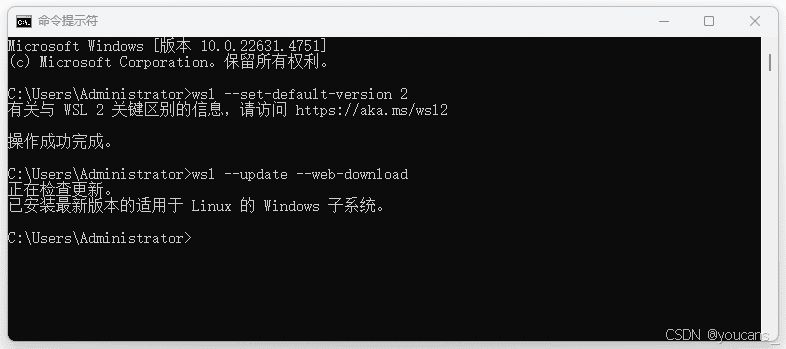

- 设置 WSL 2: 以管理员身份打开命令提示符窗口,输入以下命令将默认 WSL 版本设置为 2:

wsl --set-default-version 2WSL (Windows Subsystem for Linux) 允许您在 Windows 上直接运行 Linux 发行版,而无需进行任何修改。

- 更新 WSL: 在命令提示符窗口,输入以下命令更新 WSL:

wsl --update --web-download

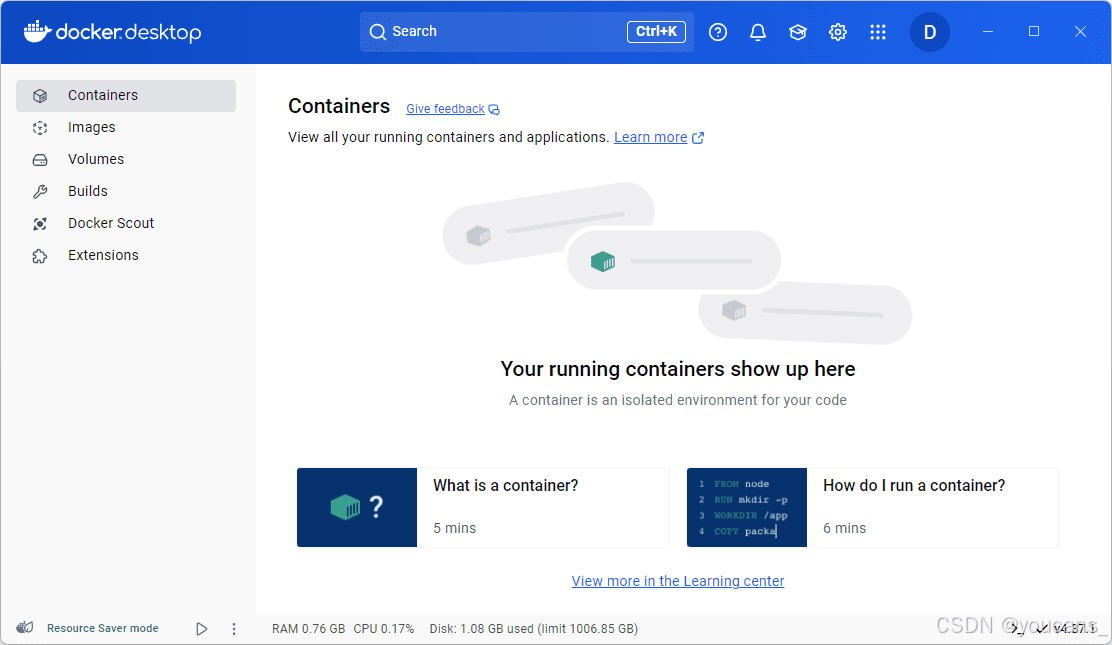

4.2 安装 Docker Desktop

Docker Desktop 是 Docker 官方提供的桌面应用程序,旨在简化在 Windows 和 macOS 系统上构建、运行和共享容器化应用程序的过程。它提供了一个方便的工具集,使用户能够快速部署容器化应用程序,同时还包括 Docker Engine、Docker CLI 和 Docker Compose 等强大功能。

- 下载 Docker Desktop: 访问 Docker 官方网站,下载 Docker 安装程序。

安装 Docker Desktop: 双击下载的安装程序,按照提示完成安装。建议选择推荐设置。

登录 Docker 账号: 安装完成后,根据提示登录您的 Docker 账号。您可以使用 GitHub 账号登录。

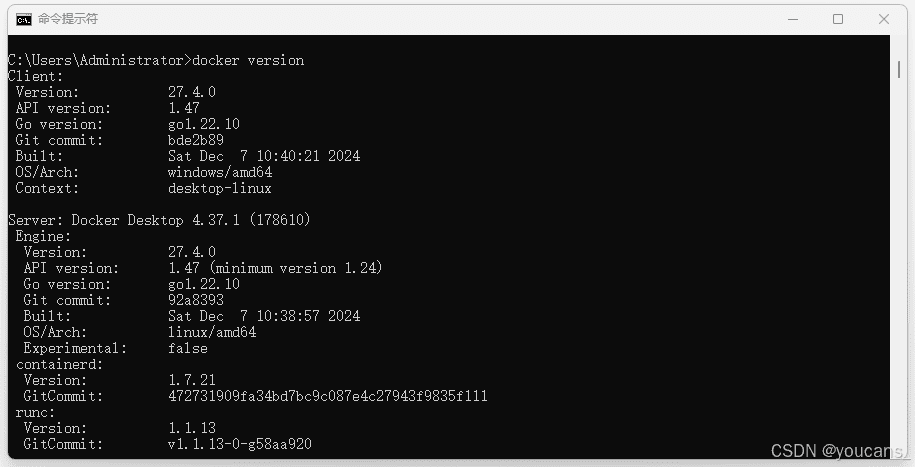

- 验证安装: 安装完成后,打开命令提示符窗口,输入

docker version命令。如果成功显示 Docker 的版本号,例如27.4.0,则表示安装成功。

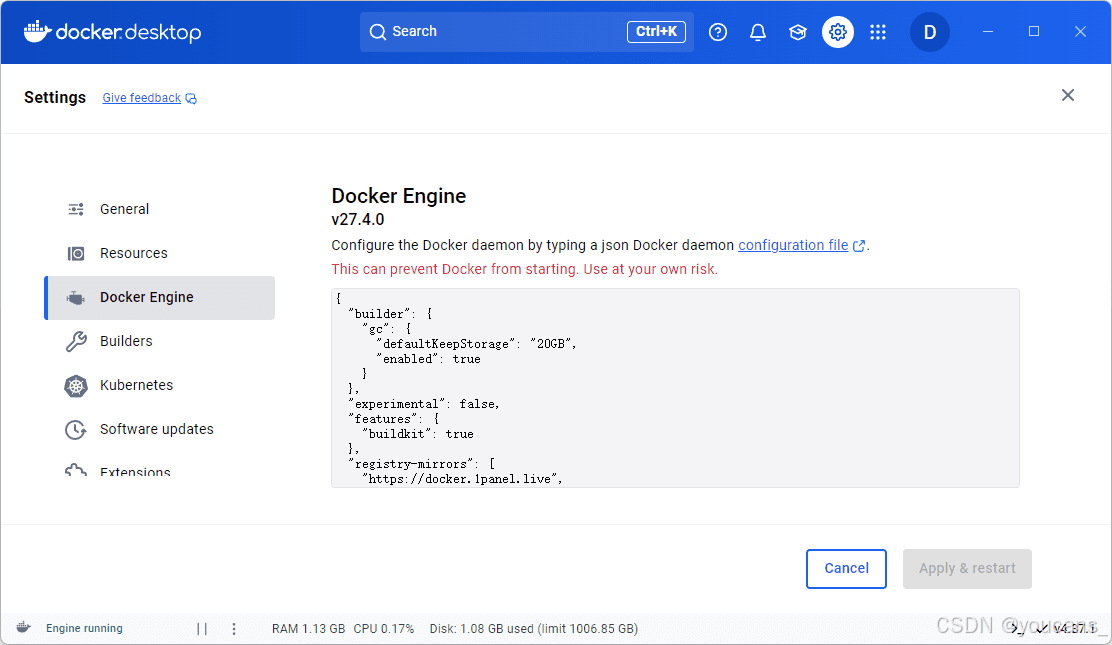

4.3 配置国内镜像源

由于网络原因,直接从 Docker Hub 拉取镜像可能会比较慢,甚至出现连接超时的错误。为了解决这个问题,我们可以配置国内的镜像源来加速镜像拉取。

- 打开 Docker 设置: 右键单击系统托盘中的 Docker 图标,选择 “Settings”。

- 配置镜像源: 在 “Settings” 窗口中,选择 “Docker Engine”,将以下内容复制到文本框中:

{

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": false,

"features": {

"buildkit": true

},

"registry-mirrors": [

"https://docker.m.daocloud.io",

"https://docker.1panel.live",

"https://registry.docker-cn.com",

"https://cr.console.aliyun.com",

"https://mirror.ccs.tencentyun.com"

]

}

- 重启 Docker: 点击 “Apply & restart” 按钮,重启 Docker。

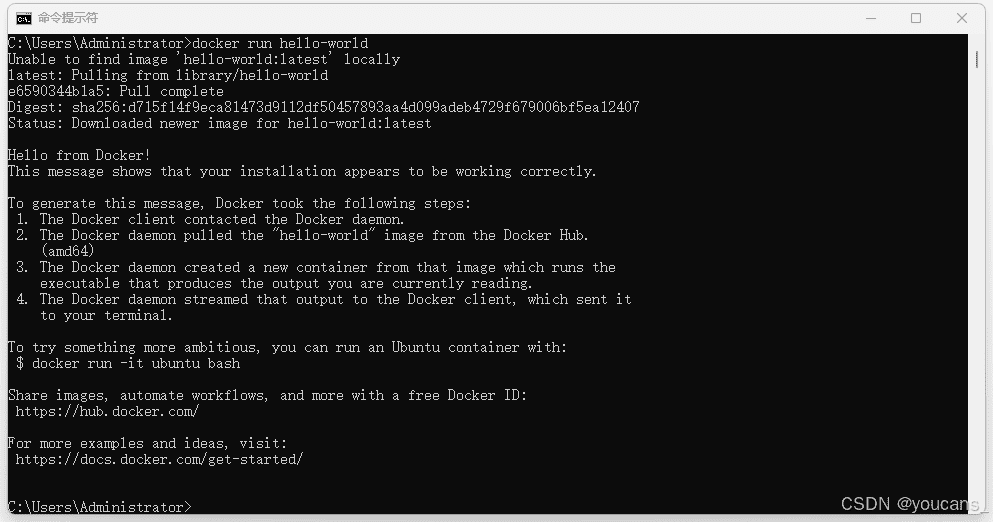

- 验证配置: 重启完成后,再次执行

docker run hello-world命令。如果能够成功拉取 hello-world 镜像并运行,则表示镜像源配置成功。

5. Open WebUI 安装与使用

Open WebUI 是一款可扩展、功能丰富、用户友好的自托管 WebUI,专为离线操作而设计。它支持各种 LLM 运行程序,包括 Ollama 和 OpenAI 兼容的 API。Open WebUI 适配了 Ollama 接口,提供了通过 Web 界面访问 Ollama API 的便捷方式。

5.1 安装和启动 Open WebUI

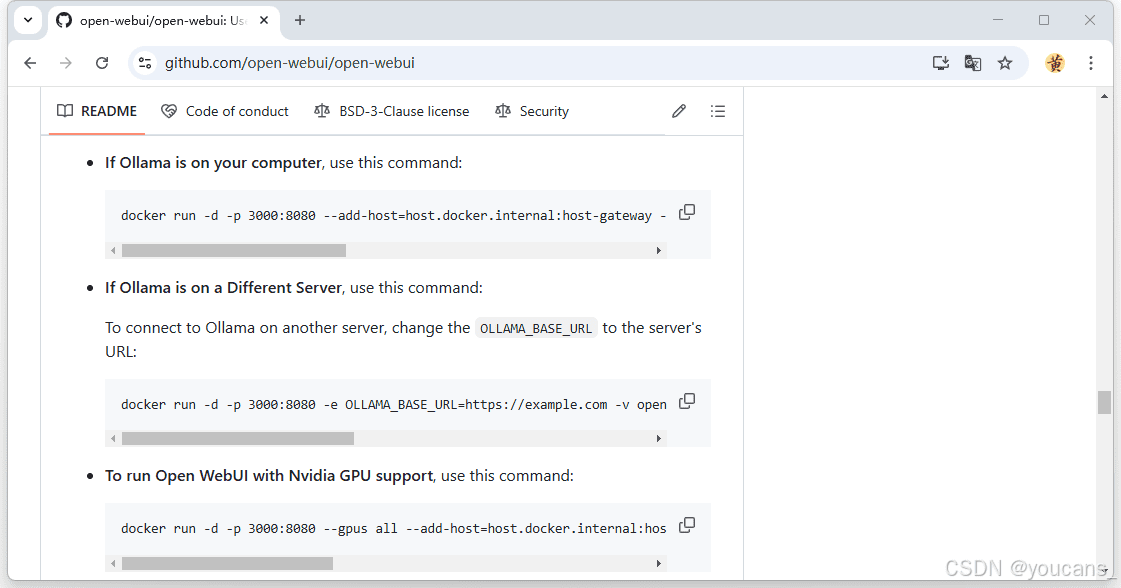

- 访问 Open WebUI GitHub 仓库: 打开 https://github.com/open-webui/open-webui。

- 获取安装命令: 在 README 文件中找到用于 Ollama 的安装命令:

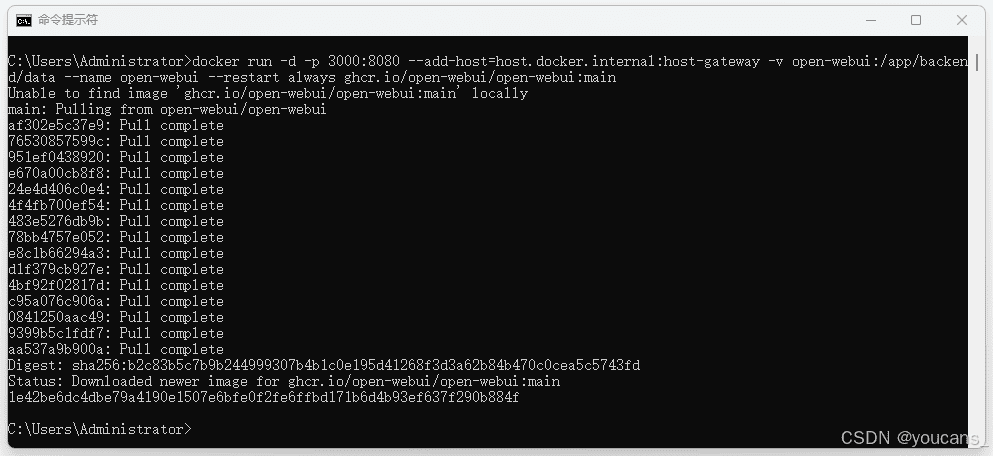

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

- 执行 Docker 命令: 在命令提示符窗口执行上述 docker 命令,自动下载并安装 Open WebUI。

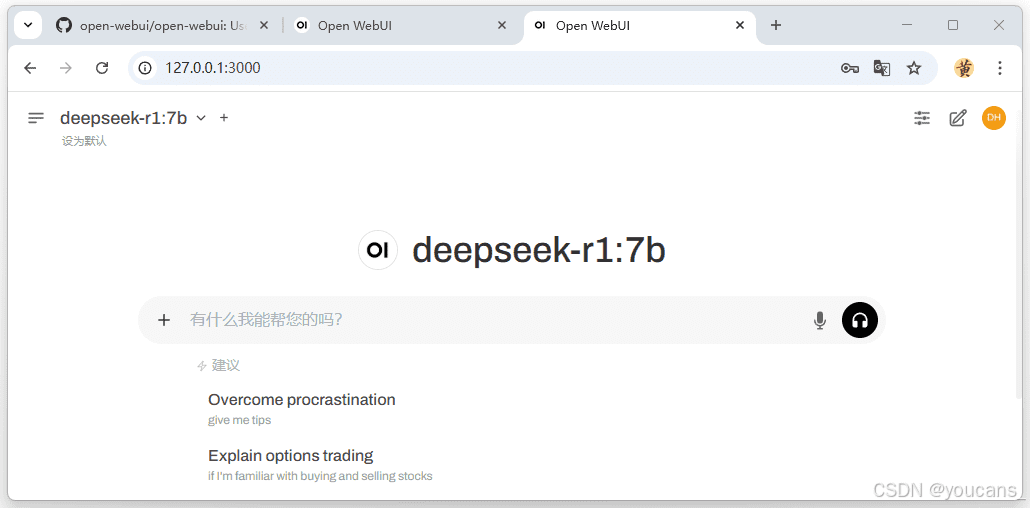

5.2 登录 Open WebUI 并进入 DeepSeek-R1

- 访问 Open WebUI 界面: 在浏览器中输入

localhost:3000/auth或http://127.0.0.1:3000,进入 Open WebUI 首页。

- 注册账号: 注册账号密码,创建管理员账号。

- 登录 Open WebUI: 注册完成后,使用您的账号密码登录。

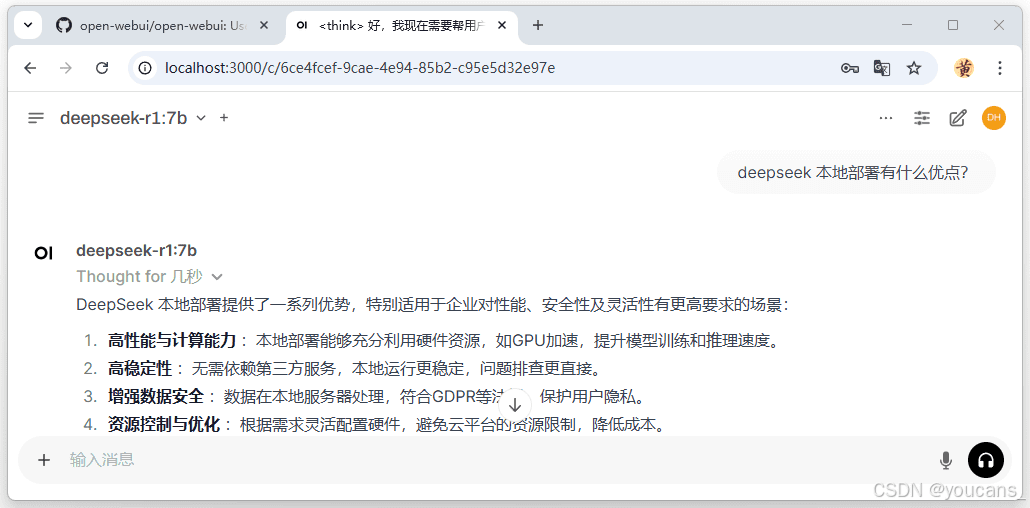

- 开始使用 DeepSeek-R1: 登录成功后,您将进入 DeepSeek-R1 模型的首页,可以开始与模型进行交互了。

现在,您已经成功地在本地部署了 DeepSeek-R1 模型,可以通过 Open WebUI 界面与模型进行聊天和交互。

通过本教程,您已经掌握了基于 Ollama、Docker 和 Open WebUI 在本地部署 DeepSeek-R1 大模型的完整流程。现在,您可以尽情探索 DeepSeek-R1 的强大功能,并将其应用于各种实际场景中。