搭建你的专属AI知识库:Ollama & AnythingLLM实战指南

在人工智能浪潮席卷而来的今天,构建一个属于自己的AI知识库,让AI成为你高效工作的助手,已经不再是遥不可及的梦想。本文将手把手教你如何利用Ollama和AnythingLLM这两款强大的工具,无需编写复杂的代码,即可轻松搭建一个本地化的AI知识库。让我们一起踏上这场AI赋能之旅!

本地化AI知识库的优势

在深入探讨搭建方法之前,我们首先要了解本地化AI知识库的优势所在。与依赖云端服务的AI工具相比,本地化AI知识库具有以下显著优势:

- 数据安全与隐私保障: 所有数据都存储在本地,无需担心数据泄露或被滥用的风险。

- 定制化程度高: 可以根据自身需求,灵活调整知识库的内容和AI模型的参数,打造个性化的AI助手。

- 离线可用性: 即使在没有网络连接的情况下,也能正常使用知识库,保证工作效率。

- 降低成本: 避免了长期使用云端服务所产生的费用,一次投入,长期受益。

核心工具介绍

在搭建本地化AI知识库的过程中,我们将用到以下几款核心工具:

- Ollama: 一个轻量级的本地大语言模型运行框架,可以让你在本地轻松运行各种开源大语言模型。

- AnythingLLM: 一个强大的AI知识库管理平台,可以让你轻松上传、管理和查询知识库文档,并与Ollama等大语言模型进行集成。

- Chatbox 或 Open WebUI: 用户友好的图形界面工具,用于与本地运行的大语言模型进行交互,方便用户进行提问和获取答案。

- 向量数据库: 用于存储知识库文档的向量化表示,提高检索效率,常见的向量数据库包括Chroma、Pinecone等。

- 嵌入模型: 用于将知识库文档转换为向量表示,以便于向量数据库存储和检索,常见的嵌入模型包括Sentence Transformers等。

- 本地模型 Gemma: Google开源的轻量级大语言模型,适合在本地运行,可以作为AnythingLLM的基础模型。

搭建步骤详解

下面,我们将详细介绍如何使用这些工具,一步步搭建一个本地化的AI知识库。

步骤一:安装Ollama

首先,我们需要安装Ollama。Ollama的安装非常简单,只需访问其官方网站,下载对应操作系统的安装包,然后按照提示进行安装即可。安装完成后,打开终端,输入ollama --version命令,如果能正确显示Ollama的版本号,则说明安装成功。

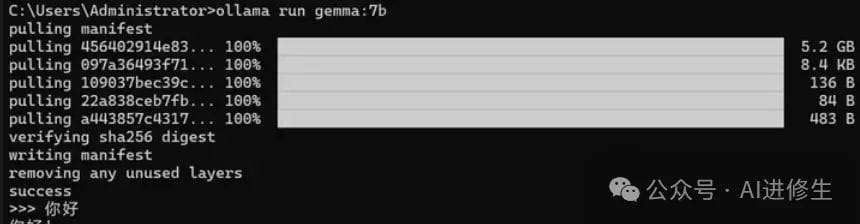

步骤二:下载并运行Gemma模型

接下来,我们需要下载一个适合在本地运行的大语言模型。这里我们选择Google开源的Gemma模型。在终端中输入以下命令即可下载并运行Gemma模型:

ollama run gemmaOllama会自动下载Gemma模型,并将其运行起来。下载过程可能需要一些时间,请耐心等待。

步骤三:安装AnythingLLM

安装完Ollama和Gemma模型后,我们需要安装AnythingLLM。AnythingLLM的安装也比较简单,只需访问其GitHub仓库,下载最新版本的压缩包,然后解压到本地即可。

步骤四:配置AnythingLLM

解压AnythingLLM后,我们需要对其进行一些配置。首先,复制.env.example文件,并将其重命名为.env。然后,打开.env文件,修改以下配置项:

OPENAI_API_KEY=YOUR_OPENAI_API_KEY

OLLAMA_API_BASE_URL=http://localhost:11434OPENAI_API_KEY:由于AnythingLLM默认使用OpenAI的API,我们需要在这里填写一个有效的OpenAI API Key。如果你不想使用OpenAI的API,可以将此项留空。OLLAMA_API_BASE_URL:这里填写Ollama的API地址,默认为http://localhost:11434。

步骤五:启动AnythingLLM

配置完成后,我们就可以启动AnythingLLM了。在终端中,进入AnythingLLM的根目录,然后输入以下命令:

npm install

npm run dev第一条命令用于安装AnythingLLM的依赖包,第二条命令用于启动AnythingLLM的开发服务器。启动成功后,在浏览器中输入http://localhost:3000即可访问AnythingLLM的Web界面。

步骤六:创建知识库

在AnythingLLM的Web界面中,点击"Create a Workspace"按钮,创建一个新的知识库。在创建知识库时,需要填写知识库的名称、描述等信息。

步骤七:上传文档

创建知识库后,我们就可以上传文档了。点击知识库页面中的"Add Documents"按钮,选择要上传的文档。AnythingLLM支持多种文档格式,包括PDF、TXT、Markdown等。

步骤八:配置嵌入模型

文档上传完成后,我们需要配置嵌入模型。在知识库页面中,点击"Settings"按钮,进入设置页面。在设置页面中,选择一个合适的嵌入模型。如果你不想使用OpenAI的嵌入模型,可以选择使用Sentence Transformers等开源嵌入模型。

步骤九:开始提问

配置完成后,我们就可以开始提问了。在知识库页面中,输入你的问题,然后点击"Ask"按钮。AnythingLLM会将你的问题发送给Ollama运行的Gemma模型,然后将Gemma模型的答案返回给你。

优化与进阶

通过以上步骤,我们已经成功搭建了一个本地化的AI知识库。但是,这只是一个基础版本,我们还可以通过以下方式对其进行优化和进阶:

- 选择更强大的模型: Gemma模型虽然适合在本地运行,但其能力相对较弱。如果你有更强大的硬件设备,可以选择更强大的模型,例如LLaMA、Falcon等。

- 使用更专业的向量数据库: AnythingLLM默认使用基于文件的向量数据库,其性能相对较差。如果你需要处理大量的文档,可以选择使用更专业的向量数据库,例如Chroma、Pinecone等。

- 自定义Prompt: 通过自定义Prompt,可以更好地控制AI模型的行为,使其更符合你的需求。

- 集成外部数据源: AnythingLLM可以集成外部数据源,例如网站、API等,从而扩展知识库的内容。

常见问题与解决方案

在搭建和使用本地化AI知识库的过程中,可能会遇到一些问题。以下是一些常见问题及其解决方案:

- Ollama CUDA Error: 如果在运行Ollama时出现CUDA错误,表示显存不足。可以尝试选择更小的模型,或者减少模型的并发数。

- 中文支持问题: 部分模型对中文的支持不够完善,可能会出现乱码或翻译错误。可以尝试选择对中文支持更好的模型,或者使用翻译工具进行辅助。

- AnythingLLM启动失败: 如果AnythingLLM启动失败,可以检查

.env文件中的配置是否正确,或者查看日志文件以获取更多信息。

总结

通过本文的介绍,相信你已经掌握了使用Ollama和AnythingLLM搭建本地化AI知识库的方法。本地化AI知识库具有数据安全、定制化程度高、离线可用等诸多优势,可以帮助你更好地利用AI技术,提高工作效率。赶快动手搭建一个属于自己的AI知识库吧!

希望这篇教程能够帮助你开启AI赋能之旅。在未来的日子里,让我们一起探索AI技术的无限可能!