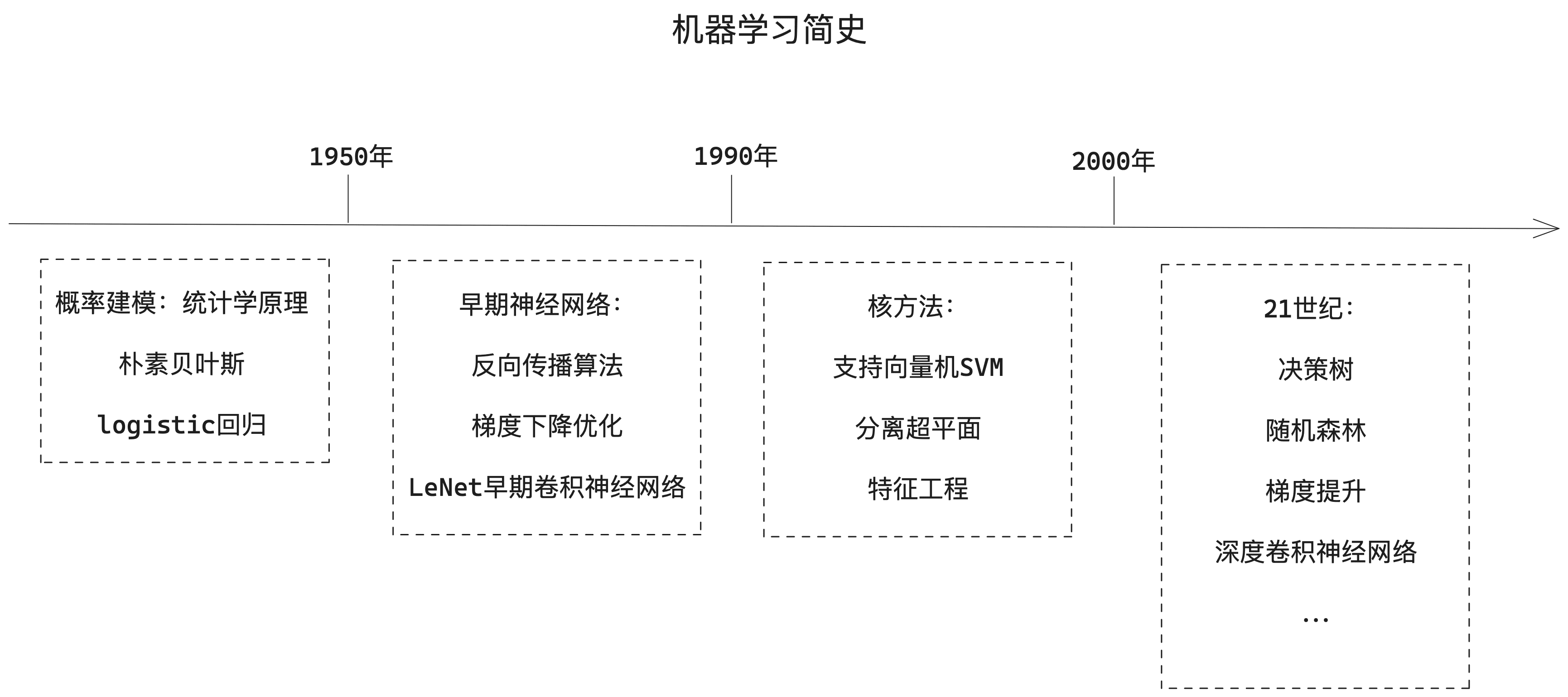

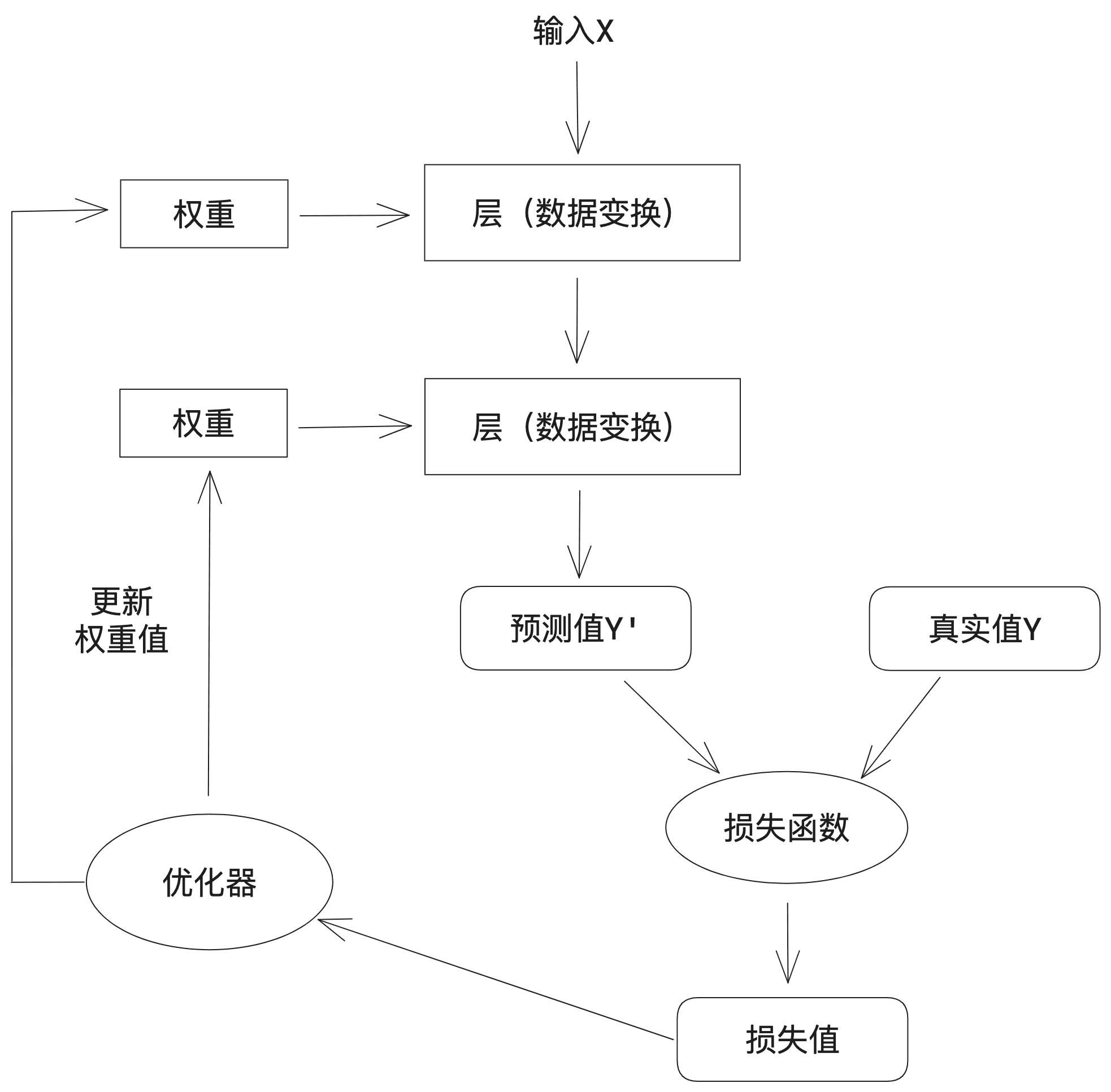

深度学习,作为机器学习领域的一颗璀璨明星,正以其强大的能力改变着我们与世界的交互方式。它并非横空出世,而是站在了机器学习的肩膀上,汲取养分,不断进化。本文将深入剖析深度学习的原理、数学基础,并通过实战案例,揭示其在手写数字识别中的应用。

1. 深度学习:从机器学习到神经网络

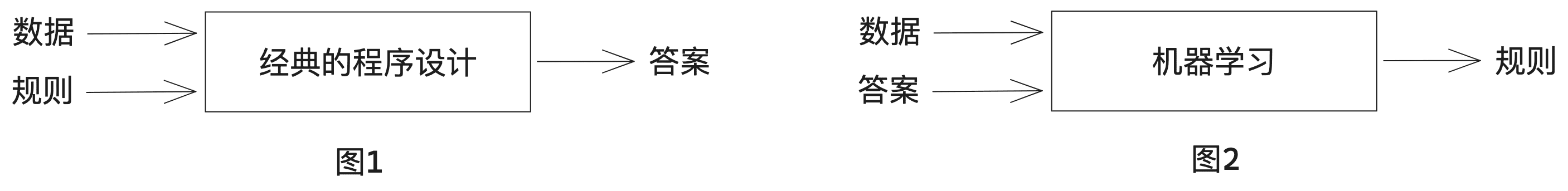

机器学习是让计算机从数据中学习规则,而不是通过程序员编写的明确指令。传统的编程方式适用于解决定义明确的逻辑问题,但在图像识别、语音识别等复杂任务面前显得力不从心。机器学习则反其道而行之,它通过分析大量带标签的数据,自动发现数据中的模式和规则,实现智能化。

深度学习是机器学习的一个分支,其核心在于通过多层神经网络学习数据的表示。这些神经网络通常包含数十层甚至数百层,每一层都对数据进行一次变换,提取出更高级、更抽象的特征。与传统的“浅层学习”相比,深度学习能够处理更复杂的问题,挖掘数据中更深层次的信息。

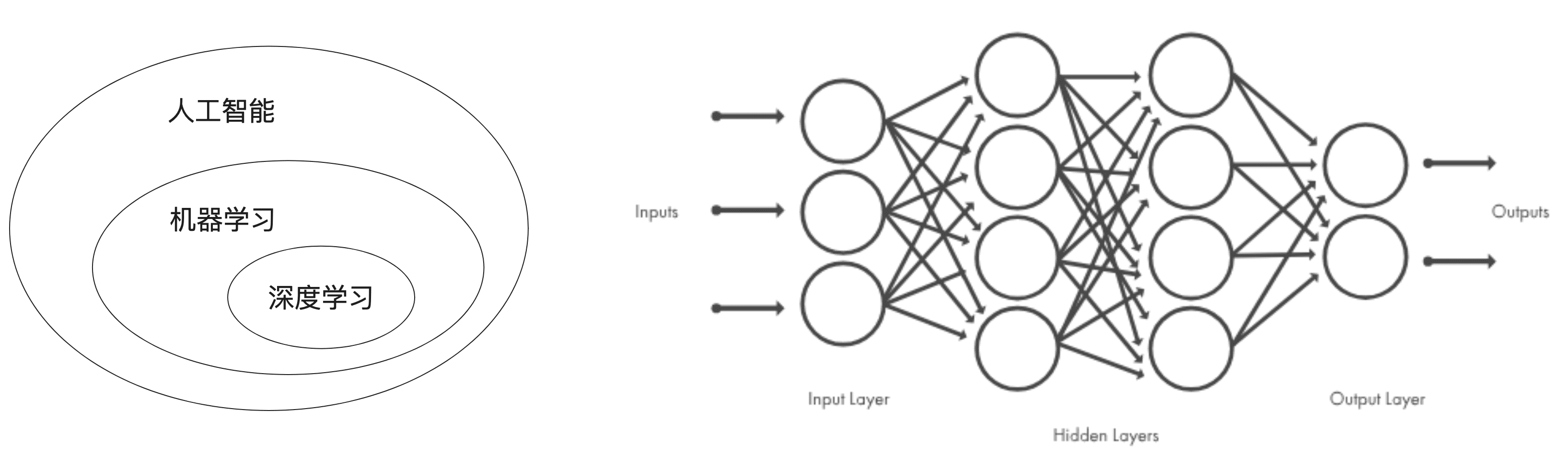

深度学习模型的工作原理可以概括为以下几个步骤:

- 初始化权重:对神经网络的权重进行随机赋值,这是模型学习的起点。

- 前向传播:输入数据经过一系列随机变换,产生预测值。

- 计算损失:通过损失函数,比较预测值与真实值之间的差异,得到损失值。损失函数是衡量模型预测准确程度的重要指标。

- 反向传播与优化:将损失值作为反馈信号,利用优化器调整权重,以降低损失值。这个过程不断迭代,直至模型达到最佳状态。

2. 神经网络的数学基石:张量与运算

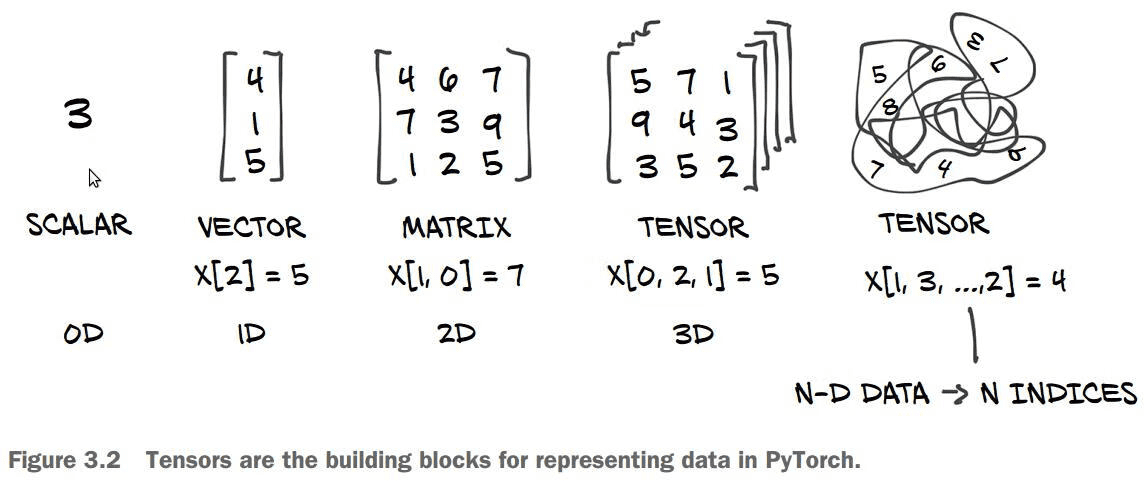

张量是现代机器学习系统中的基本数据结构,可以理解为多维数组。张量具有三个关键属性:轴(维度)、形状(各维度的大小)和数据类型(如float32、int8等)。

- 标量(0阶张量):一个单独的数字,例如3。

- 向量(1阶张量):数字组成的一维数组,例如[1, 2, 3]。

- 矩阵(2阶张量):向量组成的二维数组,具有行和列,例如[[1, 2], [3, 4]]。

- 3阶及更高阶张量:将多个矩阵或张量组合在一起,形成更高维度的数组。

理解张量的概念至关重要,因为神经网络中的所有运算都基于张量进行。

神经网络的“齿轮”是张量运算,包括逐元素运算、张量积(点积)和张量变形。

- 逐元素运算:对张量的每个元素进行独立运算,例如加法、减法、乘法、除法等。参与运算的张量形状必须相同。ReLU激活函数也是一种逐元素运算,它将小于0的元素置为0,保留大于0的元素。

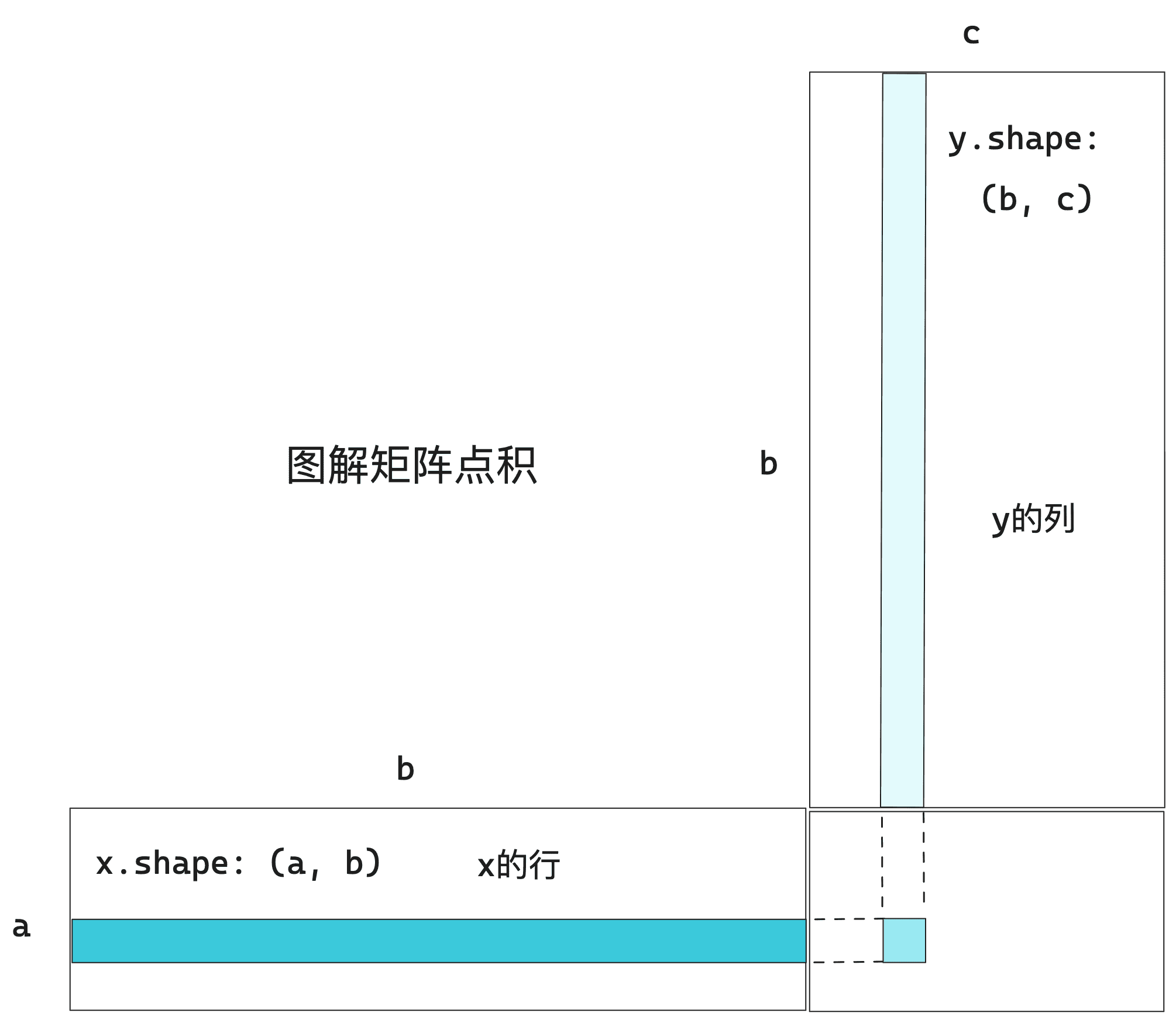

- 张量积(点积):一种重要的张量运算,将两个张量按照一定的规则进行组合。两个向量的点积是一个标量。矩阵和向量的点积是一个向量。矩阵和矩阵的点积是一个矩阵。点积的计算要求参与运算的张量满足特定的形状匹配条件。

- 张量变形:改变张量的形状,例如将一个(3, 2)的矩阵变形为(6, 1)或(2, 3)的矩阵。转置是一种特殊的张量变形,将矩阵的行和列互换。

线性变换、仿射变换与几何解释

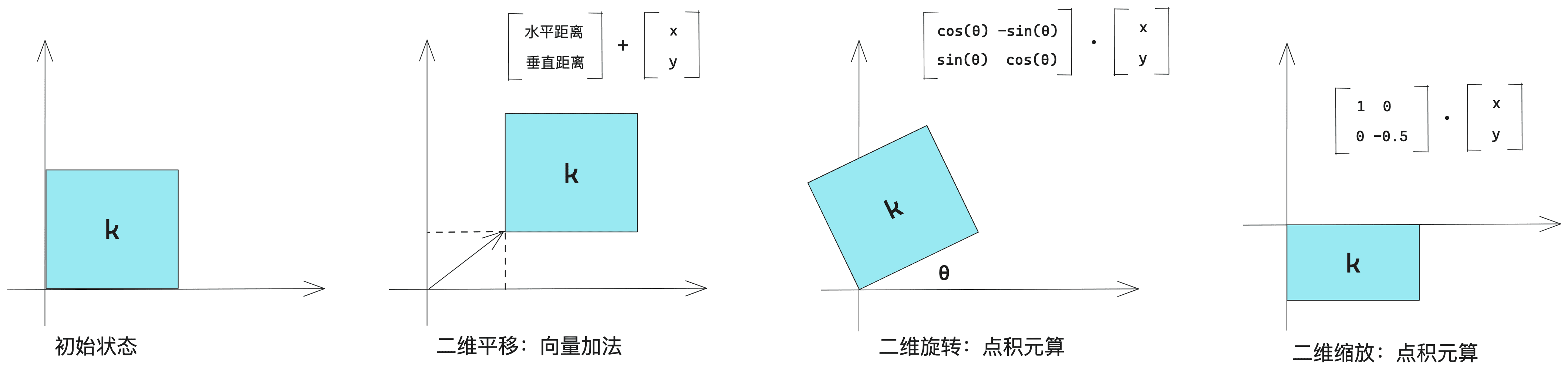

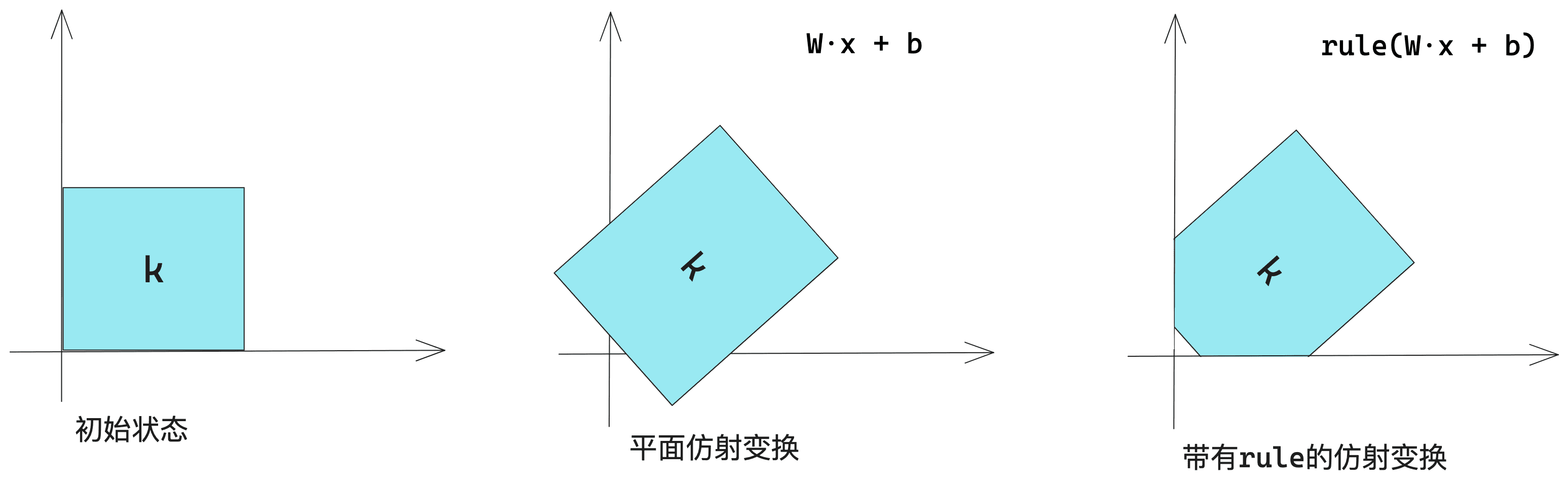

张量运算具有几何解释,可以将平移、旋转、缩放等几何操作表示为张量运算。与任意矩阵做点积运算可以实现线性变换。线性变换与平移的组合称为仿射变换。如果一个神经网络没有激活函数,那么它等同于一个线性模型,即使有多层结构,也无法表达复杂的非线性关系。

深度学习的本质是利用一系列张量运算对输入数据进行复杂的几何变换。可以将神经网络看作是在高维空间中对数据进行逐步变换,最终找到简洁的表示。

3. 神经网络的“引擎”:基于梯度的优化

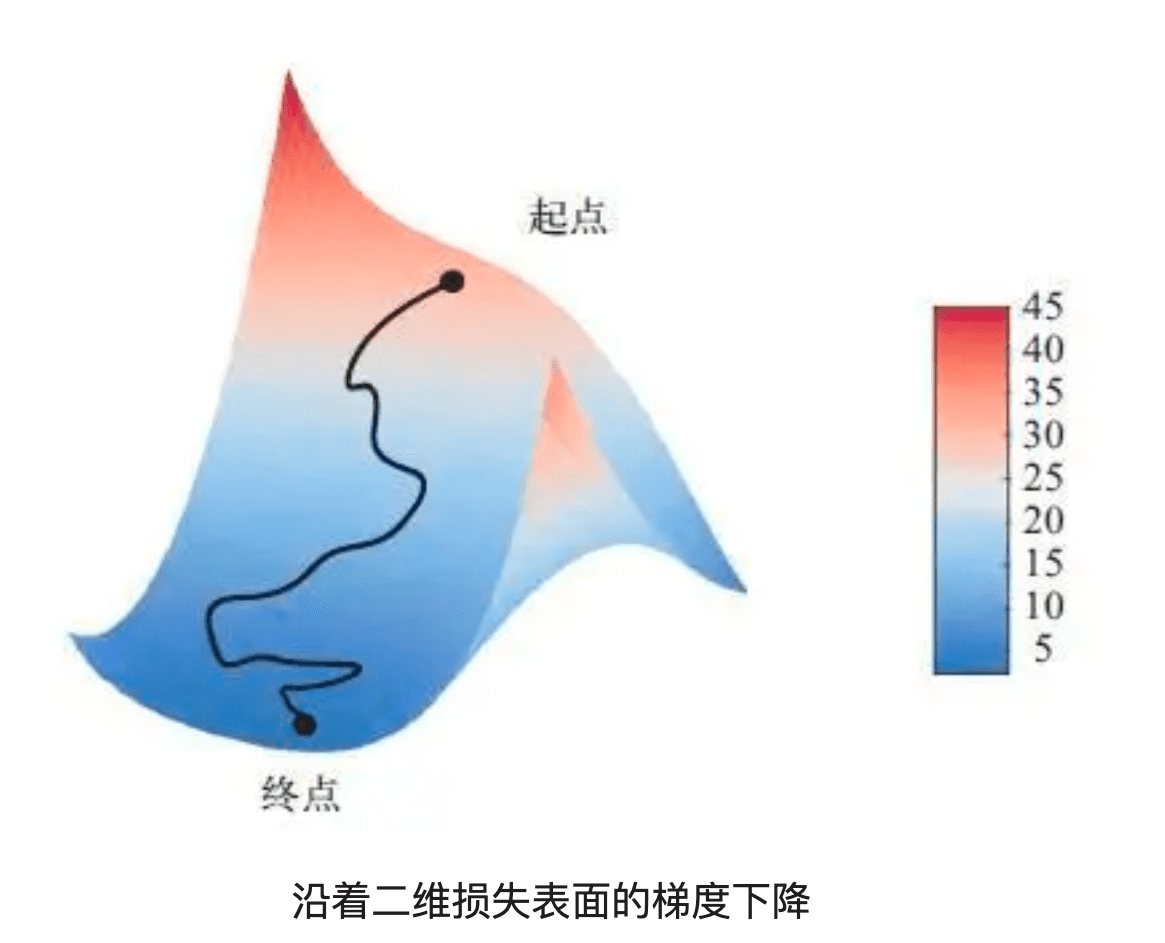

神经网络的训练过程实际上是一个优化过程,目标是找到使损失函数最小化的权重值。梯度下降法是一种常用的优化算法,它通过计算损失函数相对于权重的梯度,然后沿着梯度的反方向更新权重,使损失值逐渐减小。

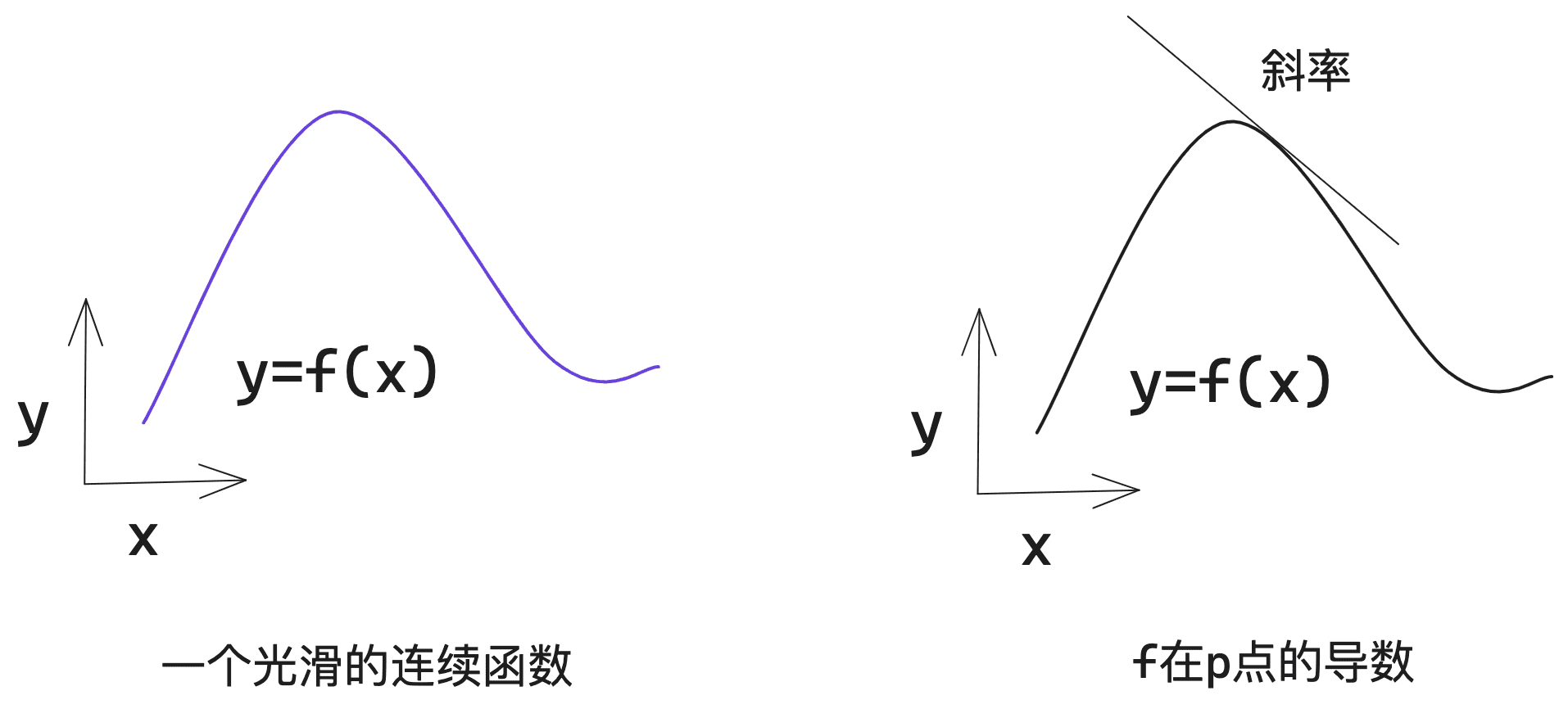

- 导数:函数在某一点的局部斜率,表示函数在该点附近的变化趋势。

- 梯度:张量函数的导数,表示函数所对应多维表面的曲率。

- 随机梯度下降(SGD):一种常用的优化算法,每次迭代只使用一小部分数据(小批量)来计算梯度并更新权重。

为了计算复杂表达式的梯度,需要使用反向传播算法。反向传播算法基于链式法则,利用简单运算的导数,计算出复杂运算组合的梯度。计算图是 TensorFlow 等深度学习框架的核心数据结构,它可以自动计算任意可微张量运算组合的梯度,大大简化了深度学习模型的开发过程。

4. 实战:使用 Keras 识别手写数字

下面我们将使用 Keras 库,构建一个简单的神经网络,用于识别 MNIST 数据集中的手写数字。

- 加载 MNIST 数据集:Keras 提供了方便的函数,可以轻松加载 MNIST 数据集。

from tensorflow.keras.datasets import mnist

(train_images, train_labels), (test_images, test_labels) = mnist.load_data()- 构建神经网络模型:使用 Keras 的 Sequential API,构建一个包含两个 Dense 层的神经网络。

from tensorflow import keras

from tensorflow.keras import layers

model = keras.Sequential([

layers.Dense(512, activation="relu"),

layers.Dense(10, activation="softmax")

])- 编译模型:指定优化器、损失函数和评估指标。

model.compile(

optimizer="rmsprop",

loss="sparse_categorical_crossentropy",

metrics=["accuracy"]

)- 准备图像数据:将图像数据进行预处理,将其reshape为模型需要的形状,并将像素值缩放到 0 到 1 之间。

train_images = train_images.reshape((60000, 28 * 28))

train_images = train_images.astype("float32") / 255

test_images = test_images.reshape((10000, 28 * 28))

test_images = test_images.astype("float32") / 255- 训练模型:使用 fit 方法在训练数据上训练模型。

model.fit(train_images, train_labels, epochs=5, batch_size=128)- 使用模型进行预测:使用 predict 方法对新的图像数据进行预测。

test_digits = test_images[0:10]

predictions = model.predict(test_digits)- 评估模型:使用 evaluate 方法在测试数据上评估模型的性能。

test_loss, test_acc = model.evaluate(test_images, test_labels)

print(f"test_acc: {test_acc}")通过这个简单的例子,我们可以看到深度学习在图像识别领域的强大能力。当然,这只是深度学习的冰山一角,它在自然语言处理、语音识别、推荐系统等领域都有着广泛的应用。

深度学习是一个充满活力和机遇的领域,它正在不断发展和完善。掌握深度学习的原理和技术,将有助于我们更好地理解和利用人工智能的力量,解决现实世界中的各种问题。